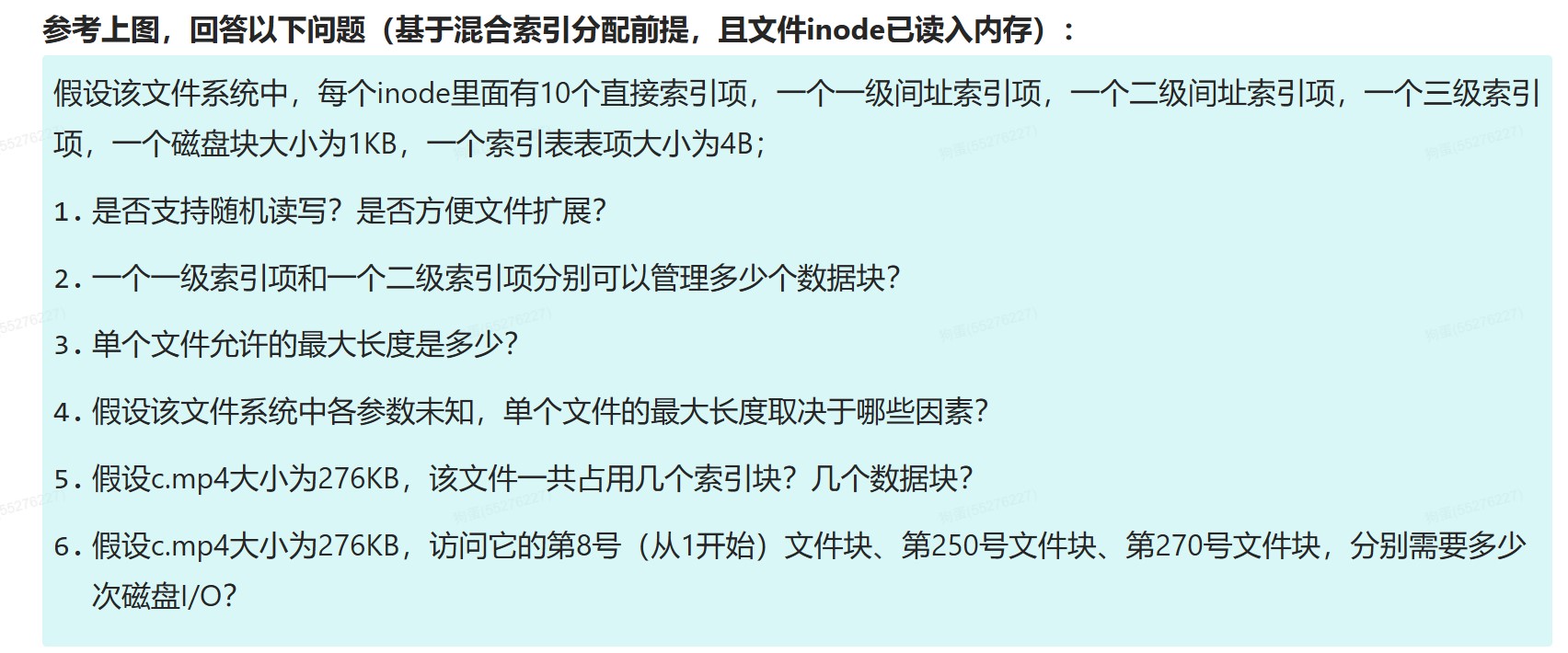

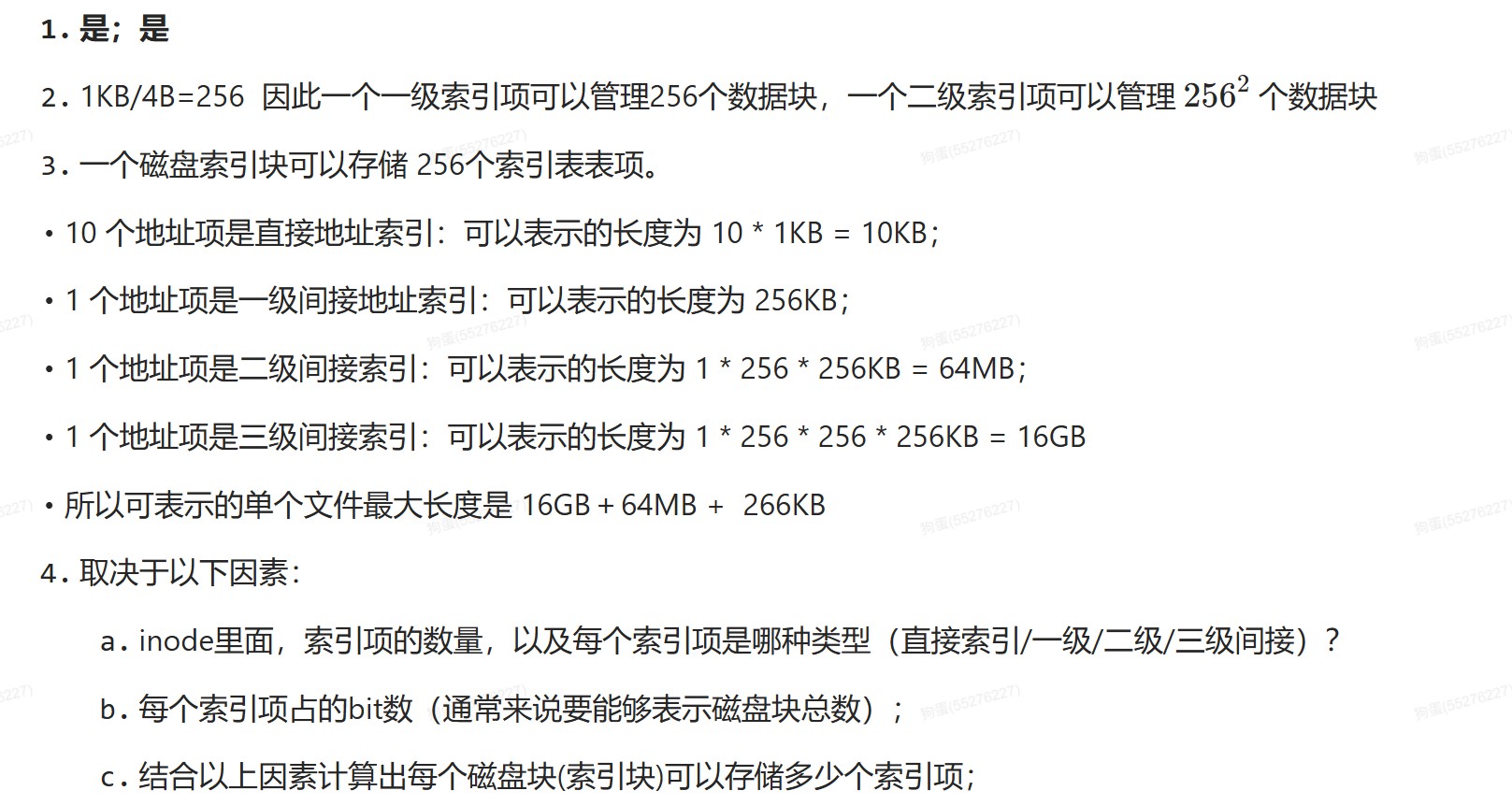

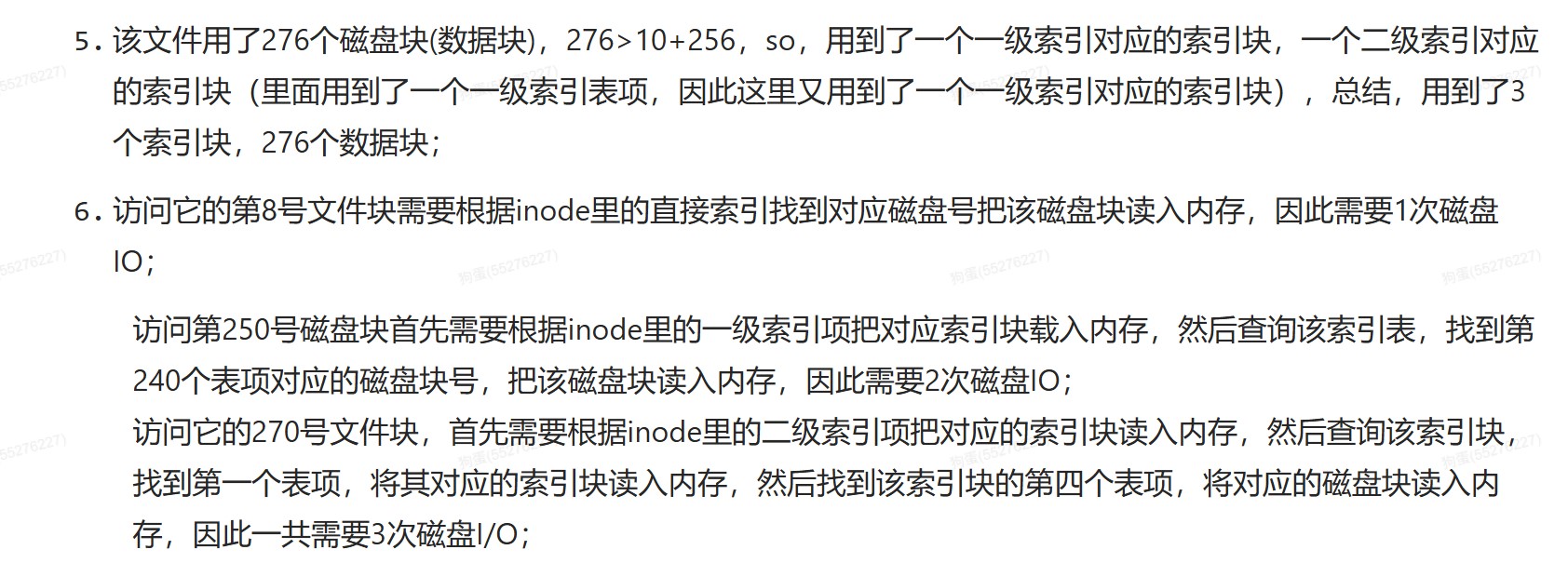

408错漏知识

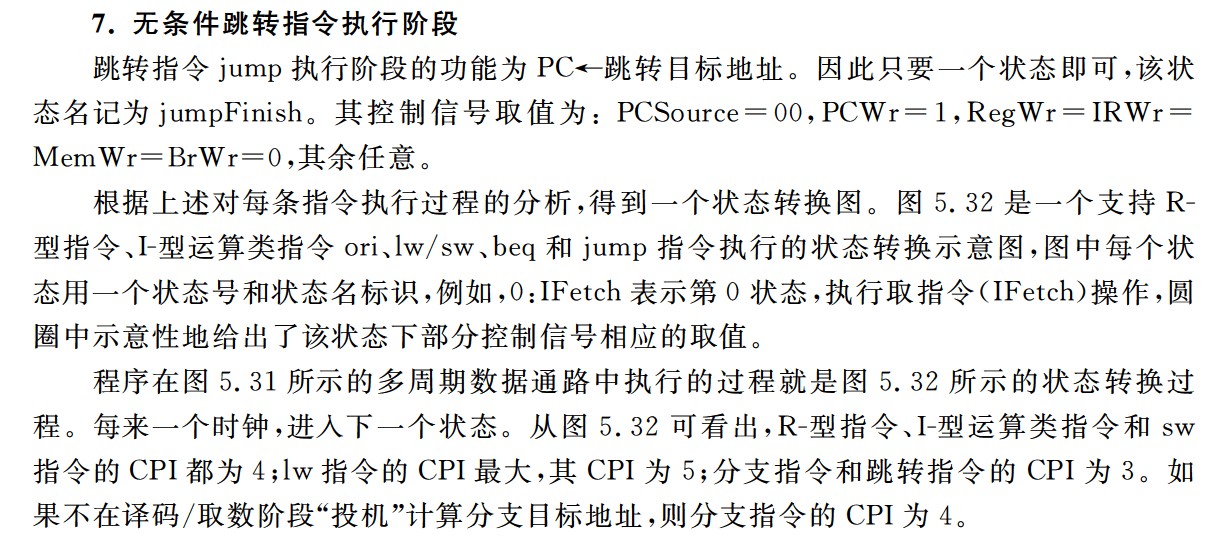

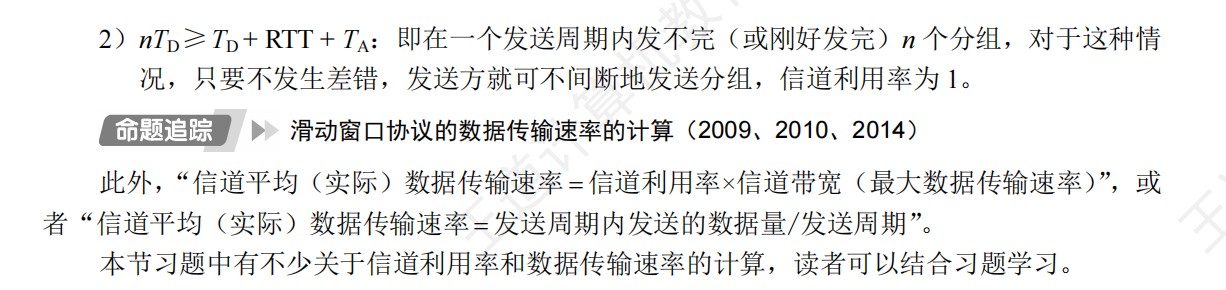

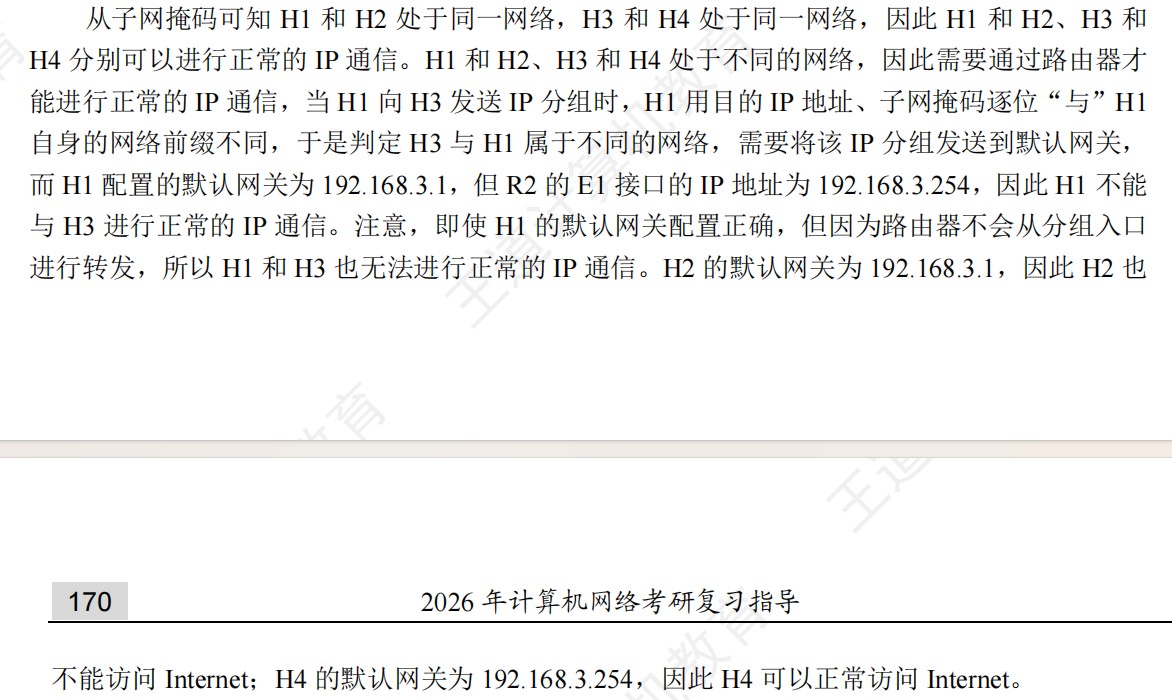

DS(数据结构)

数据结构的基本概念

- 数据元素是数据的基本单位。

- 数据项是构成数据元素的不可分割的最小单位

- 循环队列和线索二叉树都属于物理结构

- 抽象数据结构包含数据对象、数据关系、基本操作

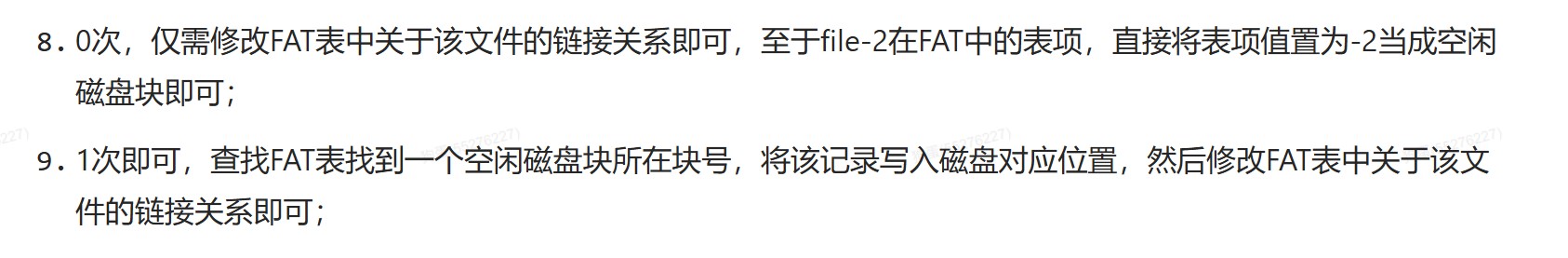

- 算法的设计依赖于逻辑结构

- 算法的实现依赖于物理结构

- 数据结构是具有特定关系的数据元素的集合

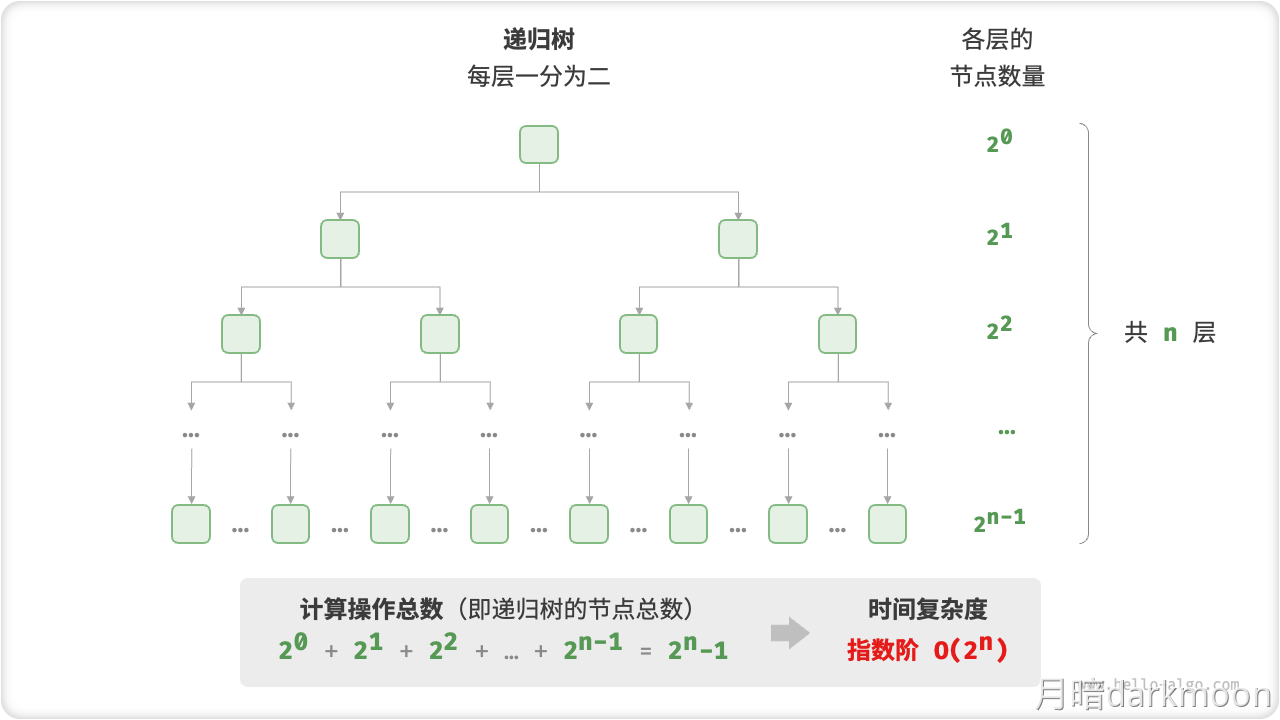

时间复杂度

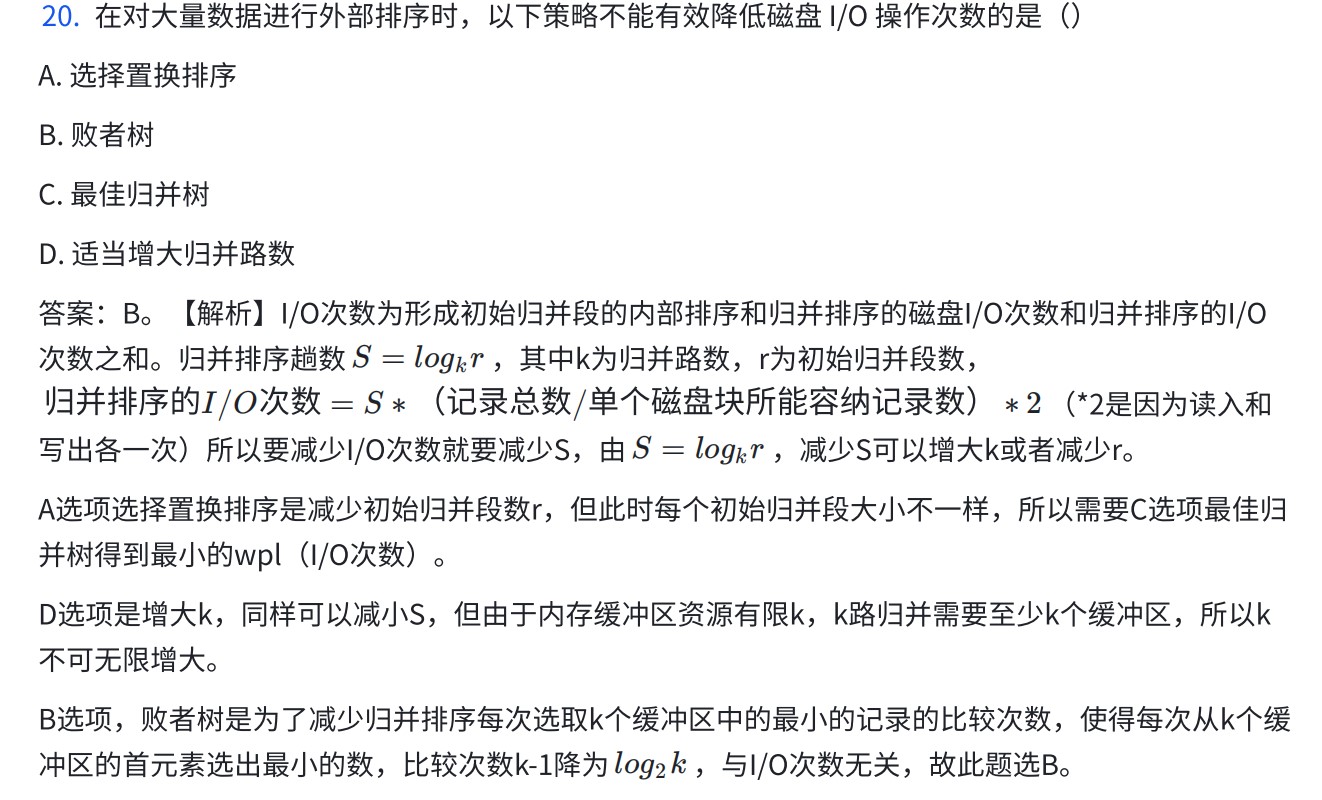

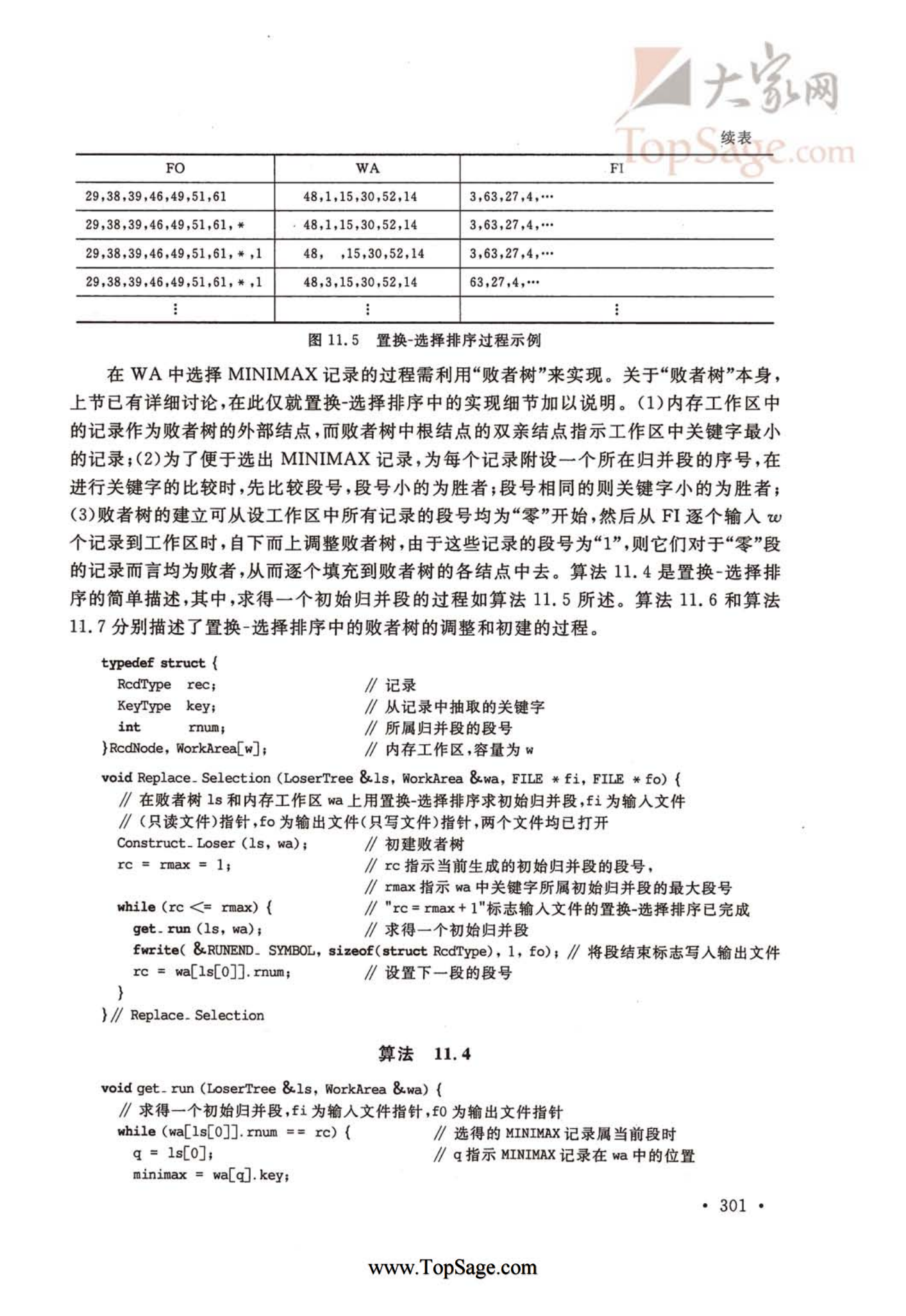

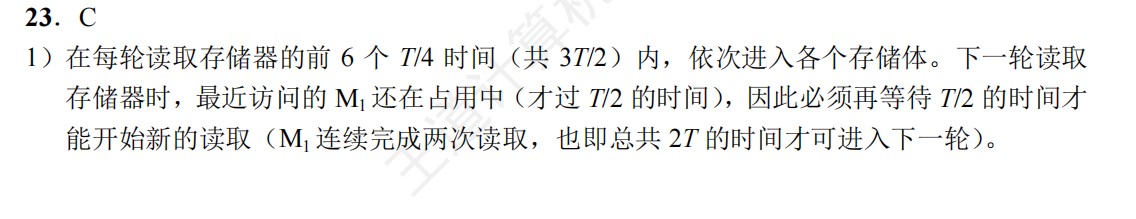

外部排序

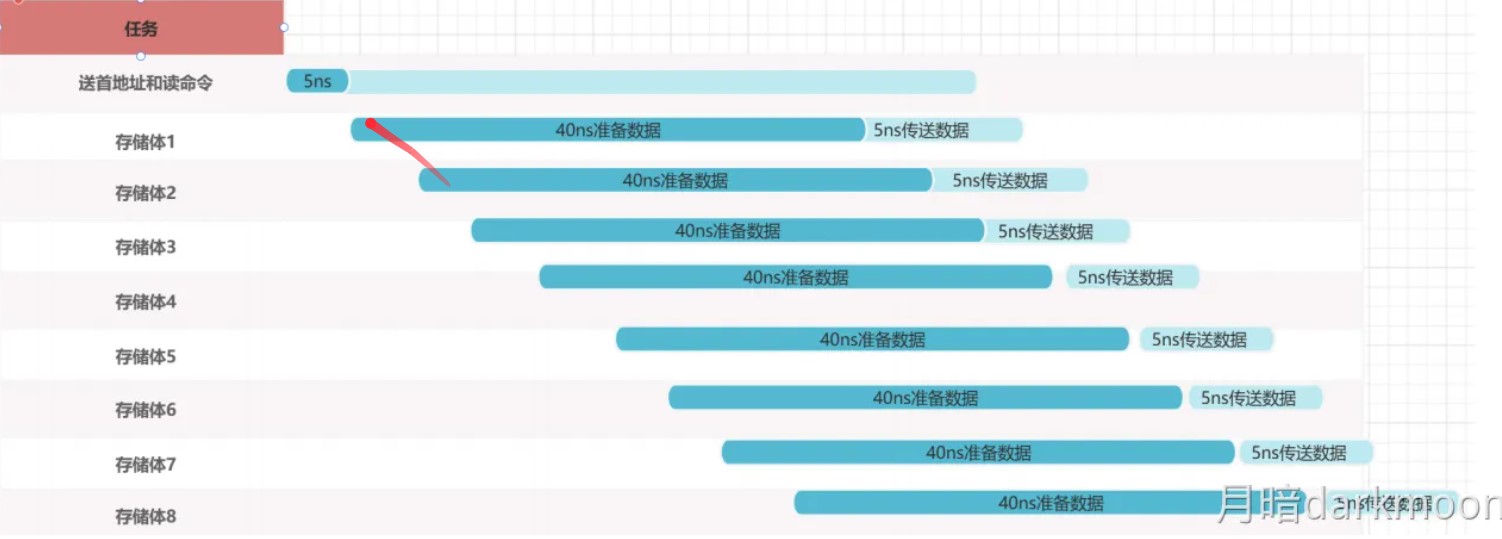

- I/O次数的计算:初始归并段生成的I/O次数+归并时的I/O次数

- 初始归并段生成的I/O次数=磁盘块数*2(读写各I/O一次)

- 归并时的I/O次数=磁盘块数* 2 *归并趟数

- 败者树中非叶子节点存储的是失败者的标记(归并段下标),而叶子节点存储的是各个路当前记录的索引值

- 败者树的空间复杂度是O(n),时间复杂度是O(nlogn)

- 败者树为k路归并段内部排序所使用的,用于提高内部排序效率,与I/O次数无关

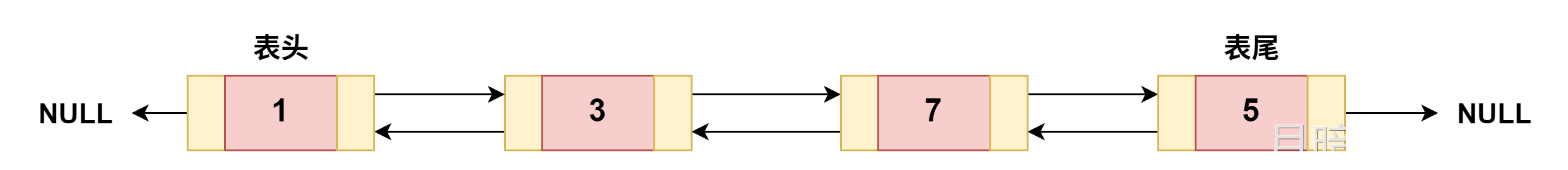

链表

- 从长度为n的顺序表中删除任一各元素,平均时间复杂度是O(n)

单链表

- 单链表中删除一个节点有两种方法

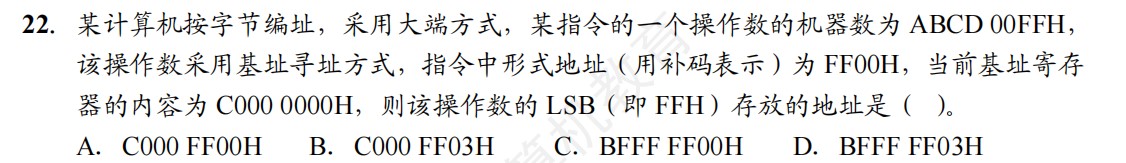

- 1、将该点直接删除,让该点的上一个节点直接指向该点的下一个节点

- 2、将该点变成该点的下一个点

- 要保证插入的先后顺序与对应节点在链中的顺序相反,必须使用头插法

- 要保证插入的先后顺序与对应节点在链中的顺序相同,必须使用尾插法

静态链表

-

静态链表删除或插入不需要移动元素

-

静态链表的存储空间虽然是顺序分配的,但元素的存储不是顺序的,查找时仍然要按照链依次进行,而插入、删除都不需要移动元素。静态链表的存储空间是一次性申请的,能容纳的最大元素个数在定义时就已经确定。由于并非每个空间都存储了元素,因此会导致存储空间的浪费

-

数组一旦确定,数据元素的容量和位置关系就是固定的,因此不能进行插入和删除等操作

-

稀疏矩阵压缩存储后,不能直接根据元素所在数组中的位置在内存中定址,也就意味着失去了随机存取的功能

-

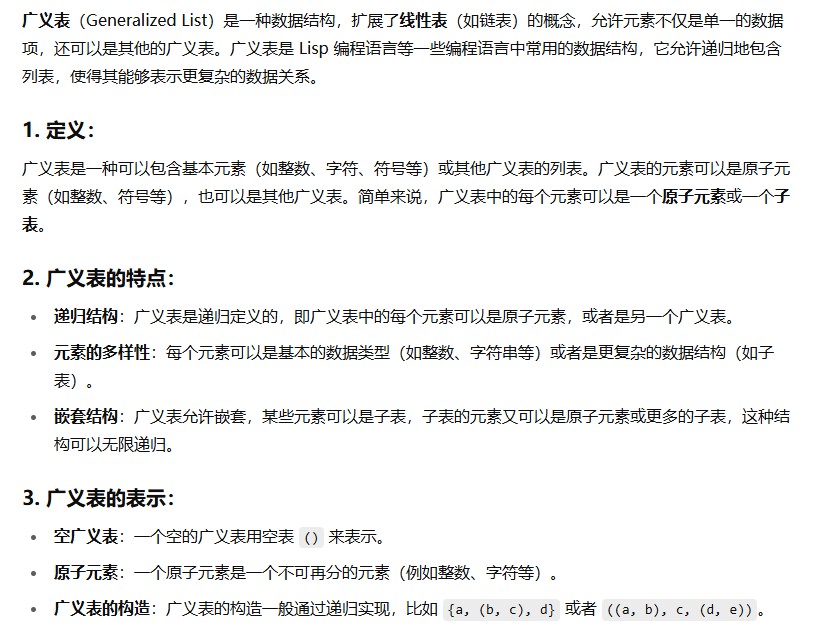

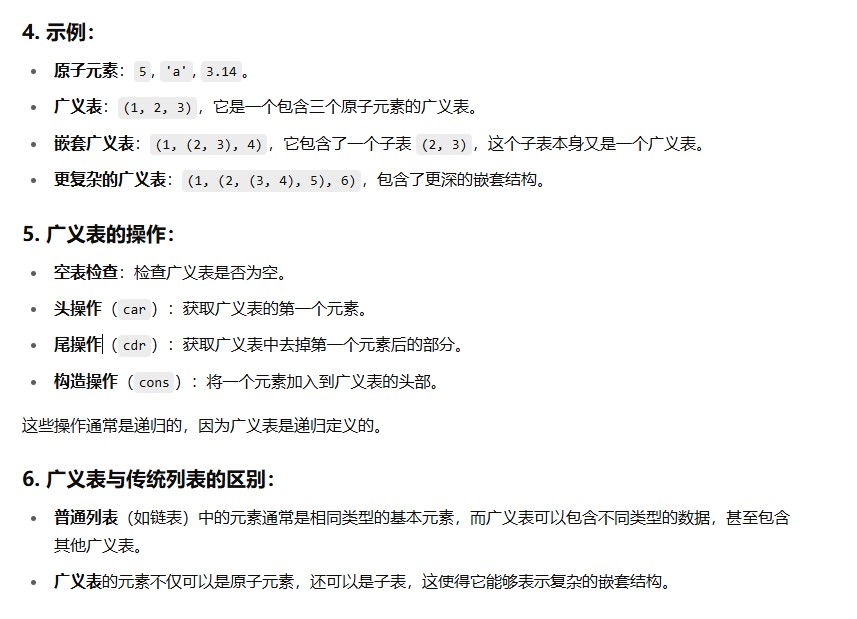

广义表:

栈和队列和数组

- 最适合用作链队的链表就是带有队首指针和队尾指针的非循环单链表

- 循环队列的三种判满方式都需要额外的开销,需要牺牲一个队列空间

- 三元组的内容为(行,列,值),其次还要存储稀疏矩阵和行列总数(否则无法分辨矩阵规模)和非零元素个数(三元组表的大小)。交换每个三元组的行列以外,还要交换总行和总列才可以实现转置

- 十字链表法适合频繁插入删除和快速定位行列元素,三元组的存储效率一般低于十字链表

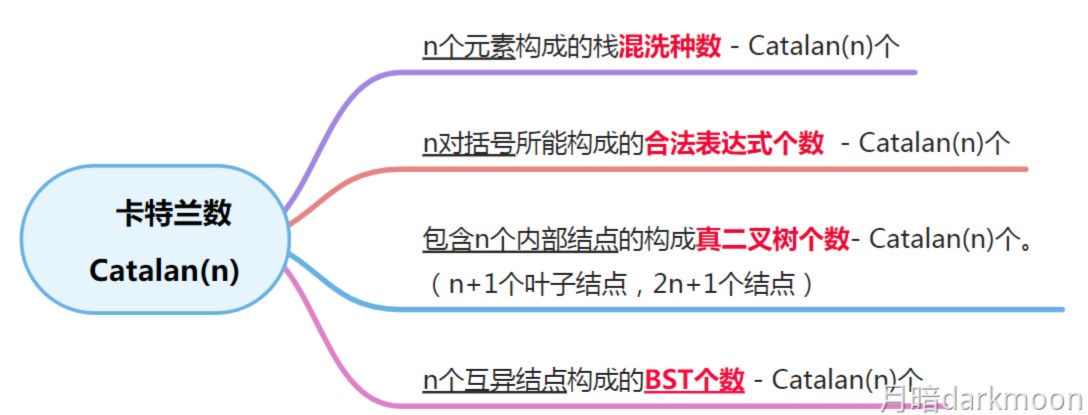

卡特兰数的应用

- n个不同元素进栈,出栈元素不同排列的个数N可由卡特兰数确定

- 先序序列为入栈次序,中序序列为出栈序列,因为前序序列和中序序列可以唯一确定一棵二叉树,因此问先序序列为xxxx的不同二叉树的个数是?相当于问以xxxx为入栈次序,出栈序列的个数是?

- 进栈出栈操作与二叉树中序遍历的关系

- 一个节点进栈后有两种处理方式:

- 要么立即出栈(此时该入栈结点没有左孩子),要么下一个结点进栈(有左孩子)

- 一个结点出栈后有两种处理方式

- 继续出栈(该结点无右孩子)

- 要么下一个结点进栈(有右孩子)

- 一个节点进栈后有两种处理方式:

矩阵压缩存储计算

- 算该点前面有多少个数,多少个数*每个数的大小,这就是该元素的起始位置,如果是结构体,再根据结构体的结构进行计算

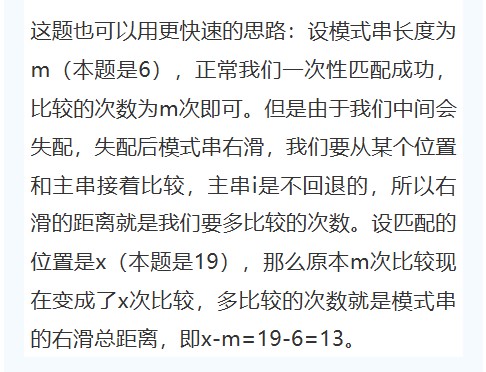

串

- 普通匹配算法的时间复杂度为O(mn),kmp算法时间复杂度为O(m+n),如果每次匹配部分匹配都接近模式串长度n,那么普通匹配算法达到最坏时间复杂度O(mn),相反普通匹配算法和kmp算法接近

kmp算法小总结

- 代码

1 | |

-

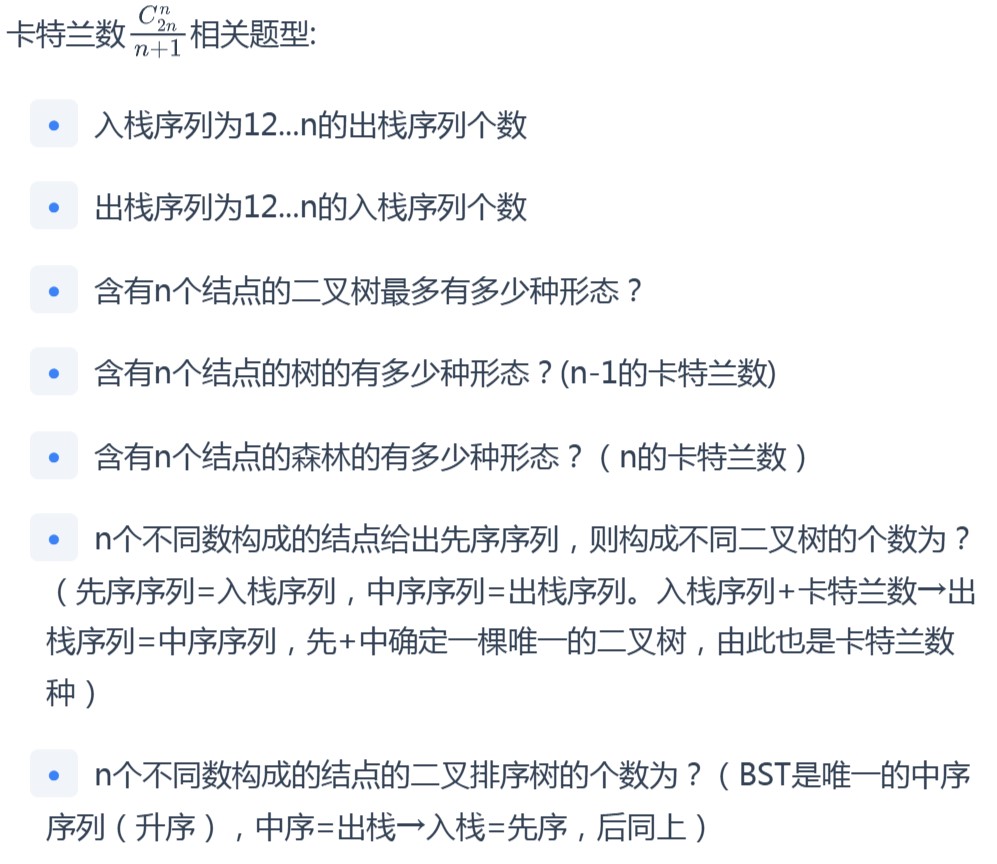

next数组手算过程:

- next[1]都无脑写0,next[2]都无脑写1

- 其他next:比较前缀后缀相同的最长长度,然后+1(因为是下一个位置)

- next数组采用求匹配失败的元素的左边起子串的前缀后缀相同的下一个位置

-

nextval数组手算过程

- 先求next数组

- nextval数组j=1的位置无脑写0,然后后面的进行回溯,如果回溯到不一样的就保持不变,一样的就继续回溯

- 如果回溯到的点一样,就可以用它的next数组

栈

- 上溢是指存储器满,还往里写,下溢是指存储器空,还往外读。

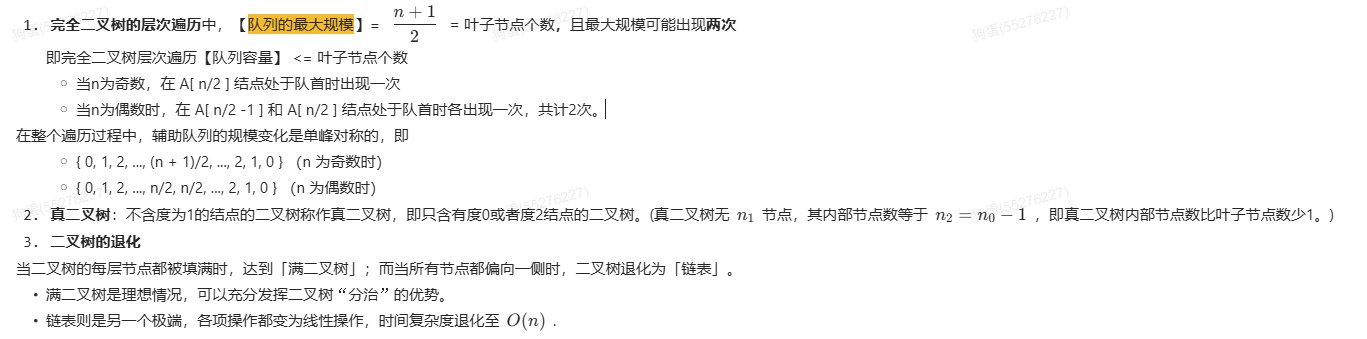

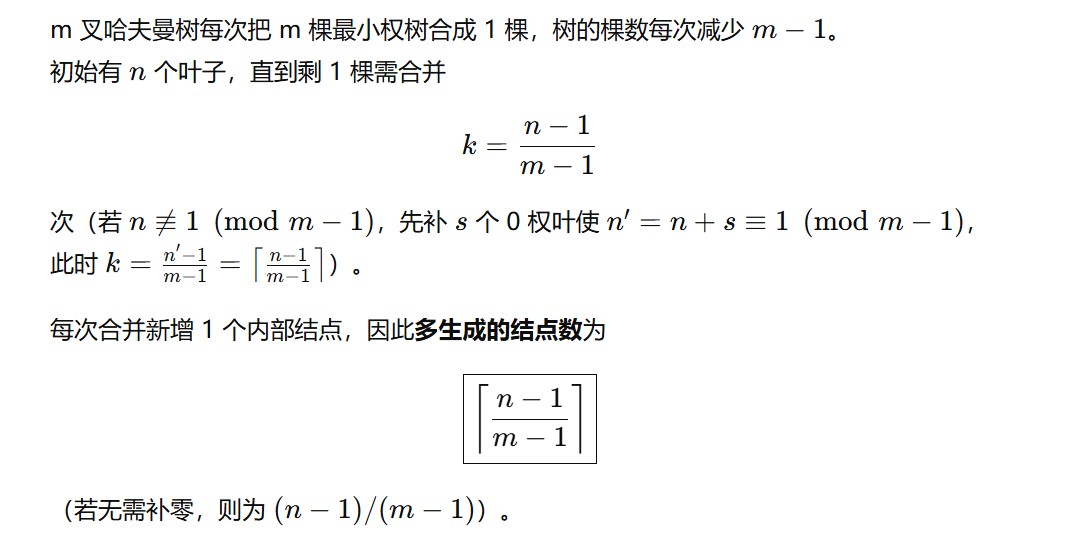

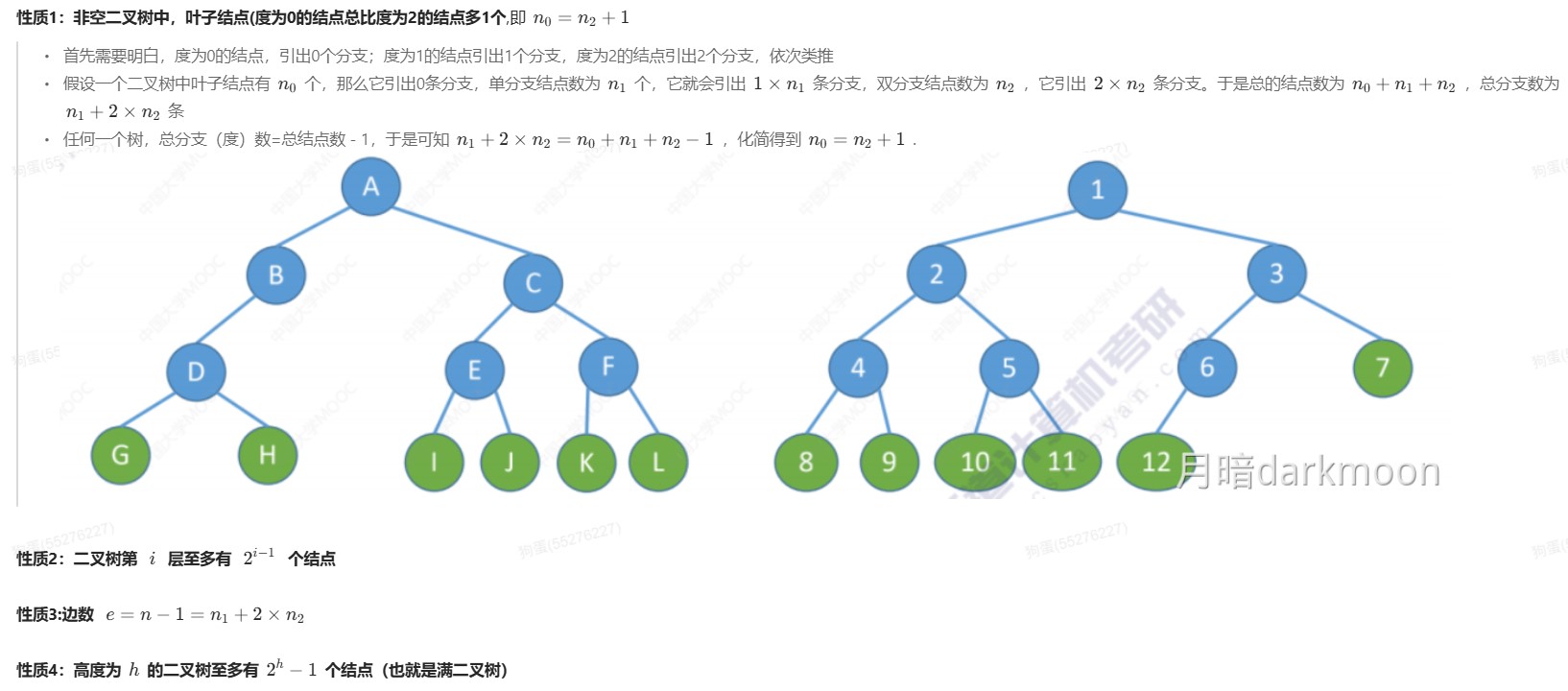

树

-

只要按照前序序列的顺序入栈,那么无论怎么出栈,肯定是符合中序序列的

-

原森林中每一个分支节点产生唯一一个对应二叉树中没有右孩子的结点,森林中最右边子树的根节点在二叉树中也没有右孩子,所以原森林中分支节点个数+1=二叉树中没有右孩子的结点数量

- 在树到二叉树的转换过程中,右孩子的数量=分支节点个数+1,这个+1是因为最后一个分支节点的右孩子指向空(

NULL),这个空的右孩子也被算作一个额外的右孩子。

- 在树到二叉树的转换过程中,右孩子的数量=分支节点个数+1,这个+1是因为最后一个分支节点的右孩子指向空(

-

树转换为二叉树后,没有右孩子的节点个数=分支节点个数+1

-

任一二叉树的叶节点在先序、中序、后序遍历序列中相对位置一定是相同的。

-

要交换二叉树的所有分支节点的左右子树的位置,利用前序或后序遍历框架解决最合适

-

森林中树的个数=结点数-边数

-

有n个结点的二叉树,最小高度是log2(n+1)上取整,最高高度是n,因此n个结点的二叉树有n-log2(n+1)+1种可能的层高

-

哈夫曼树的加权平均长度=(结点的路径数*权值的总和)/(结点权值总和)

-

m叉哈夫曼树

树的结点关系总结

- 树的

- 二叉树的

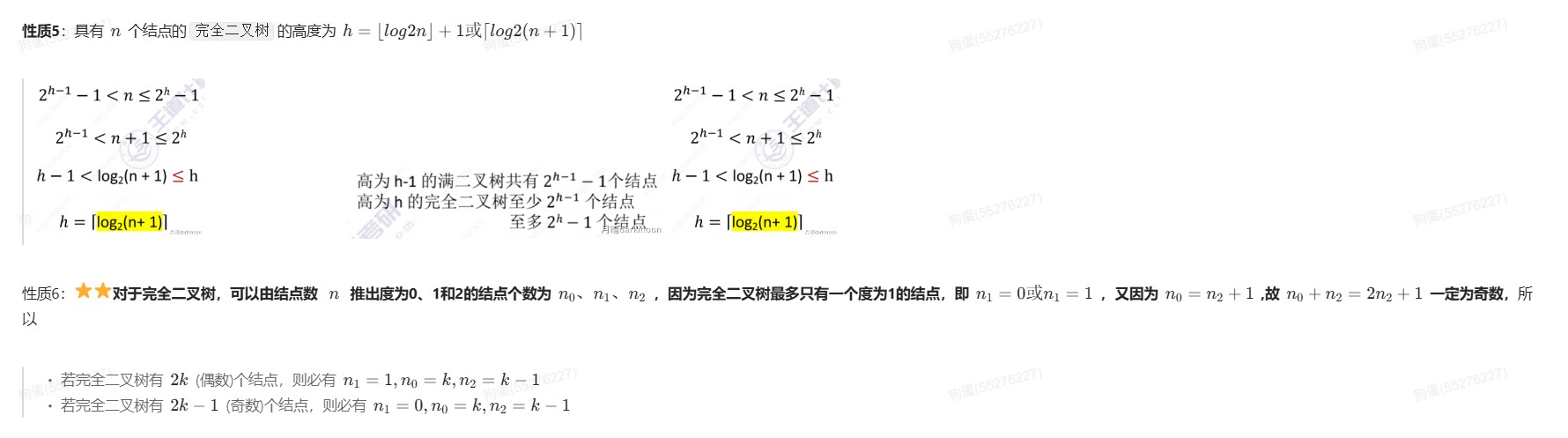

- B树的

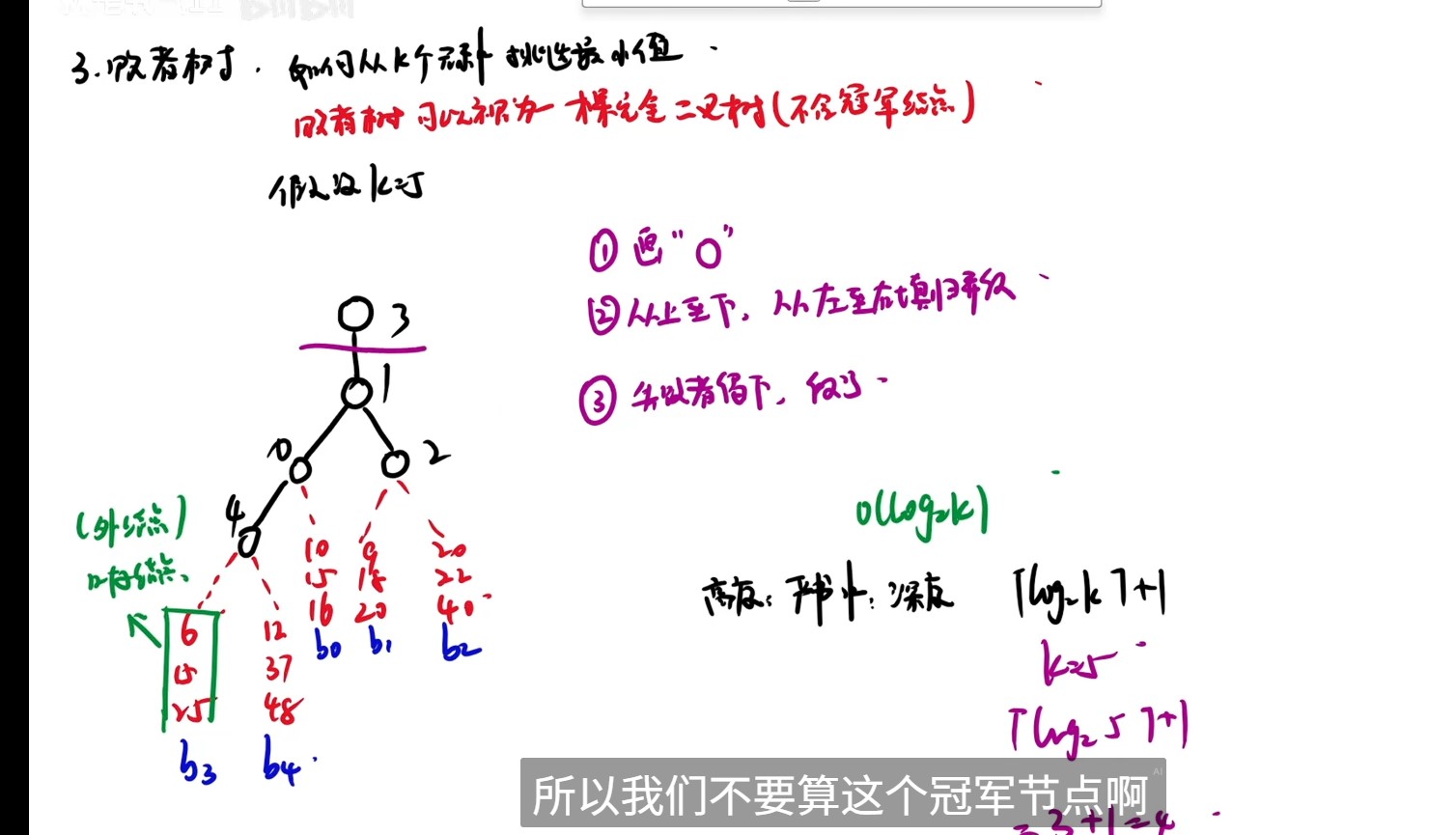

- 败者树高度

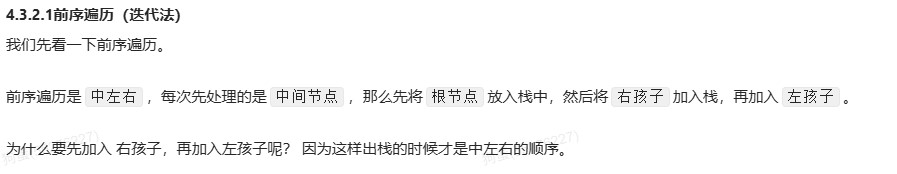

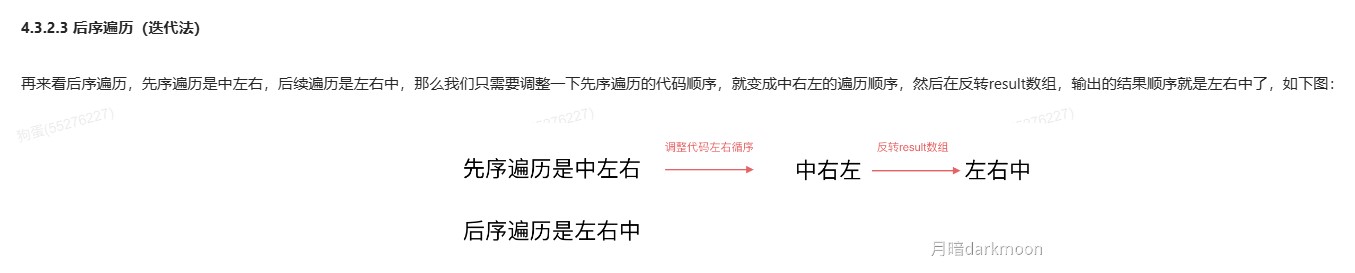

二叉树的迭代遍历

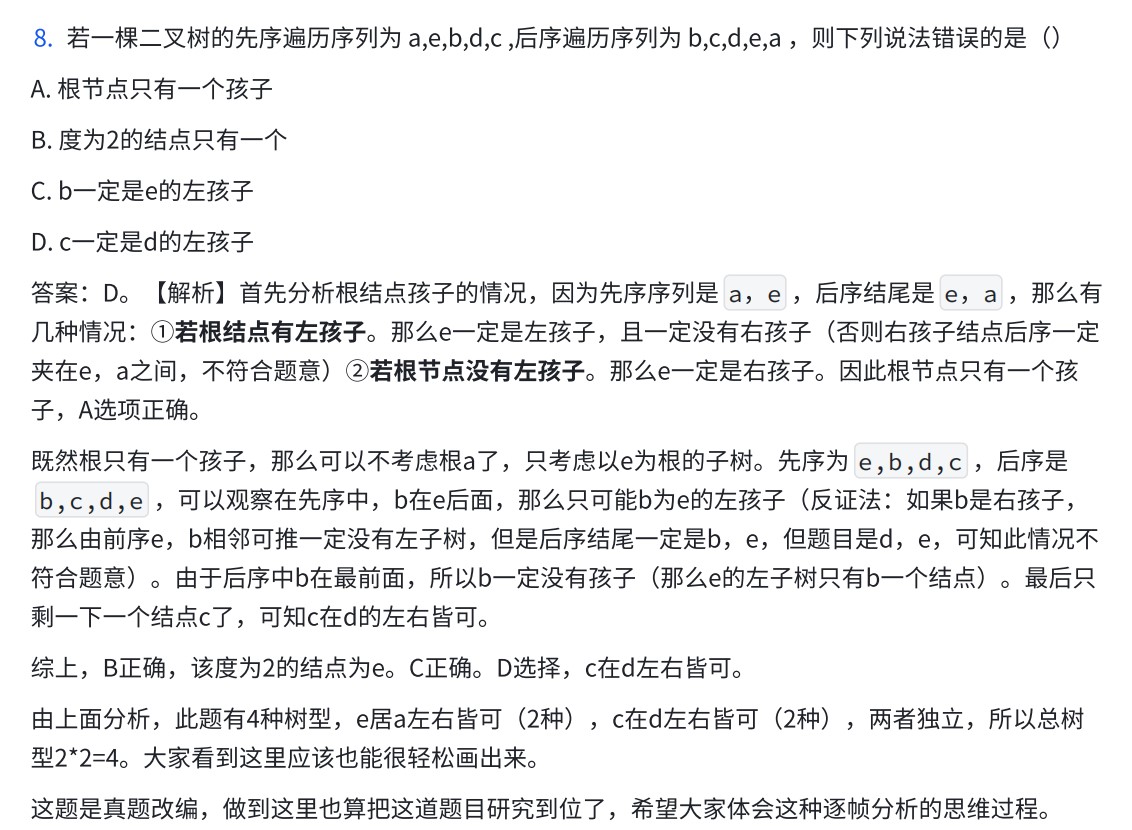

根据遍历序列确定二叉树的形态

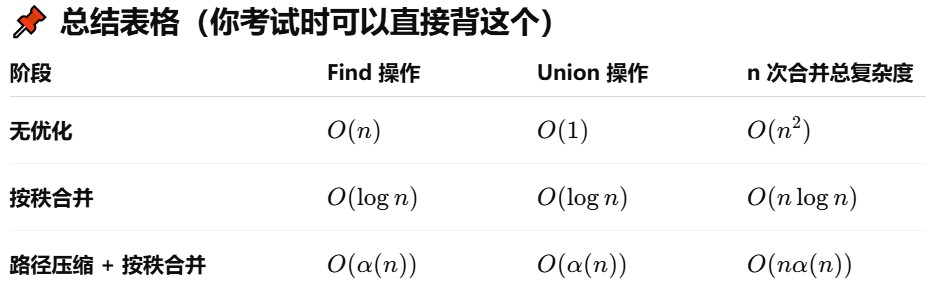

并查集三个阶段的时间复杂度

图

- 只有在无向图中,DFS的调用次数=连通分量的个数

- 有向图中因为强连通分量要求互相之间都有去往边,而DFS只保证有从一个顶点向另一个顶点的边,不保证有反向的边

- 无向图判环

- DFS或BFS或并查集或拓扑排序

- 有向图判环

- DFS和拓扑排序或并查集

- 使用邻接矩阵表示图的时候,可以直接访问矩阵元素获取边,因此增删查的时间复杂度为O(1)

- prim算法中,当同时有两个代价相同的顶点时,优先将编号更小的顶点加入MST

- kruskal算法中,当多边权值相同时,起点编号更小的边排在前面

- 有向无环图仅仅在存在一条路径可以包含其所有顶点的情况下,有唯一的拓扑排序方式,这时,拓扑排序与他们在这条路径中出现的顺序相同

图的顶点和边的关系

408图论算法复杂度+适用场景(含负权边/负环)

| 算法 / 存储结构 | 时间复杂度 | 空间复杂度 | 适用场景 | 说明 |

|---|---|---|---|---|

| 邻接矩阵 | —— | O(V²) | 稠密图 | 查询边是否存在快 O(1),遍历慢 O(V) |

| 邻接表 | —— | O(V+E) | 稀疏图 | 遍历快 O(V+E),查询边是否存在慢 O(deg(v)) |

| 十字链表(有向图) | —— | O(V+E) | 需要同时高效处理出度和入度的有向图 | 每条边存两次引用 |

| 邻接多重表(无向图) | —— | O(V+E) | 需要避免无向边重复存储 | 每条边只存一次结点 |

| DFS(邻接表) | O(V+E) | O(V+E) | 遍历所有顶点与边;拓扑排序;连通分量;检测环 | 深度优先搜索 |

| DFS(邻接矩阵) | O(V²) | O(V²) | 小规模稠密图遍历 | 遍历邻接点需扫一行 |

| BFS(邻接表) | O(V+E) | O(V+E) | 无权图最短路径;分层遍历;连通分量 | 队列实现、广度优先搜索 |

| BFS(邻接矩阵) | O(V²) | O(V²) | 小规模稠密图遍历 | |

| 拓扑排序(邻接表) | O(V+E) | O(V+E) | DAG 的线性序;任务调度;编译依赖 | 常用 Kahn 算法(队列)或 DFS |

| 拓扑排序(邻接矩阵) | O(V²) | O(V²) | 小规模稠密图 | 每次找入度=0 需扫一列 |

| Prim 算法(朴素版,邻接矩阵) | O(V²) | O(V²) | 稠密图最小生成树 | 每次扫描所有顶点选最小边 |

| Prim 算法(堆优化版,邻接表) | O(E log V) | O(V+E) | 稀疏图最小生成树 | 用优先队列维护候选边 |

| Kruskal 算法 | O(E log E)≈O(E log V) | O(V+E) | 稀疏图最小生成树 | 边排序 + 并查集 |

| Dijkstra(朴素版,邻接矩阵) | O(V²) | O(V²) | 稠密图,单源最短路径(不允许负权边) | 每次找最近点 O(V) |

| Dijkstra(堆优化,邻接表) | O(E log V) | O(V+E) | 稀疏图,单源最短路径(不允许负权边) | 用堆维护最短距离 |

| Floyd 算法 | O(V³) | O(V²) | 多源最短路径,小规模稠密图,允许负权边;可检测负环(dist[i][i]<0) |

若有负环则无解 |

| Bellman-Ford 算法 | O(VE) | O(V+E) | 单源最短路径,允许负权边;可检测负环(松弛 V 次后仍变化) | 若有负环则无解 |

| SPFA 算法 | 平均 O(E),最坏 O(VE) | O(V+E) | 单源最短路径,允许负权边;可检测负环(某点入队 ≥ V 次) | 若有负环则无解 |

| 三元组表(边集数组) | —— | O(E) | 适合稀疏图;常用于 Bellman-Ford、Kruskal、SPFA | 每条边存 (i,j,w),遍历邻接点效率低 |

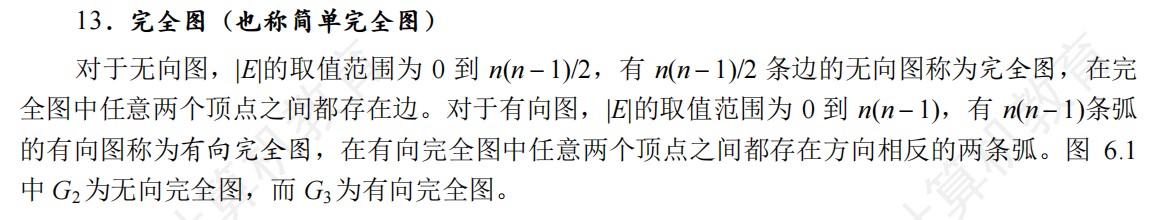

关键路径的相关计算

- 事件Vk的最早发生时间Ve(k)

- 即max{以k结点为弧头的所有边 的弧尾事件 的最早发生时间+该边权值}

- 计算该值时,可以从前往后,从源点出发,每输出一个入度为0的顶点时,计算它所有直接后继顶点的最早发生时间,如果大于则更新

- 源点到Vk的最长路径长度

- 事件Vk的最迟发生时间Vl(k)

- 即min{以k为弧尾的所有边 的弧头事件 的最迟发生时间-该边权值}

- 计算该值时,可以从后往前,从汇点(终点)出发,利用记录拓扑序列的栈,从栈顶出发,以此计算所有直接前驱节点k的最迟发生时间,小于则更新

- 总长度-这个点到终点最长路径的时间

- 活动Ai的最早开始时间E(i)

- E(i)=Ve(k),Vk是弧尾事件,因为只有事件Vk能开始做,活动Ai才能开始做

- 活动Ai的最迟开始时间L(i)

- L(i)=Vl(j)-Weight(Vk,Vj)

- 即该边弧头事件的最迟发生时间-该边的权值

- 总长度-这个边的弧头到终点的最长路径-这个边的权值

- 活动Ai完成的时间余量D(i)

- D(i)=l(i)-e(i)

- 活动余量为0/最迟开始时间=最早开始时间的活动是关键活动

- 顺序

- 从源点出发,先求Ve()

- 再从汇点出发,求Vl()

- 根据Ve()求E()

- 根据Vl求L()

- 求AOE网中所有活动的差额D,并找出D为0的活动构成关键路径

- 只有加快包括在所有关键路径上的关键活动才能达到缩短工期的目的

查找

折半查找

- 有序线性表的顺序查找中,实际上失败节点是不存在的,所以到达失败节点时所查找的长度=它上面的圆形结点的所在层数

- 折半查找在查找不成功时和给定值进行关键字比较次数最多为树的高度,即(Log2n)下取整+1或(log2n+1)上取整

- 折半查找的判定树有n个非叶结点(元素节点)和n+1个方形叶节点(失败结点)

- 折半查找的成功ASL=(层数*点数和)/有序表元素数

- 折半查找的失败ASL=(方形结点上面的圆形节点所在层数*点数和)/方形结点个数

- 二分查找的判定树唯一,而二叉排序树的查找不唯一,相同的关键字其插入顺序不同可能生成不同的二叉排序树

- 二叉排序树的插入和删除平均时间复杂度是O(logn),二分查找的插入和删除时间复杂度为O(n)

- 折半查找树基本都是偏向一边的,也就是说左右子树高度要么相等,要么每个左右子树的高度差都是固定值

- 小数据量下,线性查找性能更佳

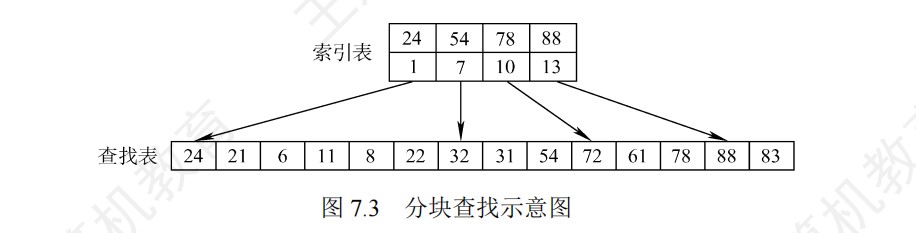

分块查找

- 分块查找分为索引表和查找表,索引表中每个元素含有各块的最大关键字和各块中第一个元素的地址

- 即使在索引表上直接找到了元素,也仍然要进入块内查找,只有在块内找到才是真的找到

- 分块查找既有动态结构又适于快速查找

二叉排序树(BST)

- 二叉排序树新插入的结点一定是一个叶节点

- 删除的是有两个孩子的节点:用直接前驱(左子树最右下)或者直接后继(右子树最左下)来替代原节点,然后进行调整

- 如果删除的结点是叶节点,那么删除后再插入,树的形态与原来保持不变,如果删除的结点不是叶子节点,那么删除再插入其形态就会变化了。

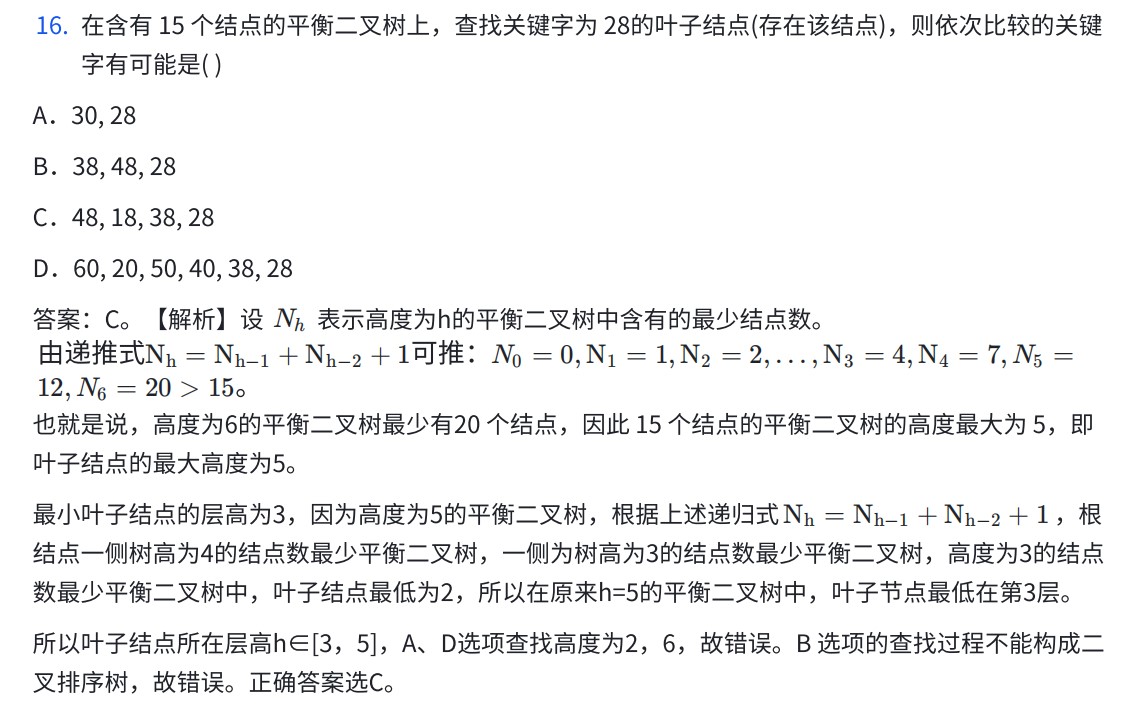

平衡二叉树(AVL)

-

平衡二叉树是对失衡的最小子树的根结点进行调整,每次调整的都是以插入路径上离插入节点最近的平衡因子的绝对值大于1的结点作为根的子树

-

LL和RR的单旋操作发生在最小不平衡子树的根节点和其两个子树构成的三角中

-

LR和RL的双旋操作,先发生在孩子的子树的根节点构成的三角,再发生在最小不平衡子树的根节点构成的三角

-

平衡二叉树的删除

- 删除的是叶子节点:直接删除

- 删除的是只有左子树或者右子树的节点:删除后用子树替代原节点

- 删除的是有两个孩子的节点:用直接前驱(左子树最右下)或者直接后继(右子树最左下)来替代原节点,然后进行调整

-

平衡二叉树的结点数计算

-

求解给定结点数的平衡二叉树的查找所需的最多比较次数(或树的最大高度)

- n0=0,n1=1,n2=2,nh=nh-1+nh-2+1

-

平衡二叉树的叶节点删除后再插入,形态也可能发生变化

-

所有非叶节点的平衡因子均为1,即平衡二叉树结点数最少的情况

-

AVL的树型个数判断

- ①确定最高高度和最低高度

- ②确定不同层高的树型数量

- ③乘法原理

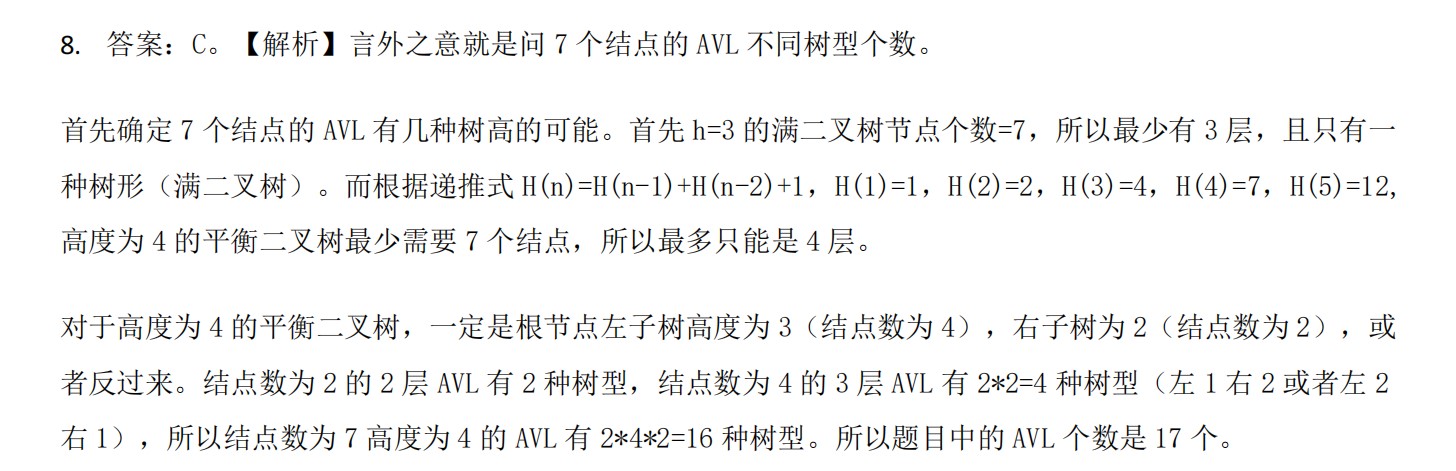

红黑树

- 十二字真言

- 根叶黑,左根右,黑路同,不红红

- n个结点的红黑树有n+1个空黑叶节点

- 对于一颗动态查找树,若插入和删除操作比较少,查找操作比较多,则采用AVL树比较合适,否则采用红黑树更合适

- 不过广义上来讲,二者的插入、删除、查找的时间复杂度均为O(logn)

- AVL的查找效率往往优于红黑树

- 一颗含有n个结点的红黑树的高度至多为2log_2(n+1)

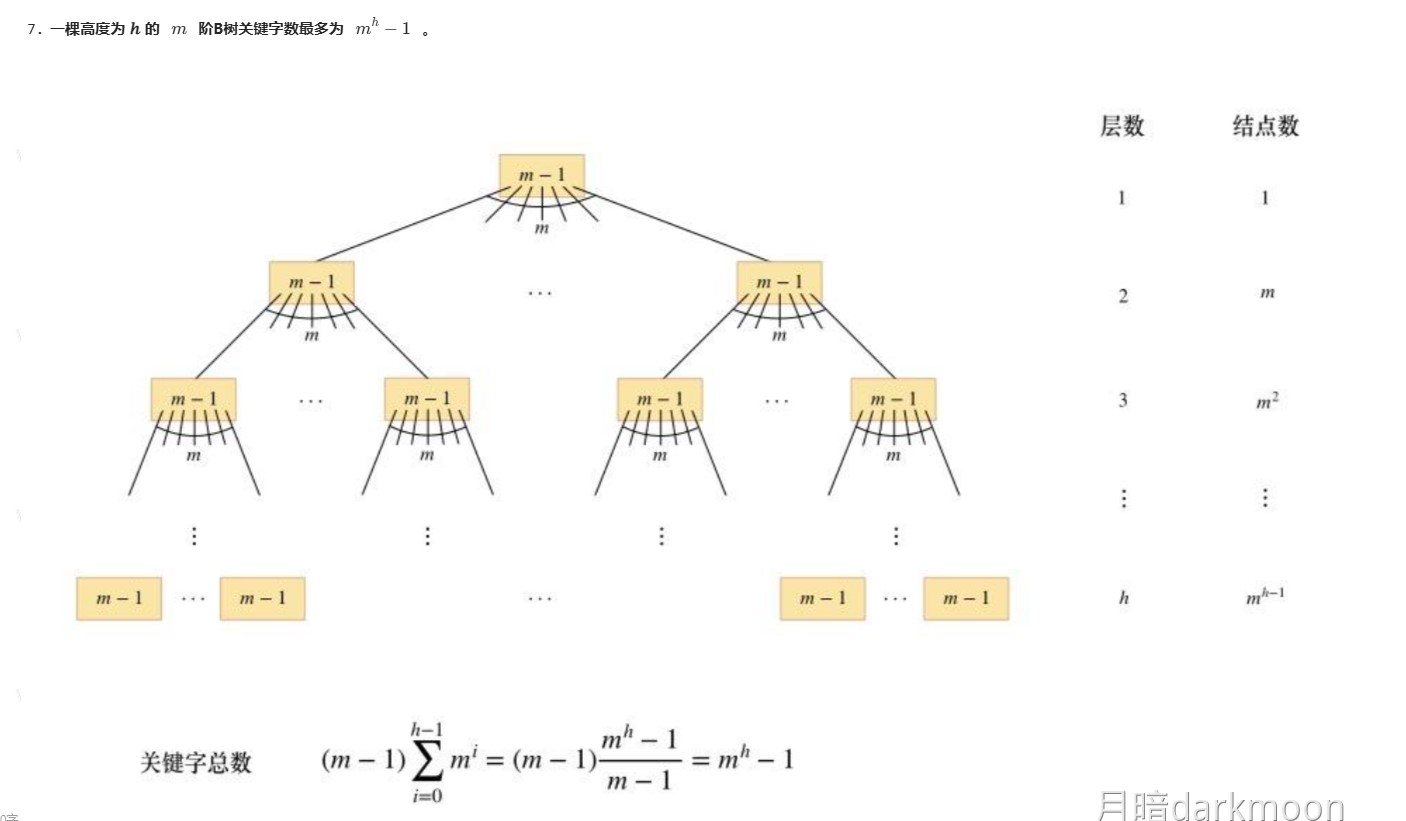

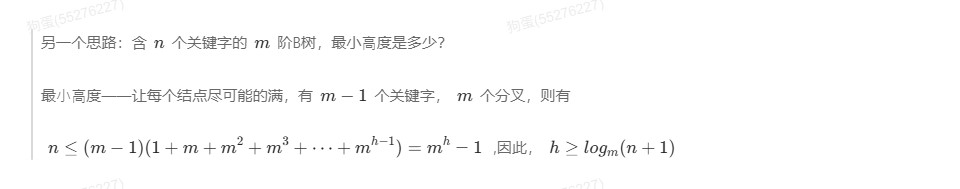

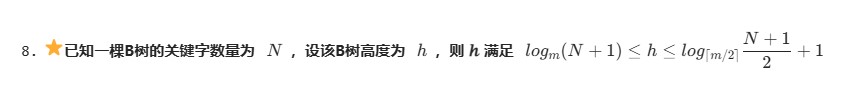

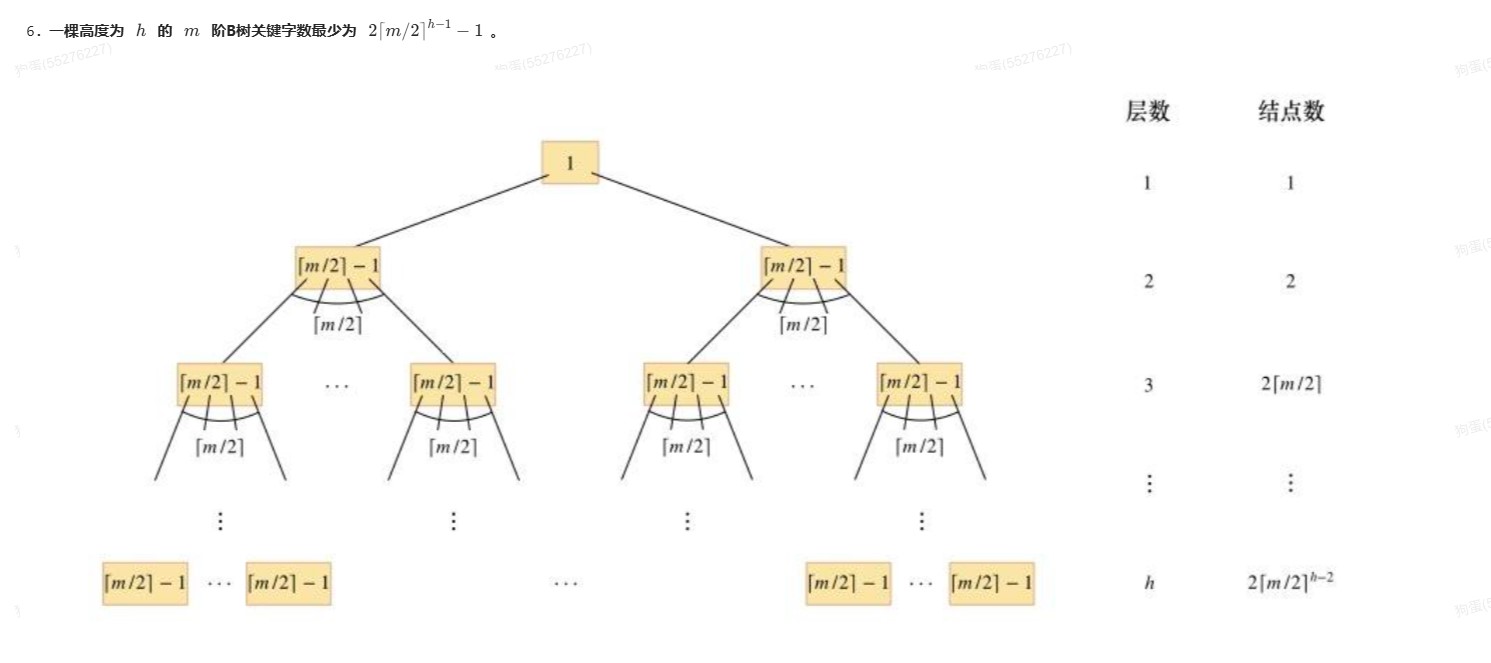

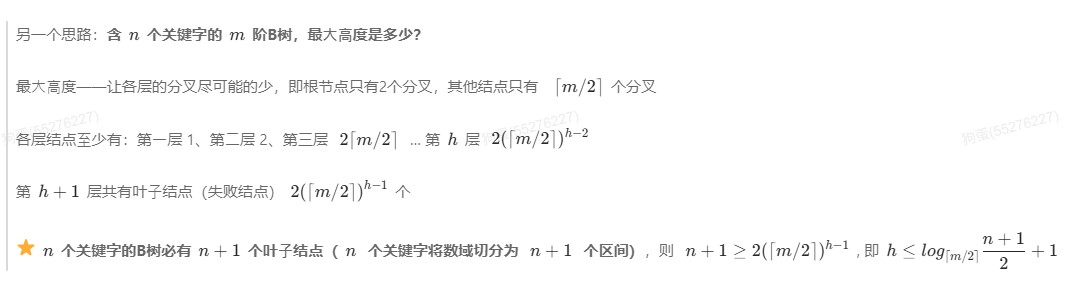

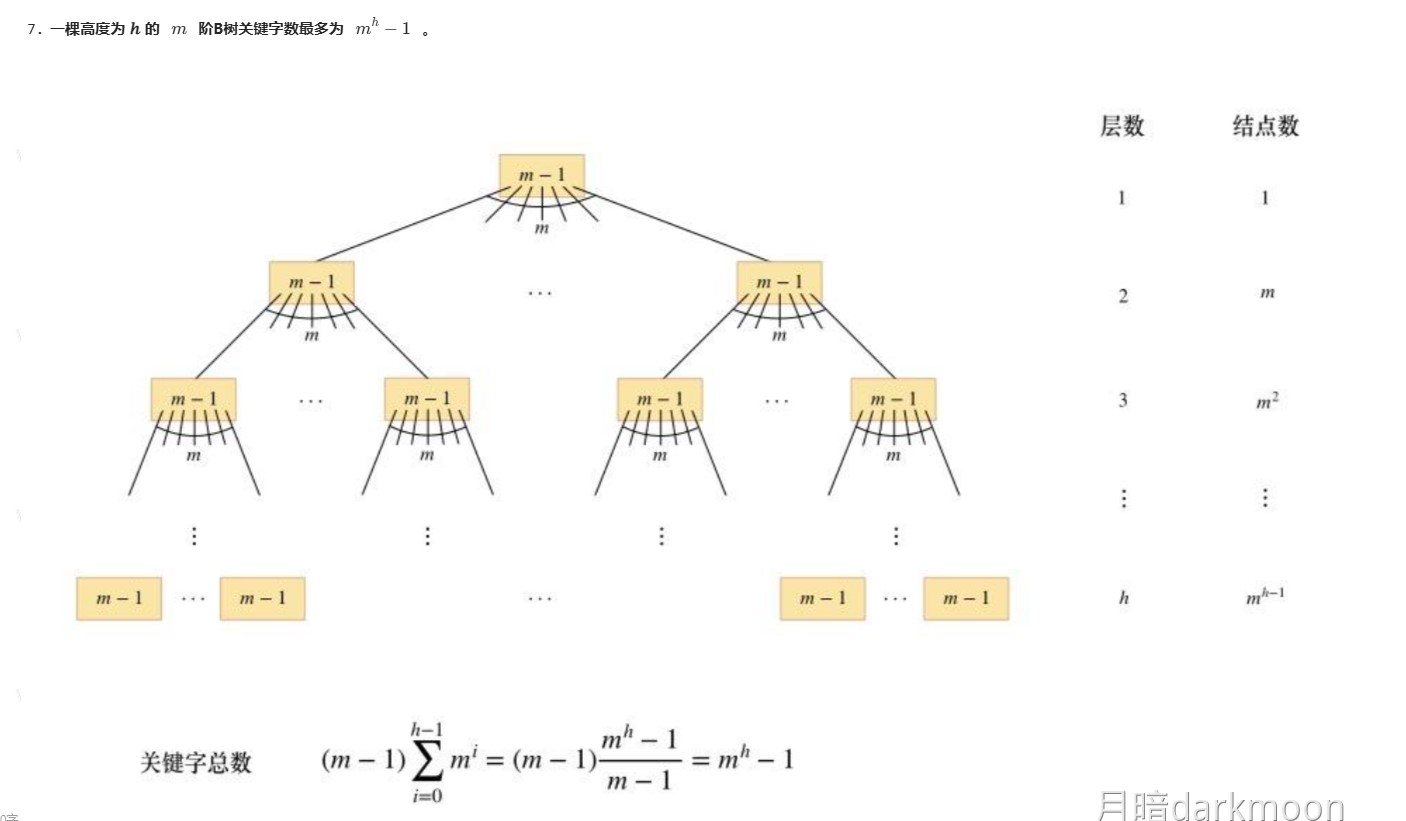

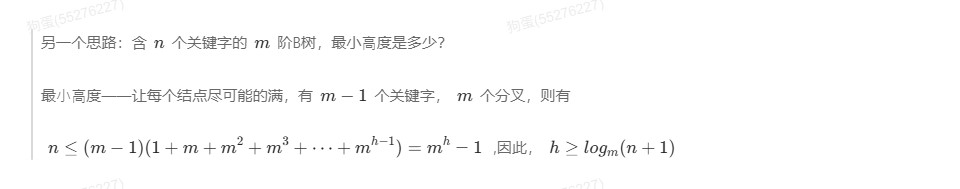

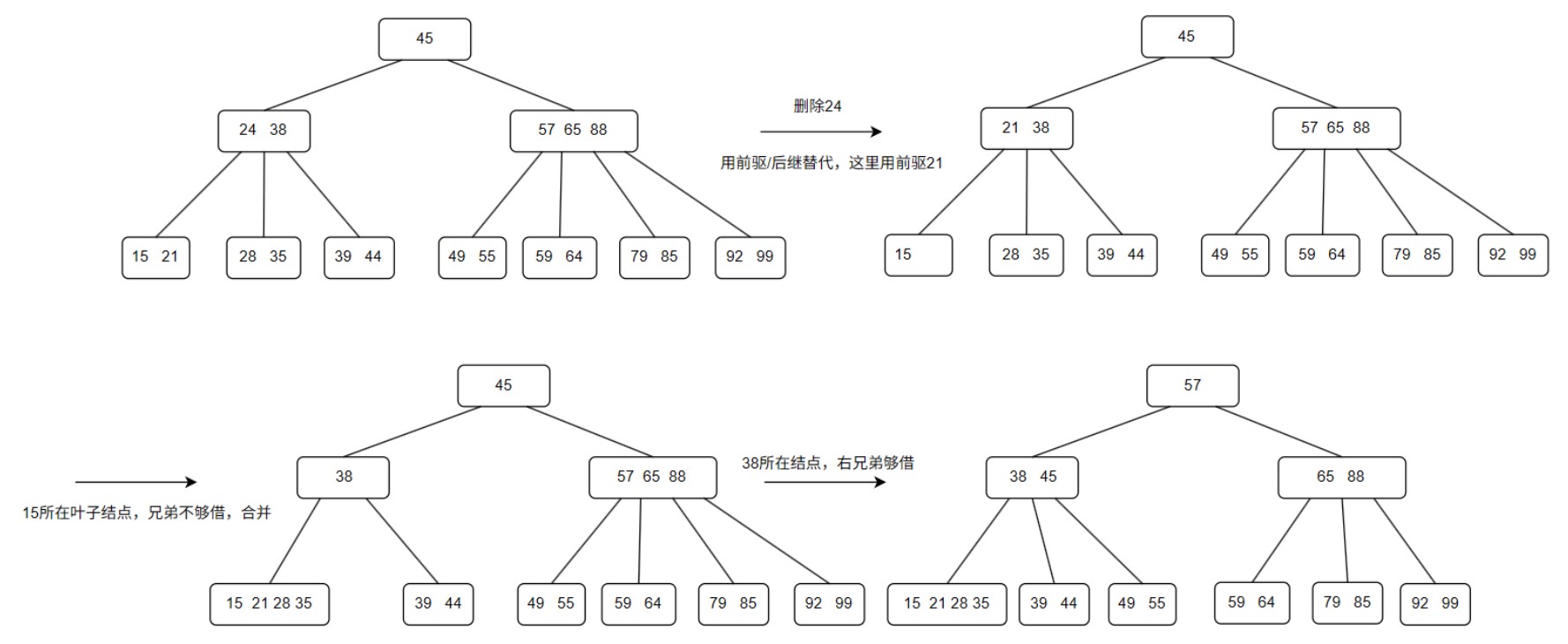

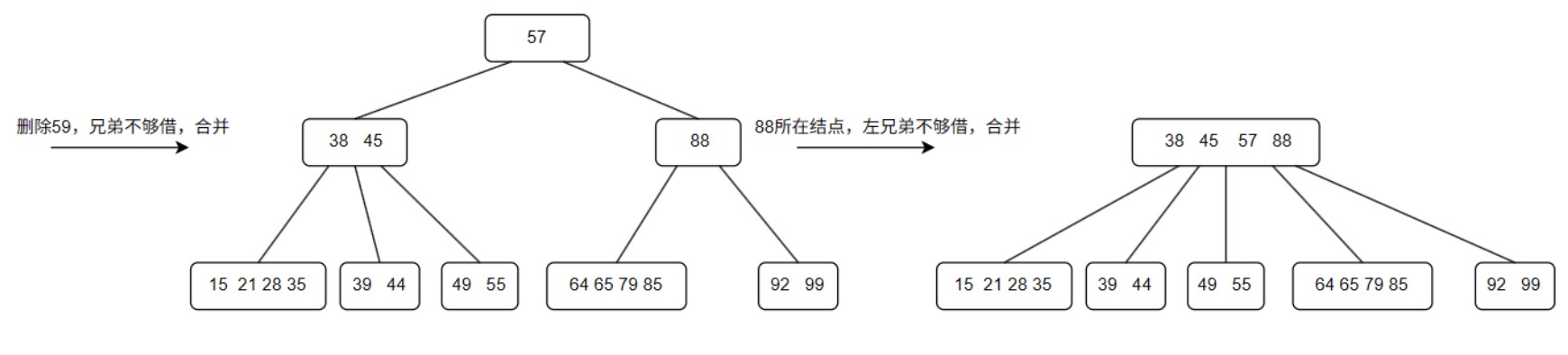

B树

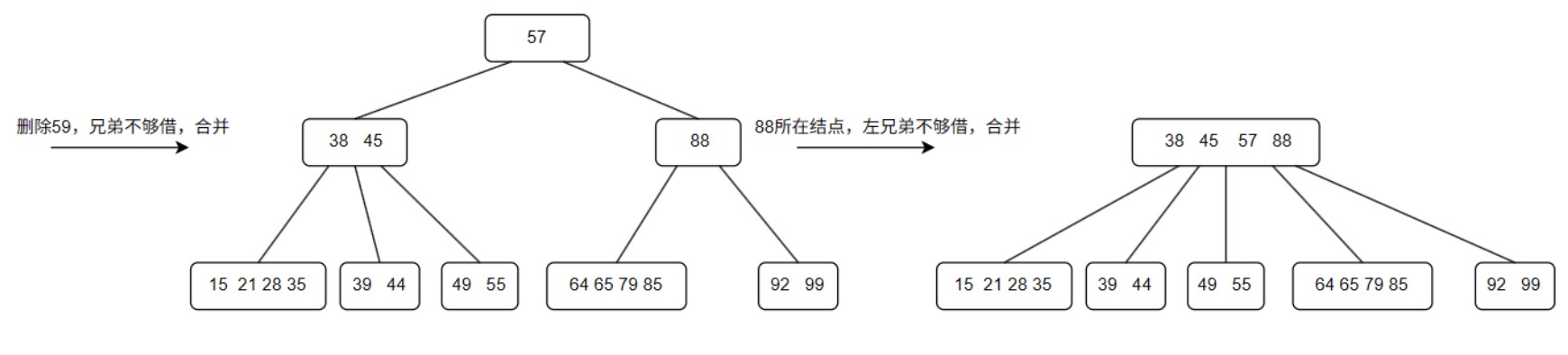

- B树的删除

- 叶子节点:直接删除

- 符合规则无需改动

- 不满足最低叶子节点:

- 兄弟够借借兄弟

- 兄弟不够借,合并兄弟节点和自己以及夹在中间的双亲结点

- 非叶子节点:删除后用直接前驱或者直接后继替代,相当于在叶子节点删除直接前驱或者直接后继

- 叶子节点:直接删除

- B树的插入

- 在一棵高度为h的B树中插入一个新关键码可能导致节点分裂,这种分裂过程可能从下向上一直到根节点,使得树的高度+1,假设内存足够大,在插入过程中为查找插入位置读入的结点一直在内存中,假设根节点高度为1,且根节点初始未读入内存,则最坏情况下可能需要读/写磁盘次数为3h+1

- 首先,从根节点找到插入位置需要进行h次读磁盘操作

- 在最坏情况下,在待插入结点中插入一个关键码后,导致节点分裂,在该层分裂成2个结点,因此需要2次读磁盘操作,分裂操作逐层向上传导,导致每一层都有节点分裂,因为节点分裂而导致的写磁盘操作总共有2h次

- 再加上最后一次节点分裂形成新根结点需要额外的一次写磁盘操作,写磁盘的总次数为2h+1

- 因此,整个过程中读写磁盘的总次数为3h+1

- 在一棵高度为h的B树中插入一个新关键码可能导致节点分裂,这种分裂过程可能从下向上一直到根节点,使得树的高度+1,假设内存足够大,在插入过程中为查找插入位置读入的结点一直在内存中,假设根节点高度为1,且根节点初始未读入内存,则最坏情况下可能需要读/写磁盘次数为3h+1

- 408真题将B树的叶节点定义为最底层的终端节点

- B树的查找包括①在B树中找节点;②在节点内找关键字。

- 由于B树经常存储在磁盘上,因此

- ①操作(在B树中找节点)在磁盘上进行

- ②操作(在节点内找关键字)在内存中进行

- 在磁盘上找到目标节点后,先将节点信息读入内存,然后再采用顺序查找法或折半查找法

- 在磁盘上进行查找的次数即目标节点在B树上的层次数,决定了B树的查找效率

- 由于B树经常存储在磁盘上,因此

- B树的查找时间复杂度为O(logn)

| B树应用 | B+树应用 |

|---|---|

| 数据库索引 | 数据库索引 |

| 文件系统的目录管理 | 文件系统 |

| 内存管理 | 内存数据库 |

| 搜索引擎的倒排索引 | 外部排序 |

B树的应用场景:

- 适合一般的索引结构,用于数据库索引和文件系统目录管理等。

- 支持插入和删除操作,但在范围查询时,相比B+树效率较低。

- 插入、删除操作的效率较好,因为所有节点都包含数据,因此能较为直接地查找到所需信息。

B+树的应用场景:

- 数据库和文件系统中更常用,因为B+树在范围查询方面性能更优。

- 所有数据存储在叶子节点中,叶子节点之间通过链表连接,可以快速进行范围查询。

- 高效的顺序访问和磁盘优化,特别适合处理大量数据时提高访问速度。

具体差异:

- 范围查询:

- B树:由于数据存储在所有节点中,进行范围查询时需要遍历整个树,效率较低。

- B+树:所有数据存储在叶子节点,且叶子节点通过链表连接,范围查询可以一次性访问所有相关数据,效率更高。

- 空间效率:

- B树:每个节点都存储数据,因此对于存储空间的需求相对较高。

- B+树:内部节点仅存储索引,节省了空间,且可以存储更多的索引信息,适合大规模数据存储。

哈希表

-

开放定址法中的平方探测法,要求k<=m/2,散列表长度m必须是一个可以表示为4k+3的素数

-

直接定址法不会产生冲突

-

失败时,分母是散列函数中的模的值(或者说初次探测可能会落在的区间,即min{散列表长度,散列函数中的模的值});成功时,分母是元素个数

-

数字分析法

-

平方取中法

-

线性探测法很容易造成同义词、非同义词的聚集“堆积”现象,严重影响查找效率

- 只有同义词的不叫聚集,只能叫冲突

-

平方探测法先正再负

-

双散列法只能缓解聚集现象,而不能避免

-

所有的开放定址法都无法避免聚集现象。

-

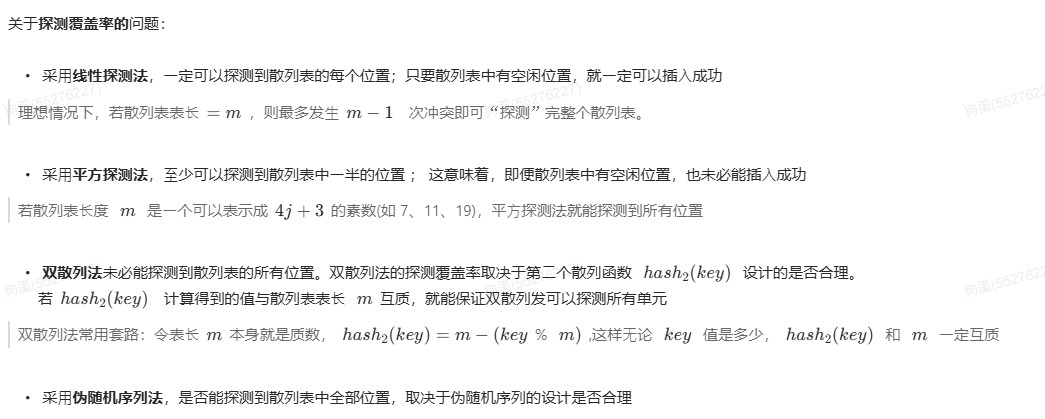

开放定址法四种方法的探测覆盖率问题

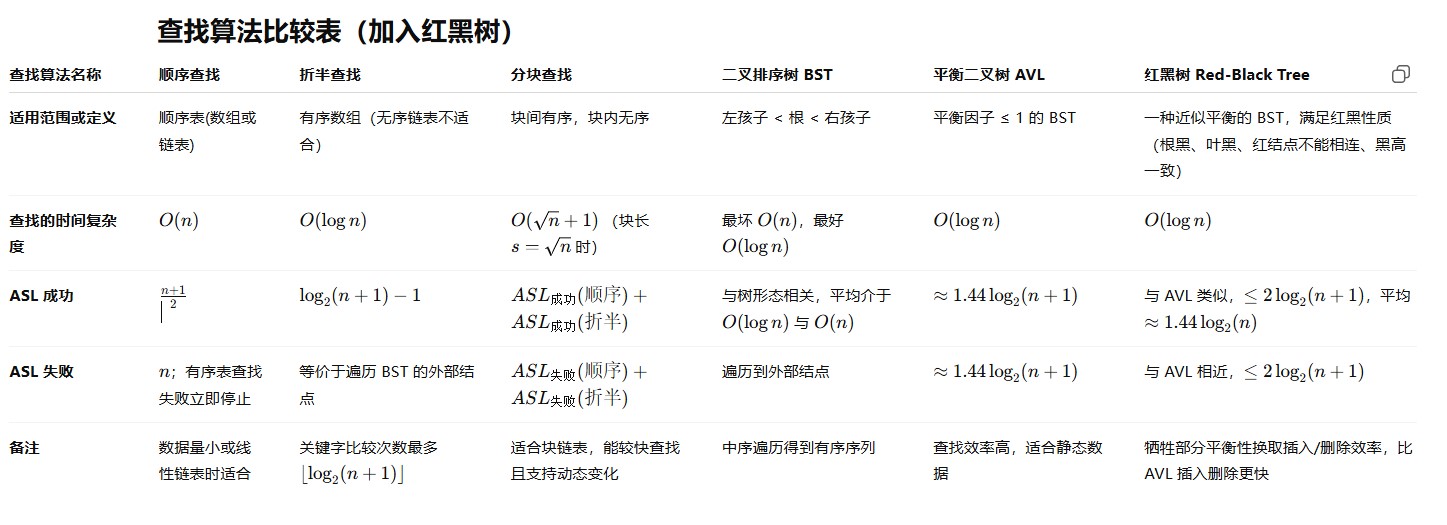

查找算法时间复杂度表

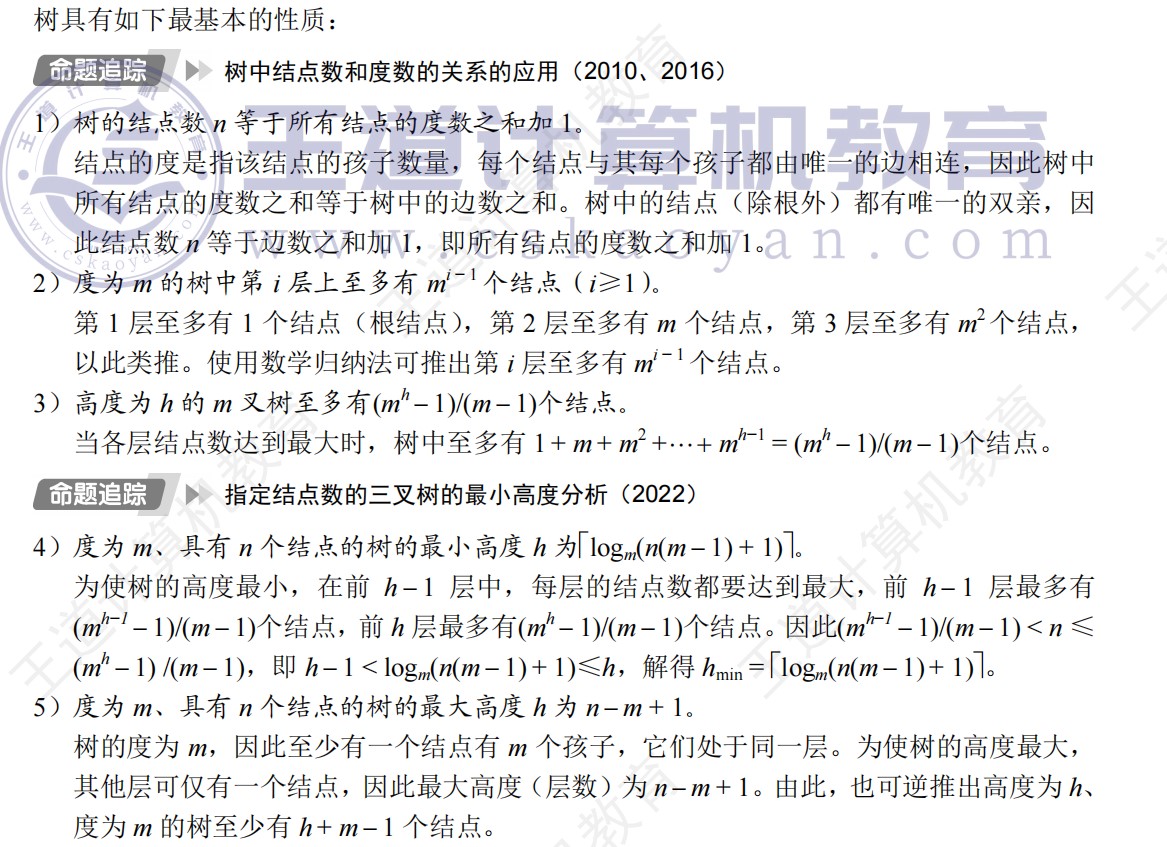

排序

-

从五个方面考察排序算法

- 时间复杂度

- 空间复杂度

- 常数辅助空间的算法

- 简单选择排序

- 插入排序

- 冒泡排序

- 希尔排序

- 堆排序

- 常数辅助空间的算法

- 稳定性

- 稳定的算法只有

- 插入排序

- 冒泡排序

- 归并排序

- 基数排序

- 计数排序

- 稳定的算法只有

- 适用性

- 顺序存储

- 折半插入排序

- 希尔排序

- 快排

- 堆排序

- 顺序存储和链式存储

- 冒泡排序

- 简单选择排序

- 归并排序

- 基数排序

- 顺序存储

- 过程特征

-

快速排序的枢轴值将序列划分的越平均排序速度越快

-

快速排序越有序,递归深度越深

-

直接插入排序与简单选择排序相比

- 直接插入排序元素比较次数少

- 简单选择排序移动的元素少

- 均为就地排序,空间复杂度均为O(1)

-

是否具有稳定性不能衡量一个算法的优劣

-

基数排序不基于比较操作

排序算法时间复杂度表

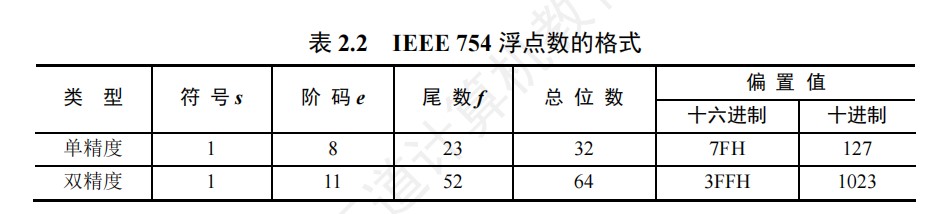

| 排序算法 | 平均时间复杂度 | 最好时间复杂度 | 最坏时间复杂度 | 空间复杂度 | 稳定性 | 就地性 | 适用数据对象 | 比较次数与初始状态关系 | 移动次数与初始状态关系 | 排序趟数与初始状态关系 |

|---|---|---|---|---|---|---|---|---|---|---|

| 插入排序 | O(n²) | O(n) | O(n²) | O(1) | ✔ 稳定 | 原地 | 数组/链表 | 有关 | 有关 | 无关 |

| 折半插入 | O(n²) | O(nlogn) | O(n²) | O(1) | ✔ 稳定 | 原地 | 数组 | 无关 | 有关 | 无关 |

| 希尔排序 | O(n^1.3) | O(n log n) | O(n²) | O(1) | ✘ 不稳定 | 原地 | 数组 | 有关 | 有关 | 无关 |

| 冒泡排序 | O(n²) | O(n) | O(n²) | O(1) | ✔ 稳定 | 原地 | 数组/链表 | 有关 | 有关 | 有关 |

| 快速排序 | O(n log n) | O(n log n) | O(n²) | O(log n) | ✘ 不稳定 | 原地 | 数组 | 有关 | 有关 | 有关 |

| 选择排序 | O(n²) | O(n²) | O(n²) | O(1) | ✘ 不稳定 | 原地 | 数组/链表 | 无关 | 有关 | 无关 |

| 堆排序 | O(n log n) | O(n log n) | O(n log n) | O(1) | ✘ 不稳定 | 原地 | 数组 | 有关 | 有关 | 无关 |

| 归并排序 | O(n log n) | O(n log n) | O(n log n) | O(n) | ✔ 稳定 | 非原地 | 数组/链表 | 有关 | 无关 | 无关 |

| 计数排序 | O(n+k) | O(n+k) | O(n+k) | O(n+k) | ✔ 稳定 | 非原地 | 数组 | 无关 | 无关 | 无关 |

| 基数排序 | O(d(n+r)) | O(d(n+r)) | O(d(n+r))顺序基数排序O(n + r) 链式基数排序O® |

✔ 稳定 | 非原地 | 数组 | 无关 | 无关 | 无关 | |

| 桶排序 | O(n+k) | O(n+k) | O(n²) | O(n+k) | ✔ 稳定 | 非原地 | 数组 | 无关 | 无关 | 无关 |

各个排序的操作顺序

插入排序

- 含义:找到插入位置,将后面的数据后移,空出位置后插入

直接插入排序

- ①找到插入位置k(涉及比较次数)

- ②k后面的所有元素依次向后移一个位置(涉及移动次数)

- ③插入

- L1视为固定,只需要进行n-1次插入操作

- 最多比较次数为n(n-1)/2

- 直接插入排序和自己之前的开始,依次往前比较,查到即停止

- 只有在线性表的初始状态为反序的情况下,直接插入排序过程中元素的移动次数才会达到最大值

折半插入排序

- ①二分找到插入位置k(涉及比较次数)

- ②k后面的所有元素依次向后移一个位置(涉及移动次数)

- ③插入

- 折半插入排序的比较次数与待排序表的初始状态无关,仅取决于表中的元素个数n;而移动次数并未改变,依赖于带排序表的初始状态

- 折半插入排序相对于直接插入优化的是比较次数

希尔排序

- ①根据增量分组

- ②在个组内进行直接插入排序(逐渐获得较好的局部有序性)

- ③重复上述过程

- 希尔排序的d是指从每组第一个数开始,从后数d个数加入同一组

- 组内直接插入排序的比较次数:和前面一个开始比,比到小的就停止

交换排序

- 根据序列中两个元素关键字的比较结果来对换这两个记录在序列中的位置

冒泡排序

- ①从后往前(或者从前往后)两两比较相邻元素的值,如果为逆序,则交换他们,直到序列比较完毕。(从前往后或者从后往前走一遍叫做一趟冒泡

- 冒泡排序在排序好以后还要再走一遍确认没有发生交换,表命已经有序,冒泡排序结束

- 每趟都有一个元素被放到最终的位置上

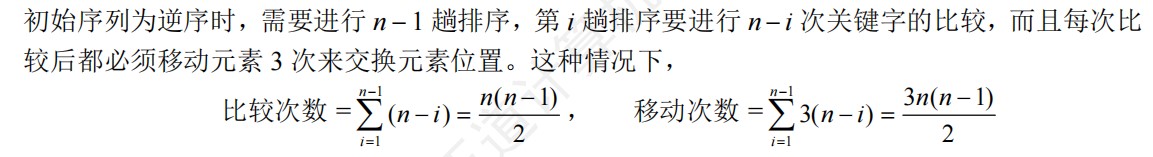

- 序列的逆序数不变,交换次数不变,移动次数=交换次数*3

- 只有在线性表的初始状态为反序的情况下,冒泡排序过程中元素的移动次数才会达到最大值

快速排序

- 注:此处所写过程为笔试考试过程,不同于yxc写的上机代码

- ①取首元素作为枢轴

- ②两个指针分别指向表头表尾

- ③表尾指针先动,找到第一个小于枢轴的元素,交换到i所指的位置

- ④表头指针往后走,找到第一个大于枢轴的元素,交换到j所指位置

- ⑤重复上述过程,直到i、j相遇

- ⑥将枢轴元素放到i==j的位置

- ⑦上述过程叫做一趟排序,重复上述过程,直到序列全局有序

- 快排是所有内部排序算法中平均性能最优的排序算法

- 快排不产生有序子序列,但每一趟排序后会将上一趟划分的各个无序子表的枢轴(基准)元素放到其最终的位置上。

- 快排比较次数的计算

- 长度为n的子表,比较n-1次,当子表长度为1的时候不进行比较。

- 快排序列的确定

- 第一层分界点不是端点,第二层必然存在左右半边,因此必然至少有三个点在正确的位置上

- 第一层分界点是端点,第二层只有一个区间,因此该区间内只有一个分界点,因此至少有两个点在正确的位置上,且其中一个点为端点

选择排序

- 基本思想:每一趟在后面n-i+1个待排序元素中选取关键字最小的元素,作为有序子序列的第i个元素,直到第n-1趟做完,待排序元素只剩下一个

简单选择排序

- ①找到待排序元素中的最小元素

- ②第i趟就同第i个数进行交换

- 简单选择排序的比较次数与序列初始状态无关,始终是n(n-1)/2次

堆排序

- 可以将堆视为一颗完全二叉树

- 不是二叉排序树

- 不是平衡二叉树

- ①将n个元素建成初始堆

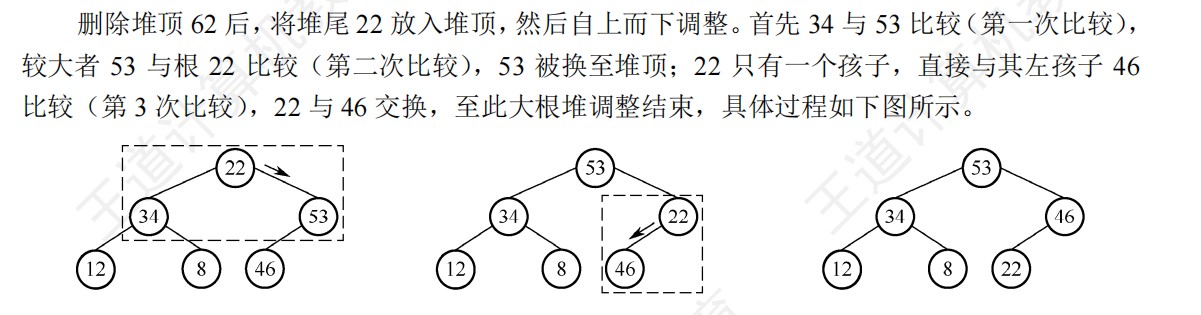

- ②输出堆顶元素,重新调整维持堆的性质

- 根节点的关键字小于左右孩子中关键字较大者,则交换

- 建堆时间复杂度O(n),建堆比较次数O(n),空间复杂度O(1),调整堆O(logn)

- 堆排序是所有时间复杂度为O(logn)的排序算法中空间复杂度最小的

- 在向n个元素的堆中插入一个元素的时候,比较次数最多等于树的高度-1,即log2n下取整

- 初始堆进行调整的时候,调节某一个分支节点子树的时候,一定要保证这个子树是大根堆后再调整下一个分支节点

- 堆排序的删除调整中,两个孩子先进行比较,然后孩子的最大值和根节点进行比较,两次比较都是单独算次数,并且只有变动的点经过的路径要进行比较

- 堆的插入调整中,只和根节点进行比较

- 注意初始堆是插入完毕后进行调整,而依次插入初始为空的大根堆是每次插入都要调整

- 由于堆是用于排序的,在查找的时候它是无序的,所以效率没有其他查找结构高

- 堆排序可以并行执行,因为根节点的左右子树构成的子堆在执行过程中是互不影响的

- 堆排序中,第二次调整堆的意思是,建堆以后进行的第二次调整

归并排序

- 奇数个归并段,最后一个段单独空出来,下一轮再参与归并

- 整个归并排序需要log2n上取整趟

- 对n个元素进行k路归并排序的时候,需要logkn上取整趟

- 每趟归并的时间复杂度为O(n)

基数排序

- 不基于比较和移动进行排序,基于关键字各位的大小进行排序

- 最高位优先MSD,最低位优先LSD

- 使用的是r个队列

- ①分配,根据关键字放入对应的队列

- ②收集,把各个队列的结点首尾相接,得到新的节点序列,从而组成新的线性表

- 求升序序列的情况下,从左到右收集,分配的时候也是从左到右分配

- 时间复杂度与初始序列状态无关

计数排序

- 思路:对每个待排序元素x,统计小于x的元素个数,利用该信息就可以确定x的最终位置。

- 当数组的值域过大,效率反而不如一些基于比较的排序

外部排序

-

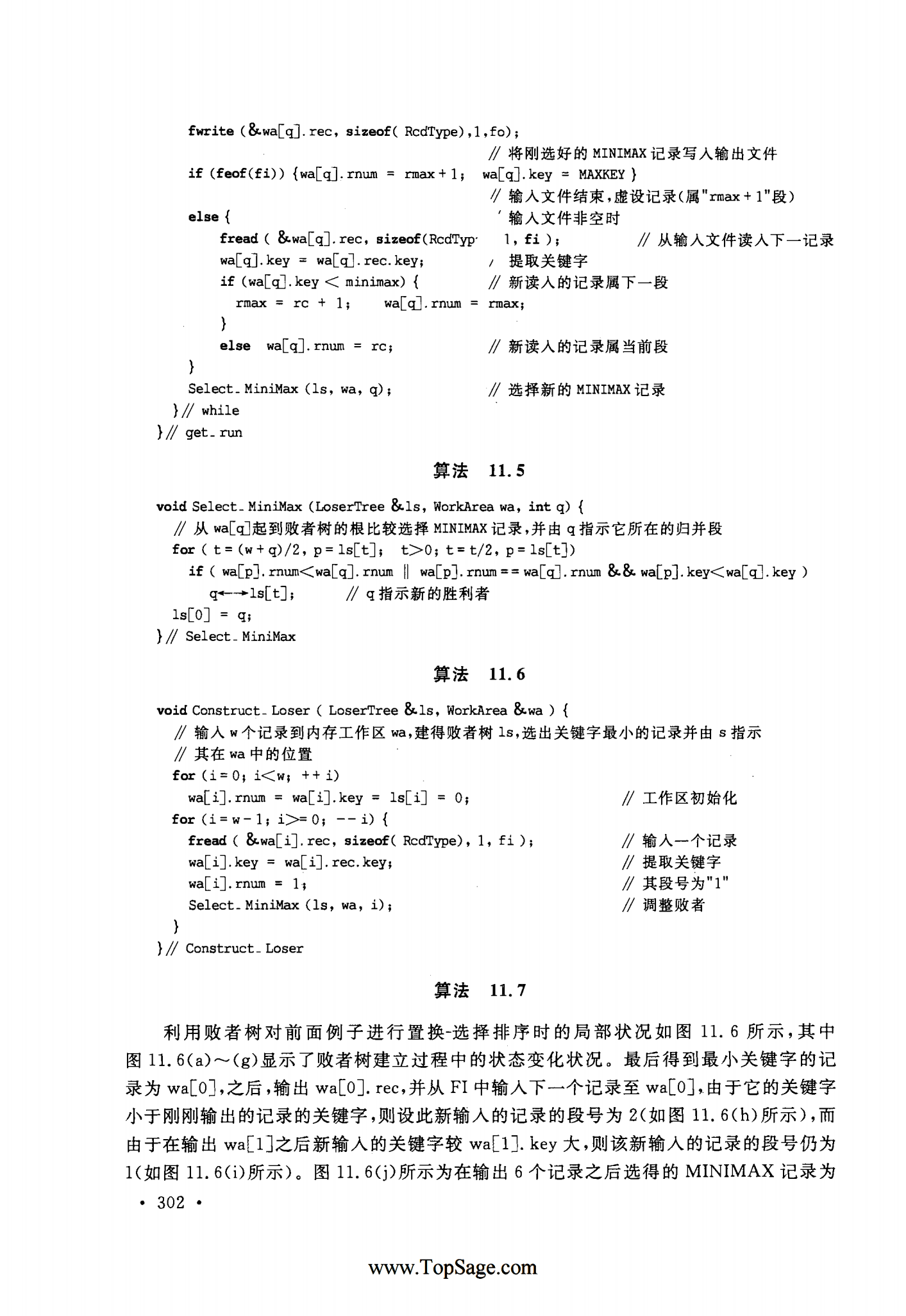

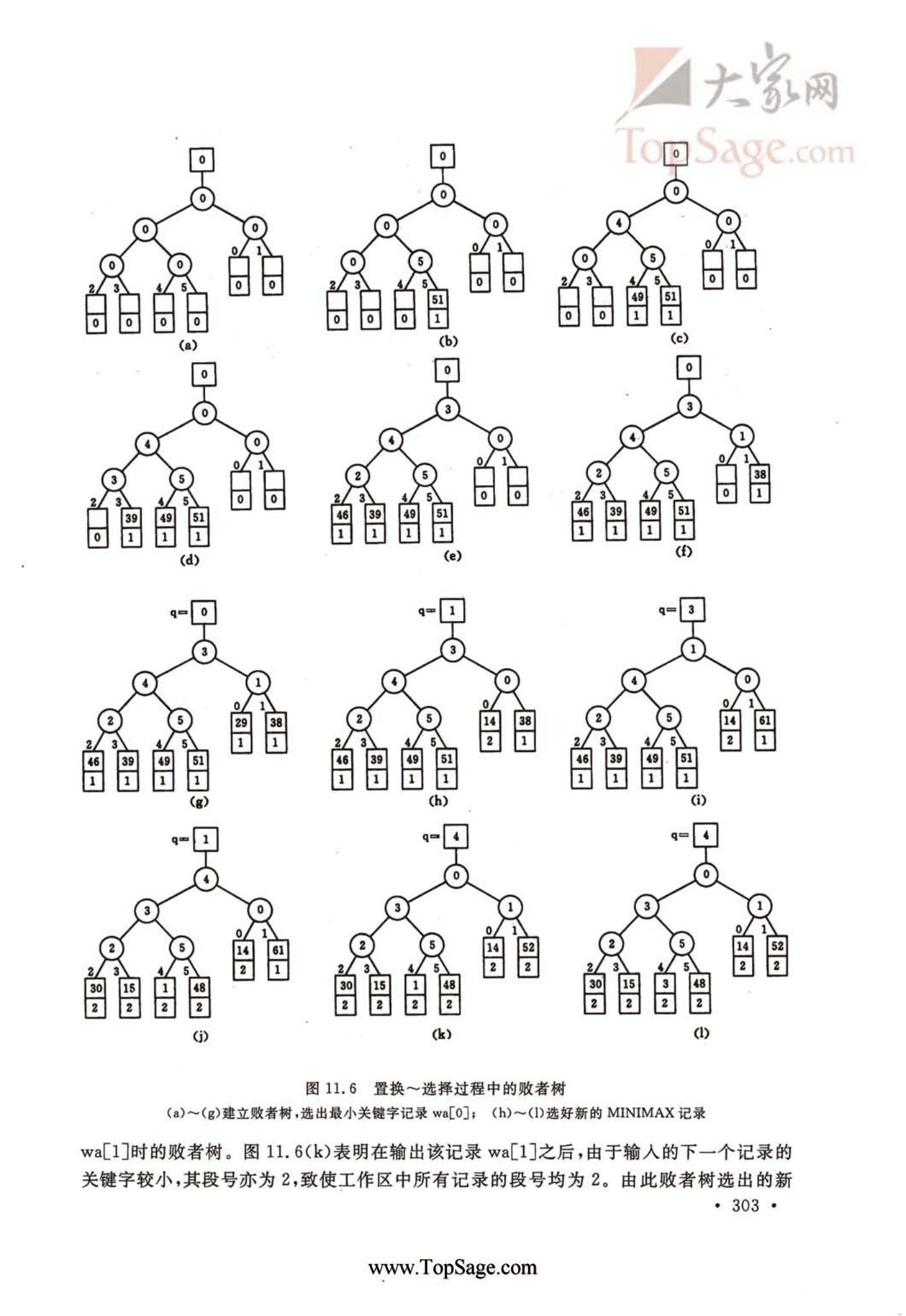

败者树的作用

- 增大归并路数,减少关键字对比次数

-

置换-选择排序的作用

- 增大归并段长度来减少归并段数量

-

最佳归并树(哈夫曼树)的作用

- 用于长度不等的归并段进行多路平衡归并

-

外部排序过程中的时间代价主要考虑I/O次数

-

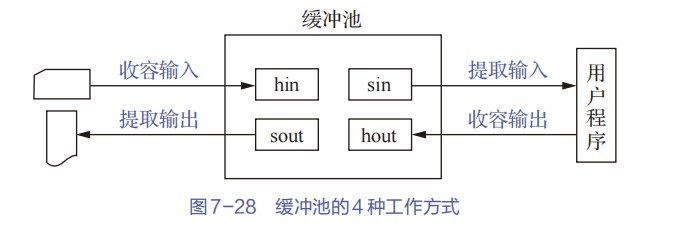

若要进行k路归并排序,则需要在内存中分配k个输入缓冲区和1个输出缓冲区

-

如何进行k路归并

- ①把k个归并段的块读入k个输入缓冲区

- ②用“归并排序”的方法从k个归并段中选出几个最小记录暂存到输出缓冲区中

- ③当输出缓冲区满时,写出外存

- 第一次生成的是初始归并段

-

外部排序时间开销=读写外存的时间+内部排序的时间+内部归并的时间

-

外部排序做题需要有全局思维,即有两块空间,一个是磁盘一个是内存,而这两大空间又能划分为n个子空间,也就是磁盘中的磁盘块,和内存中的输入缓冲区和输出缓冲区

- 一个归并段可能包含多个磁盘块,而读写次数以磁盘块为单位计算

- 由于归并段是内部有序的,所以在给多个归并段进行归并的时候,一般优先读取每个归并段最前面的磁盘块,而输出缓冲区满后写入磁盘的,也是写入最前面的磁盘块

-

外部排序的读写磁盘次数=文件总块数x2+文件总块数x归并趟数x2

-

k路归并≠k路平衡归并,k路平衡归并要求m个归并段参与归并,经过该趟处理得到m/k上取整个新的归并段

-

外部排序的优化流程

- 初始状态

- ①二路归并→多路归并→败者树

- 优化方向:

- ①多路归并

- 原理:减少归并趟数,从而减少I/O读写次数

- 归并趟数=logkr上取整

- k越大,r越小,归并趟数越少,读写磁盘次数越少

- 归并趟数=logkr上取整

- 缺点:

- k路归并需要k个输入缓冲区,内存开销增加

- 每挑选一个关键字需要对比关键字k-1次,内部归并所需时间增加

- 优化方向:

- ①败者树

- 第一次构造k路归并败者树需要比较k-1次,有了败者树之后,关键字对比次数减少到log2k上取整

- k个叶节点分别对应k个归并段中当前参加比较的元素,非叶子节点用来记忆左右子树中的失败者,而让胜者一直往上比较,一直到根节点

- 叶子节点是虚拟的

- 根节点记录冠军来自哪个归并段,分支节点记录失败者来自哪个归并段

- 败者树的每次维护必定要从叶节点一直走到根节点,不可能从中间停止

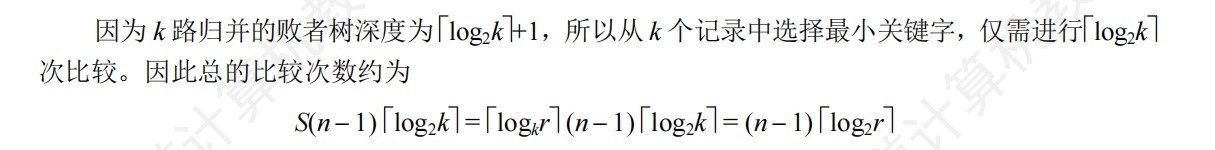

- 使用败者树后,内部归并的比较次数与归并路数无关,总的比较次数=(n-1)(log2r上取整)

- n是归并的元素个数,r是初始归并段的数量

- k路归并败者树的建树时间复杂度为O(klog2k),空间复杂度O(n),调整一次的时间复杂度O(logn)

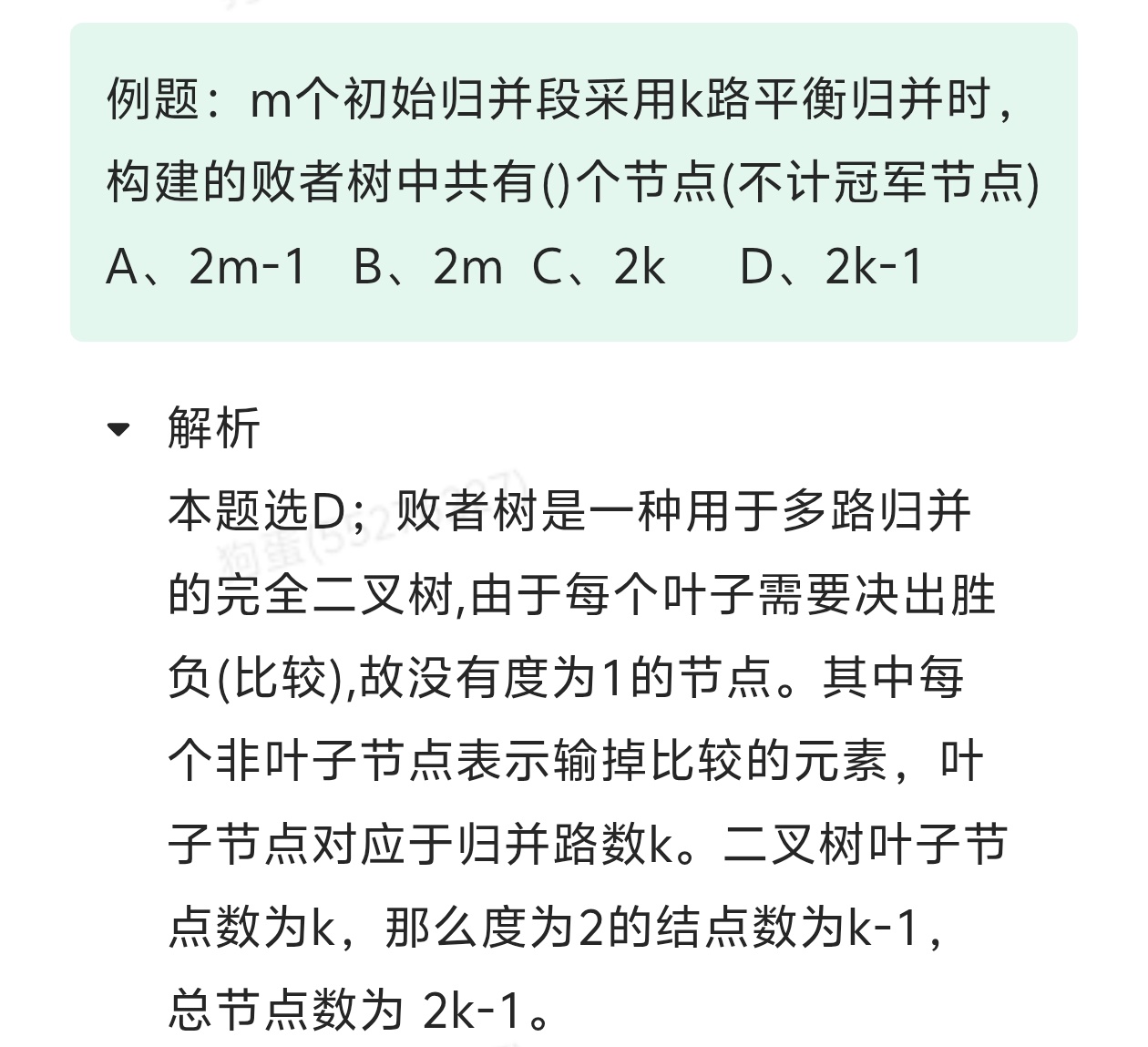

- 败者树是一颗完全二叉树,初始归并段的个数就是叶子节点个数,因此计算高度时要把初始归并段算作叶子节点

- 败者树胜者胜出输出后,胜者所在的那个归并段的下一个元素上位,然后败者树重新调整,从这个上位元素所在的子树开始调整,一直维护到根节点即新胜利者出现

- ①败者树

- 优化方向:

- ②形成N/L个初始归并段(N为记录总数,L为内存工作区可以容纳L个记录)→置换-选择排序→最佳归并书

- 优化方向:

- ①置换选择排序

- 可以让每个初始归并段的长度超越内存工作区大小的限制

- 问题:长度不同的情况下如何决定哪几个归并段进行归并

- 优化方向:

-

①最佳归并树

- 归并过程中的磁盘I/O次数=归并树的WPL*2=非叶节点的权值之和x2

- 注意总体I/O次数还要加入构造初始归并段的I/O次数,即磁盘块块数*2

- 归并过程中的磁盘I/O次数=归并树的WPL*2=非叶节点的权值之和x2

-

②败者树优化置换选择排序比较次数(注意k路归并最先放在A[k-1],从后往前放

-

- 优化方向:

- ①置换选择排序

- 优化方向:

- ①二路归并→多路归并→败者树

- 初始状态

-

最佳归并树和败者树的区别

- 最佳归并树用于决定哪几个归并段进行归并,而败者树用于在这几个归并段进行归并的时候,减少关键字比较次数,形成新的归并段

-

败者树补充

-

外部排序的归并趟数不算生成初始归并段的那趟,只算生成初始归并段以后的排序趟数

CO(计组)

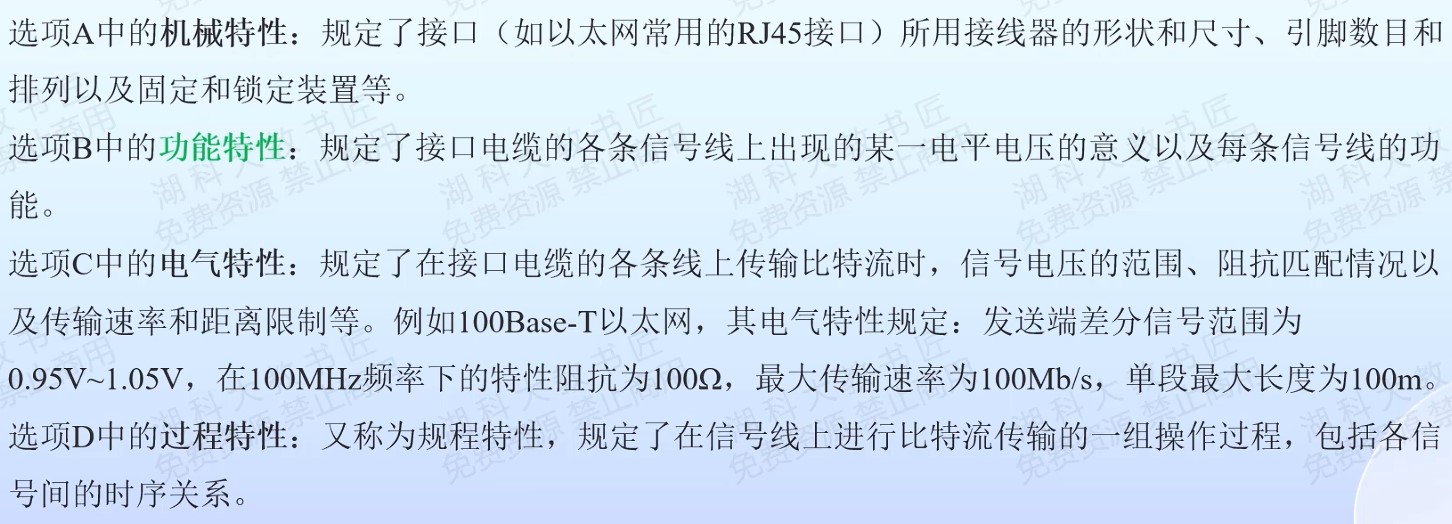

计算机系统概述

- 编译程序产生的目标代码执行效率高,但是可移植性较差;解释程序具有较好可移植性,但执行效率较低

- 向后兼容是指时间上向后兼容,即新机器兼容使用以前机器的指令系统。

- 全面代表计算机性能的是实际软件的运行情况

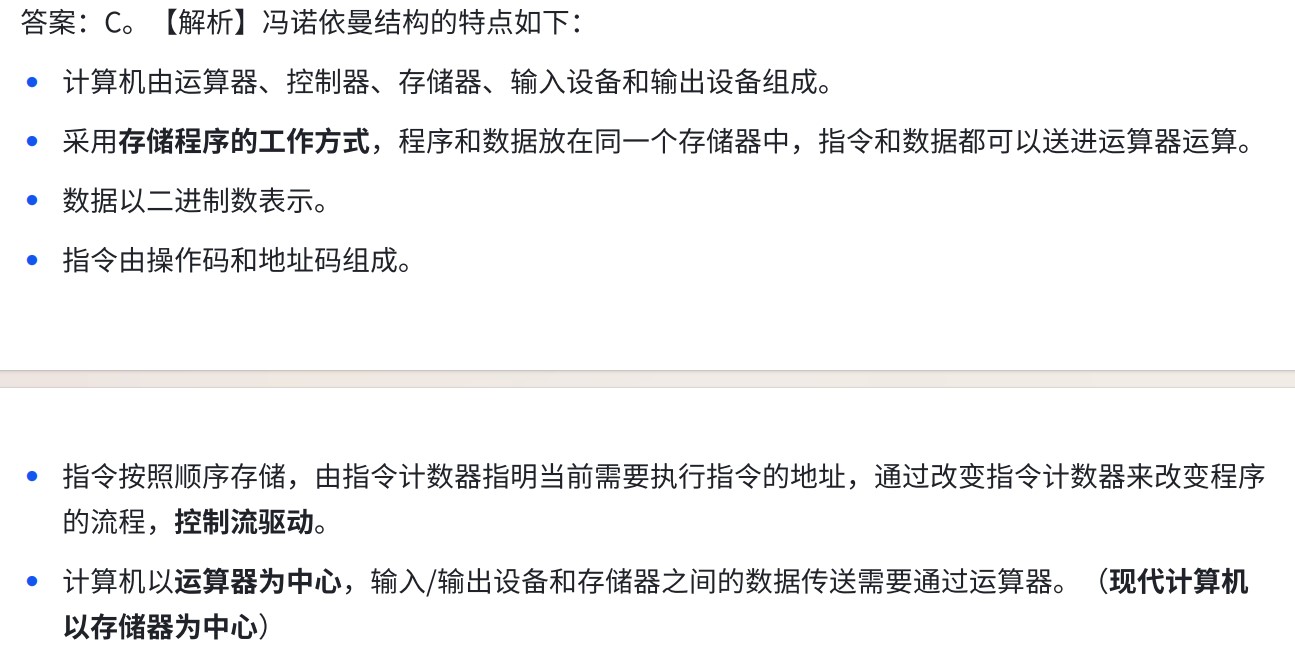

冯诺依曼计算机的特点

- 输入设备都必须有离散化和编码两方面的功能

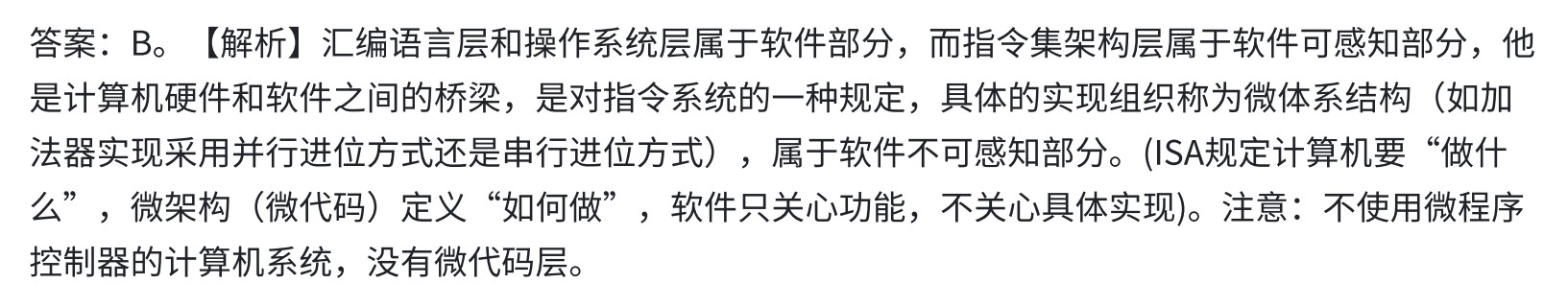

计算机分层系统

计算机性能指标

- MIPS=(主频/CPI)/10^6

- 时间=CPI*指令总数/主频

- 影响平均CPI的因素

- 微体系结构决定硬件执行指令的效率

- 如流水线、超标量、分支预测等

- 指令调度策略用于优化指令执行顺序,减少数据依赖或者控制依赖导致的冒险

- 如编译器静态调度或硬件动态调度

- 指令系统结构直接决定指令的复杂度和执行效率

- 如RISC或CISC

- 微体系结构决定硬件执行指令的效率

- 系统的吞吐量主要取决于主存储器的存取周期

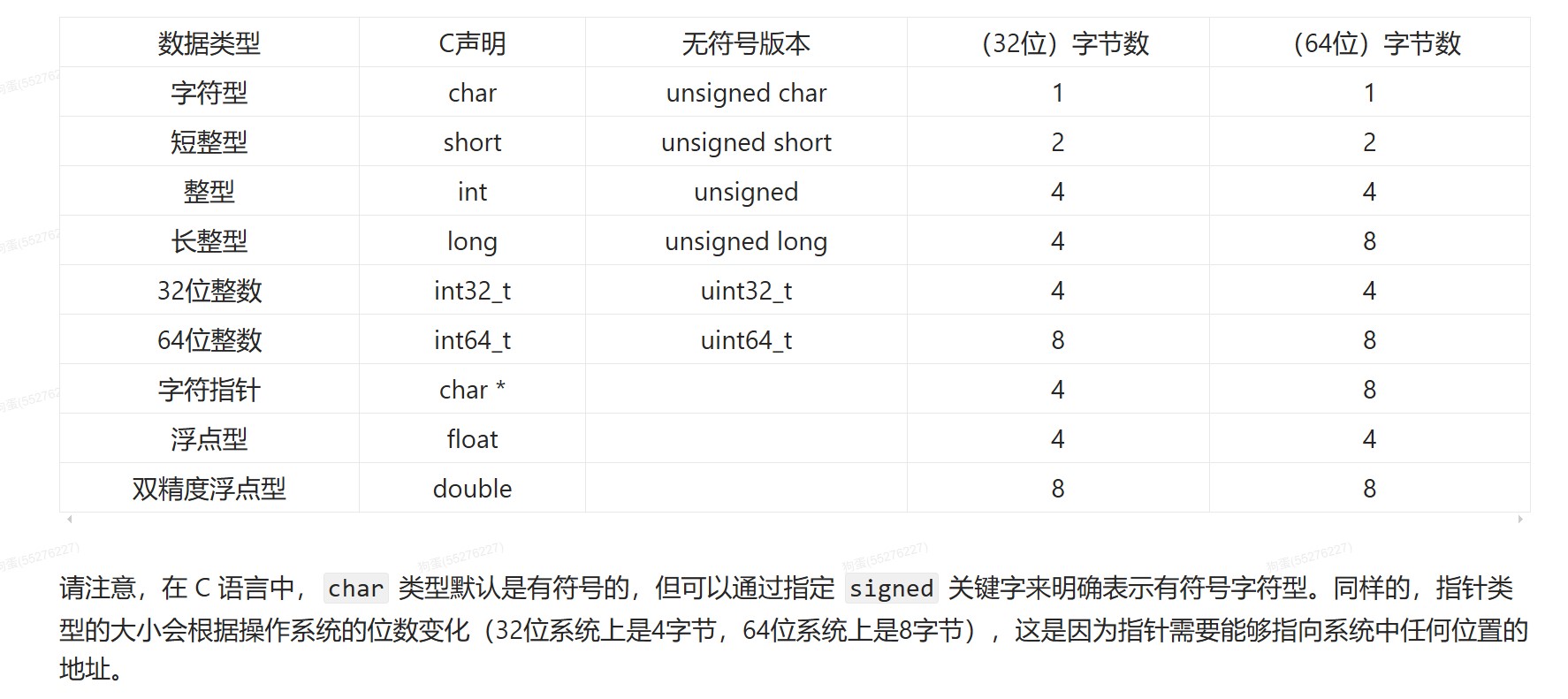

各种字长的总结

- 机器字长

- CPU在同一时间内一次能够处理的二进制的位数,相当于CPU中定点运算数据通路的位数

- 一个字的宽度并不等于机器字长

- 通常与CPU的寄存器位数、加法器有关

- 一般等于通用寄存器的大小

- 字长越长,数的表示范围越大,计算精度越高

- 编址单位

- 存储单元的宽度,也就是按多少位存储

- 存取宽度

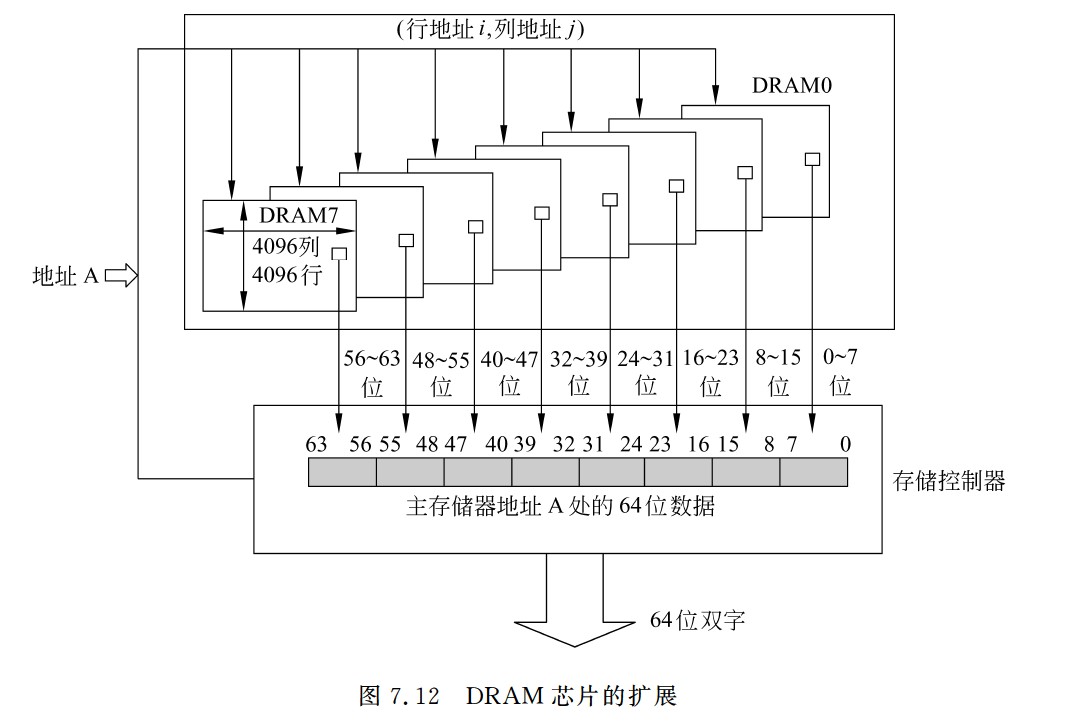

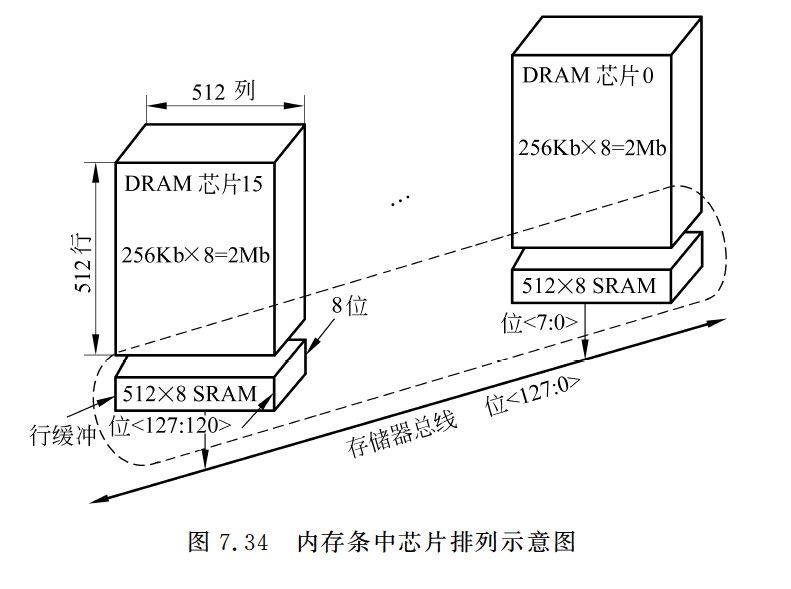

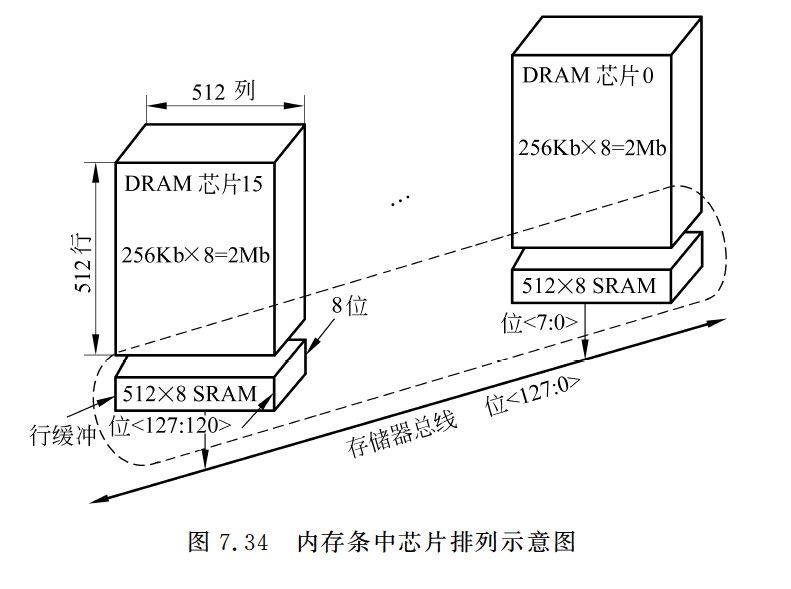

- 一次从由多个DRAM芯片构成的存储模块(即主存)中同时读写的信息的宽度

- eg:假定某个存储模块由8个4096*4096 * 8位的DRAM芯片按交叉编址方式构成,则该存储模块的存取宽度是64位,也即,8个芯片可同时读写,每个芯片同时读8位,因而最多可以同时存取64位信息

- 传输宽度

- 总线宽度,一次最多能在总线上传输的数据位数,对于存储器总线来说,总线上传输的信息宽度应该等于存储器的存取宽度,因此在设计系统时,应该考虑传输宽度和存取宽度的匹配,并且每个设备中的总线接口部件也要与这些宽度匹配。

- 指令字长

- 指令的位数,有定长指令字机器和不定长指令字机器。定长指令字机器中所有指令的位数是相同的,因此定长指令字大多是32位。不定长指令字机器的指令有长有短,但每条指令的长度一般都是8的位数。因此,一个指令字在存储器中存放时,可能占用多个存储单元;从存储器读出并通过总线传输时,可能分多次进行,也可能一次读多条指令

- 指令字长决定了IR寄存器的位数

- 存储字长

- 一个存储单元的位数,也就是CPU向内存某个地址取数据时一次性取走的数据量

- MDR位数与总线中的数据线宽度相等, 与存储字长不一定相等,与ALU的位数也不一定相等,也就是说MDR只对数据通路负责

- 因为数据可以多次存取,但是数据的输入接口必须能够对接

- 机器字长、存储字长、指令字长之间的长度关系

- 存储字长和机器字长的关系

- 机器字长>=存储字长,通常是存储字长的整数倍,相等的时候方便一次性存取计算

- 存储字长和指令字长的关系

- 半存储字长指令、单存储字长指令、双存储字长指令

- 机器字长和指令字长之间没有约束关系,机器字长强调操作数长度,指令字长强调指令长度

- 存储字长和机器字长的关系

数据的表示和运算

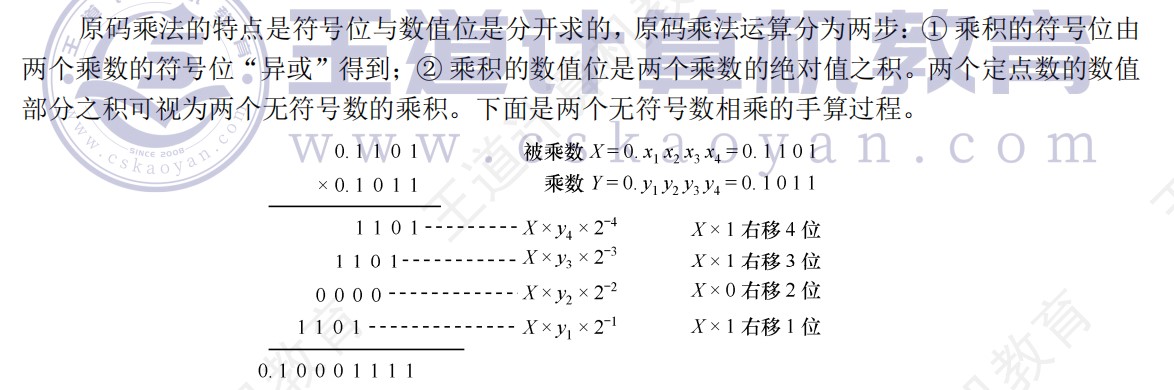

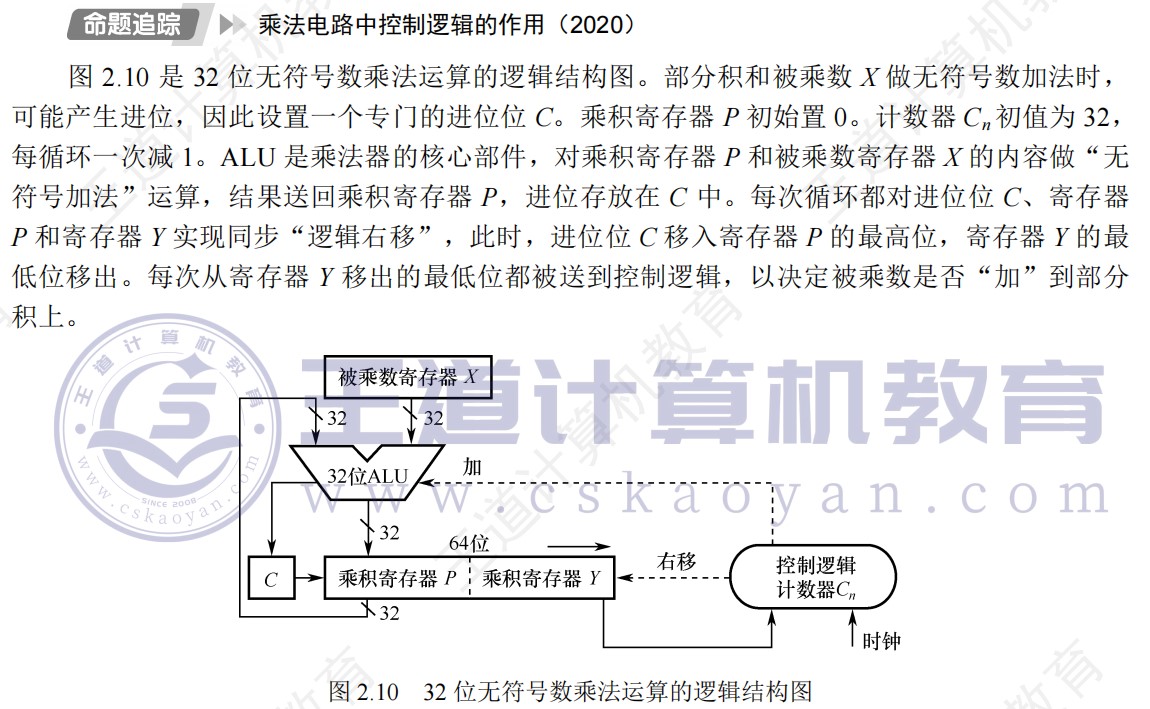

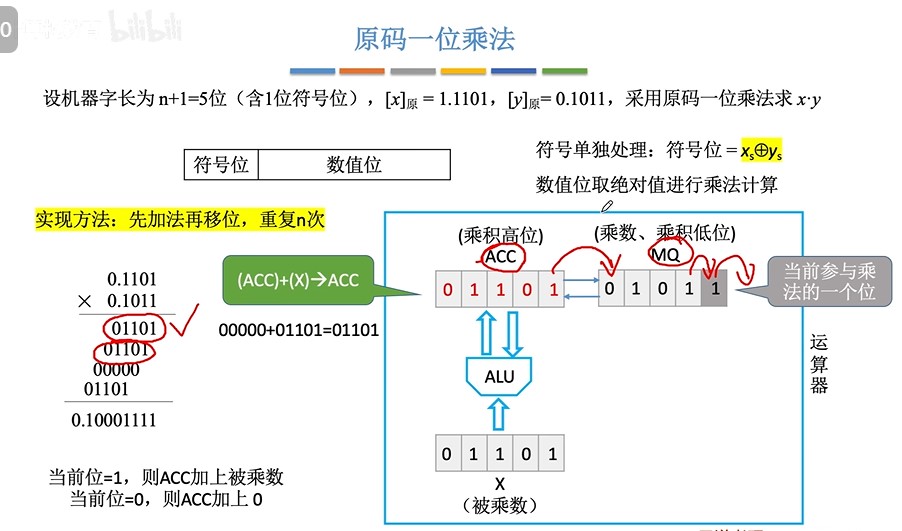

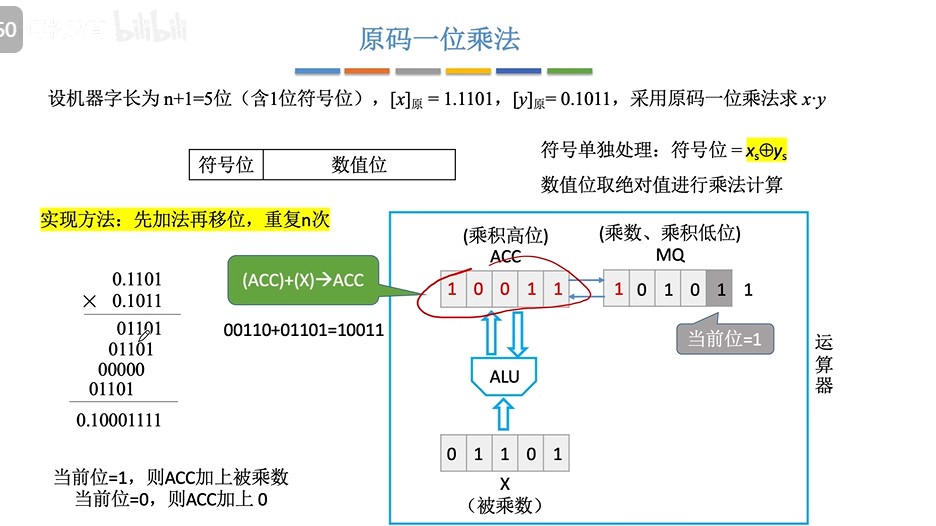

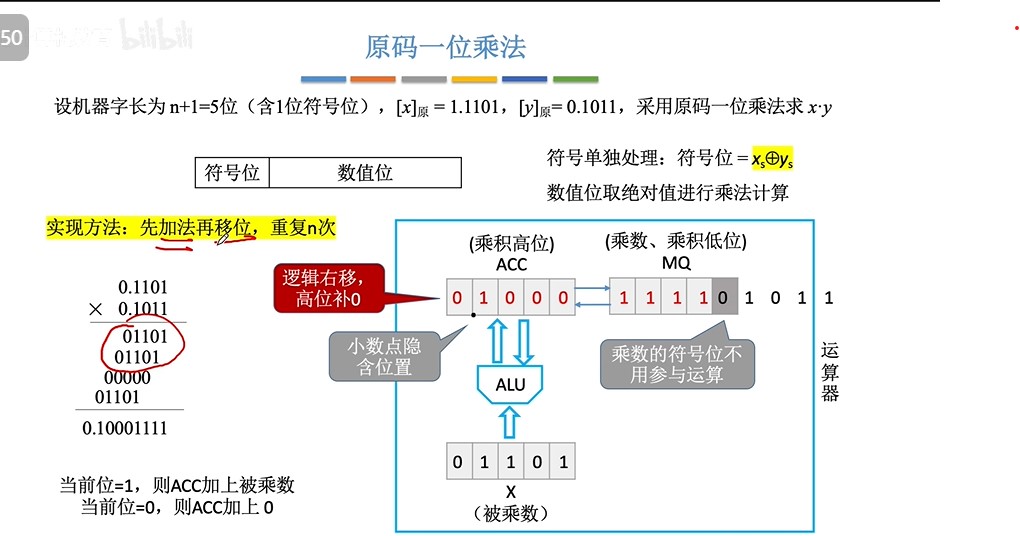

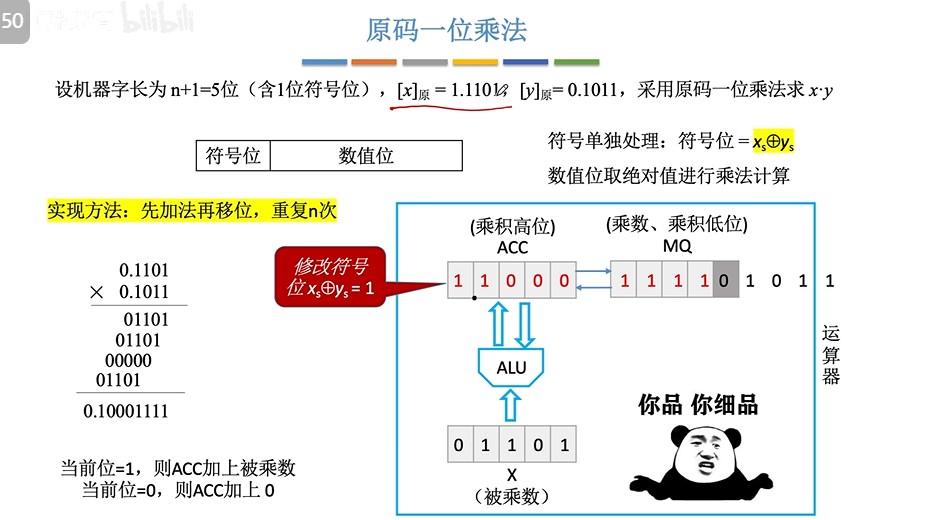

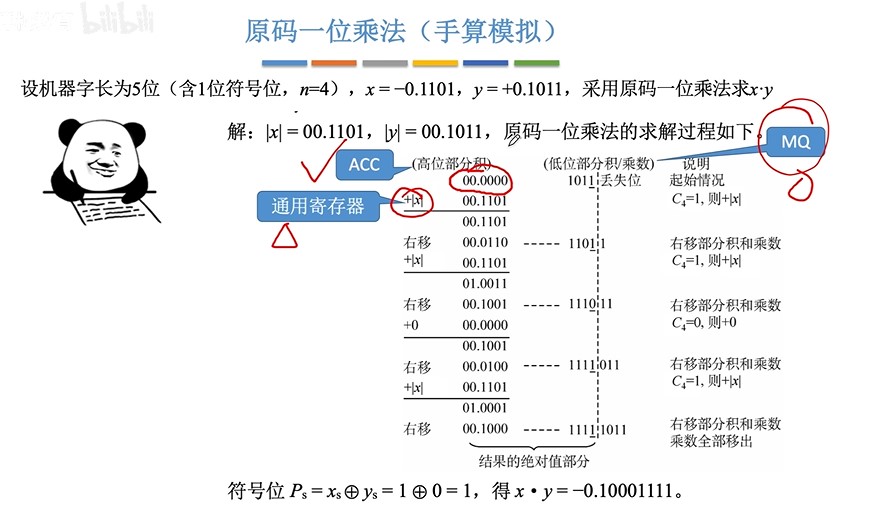

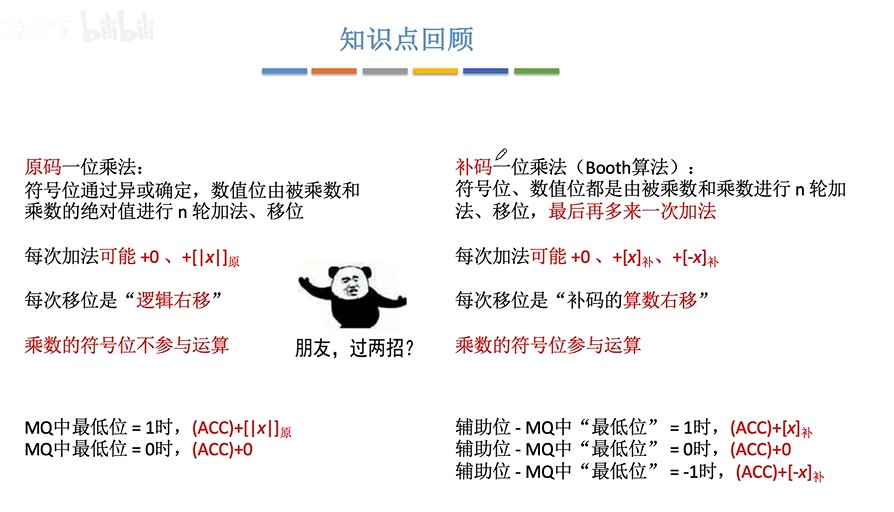

- 原码一位乘共进行n次加法和n次逻辑右移

- 补码booth乘法共进行n+1次加法和n次算术右移

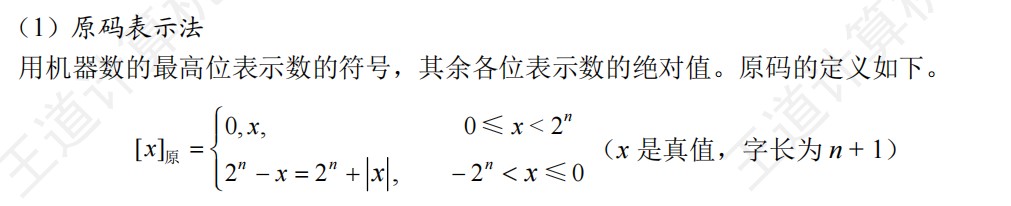

- 补码的本质是取模,对于补码表示的定点小数,模数是2,对于补码表示的定点整数,模数是2^(n+1)(n+1位补码)

- 两个短相加变长,会先对两短进行扩展,扩展的时候按照短自己的类型进行扩展(短的是无符号数就0扩展,是有符号数就符号扩展)。

-

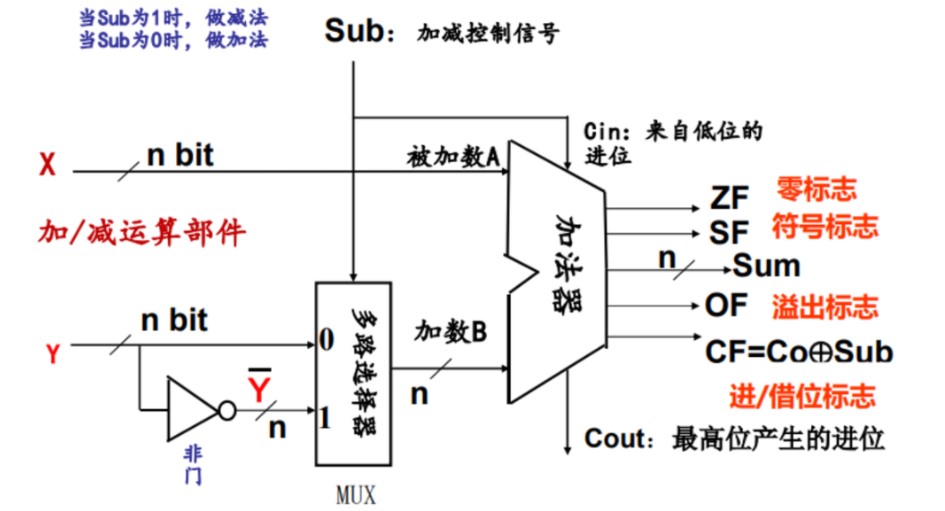

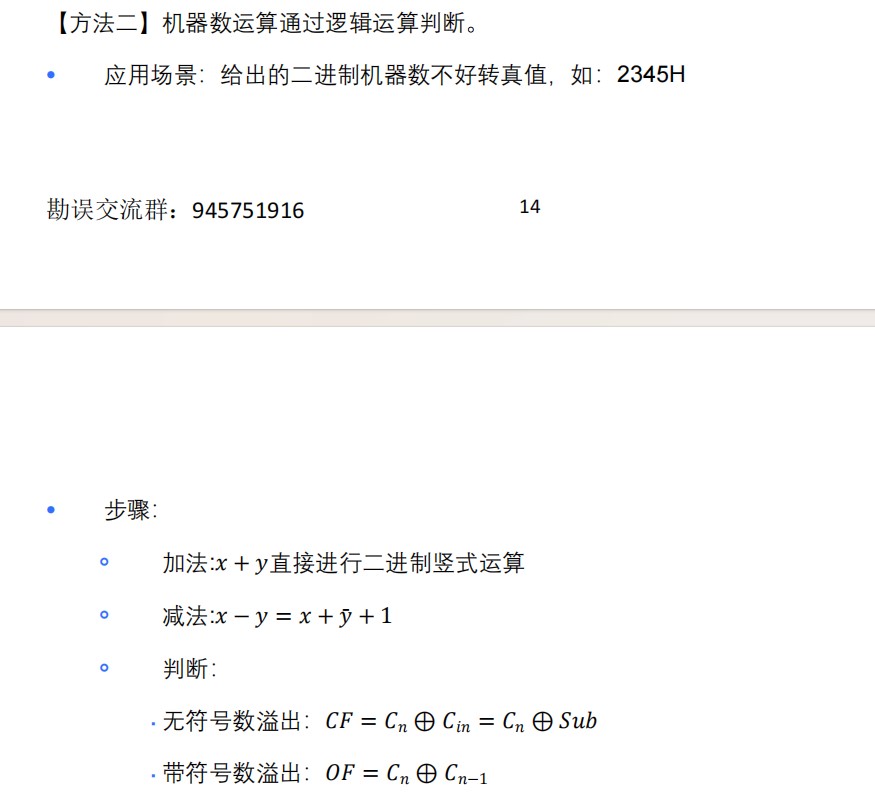

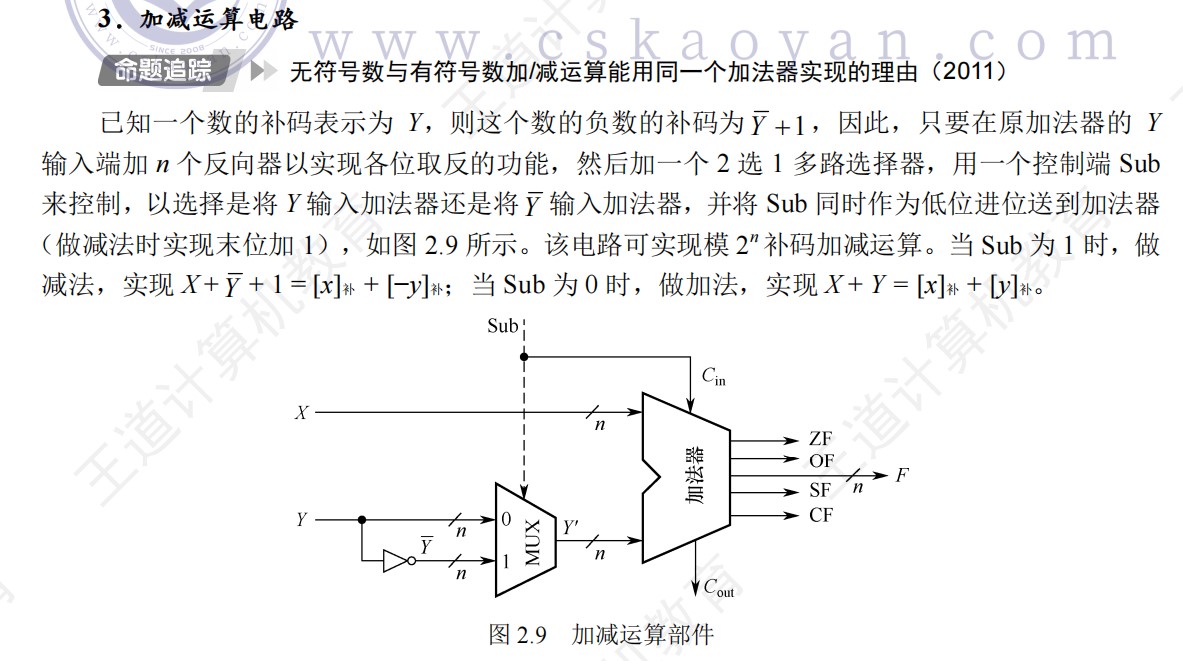

加减法电路

sub=1,一个作为控制信号传到多路选择器控制取反后的Y进入加法器,而另一个作为cin也就是低位的进位加到加法器

最好会画

-

并不是每个十进制小数都可以准确地用二进制小数表示,但是任意一个二进制小数都可以用十进制小数表示

-

定点小数是纯小数,没有整数部分,约定小数点的位置在符号位后,有效数值部分最高位之前

-

定点整数是纯整数,没有小数部分

-

负数补码大小的快速判断

- 数值位部分越小,其绝对值越大,即负得越多,即越小

-

无符号整数主要用于表示指针、进行地址运算

-

char在C语言中是有符号的

-

C语言常见的类型都是用补码形式存储的

-

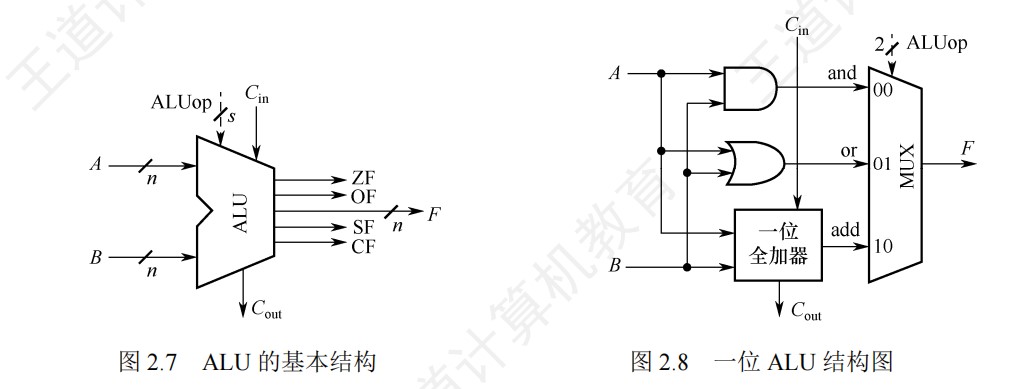

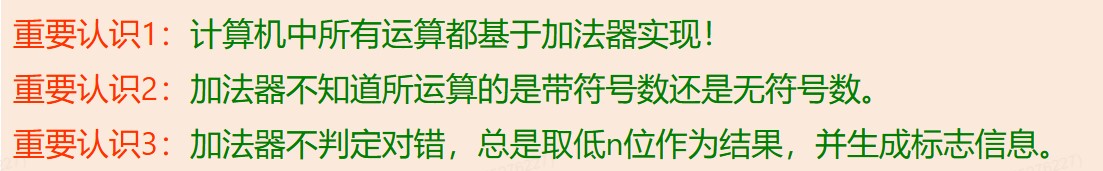

ALUop的位数决定了ALU操作的种类

-

对于有符号数来说,加法器两端分别是他们的补码表示,对于无符号数来说,加法器两端是他们的二进制表示

-

无论是无符号数减法还是补码减法,都是用被减数加上减数的负数的补码来实现的,运算器本身无法识别所处理的二进制串是有符号数还是无符号数

-

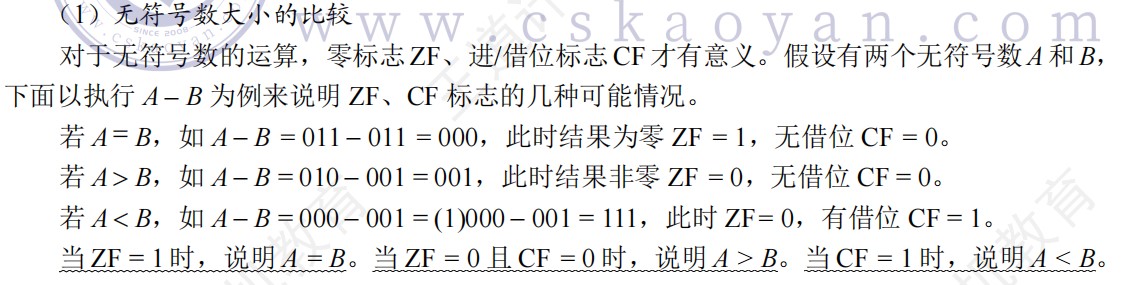

OF快速判断

.png)

- 大小端判断:从左往右地址从低往高,如果顺序符合人类阅读,那就是大端,逆序则是小端

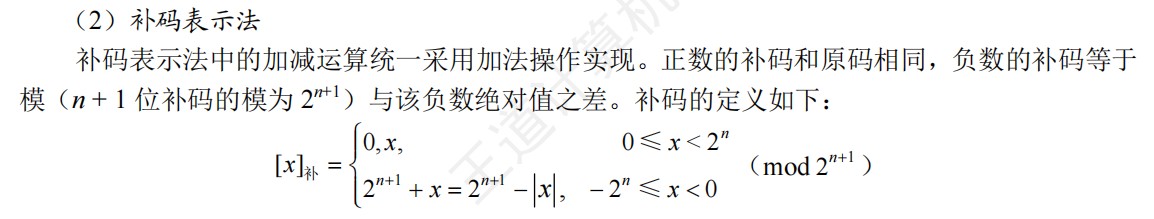

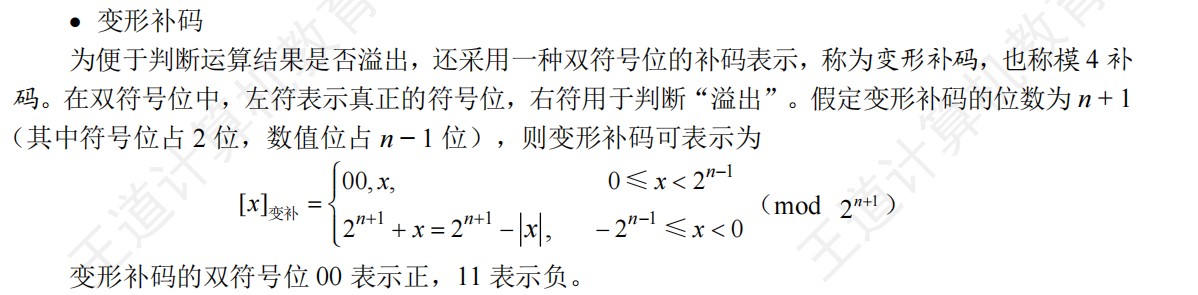

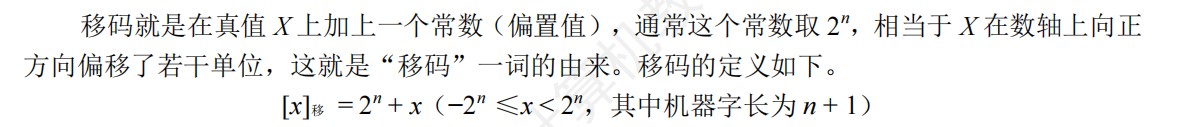

原码、补码、移码的定义(重点)

- 补码符号位不变时,其真值随着数值位的增大而增大

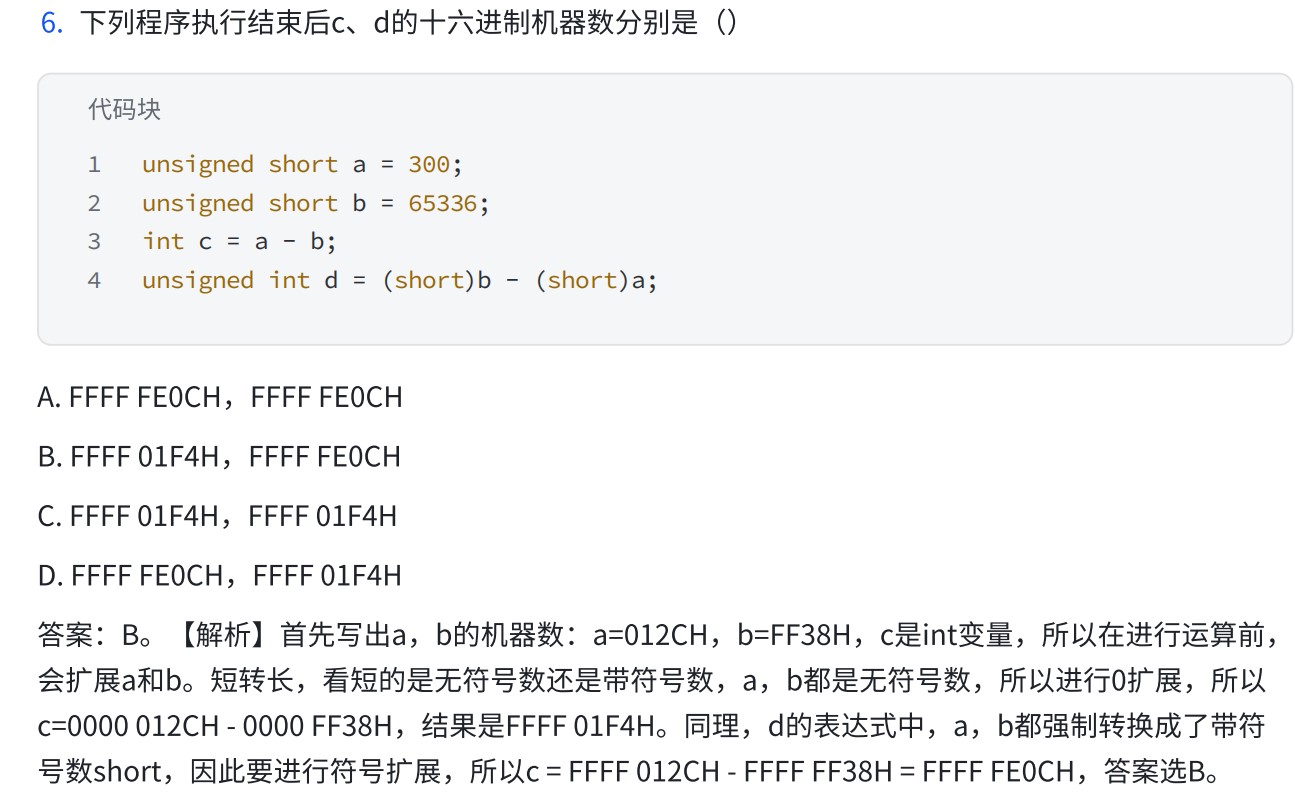

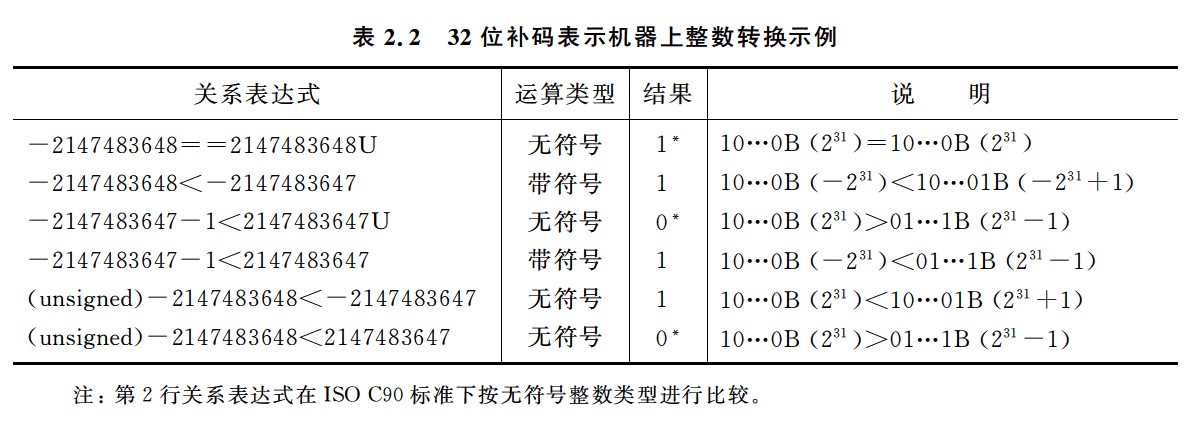

类型转换集合(重点)

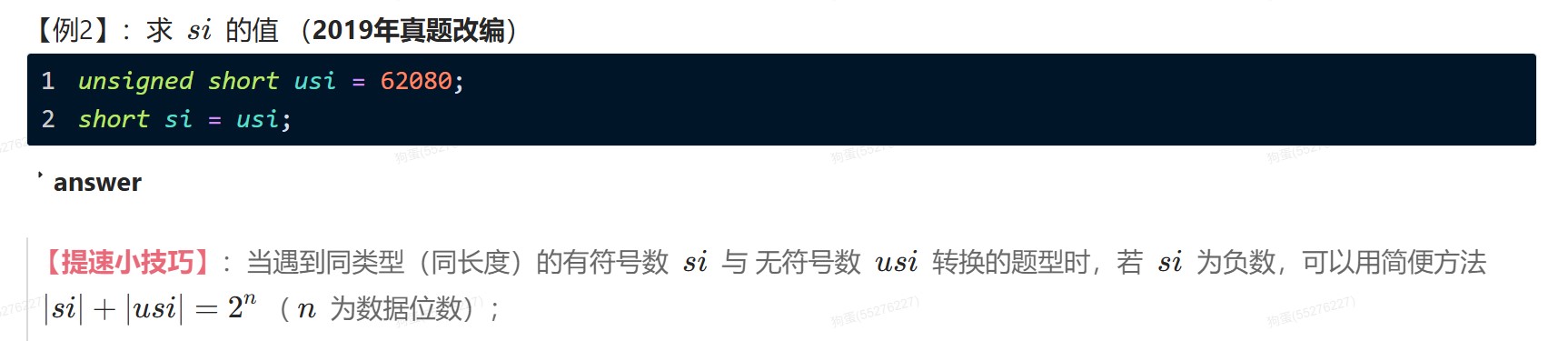

同字长有符号数和无符号数之间

- 有符号数和无符号数的强制转换,保持二进制各位的值不变,仅改变解释这些位的方式

- 有符号数转化为无符号数的时候,符号位解释为数值的一部分

- 无符号数转化为有符号数的时候,最高位解释为符号位

- 可能改变数值的情况

- 负数有符号数转化为无符号数

- 无符号数转化为有符号数

- 有符号数和无符号数参与运算,按无符号数进行运算,运算与结果类型都是无符号

不同字长整数之间

- 大转小,高位直接截断,低位直接赋值

- 小转大,无符号整数0扩展,有符号整数符号扩展

- char型为8位有符号整数,转换int时高位补符

不同字长无符号数和有符号数之间

- 小转大,先扩展,再换解释

- 原数字是无符号整数,进行0扩展,然后将扩展后的数按照有符号数进行解释

- 原数字是有符号整数,进行符号扩展,然后将扩展后的数按照无符号数进行解释

- 大转小,先截低位,再改变解释方式

- 总的来说,转换的时候,先进行字长转换,再改变解释方式

- 不同字长的无符号数和有符号数进行运算,结果为字长更长的类型,因为字长更长,能表示的范围更大

- 隐式类型转换:不同类型数混合运算的时候,遵循的原则是类型提升,即较低类型转换为较高类型,运算中和结果都是更高的类型

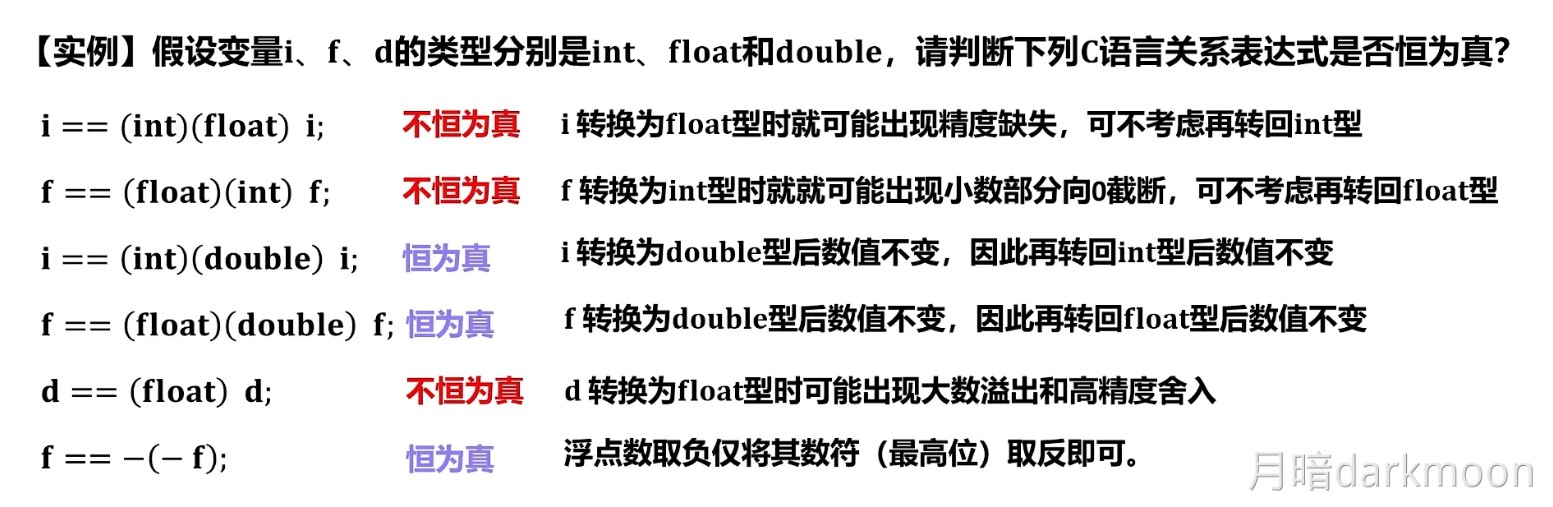

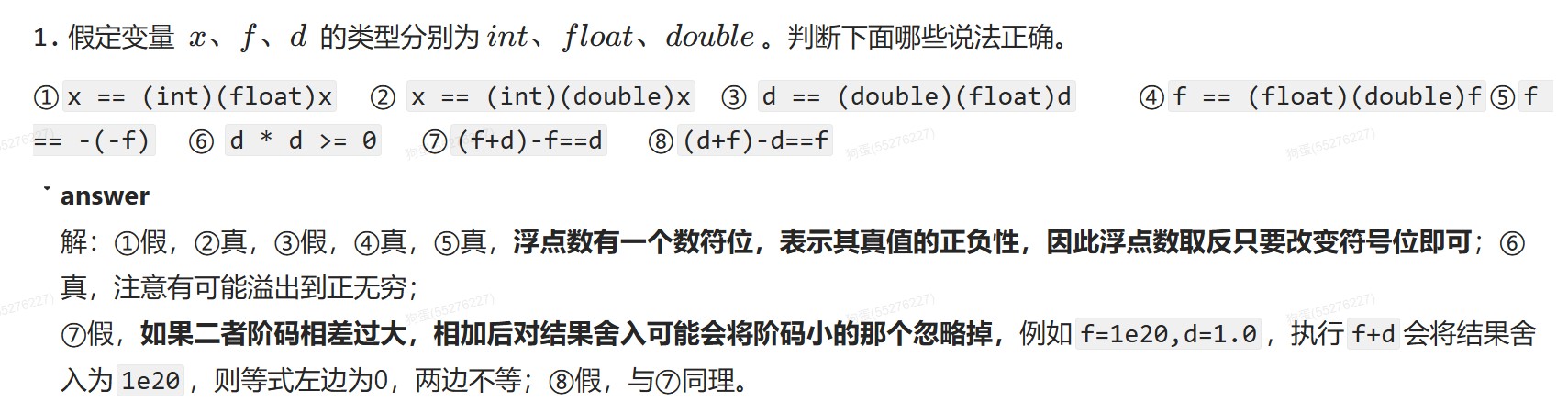

浮点数和整数之间

- int转float,int是补码,由于float尾数是原码表示,所以先要将int转为原码表示。

- float的有效位数是24位,相当于十进制7位,double的有效位数是53位,相当于十进制17位,int的有效位是31位,相当于十进制10位

定点整数的运算(重点)

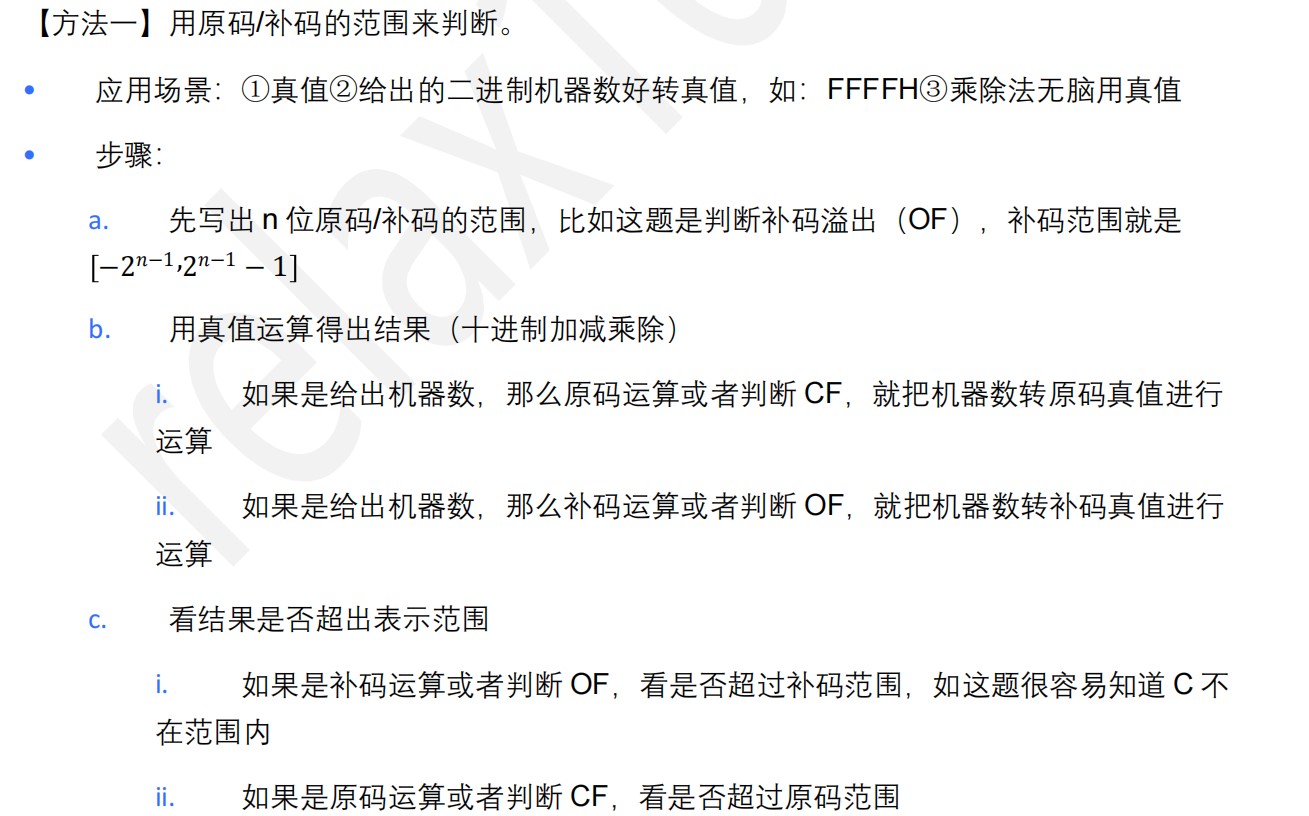

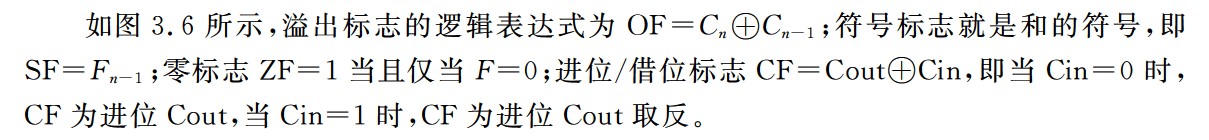

溢出判断

- 逻辑位移,左移出1,溢出

- 算术位移,左移前后符号位不同,溢出

- 这里的左移前后符号位不同,移出的每一位都要判断,只要有一位不同就是溢出

- 补码定点数加减法

- 同号相加,异号相减,符号位改变,溢出

- ①一位符号位

- 操作数符号相同,结果与源操作数的符号不同,结果溢出

- ②双符号位(模4补码)

- 运算结果的两个符号位相同,表示未溢出,不同表示溢出

- 最高位符号代表真正的符号

- 模4补码存储仅需一个符号位,只有在ALU中采用双符号位

- ③OF判断

- 最高位进位异或次高位进位

- 模4补码更容易检查加减运算中的溢出问题而非乘除运算中的溢出问题

- 原码定点乘法

- 在字长为32位的计算机中,对于两个int型有符号数的乘积,若乘积高32位的每一位都相同,且都等于乘积低32位的符号,则表示不溢出,否则表示溢出

- 在字长为32位的计算机中,对于两个unsigned int型无符号数的乘积,若乘积高32位全位0,则表示不溢出,否则表示溢出

- 原码的除法运算

- 第一次商1,溢出

- 浮点数尾数原码小数相除,第一次试商为1,虽然溢出但可以通过右规消除

- 两种快速判断方法

无符号数和有符号数大小的比较

- 无符号数大小的比较

- 有符号数大小的比较

原码的加法运算

- ①规则:符号位和数值位分开处理

- ②加法规则:

- 符号位相同,数值位相加,结果符号位不变,最高位相加产生进位则溢出

- 符号不同,做减法,绝对值大的数减去绝对值小的数,结果符号位与绝对值大的数相同

- ③减法规则:

- 减数符号取反,按照加法规则运算

定点乘法运算

-

①规则:数值位和符号位分开求

- 乘积的符号位由两个乘数的符号位异或得到

- 乘积的数值位是两个乘数的绝对值之积

-

②两个n位无符号数相乘共需进行n次加法和n次逻辑右移运算

-

③手算方式

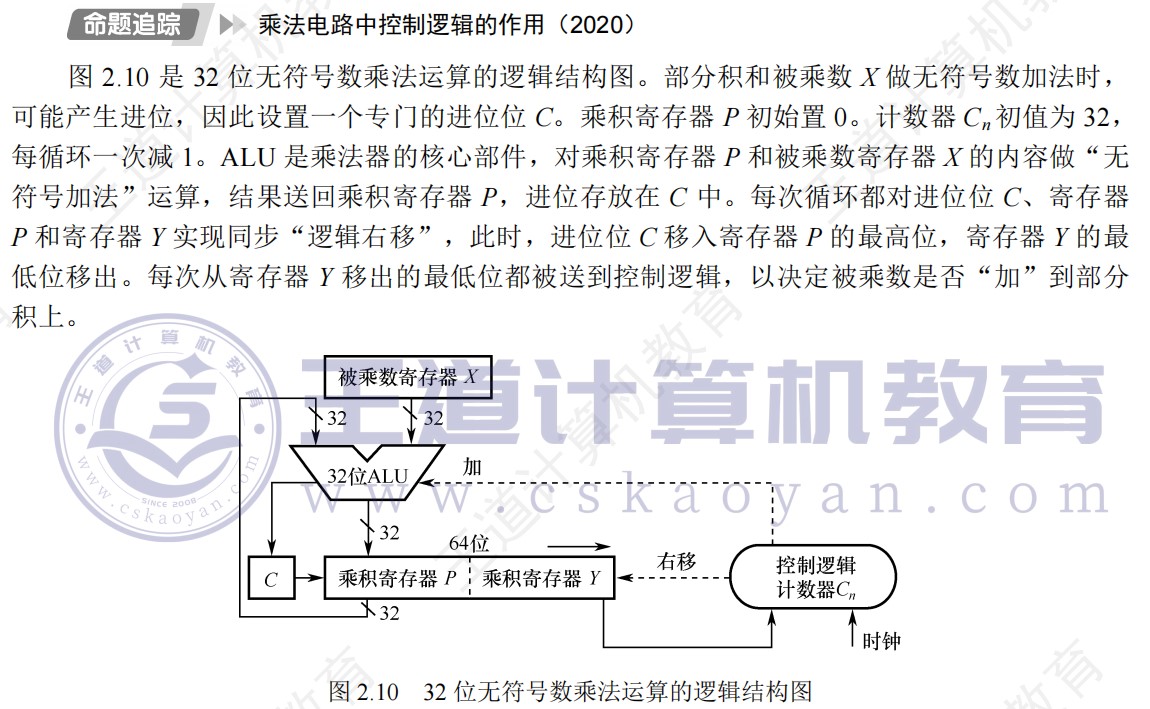

④机算方式(乘法运算电路)

- 书上图(假设一次循环在一个时钟周期内完成,则n位乘法需要n个时钟周期来完成)

- 完整过程演示(5位机器字长,1位符号位,4位数值位)

-

⑤溢出判断

- 在字长为32位的计算机中,对于两个int型有符号数的乘积,若乘积高32位的每一位都相同,且都等于乘积低32位的符号,则表示不溢出,否则表示溢出

- 在字长为32位的计算机中,对于两个unsigned int型无符号数的乘积,若乘积高32位全位0,则表示不溢出,否则表示溢出

-

⑥手算模拟机算过程

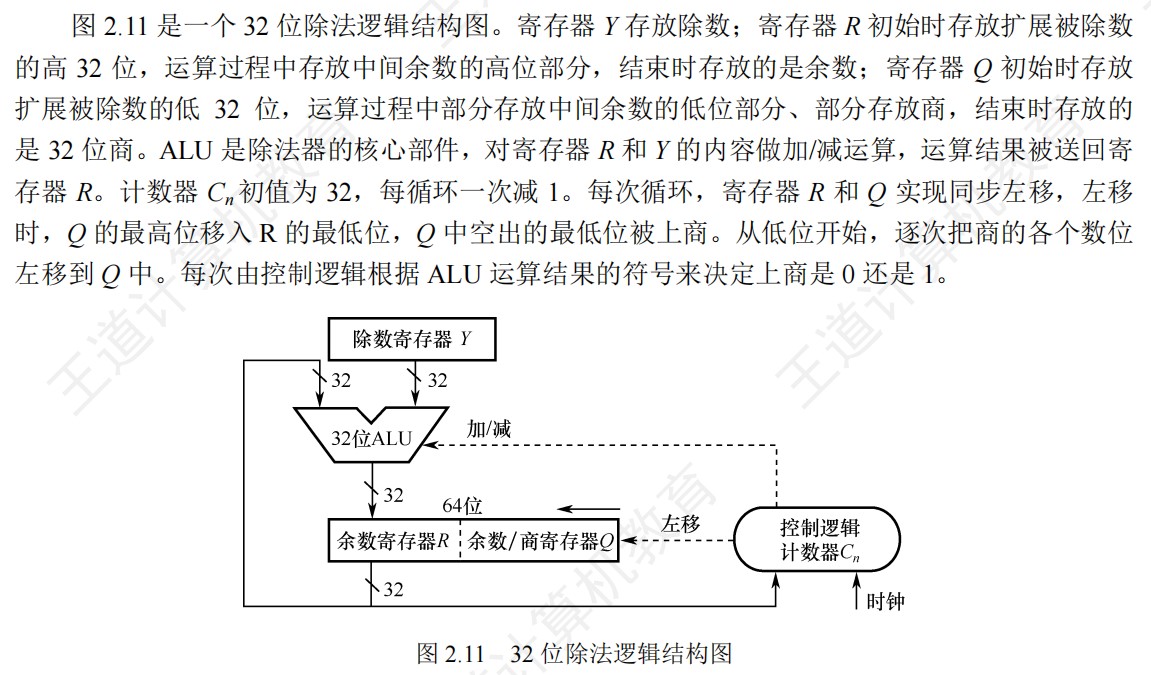

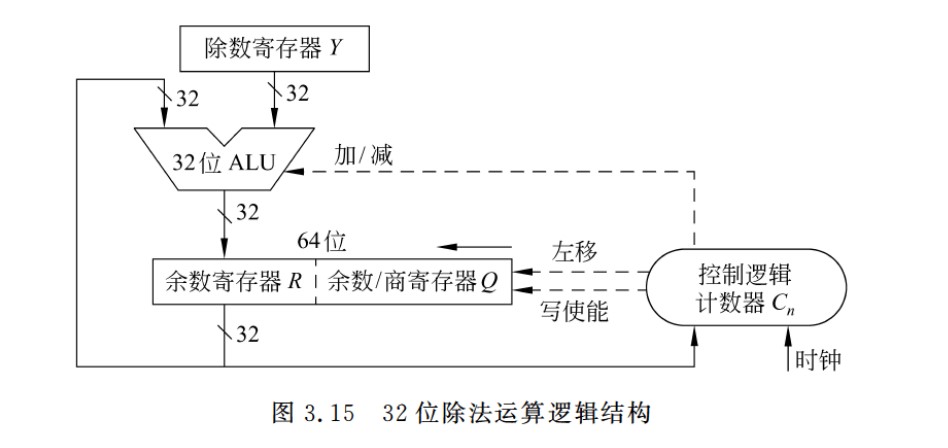

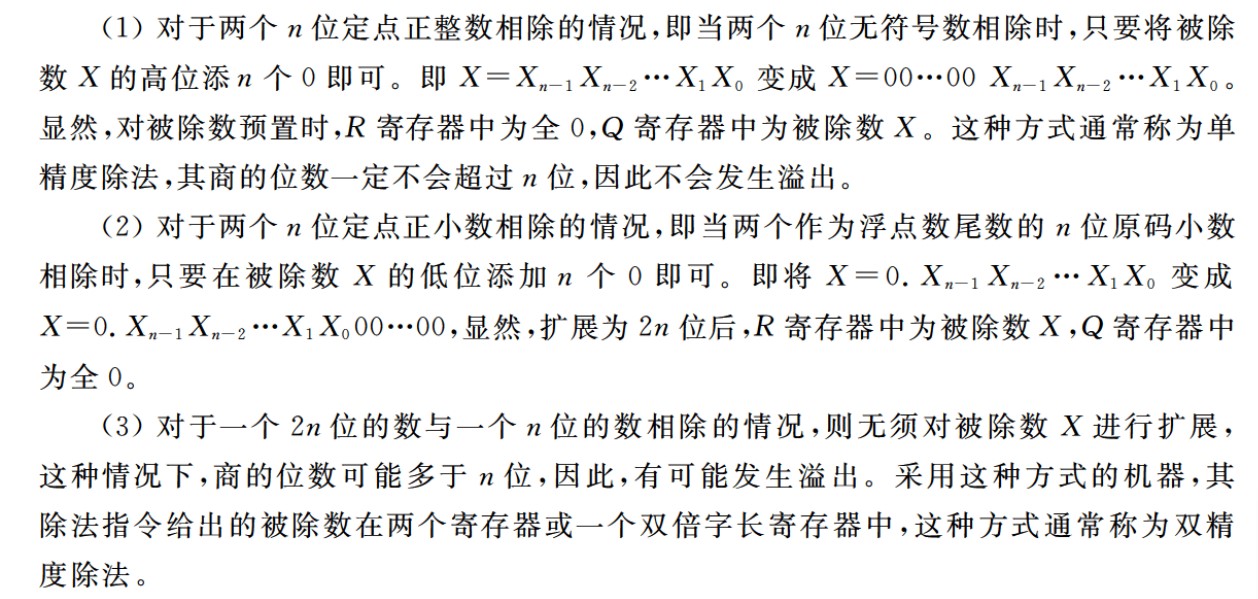

定点除法运算

-

n位定点数的除法运算,统一为一个2n位的数除以一个n位的数,得到一个n位的商

-

因此需要对被除数进行扩展:

- 定点正小数(原码),低位添n个0

- 定点正整数(无符号数),高位添n个0

-

①除法运算的过程:

- ①够减则商1,不够减商0

- 注意与CRC冗余验证码区分,CRC首位1则商1,首位0商0

- ②每次得到的差为中间余数,将除数逻辑右移后与上次的中间余数比较,够减商1,不够减商0,重复直到商的位数满足要求为止(机器字长位数)

- ①够减则商1,不够减商0

-

2n位/n位,商的位数为n+1位(因为进行了扩展,注意和乘法位数区分)

-

②溢出判断

- 第一次商1,代表结果溢出(无法用n位表示商)

- 对于浮点数尾数的原码小数相除,第一次试商位1,说明尾数部分有溢出,可以通过右规消除

-

③原码除法运算同样要将符号位和数值位分开处理,商的符号位是两个数符号位的异或结果,数值位是两个数的绝对值之商

-

在定点小数的除法运算中,被除数一定小于除数,因为如果大于,则商会>1,而定点小数无法表示>1的范围,因此当第一步的商是1,说明被除数比除数更大,硬件电路检测出以后会直接停止这些除法的运算

-

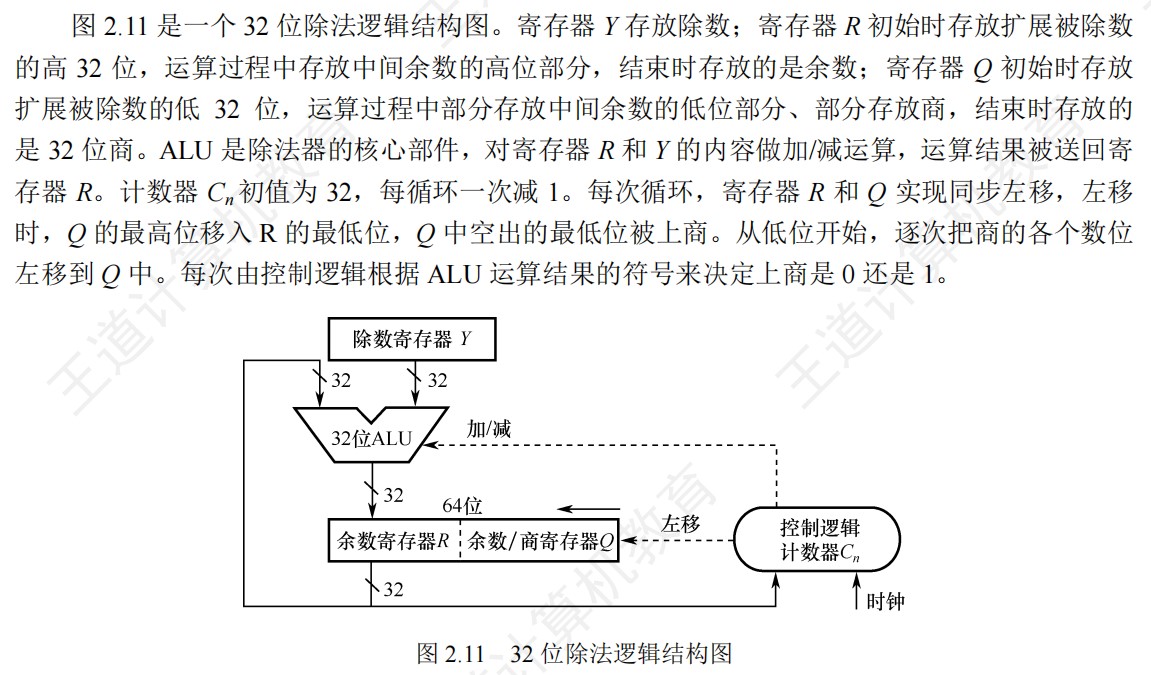

④除法运算电路

-

32位int型整数相除,则除了-2^31/-1会溢出,其余情况都不会溢出

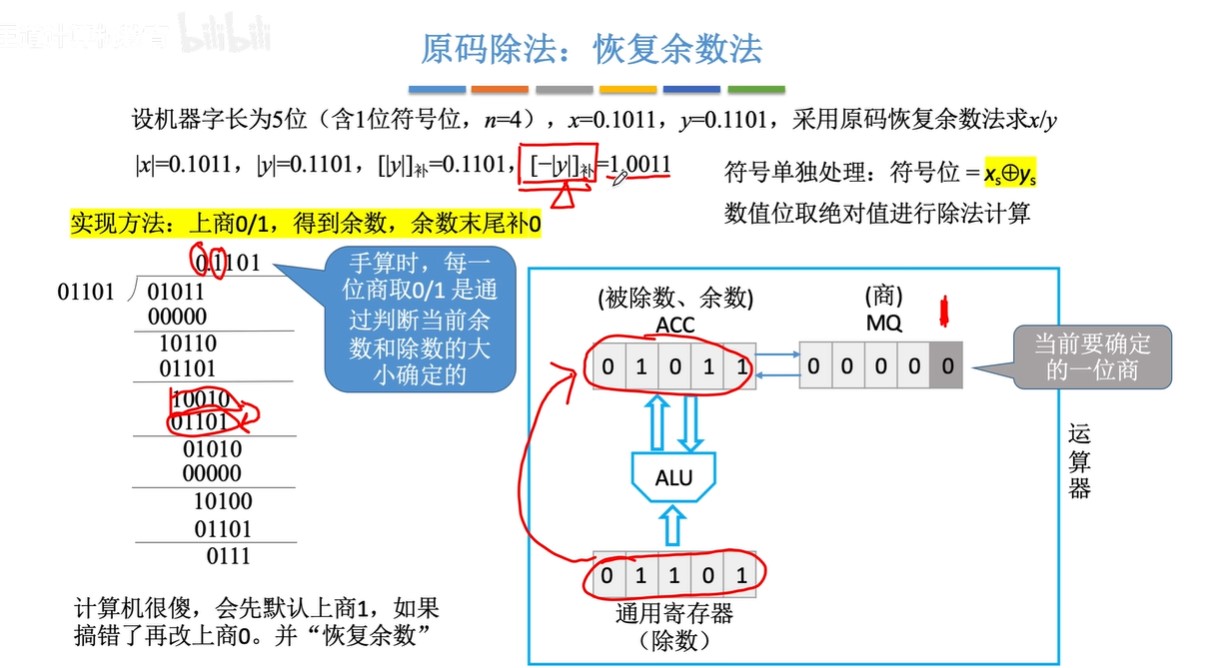

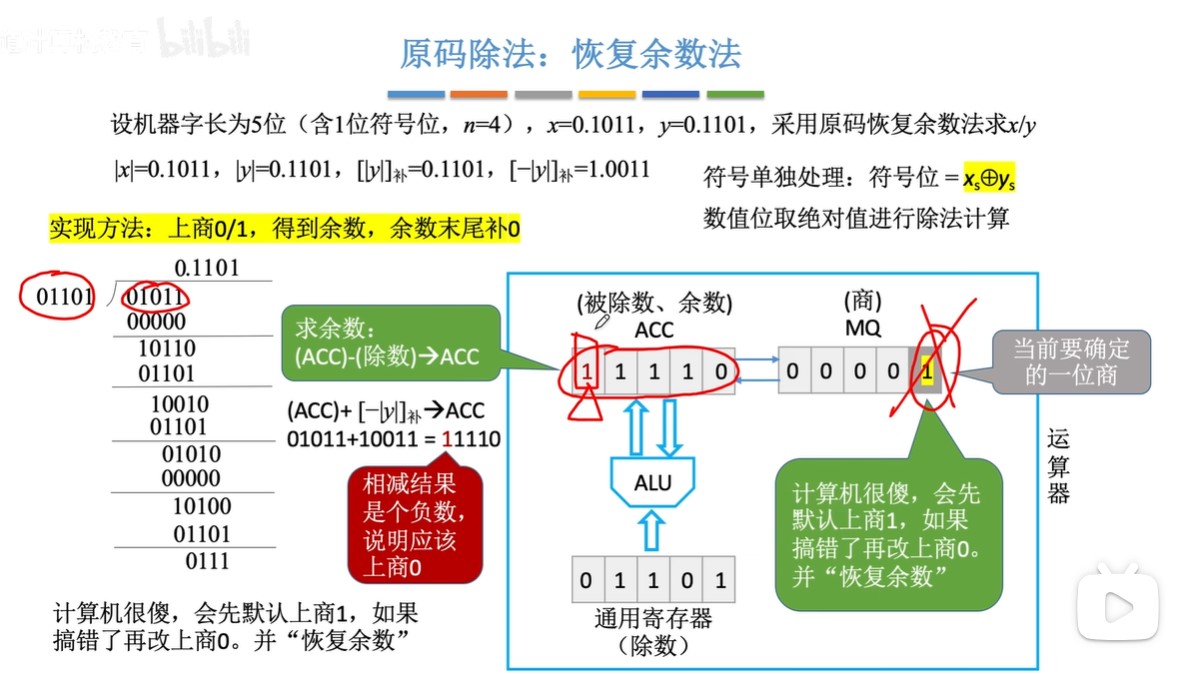

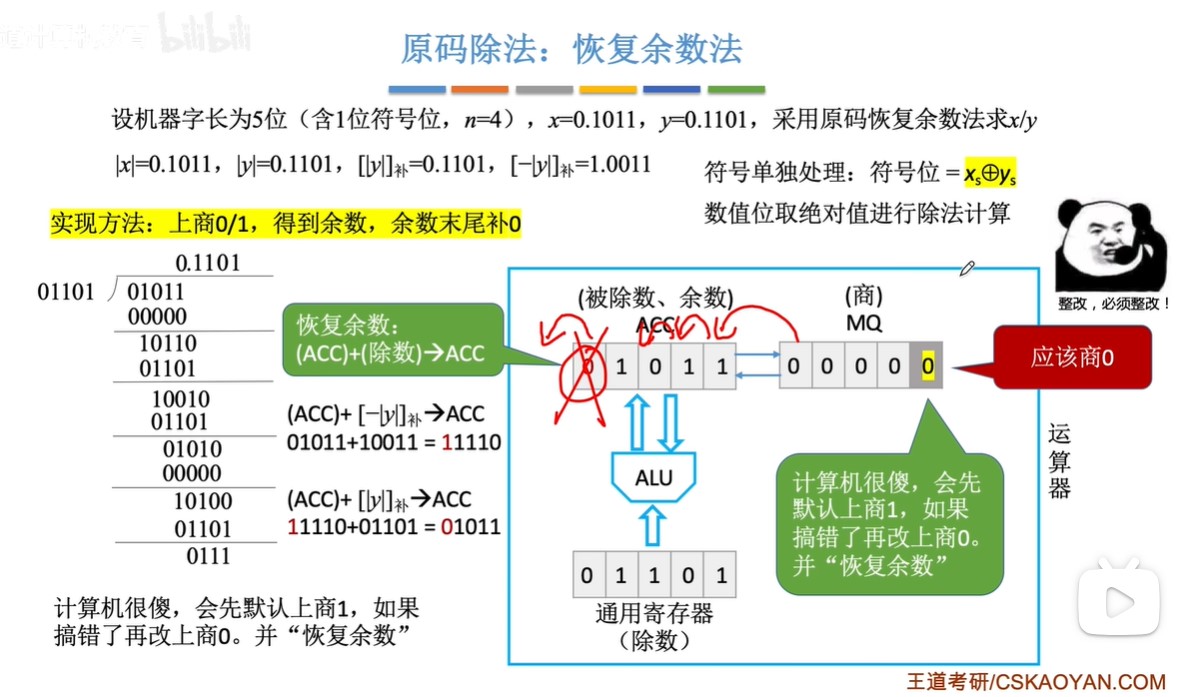

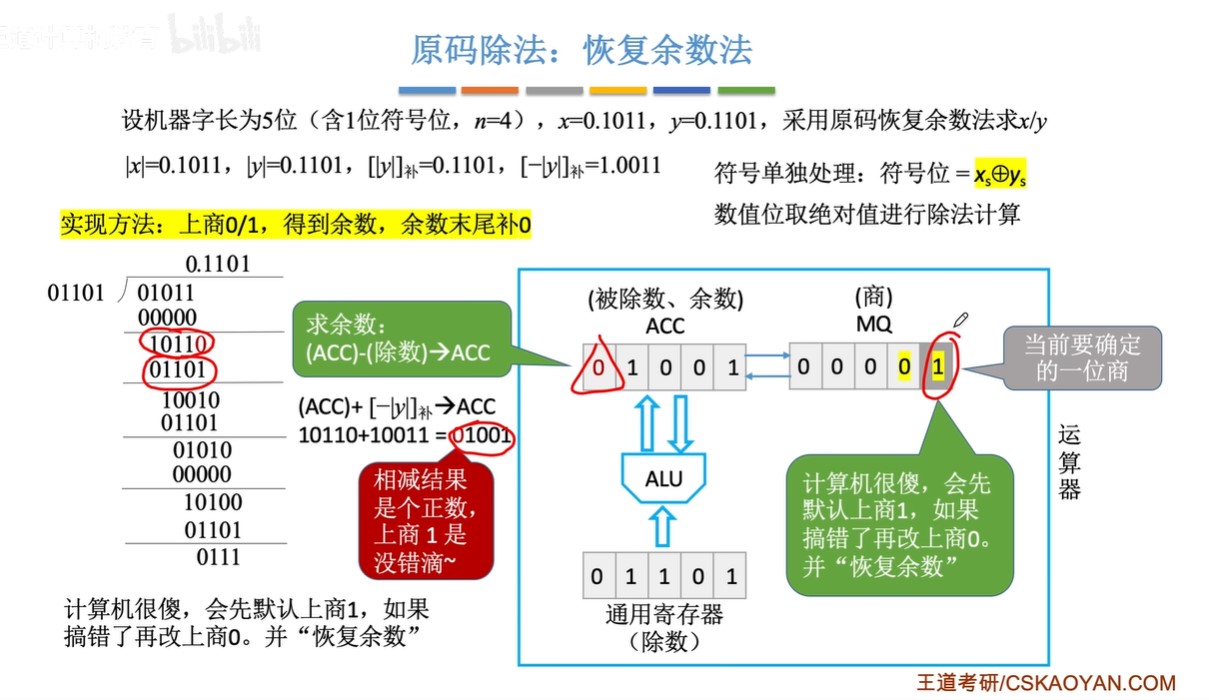

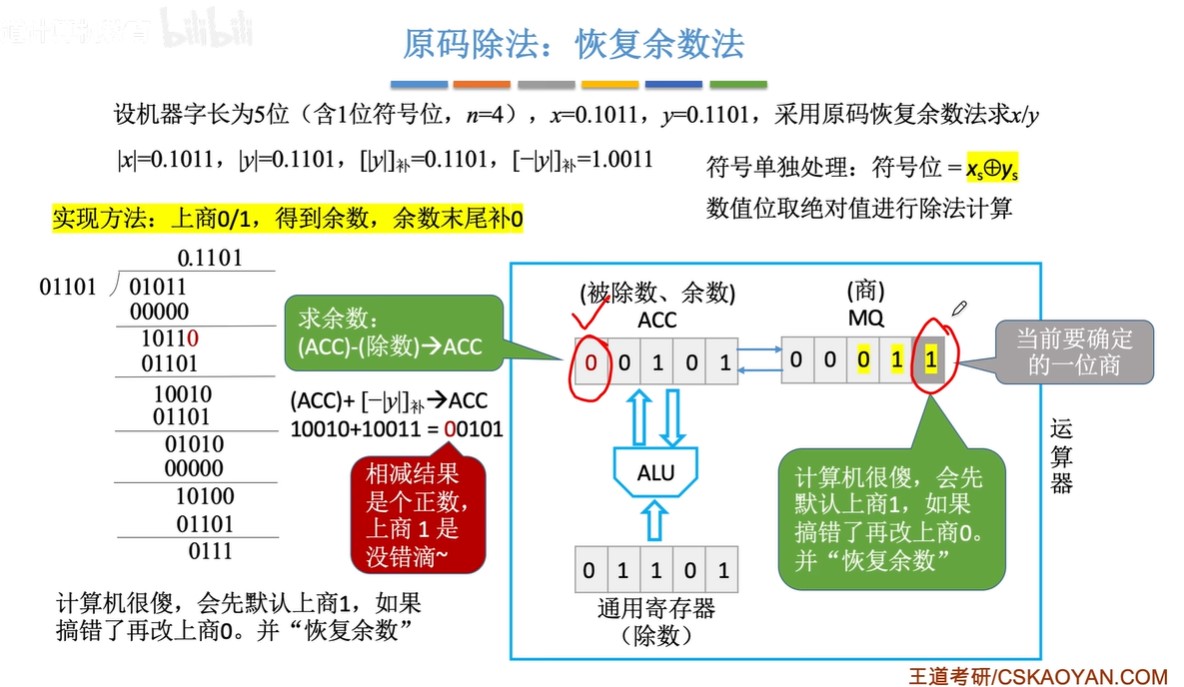

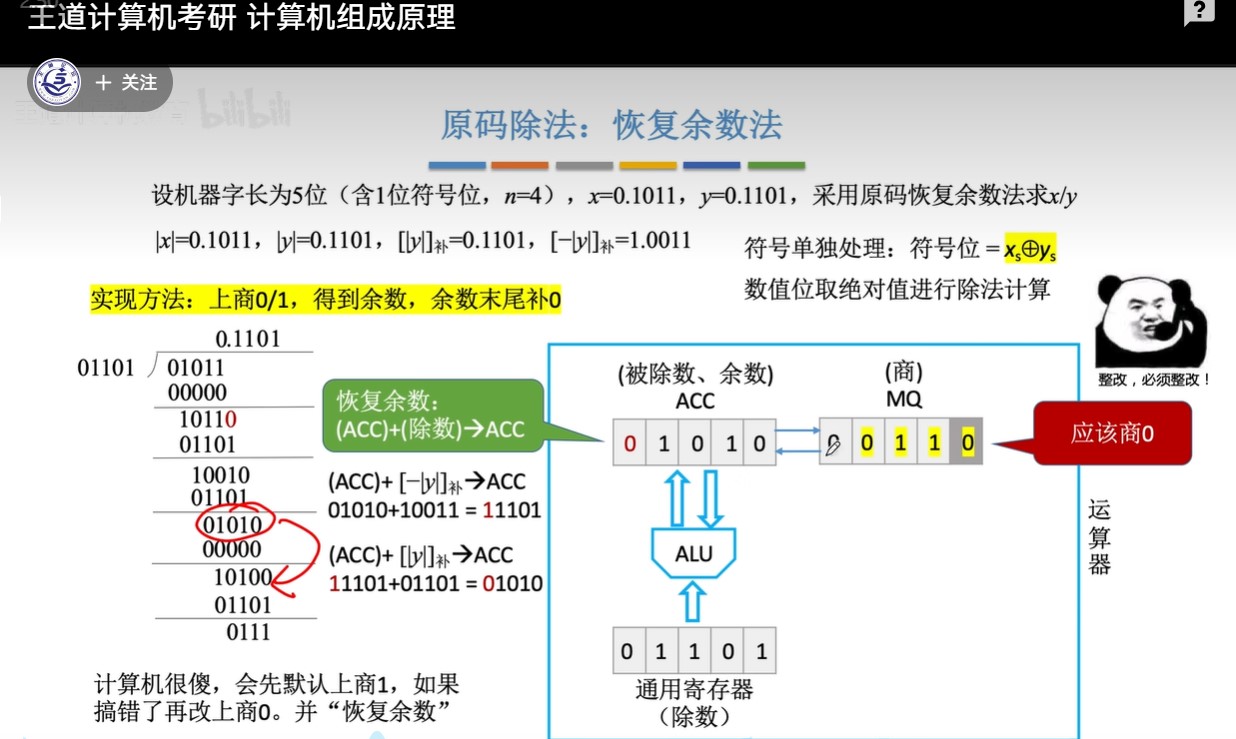

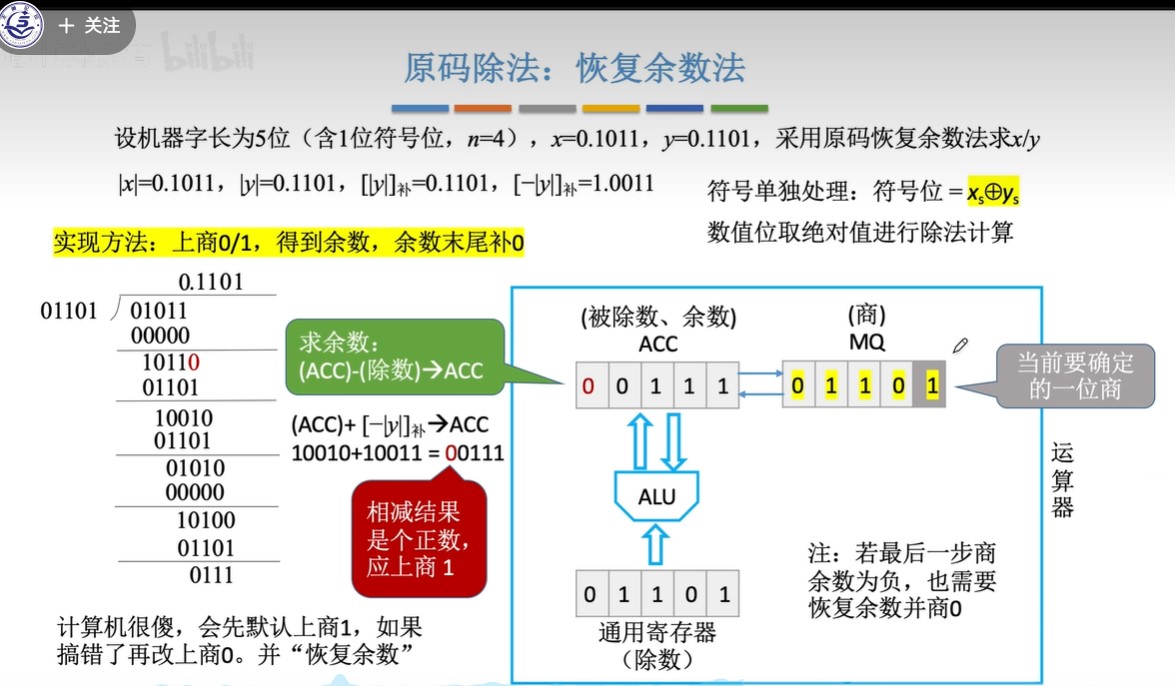

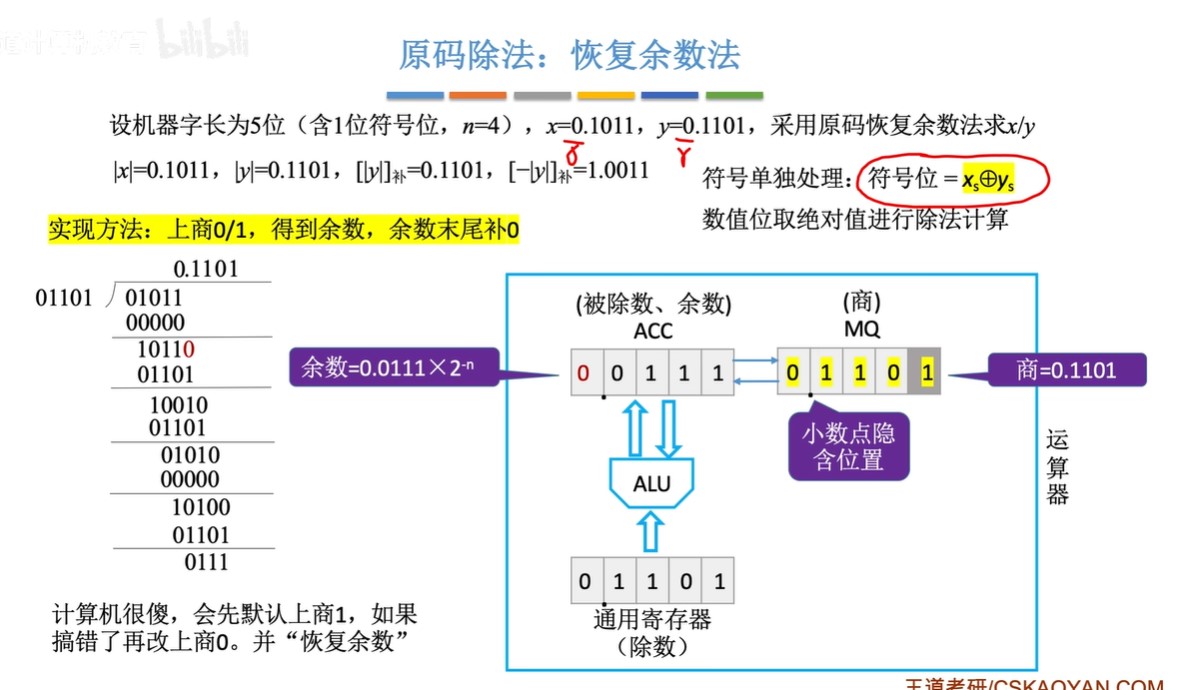

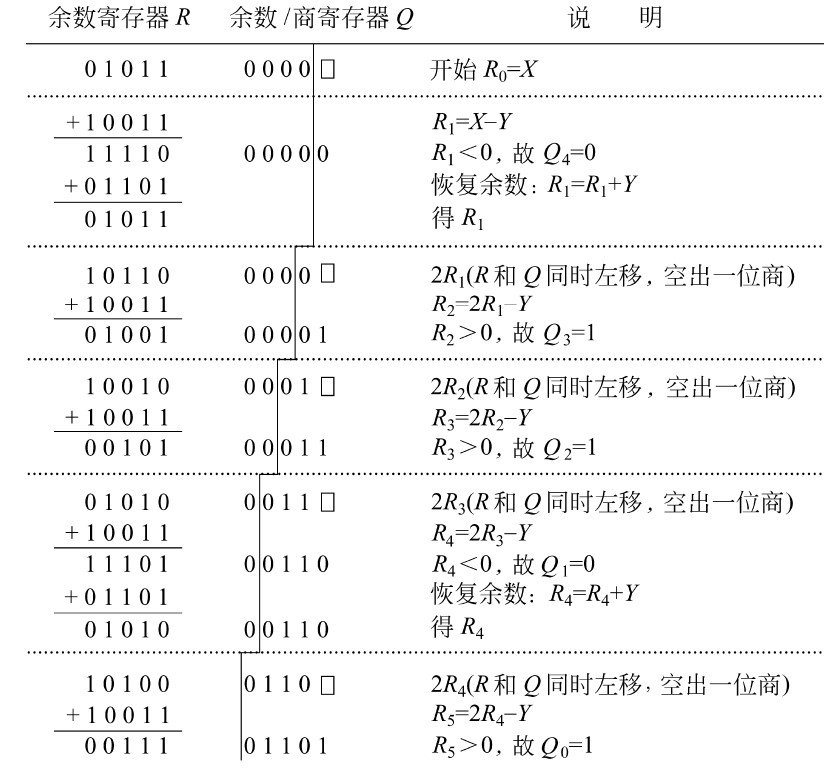

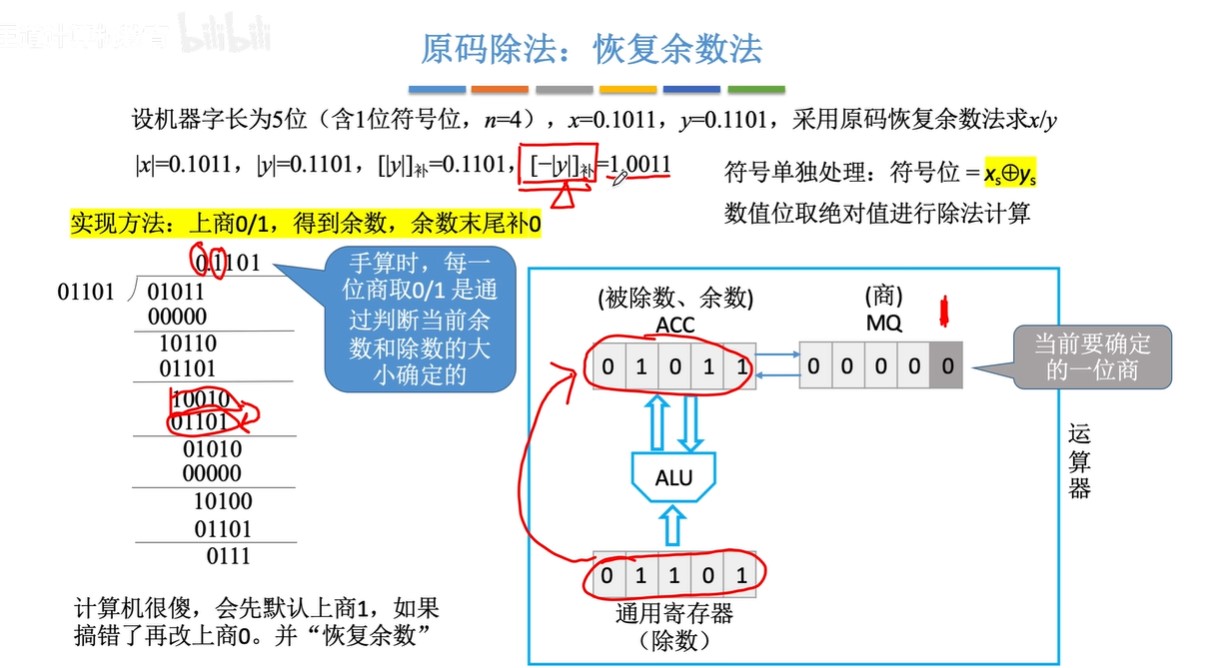

原码除法:恢复余数法(机算)

-

步骤:

- ①默认商1

- ②求余数,结果为负,改商0,余数+除数;结果为正,跳③

- ③ACC(累加寄存器)和MQ(乘商寄存器)同时逻辑左移,余数末尾补0

- 由于第②步的恢复余数,余数一定是个正数也就是开头为0,所以左移不会发生溢出

- 由于MQ最开始全位0,所以左移相当于余数末尾补0

- ④重复上述过程直到商的位数达到机器字长(1位符号位+(n-1)位数值位)

- ⑤符号位单独处理

-

恢复余数法中,一共左移n次,上商n+1次,最后一次上商余数不逻辑左移

- 因为要有符号位,所以上商n+1次,而左移的次数是因为要有n位数值位

- 原码的符号位也是参与运算了的,只不过是绝对值除法,所以符号位均为0

-

图示

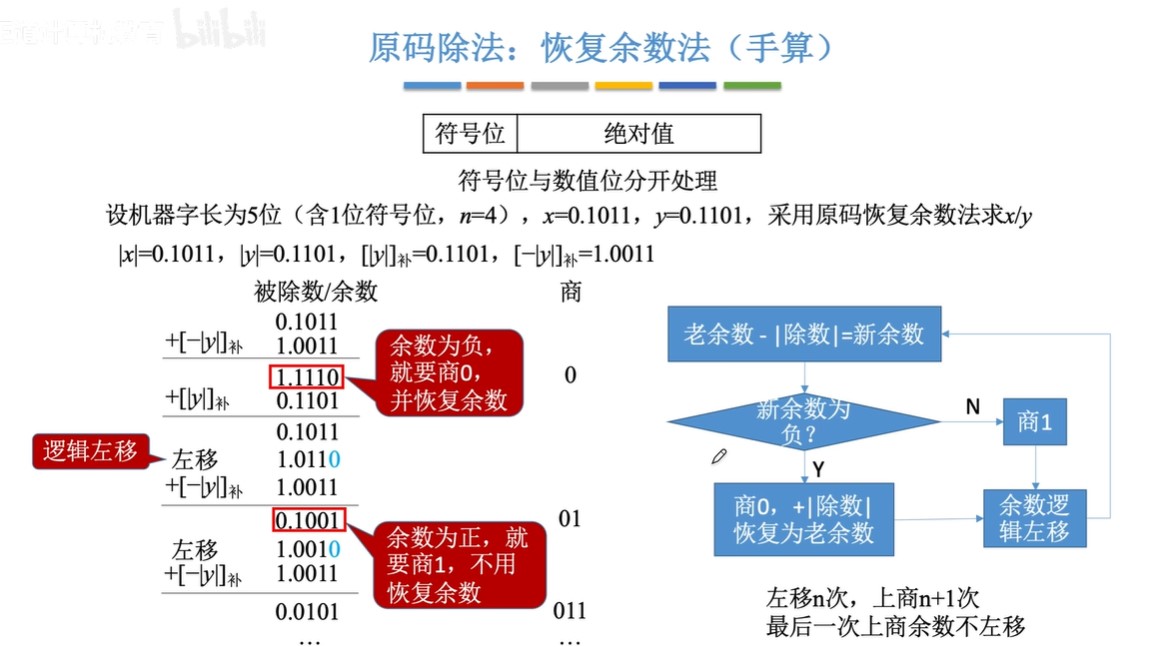

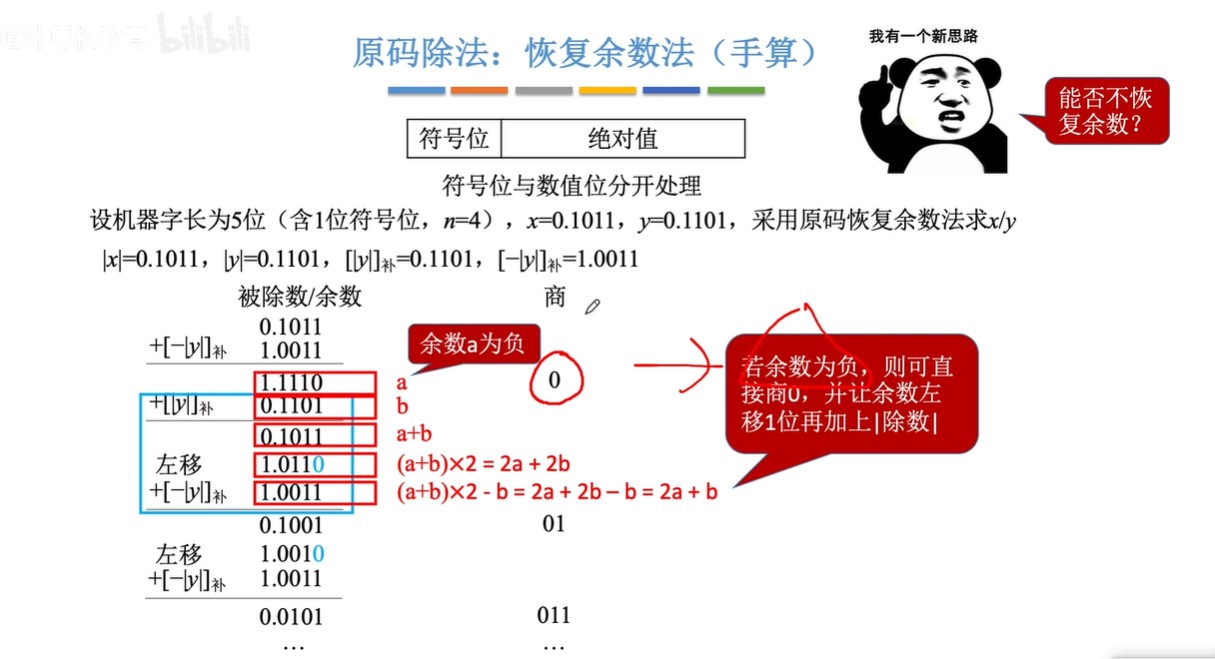

原码除法:恢复余数法(手算)

-

步骤:

- ①预处理:写出“除数的绝对值“”被除数的绝对值““除数绝对值的补码”“绝对值负数的补码”

- 因为数值位单独运算,数值位当作无符号整数进行运算

- ②每次都先试商1,相减(加上负减数的补码)得到余数

- ③余数为负,加回减数补码,恢复余数;余数为正,跳到④

- ④逻辑左移,余数末尾补0

- ⑤重复上述过程直到商的位数达到机器字长的位数

- ①预处理:写出“除数的绝对值“”被除数的绝对值““除数绝对值的补码”“绝对值负数的补码”

-

图示:

原码除法:加减交替法(不恢复余数法)

- 步骤:

- ①预处理:写出“除数的绝对值“”被除数的绝对值““除数绝对值的补码”“绝对值负数的补码”

- ②每次都先试商1,相减(加上负减数的补码)得到余数

- ③当余数为负,改商0,逻辑左移后再加除数,得到新余数;余数为正,逻辑左移再减去除数,得到下一个新余数

- ④重复上述过程直到商位数达到机器字长

- 如果最后一步上商为0,则必须恢复余数,把试商时减掉的除数加回去

- 口诀:正、1、、左移、减、负、0、左移、加

- 加减交替法和恢复余数法的区别

- 加减交替法先逻辑位移再加减

- 恢复余数法先加减再逻辑位移

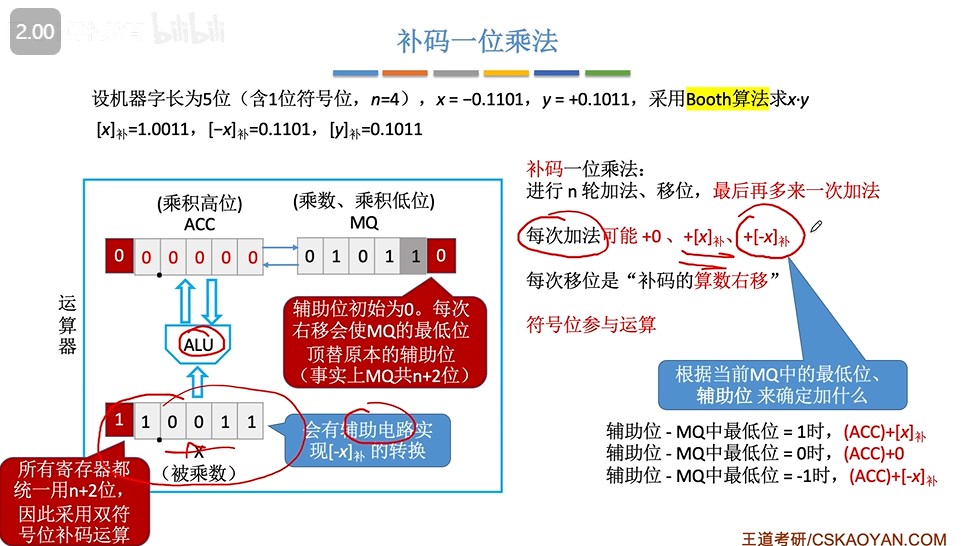

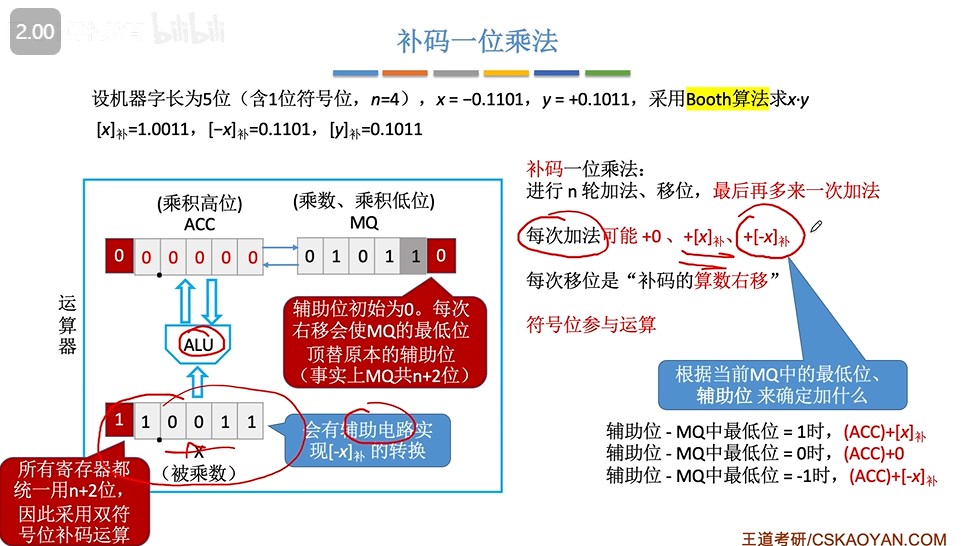

补码一位乘法(Booth算法)(机算)

-

步骤

- ①预处理:写出被乘数的双符号位补码,负被乘数的双符号位补码,乘数的补码

- ②对ACC和X左扩充一位,MQ右括充一位初始为0的辅助位,所有寄存器统一用n+2位(n是数值位位数)

- ③先计算辅助位-MQ中最低位,然后根据结果进行加法运算

- 辅助位-MQ最低位=1,ACC+[X]补

- 辅助位-MQ最低位=0,ACC+0

- 辅助位-MQ最低位=-1,ACC+[-X]补

- ④对ACC和MQ内容同时进行算术右移

- ⑤重复n次

- ⑥最后多一次加法,使得原符号位在辅助线左边

-

图示

补码一位乘法(Booth算法)(手算模拟)

- 步骤:

- ①预处理:写出被乘数的补码,负被乘数的补码,乘数的补码

- ②等式分为高位部分积和低位部分积(乘数),模拟ACC和MQ,在乘数末尾画一条线,线右边加0(辅助位)

- ③先计算辅助位-MQ中最低位,然后根据结果进行加法运算

- 辅助位-MQ最低位=1,ACC+[X]补

- 辅助位-MQ最低位=0,ACC+0

- 辅助位-MQ最低位=-1,ACC+[-X]补

- ④积整体算术右移

- ⑤重复n次

补码一位乘法和原码一位乘法的区别

- 补码一位乘的逻辑结构不需要进位位C,补码一位乘需要进位位C

补码的除法运算(加减交替法)

-

步骤:

-

①预处理:写出被除数补码、除数补码、负除数补码

-

②因为符号位参与运算,所以第一步被除数和除数单独处理:

被除数和除数同号,则被除数减去除数;被除数和除数异号,则被除数加上除数

-

③余数和除数同号,商1,余数逻辑左移一位减去除数;余数和除数异号,商0,余数逻辑左移一位加上除数

-

④重复n次直到商为n+1位,末尾恒置1

-

-

口诀:同、1、减,异、0、加

补码加减交替法和原码加减交替法的对比

- 原码比较余数正负,补码比较余数和除数符号

- 原码余数为负,商0左移再加除数;余数为正,商1左移再减除数

- 补码余数和除数同号,商1,余数左移一位减去除数;余数和除数异号,商0,余数左移一位加上除数

- 共同点:

- 都重复n次

- 商1先逻辑左移再减除数,商0先逻辑右移再加除数

逻辑电路与或非积累(重点)

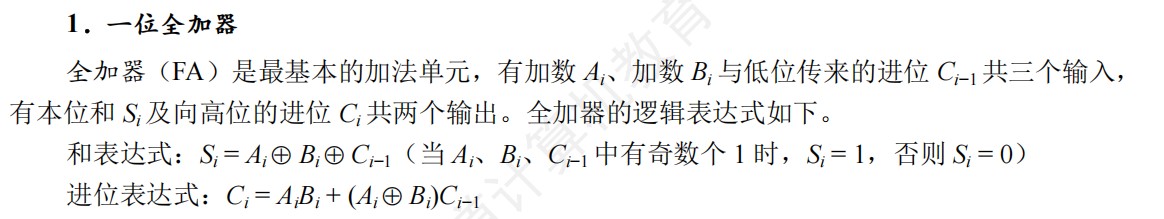

一位全加器的和和进位表达式

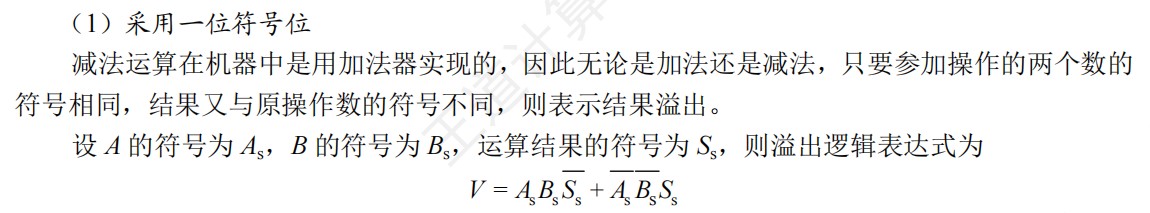

一位符号位的溢出逻辑判断表达式

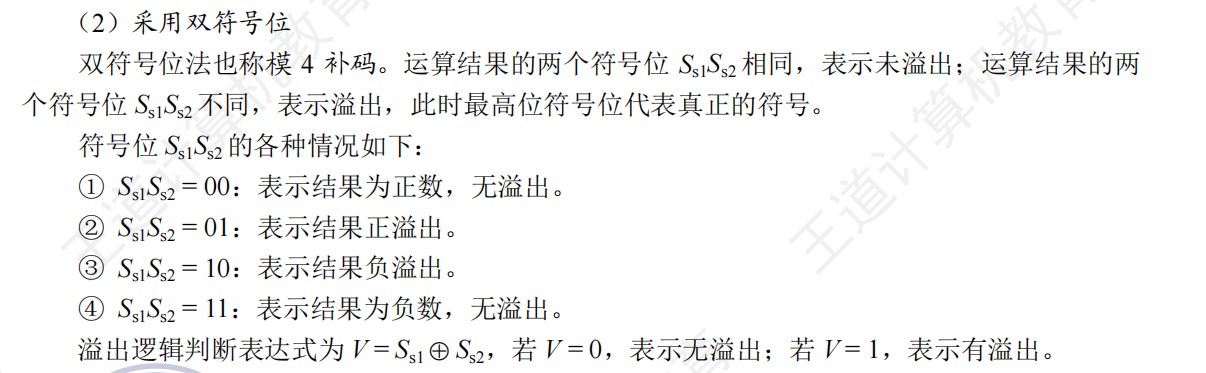

双符号位的溢出逻辑判断表达式

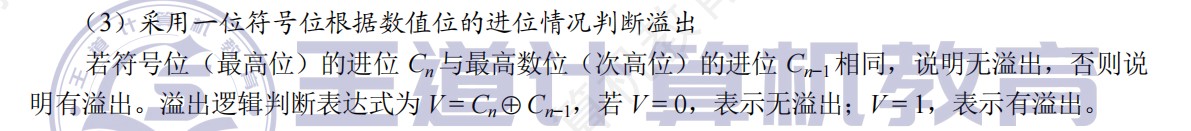

CF的逻辑表达式

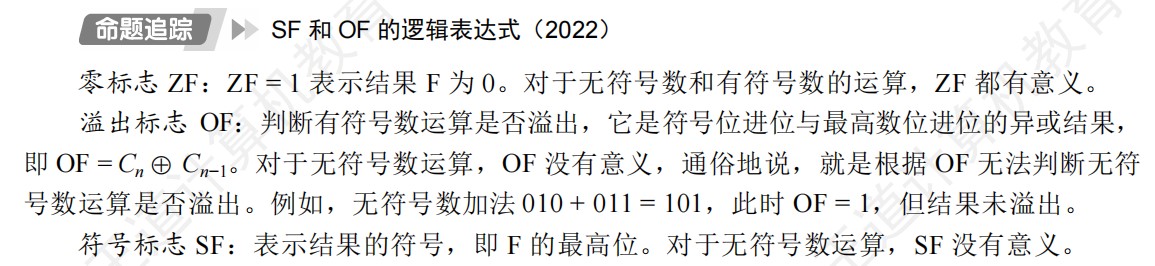

SF和OF的逻辑表达式

浮点数

- 浮点数的舍入

- 基数不同,浮点数的规格化形式也不同。当浮点数尾数的基数为2时,原码规格化数的尾数最高位一定是1。基数为4,原码规格化数的尾数最高两位不全为0

- 23位尾数实际上表示了24位有效数字

- 一般n位移码时2^(n-1),但是IEEE7的移码是2^(n-1)-1

- 长度相同、格式相同的两种浮点数,基数大的表示的范围更大,精度更低

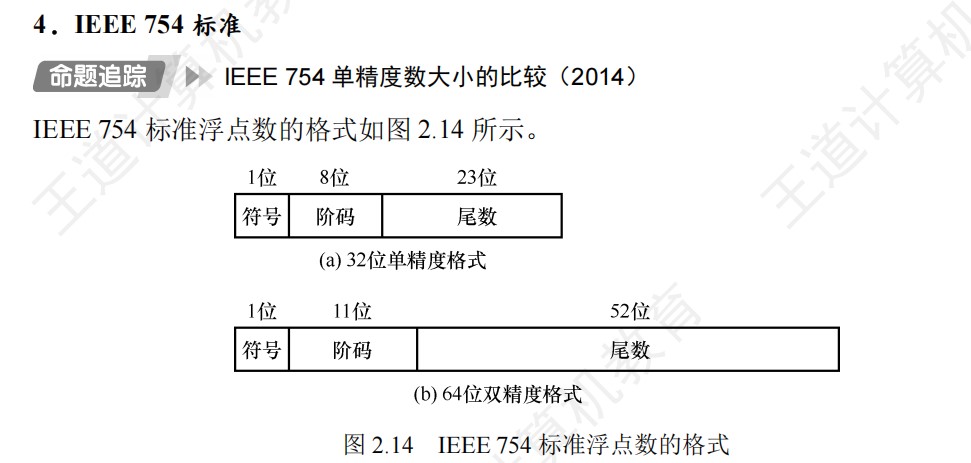

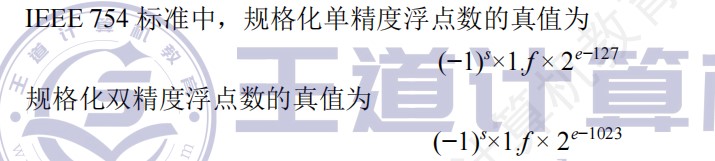

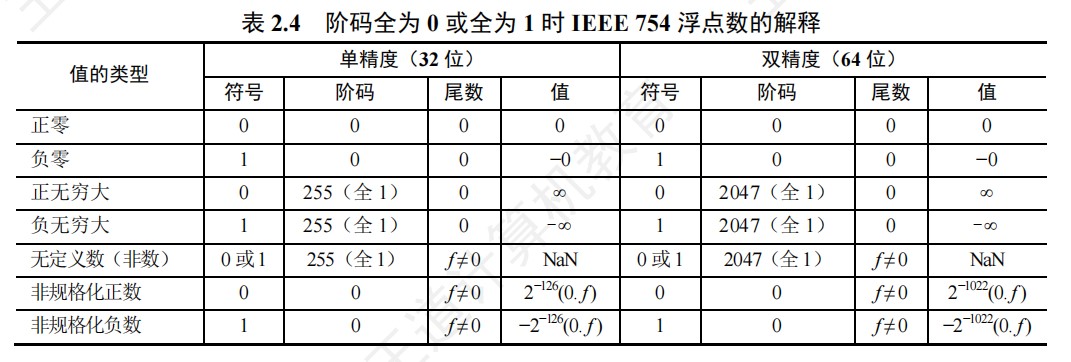

IEEE754汇总

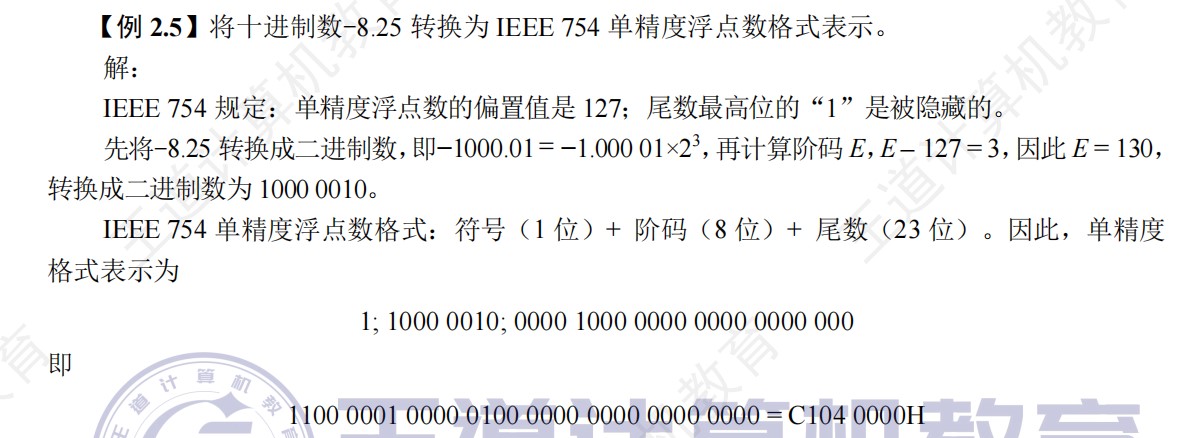

实数和IEEE754单精度数的相互转换

- 实数转化为float步骤:

- ①将实数转化为二进制数,符号独立,只转换数值部分

- ②将实数转化为1.xxxx * 2^n的格式

- ③计算阶码E=n+127,再将E转化为二进制数

- ④按照IEEE754单精度浮点数格式进行表示

- float转化为实数步骤:

- ①将float按二进制展开

- ②根据IEEE754单精度浮点数的格式进行划分

- 注:注意隐藏位

浮点数和定点数的区别和比较

- 字长相同,浮点数的表示范围更大,定点数的精度更高

- 定点运算中,当运算结果超出数的表示范围时,发生溢出;在浮点运算中,运算结果超出尾数表示范围却不一定溢出,只有规格化后的阶码超出所能表示的范围时,才会发生溢出

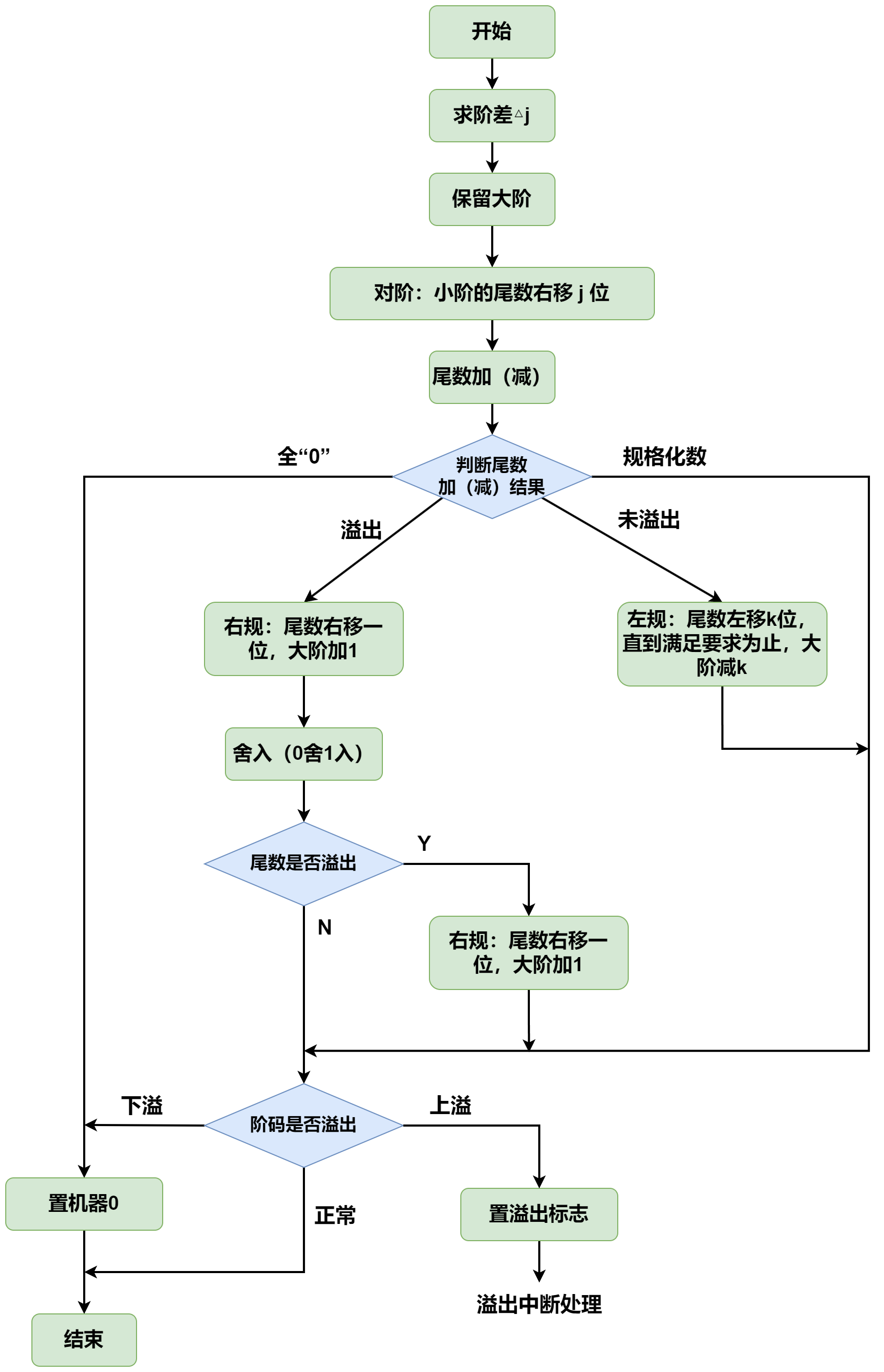

浮点数的加减运算

- 步骤:

- ①对阶

- 小阶码向大阶码看齐,尾数右移时,若舍弃有效位会产生误差,影响精度。为了保证运算的精度,尾数右移时,低位移出的位不要丢掉,应保留并参加尾数部分的运算,最后再将运算结果进行舍入,还原成IEEE754格式

- ②尾数加减

- 对接后的尾数按定点原码小数的加减运算规则进行运算

- 因为IEEE754浮点数尾数还有一个隐藏位,因此在进行尾数加减时,必须将隐藏位还原到尾数部分

- ③尾数规格化

- 变成1.xxxx的形式

- ④舍入

- 在对阶和尾数右规时,可能发生舍入,定点数没有舍入

- (1)就近舍入

- 当运算结果是两个可表示数的非中间值时,实际上是0舍1入方式

- 里哪个近就变哪个

- 当运算结果正好在两个可表示数的中间时,选择结果为偶数

- 就近舍入中间值向两边舍入取决于尾数最后一位,若是0,则直接截断尾数,若是1,则要把尾数最后一位变成0,所以采取进1的方式)

- 当运算结果是两个可表示数的非中间值时,实际上是0舍1入方式

- (2)正向舍入

- 取数轴右边最近的可表示数

- (3)负向舍入

- 取数轴左边最近的可表示数

- (4)截断法

- 直接截取所需位数,丢弃后面的所有位,相当于向原点舍入

- ⑤溢出判断

- 尾数规格化和尾数舍入的时候,可能出现阶码溢出的问题

- **右规和尾数舍入。**数值很大的尾数舍入时,可能因为末位+1而发生尾数溢出,此时需要通过右规来调整尾数和阶码。右规时阶码+1,导致阶码加大,因此需要判断是否发生了指数上溢

- 左规。左规时阶码-1,导致阶码减小,因此需要判断是否发生了指数下溢。左规一次,阶码-1,然后判断阶码是否全0来确定指数是否下溢

- 正指数超过127或1023,指数上溢,产生异常;负指数小于-149或-1074,指数下溢,按照机器0处理

- 注:某些题目中可能指定尾数或阶码采用补码表示。通常可以采用双符号位,当尾数求和结果溢出(入尾数变为10.xxxxx或01.xxxx)时,需要右规一次;当结果出现00.0xxx或11.1xxxx时,需要左规,直到尾数变为00.1xxx或11.0xxxx(符号位和最高位异号)

- 尾数规格化和尾数舍入的时候,可能出现阶码溢出的问题

- ①对阶

- float类型中,当两个数的阶码相差超过24时(>=25),较小的数在加法中就会被完全忽略。这是由float的24位尾数精度决定的。

舍入和溢出的场景

- 舍入

- 对阶和尾数右规

- 溢出

- 上溢

- 右规

- 尾数舍入

- 下溢

- 左规

- 上溢

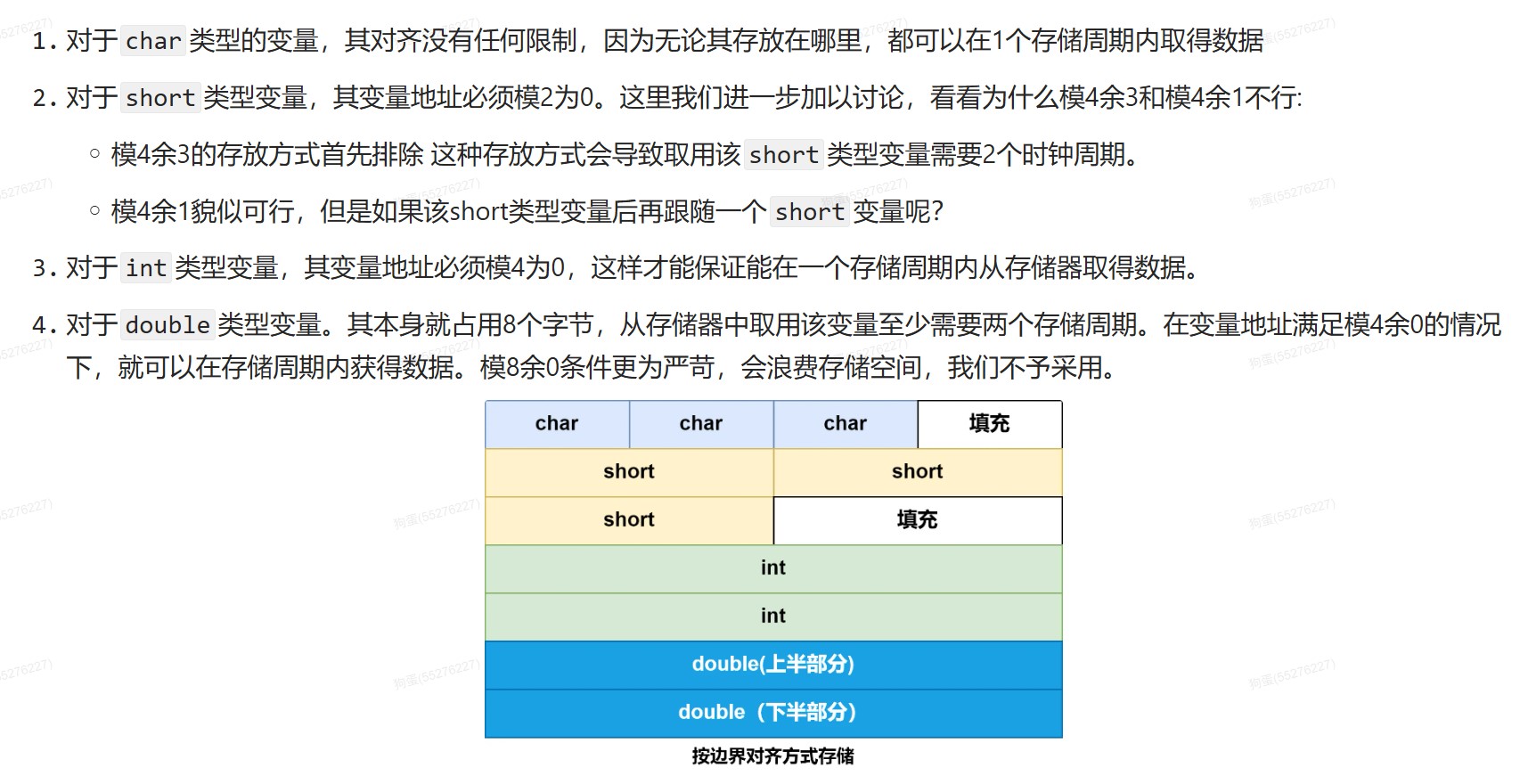

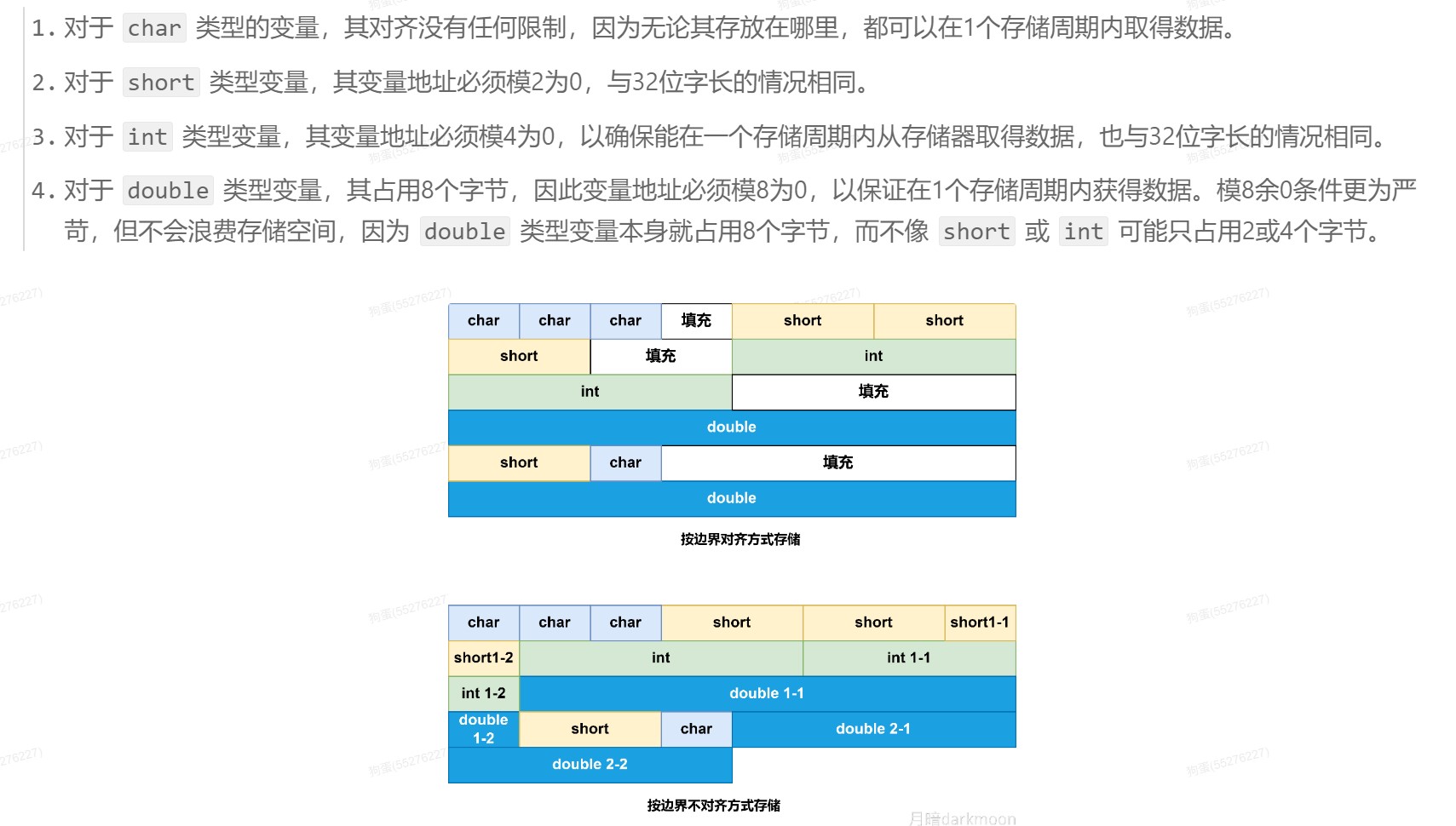

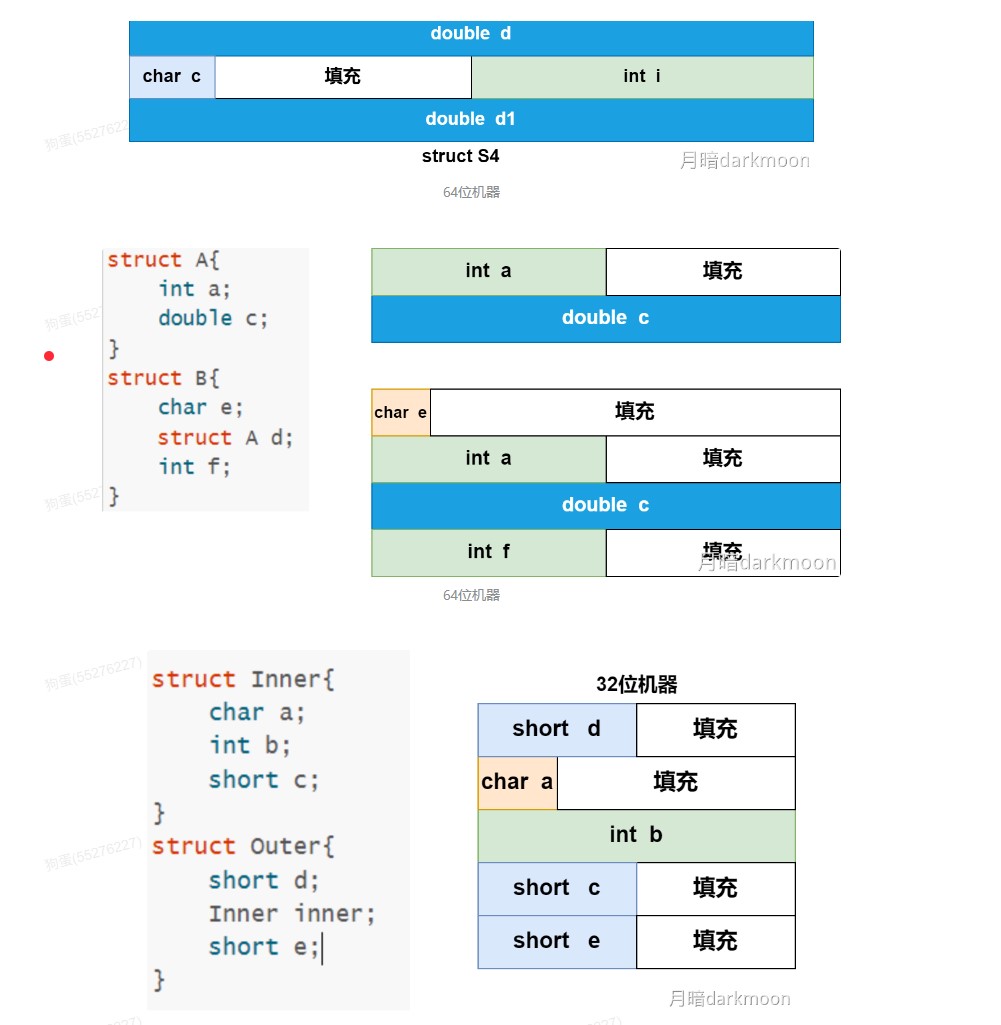

边界对齐

位权

- 无符号整数的位权

- 有符号整数补码的位权

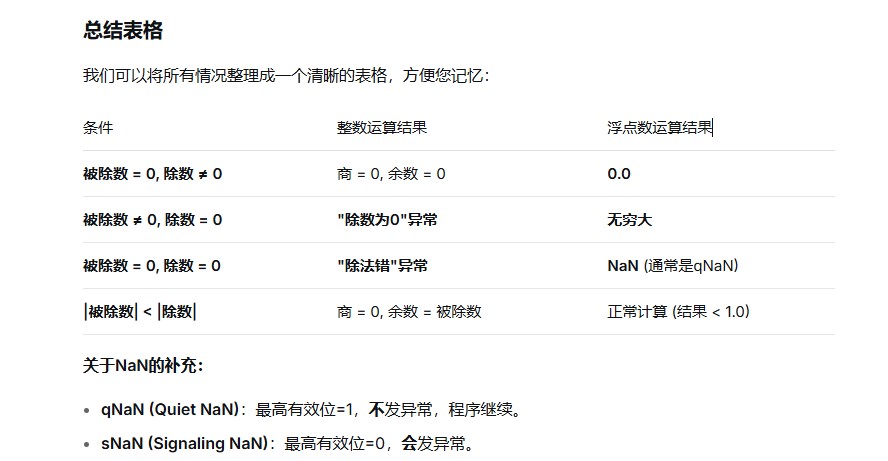

除法汇总

-

对于除数为0的情况,根据是定点除法指令还是浮点除法指令有不同的处理方式

- 对于浮点数除0,异常处理程序可以选择将指令执行结果用特殊的值(NaN或∞)表示,然后返回到用户进程继续执行除法指令后面的一条指令

- 对于整数除0,则会发生整除0故障,通常调用abort例程来终止当前用户进程

-

①若被除数为0,除数不为0,或者定点整数除法时|被除数|<|除数|,则说明商为0,余数为被除数,不再继续执行

- ②若被除数不为0,除数为0,对于整数,则发生“除数为0”异常;对于浮点数,则结果等于无穷大

- ③若被除数和除数都为0,对于整数,则发生除法错异常;对于浮点数,则有些机器产生一个不发信号的NaN,或者产生NaN信号,取决于最高有效位

-

当结果出现尾数为0的时候,不管阶码是什么,都将阶码取为0

-

当操作数为无穷大时,系统可以有两种处理方式

- 产生不发信号的非数NaN

- 产生明确的结果

-

NaN

- 当最高有效位为1的时候,为不发信号NaN,当结果产生这种非数时,不发异常通知,即不进行异常处理;当最高有效位为0时为发信号NaN,当结果产生这种非数时,则发一个异常操作通知,表示要进行异常处理

- 除了第一位有定义外其余的位没有定义,所以可用其余位来指定具体的异常条件

- 一些没有数学解释的计算,会产生一个NaN

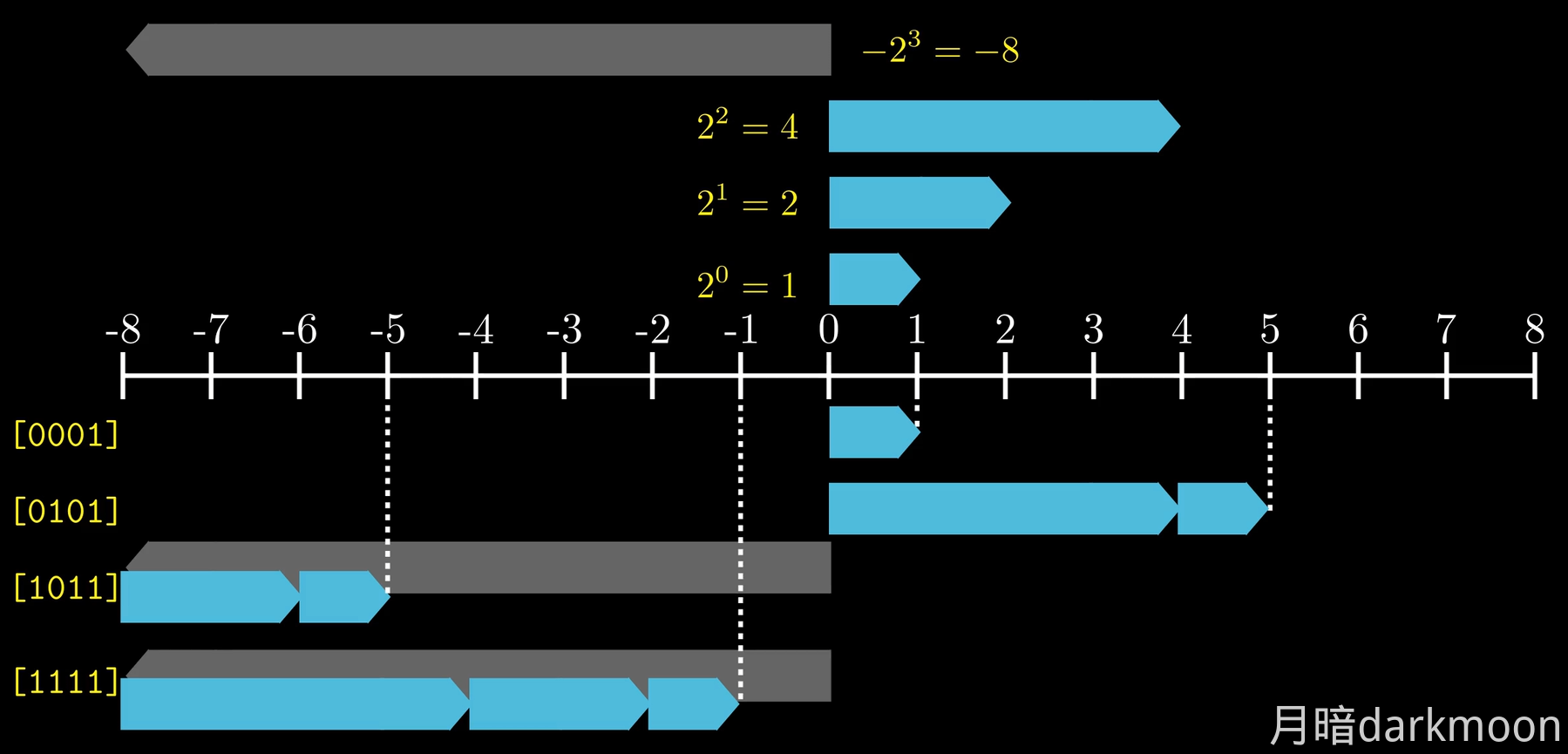

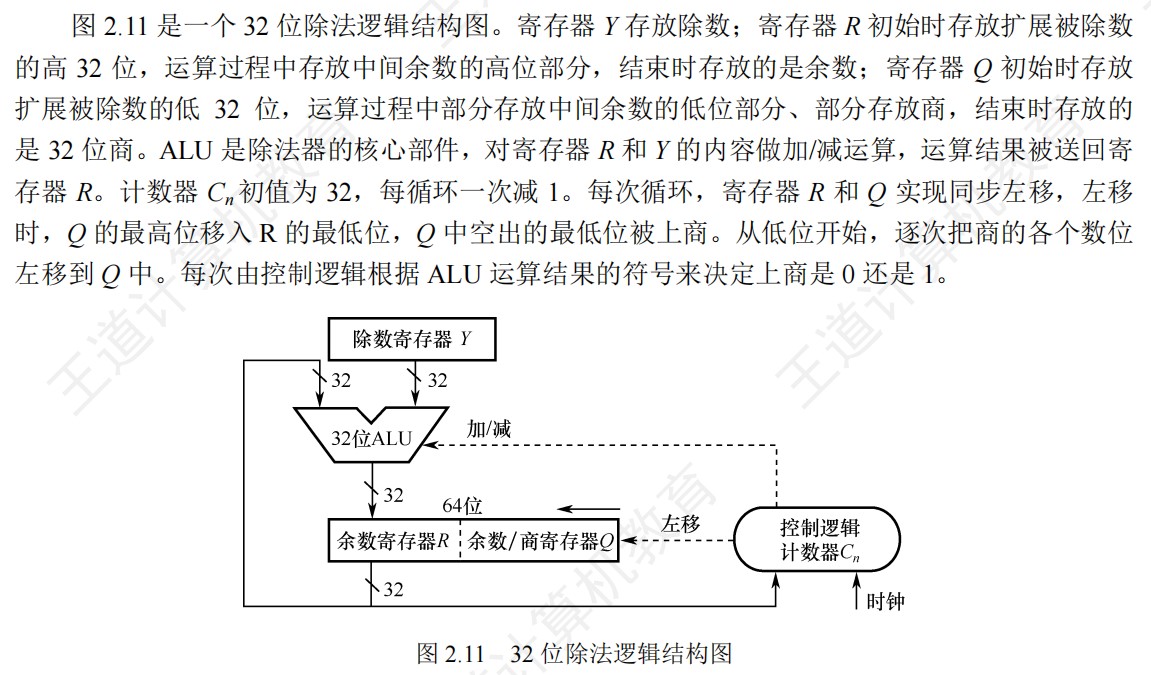

关于除法运算逻辑结构到底扩展什么

-

原码除法

-

因为原码除法符号位不参与运算,所以原码除法中,被除数和除数都当作无符号整数,进行0扩展

- 如果是定点整数,高位扩0

- 如果是定点小数,低位扩0

-

除法运算逻辑,除数寄存器Y存放除数,余数寄存器R开始时置被除数的高32位,作为初始中间余数R0的高位部分,结束时存放的是余数;余数/商寄存器Q开始时置被除数的低32位,作为初始中间余数R0的低位部分,结束时存放的是32位商

-

定点整数和定点整小数都可以用该除法逻辑实现,只是被除数扩展的方法不太一样,导致溢出的情况也有所不同

-

-

补码除法运算

- 对于两个n位补码除法,被除数需要进行符号扩展,若被除数为2n位,除数为n位,则被除数无需扩展。除数无需扩展,只需要直接放入寄存器中。

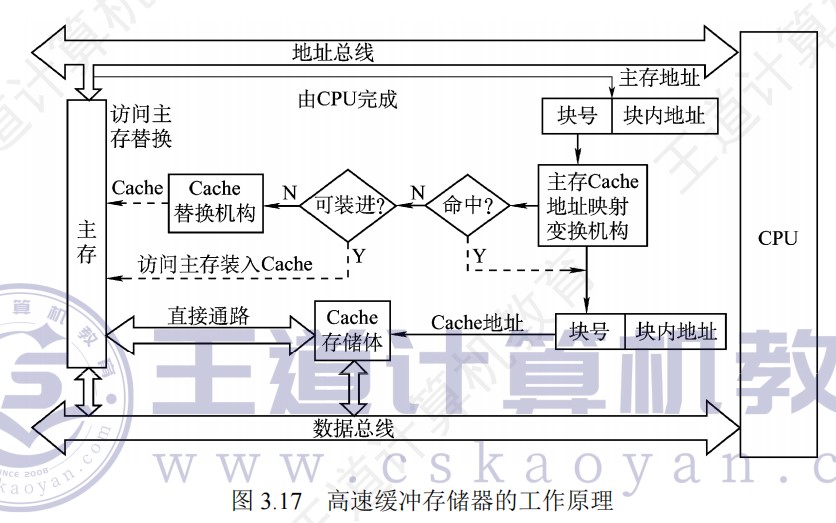

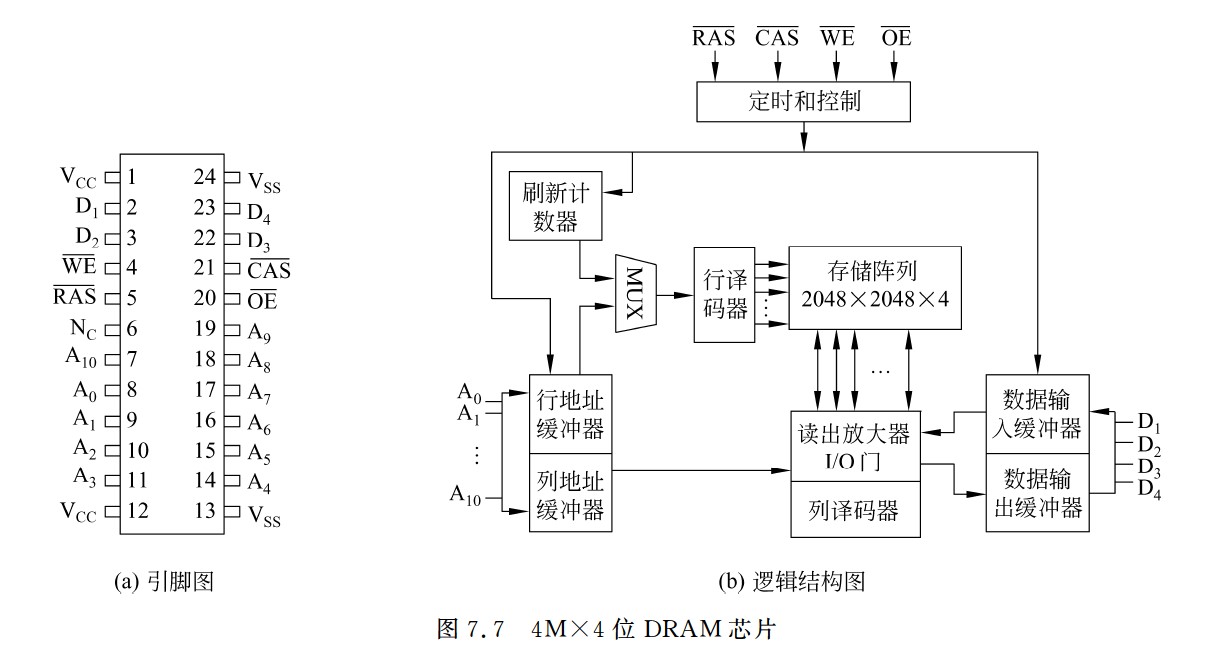

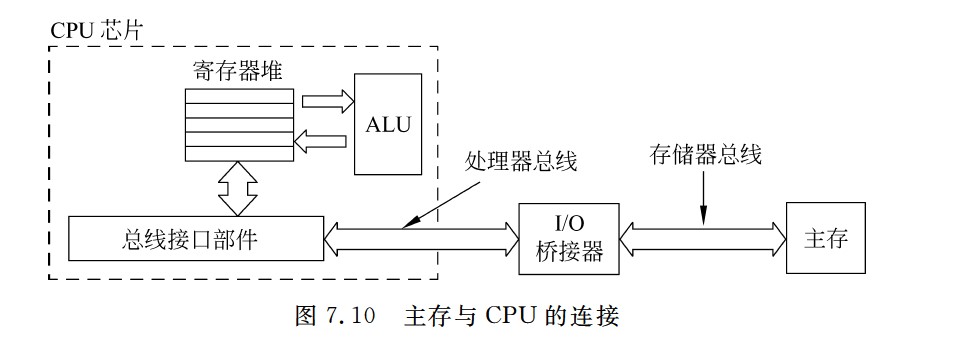

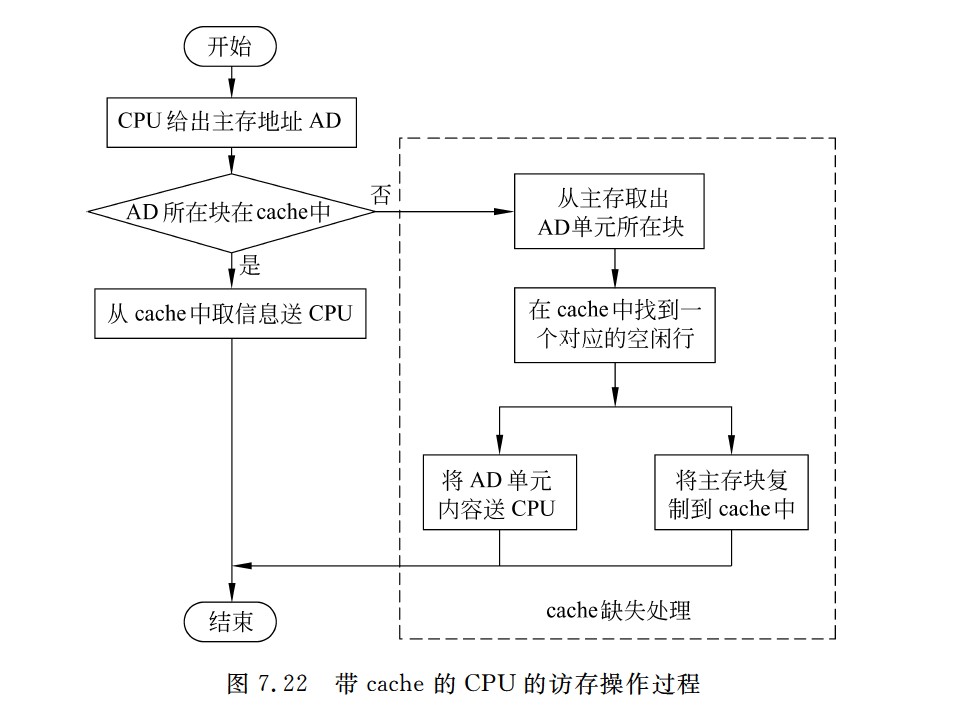

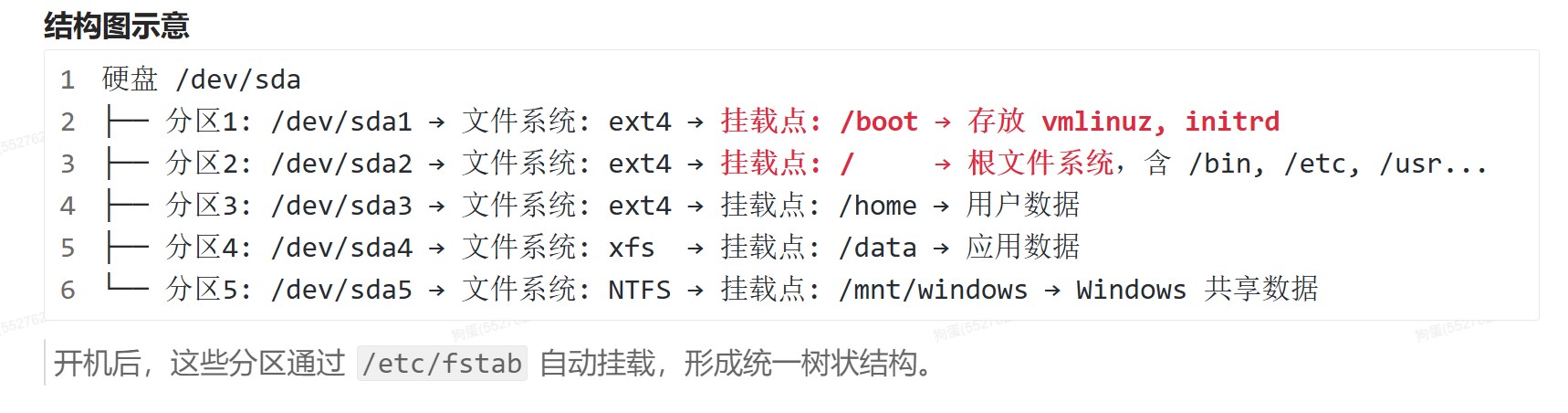

存储系统

概述

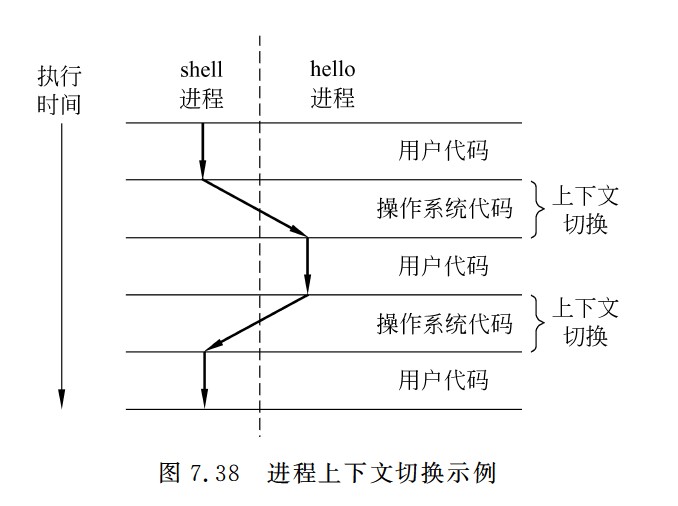

- 主存和Cache之间的数据调动是由硬件自动完成的,对所有程序员均是透明的。主存和辅存之间的数据调动是由硬件和操作系统共同完成的,对应用程序员是透明的

- 主存主要是由DRAM实现,Cache则由SRAM实现

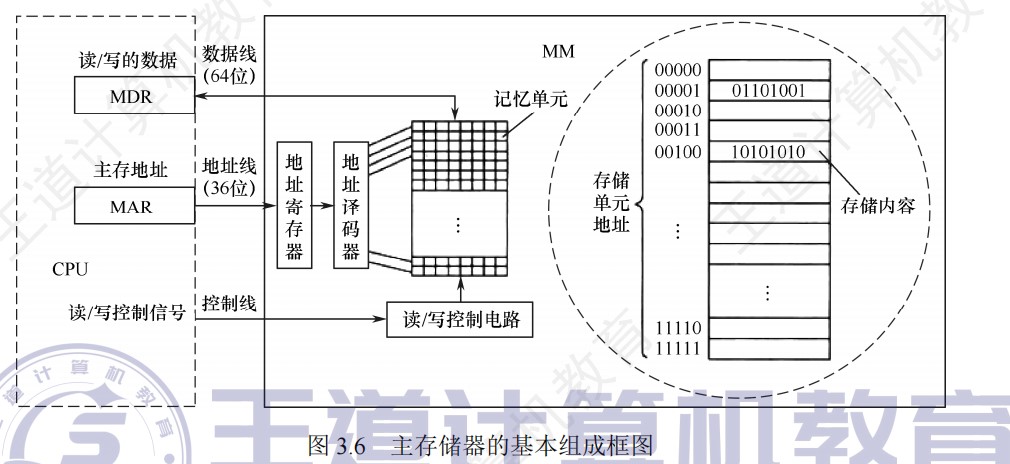

主存储器

-

固态硬盘属于半导体存储器,其核心存储介质为闪存,不同于机械硬盘

-

寄存器属于半导体存储器

-

主存和外存之间的交换通常采用DMA方式

-

ROM通常存放系统程序、标准子程序和各类常数,RAM则是为用户编程而设置的

-

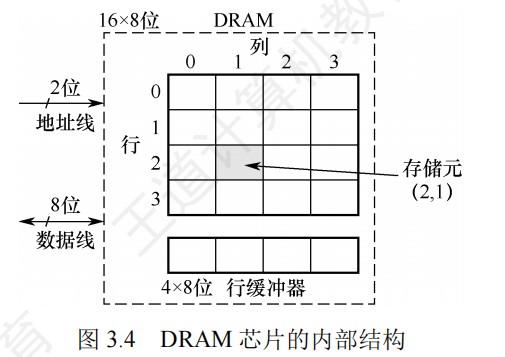

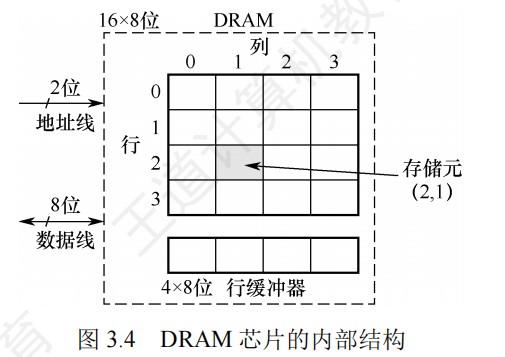

行列地址线复用的情况下,由于DRAM按行刷新,因此行地址位数要小于等于列位地址数,而地址线条数=max(列地址位数,行地址位数)

-

地址线和译码器输出的选择线的关系:n条地址线,译码输出的选择线是2^n条

-

DRAM按行刷新,刷新计数器和行地址一样,送往行译码器再进行行选,所以刷新计数器即地址线根数=log行数bit

-

行缓冲为一行的数据大小=列数*数据位数

-

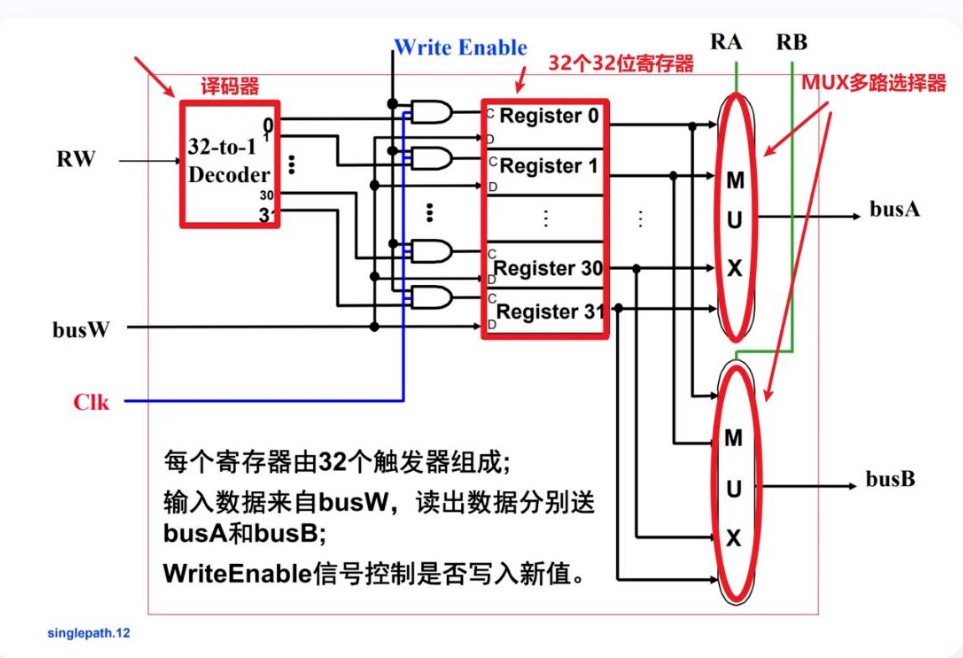

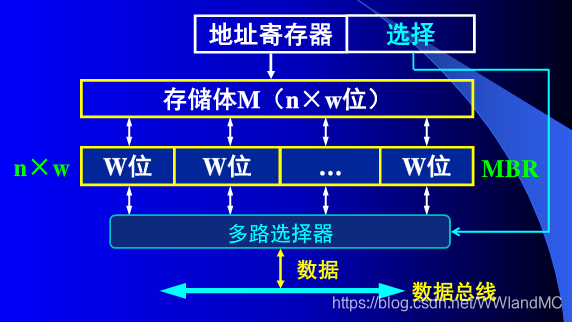

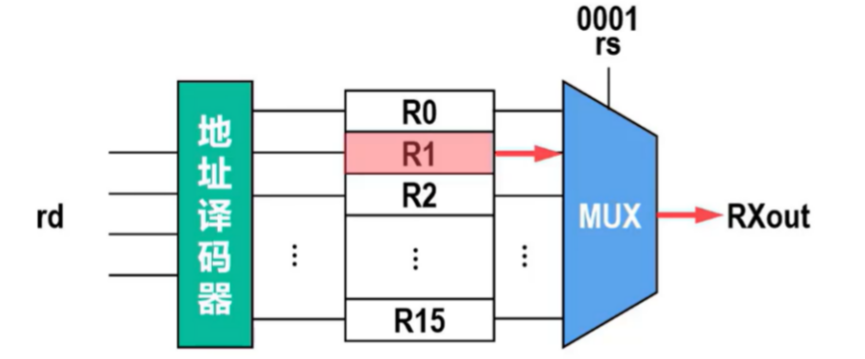

多路选择器是一种能够从多个输入信号中选择一个输出的信号转换设备。译码器是一种将二进制编码转换为一组特定输出信号的设备。在寄存器堆中,译码器常常用于地址译码,从而控制对特定寄存器的访问。

- 执行寄存器写相关指令时(将结果保存在寄存器中),指令中的寄存器编号被送到一个地址译码器进行译码,选中某个寄存器进行写入,读出时(从寄存器中获得计算数据)寄存器编号作为一个控制信号来控制一个多路选择器,选择相应的寄存器读出。

- 读口(组合逻辑操作):无需时钟控制,busA和busB分别由RA和RB给出地址。地址RA或RB有效后,经一个“取数时间(AccessTime)”,busA和busB有效

- 写口(时序逻辑操作):需要时钟控制。写使能为1的情况下,时钟边沿到来时,busW传来的值开始被写入RW指定的寄存器中。

- 写是需要改变寄存器的值的,需要等到数据的信号稳定后写入,防止出错。而读只需要和寄存器里的值相等就行

-

SRAM不地址复用,DRAM地址复用

-

SRAM的静态是指即使信息被读出后,它仍保持其原状态不需要再生(非破坏性读出)

-

刷新对CPU透明,即不依赖于外部的访问,芯片内部自行生成刷新的行的地址

-

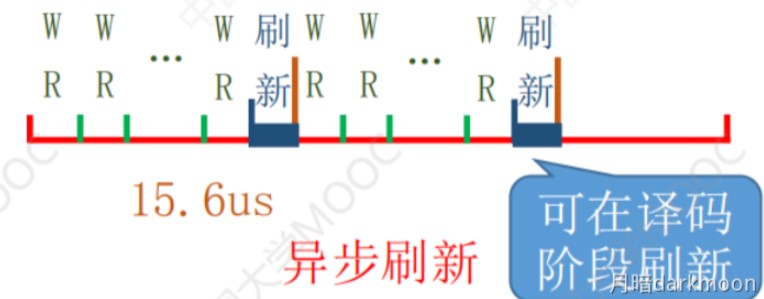

DRAM按行刷新,所有芯片同时刷新某一行,时间间隔是刷新周期/行数

-

-

异步刷新的死时间率=读写周期/(刷新周期/行数)*100%

-

刷新和再生的区别

- 刷新以行为单位逐行恢复数据,而再生仅需要恢复被读出的那些单元的数据

- 刷新每隔一段时间固定发生,而再生是发生在有人对数据进行了读取之后

-

行缓冲器的大小=列数 * 存储元的位数,用SRAM实现,选中某行后,该行的所有数据都被送到行缓冲器,以后每个时钟都可以连续地从DRAM中输出一个数据,因此可以支持突发传输(在寻址阶段给出数据的首地址,在传输阶段可传送多个连续存储单元的数据)

-

SDRAM(同步DRAM芯片),与CPU的数据交换同步于系统的时钟信号,并且以CPU-主存总线的最高速度运行,不需要插入等待状态,在时钟的控制下进行数据的读写,将CPU发出的地址和控制信号所存起来,经过指定的时钟周期数后再响应,此时CPU可以执行其他操作

- 在传统DRAM中,CPU将地址和控制信号送至存储器后,需要经过一段延迟时间,数据才读出或写入,在此期间,CPU不断采样DRAM的 完成信号,在读写完成之前,CPU不能做其他工作,降低了CPU的执行速度

- SDRAM支持突发传送,只要在第一次存取时给出首地址,以后按地址顺序读写即可,不再需要地址建立时间和行、列预充电时间,就能快速连续地从行缓冲器中输出一连串数据。

- 行缓冲器用来缓存指定行中每一行的数据,通常用SRAM实现,内部的工作方式寄存器(也称模式寄存器)可用来设置传送数据的长度以及从收到读命令(与CAS信号同时发出)到开始传送数据的延迟时间等,前者称为突发长度(BL),后者称为CAS潜伏期(CL),根据BL和CL,CPU可以确定何时开始从总线上取数以及连续取多少个数据

- 在开始的第一个数据读出后,同一行的所有数据都被送到行缓冲器中,以后每个时钟可从SDRAM读取一个数据,并在下一个时钟内通过总线传送到CPU

-

采用n位预取技术,存储器总线每秒传送数据的次数为芯片频率 n,带宽为每秒传送数据的次数*存储器总线每次传输的数据大小,总线时钟频率=每秒传送数据的次数/2(/2是因为一个时钟上升沿和下降沿都在传送,传送两次)*

-

突发传送下带宽的计算:突发传送是在完整的存储周期之后才传输数据,也就是说,第一个存储周期负责传送发送信息和数据,之后的时间负责传输剩余n-1个数据,带宽=一次突发传送的数据大小/一次突发传送的时间

-

存储器相同行、列上的多位(位平面数)同时被读出或写入

-

DRAM芯片目前普遍采用双译码结构

-

寄存器用触发器实现

-

SRAM和DRAM都是MOS管型半导体存储器,而ROM是双极型半导体存储器

-

现在的DRAM芯片采用行缓冲,可能因为位置不同而使访问时间有所差别,当访问的数据所在行已经被加载到行缓冲中时,访问时间较短(行命中),但如果访问的数据不在行缓冲中,则需要先选中对应的行,再从该行中读取数据

-

有些芯片的存储阵列采用三维结构,用多个位平面构成存储阵列(即后面所说的位扩展),不同位平面在同一行和列交叉点上的多位构成一个存储字,被同时读出或写入

-

行列译码器的方案下,高位是行地址,低位是列地址,每个存储单元只有行选通线和列选通线同时被选中时才能被选中

-

刷新放大器是集成在RAM上的,因此,刷新只进行了一次访存,也就是占用一个存取周期

-

如果将刷新安排在不需要访问存储器的译码阶段,既不会加长存取周期,又不会产生死时间,这是分散刷新的方式的发展,也称之为透明刷新

- 为什么每出现新一代DRAM芯片,容量至少提高到4倍?

- 行地址和列地址分时复用,每出现新一代DRAM芯片,至少要增加一根地址线,则行地址和列地址各增加一位,所以行数和列数各增加一倍,因而容量至少提高到4倍

- MAR的位数决定了主存地址空间的大小,MAR应保证访问到整个主存地址空间

多模块存储器

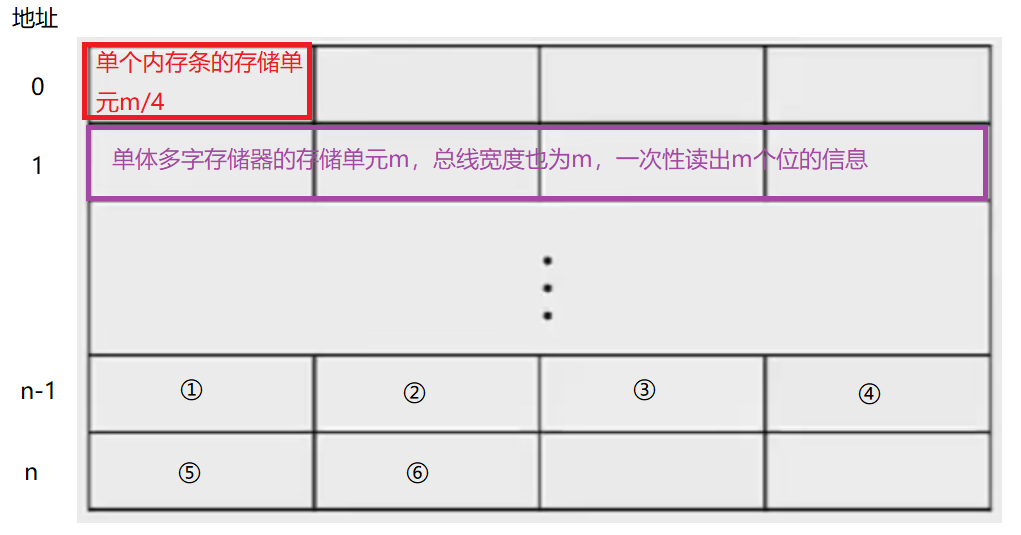

单体多字存储器

-

相当于把n个内存条的存储单元看作一个整体的存储单元,只有一套读写电路、地址寄存器和数据寄存器,当我们想要读取某个信息都是一排一排地读取的

-

如果我们想要的信息是存储在连续一排的空间时:

假设存取周期T=存取时间r+恢复时间3r,这种情况下我们在一个时间T内可以读取①②③④的信息,然后⑤所在的内存条的恢复时间刚过完,我们继续读取即可,而不采用并行设计时需要的时间为4T

-

如果我们想要的信息是③④⑤⑥这样不在一排的信息时,我们就需要读取两排的信息,这时还会读入不需要的信息①②

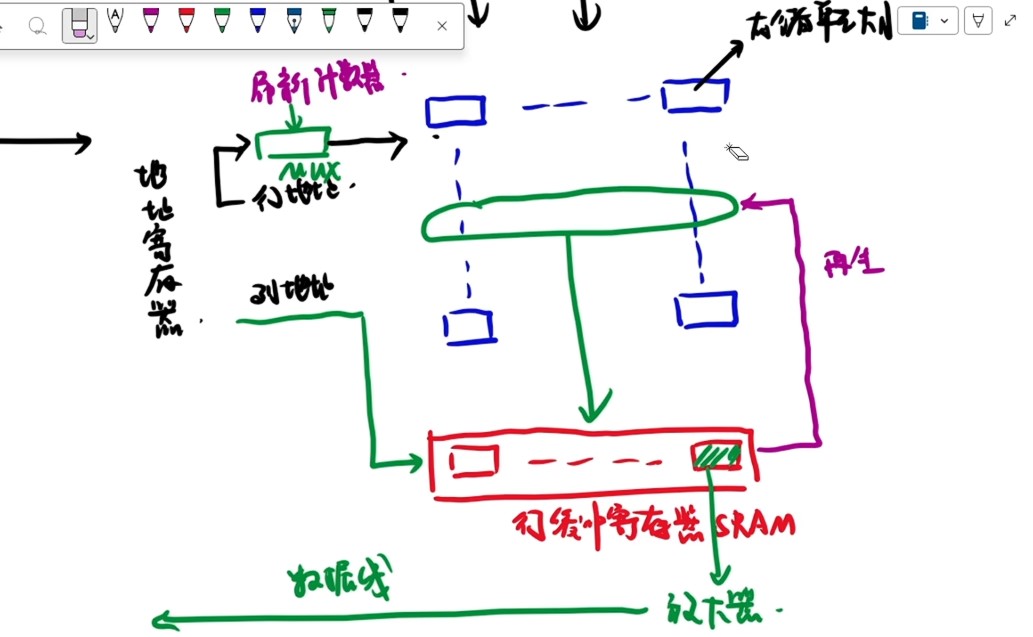

多体并行存储器

-

各模块都有独立的读/写控制电路、地址寄存器和数据寄存器、地址译码器,既能并行工作,又能交叉工作。

-

多模块的模块数m,应该是和存储周期T和总线传输周期r有关,与存取时间无关

-

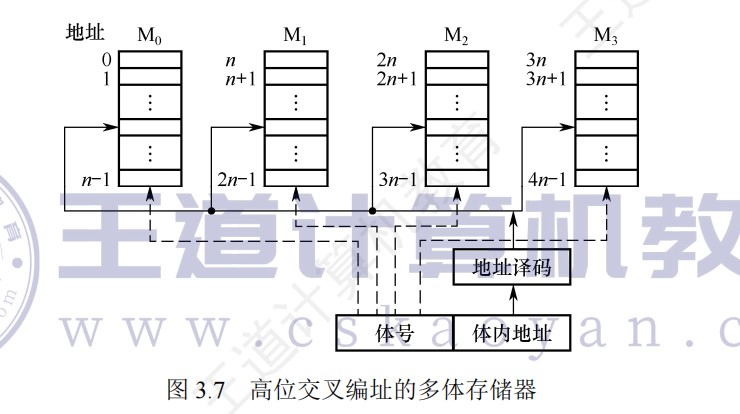

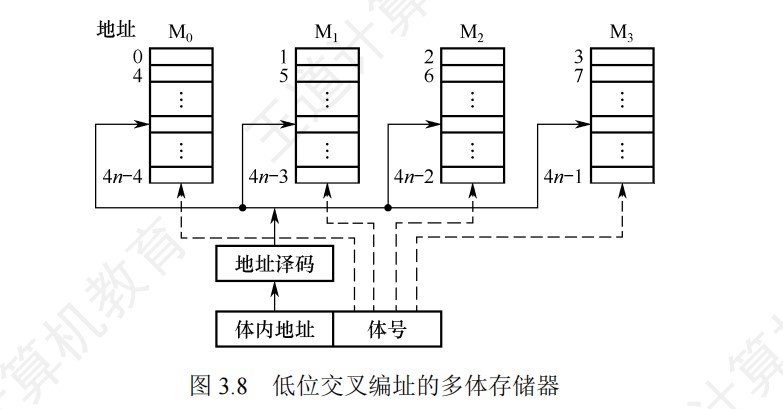

交叉编址一般就是指低位交叉编址,连续编址在一般指的是高位交叉编址

-

轮流启动:一个块的长度=数据通路的长度(总线一次性可以传输的位数),因此只能一块块取

-

①给出首地址

-

②启动第一个存储单元所在的存储体(准备数据)

-

③传输数据

-

-

同时启动:所有块的长度=数据通路的长度,因此可以同时一把抓

- 类似广播机制:将不同体内相同体内地址共同送入地址线中

-

高位交叉编址的存取方式仍然是串行存取,这种存储器仍然是顺序存储器

-

CPU一次读取操作实际上分成三个步骤:①地址和命令的传输时间②主存准备数据的时间③传输时间,而存取时间只是主存接收到读写命令开始到信息被送入数据线上的时间,或者说准备数据的时间,即②的时间

-

因此,标准的流水存取示意图中,第一个模块在T(存储周期)之后还要经过一次r(总线传输周期),才能够完成第一个模块的传输,读取到数据,而T+r的时候第二个存储字才准备好,然后接下来经过一个r的时间去进行一个传送

-

存取周期用来准备数据,准备好之后才是传输

-

-

经典计算题

- 类似的题目先计算前面的轮数,最后一轮单独计算

- t=T+(m-1)r,其中T是存取周期,r是总线周期,m是读取的块数

-

一段访存的过程中某两次访存会发生冲突的条件是:这两次访存过程将访问相同的模块并且两次访问间进行了不到【T/r-1】个访存过程

-

突发传送和Cache和交叉存储器的计算

关于交叉存储器(低位交叉编址)检测访问冲突的一种算法

【组成原理-存储】关于交叉存储器检测访问冲突的一种算法_访存冲突-CSDN博客

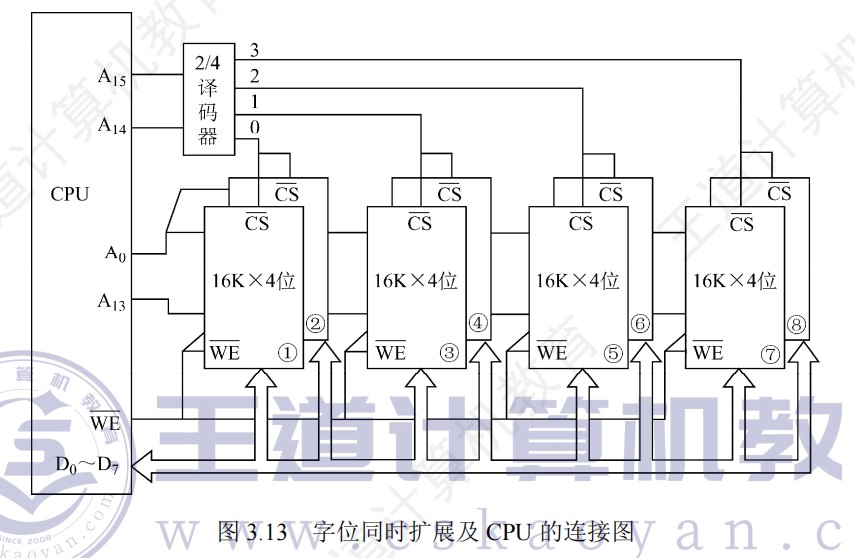

主存容量的扩展

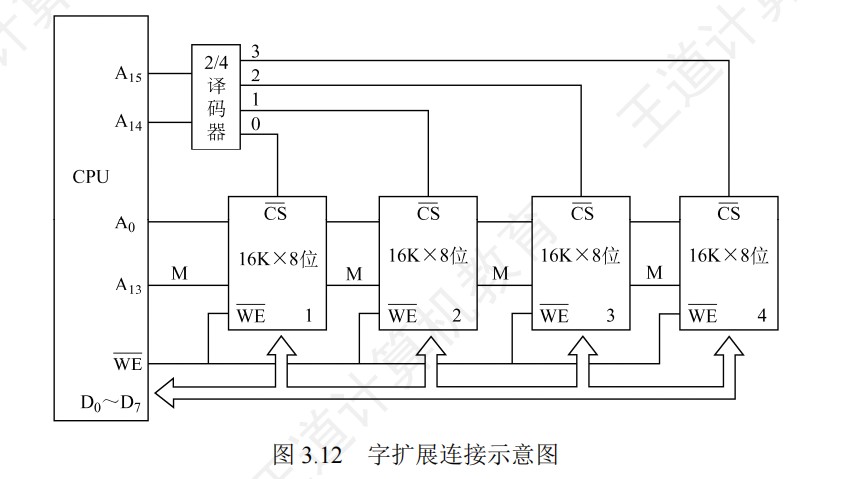

- 字扩展的情况下,各芯片分时工作

- 高位片选信号

- 片内地址线由低到高,片选信号线范围内也是由低到高

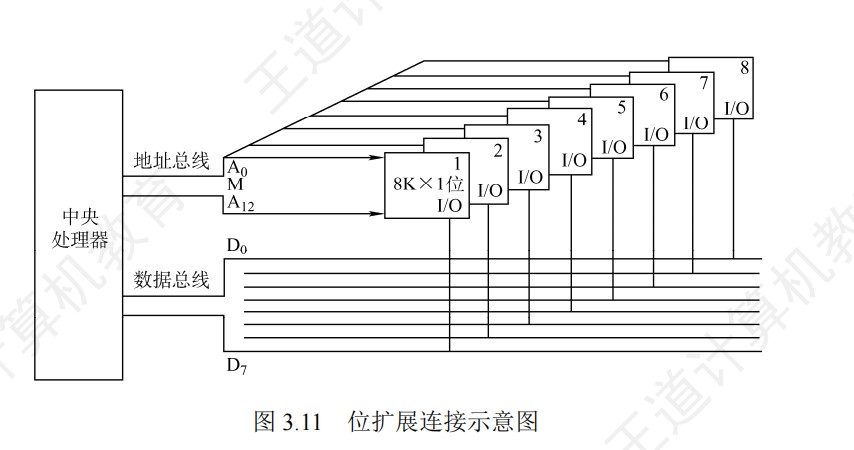

- 位扩展的情况下,各芯片同时工作

- 字位同时扩展:先位扩展再字扩展

- 将进行位扩展的芯片作为一组,各组的连接方式与位扩展的相同;由系统地址线高位译码产生若干片选信号,分别接到各组芯片的片选控制线

- 地址计算:

- 以芯片组为单位,看前面的字不看位,字有2^n位,那么片内地址就是n位,前面的根据有2^n组,那么就有n位片选信号,拼在一起构成地址,每组最低位就是片内地址全0,最高就是片内地址全1

- **地址主要用来确定访问哪个存储模块(组),而同一模块内的多个芯片共享相同的地址,通过数据总线的不同位来区分。**因为是先位扩展再字扩展,实际上同一个芯片组共享同样的行数,地址相同,区别在于数据引脚连接的是哪几根数据线

片选和线选

- 线选法,当某位地址线信息为0的时候,就选中与之对应的存储芯片,每次只能一位有效

- 字选的译码是由芯片的片内逻辑完成的,片选的译码由外接译码器逻辑完成

- 片选情况下,地址总位数=片选地址位数+字选地址位数

外存

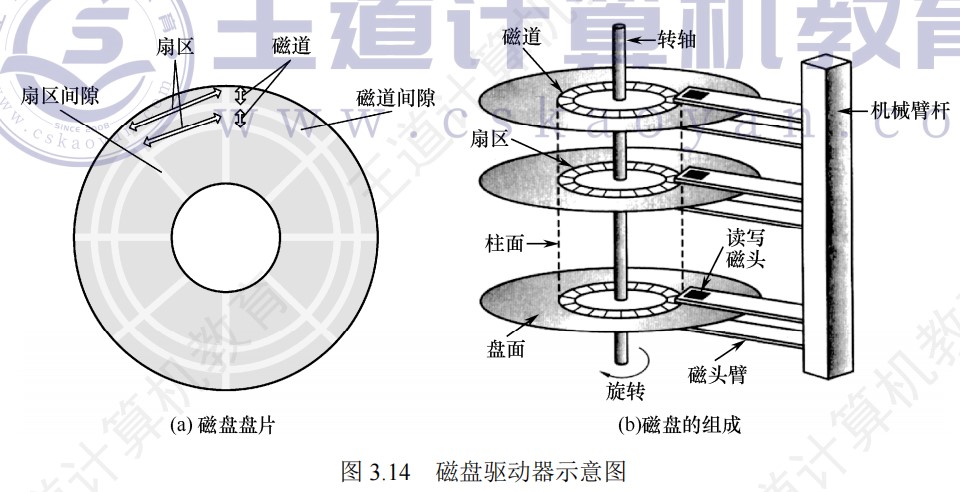

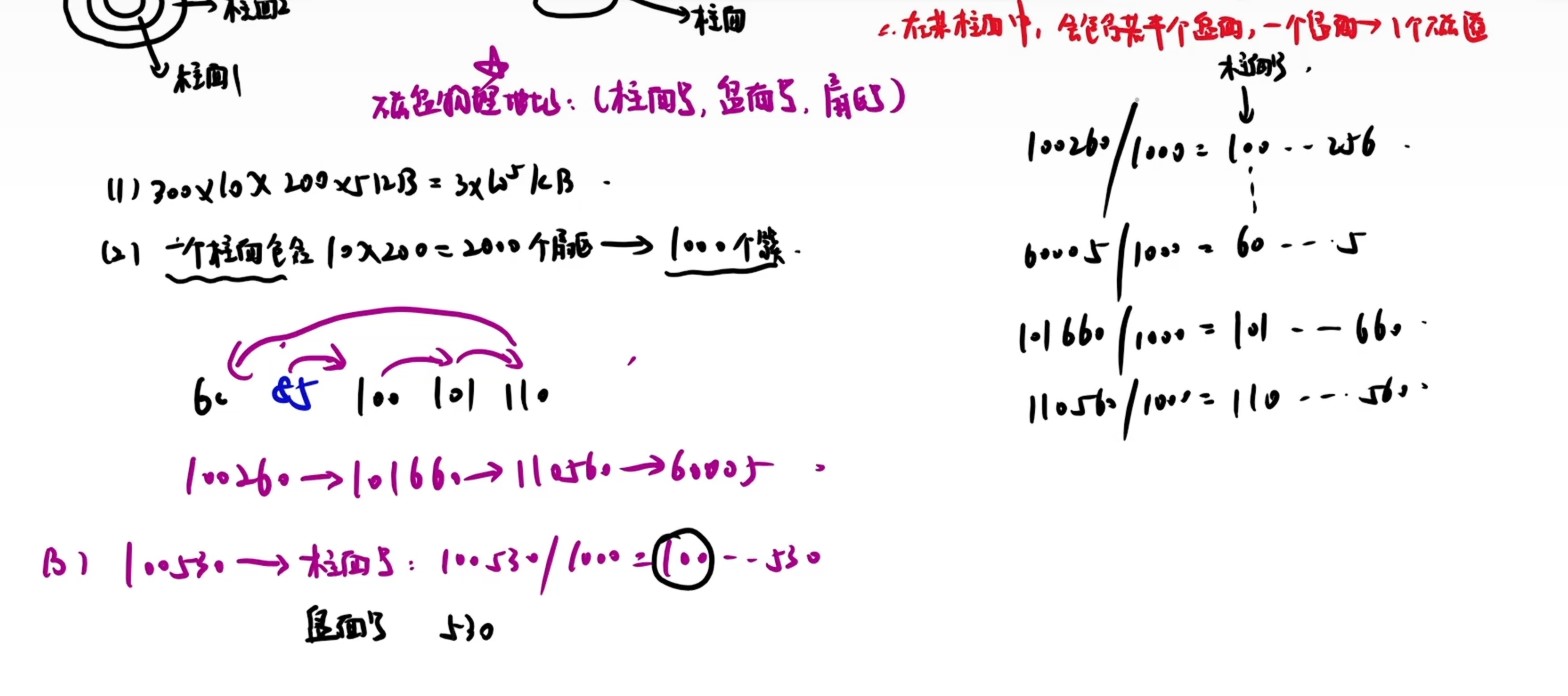

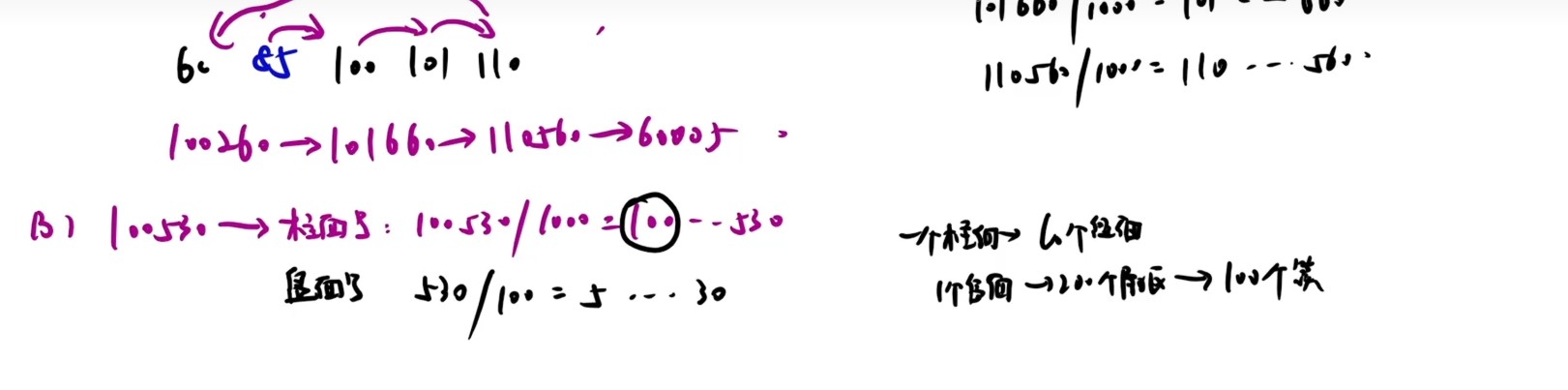

磁盘

-

磁盘对工作环境要求较高

-

磁盘控制器负责接收并解释CPU发来的命令,然后再根据命令向磁盘驱动器发出各种控制信号,并检测磁盘驱动器的状态

-

扇区是磁盘读写的最小单位,即磁盘按块存取

-

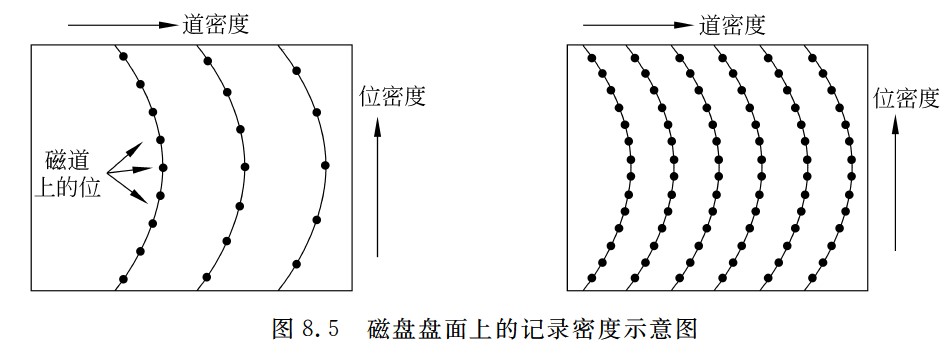

磁盘的存储能力受限于最内道的最大记录密度

-

磁盘高速缓存:在内存中开辟一部分区域,用于缓冲将被送到磁盘上的数据。

- 优点:写磁盘时按簇进行,可以避免频繁地用小块数据写盘;有些中间结果数据在写回磁盘之前可被快速地再次使用

-

磁盘容量有非格式化容量和格式化容量之分。

- 非格式化容量是指磁记录表面可利用的磁化单元总数,非格式化容量=记录面数×柱面数×每条磁道的磁化单元数。

- 格式化容量是指按照某种特定的记录格式所能存储信息的总量。格式化容量=记录面数×柱面数×每道扇区数×每个扇区的容量。

- 格式化后的容量比非格式化容量要小。

-

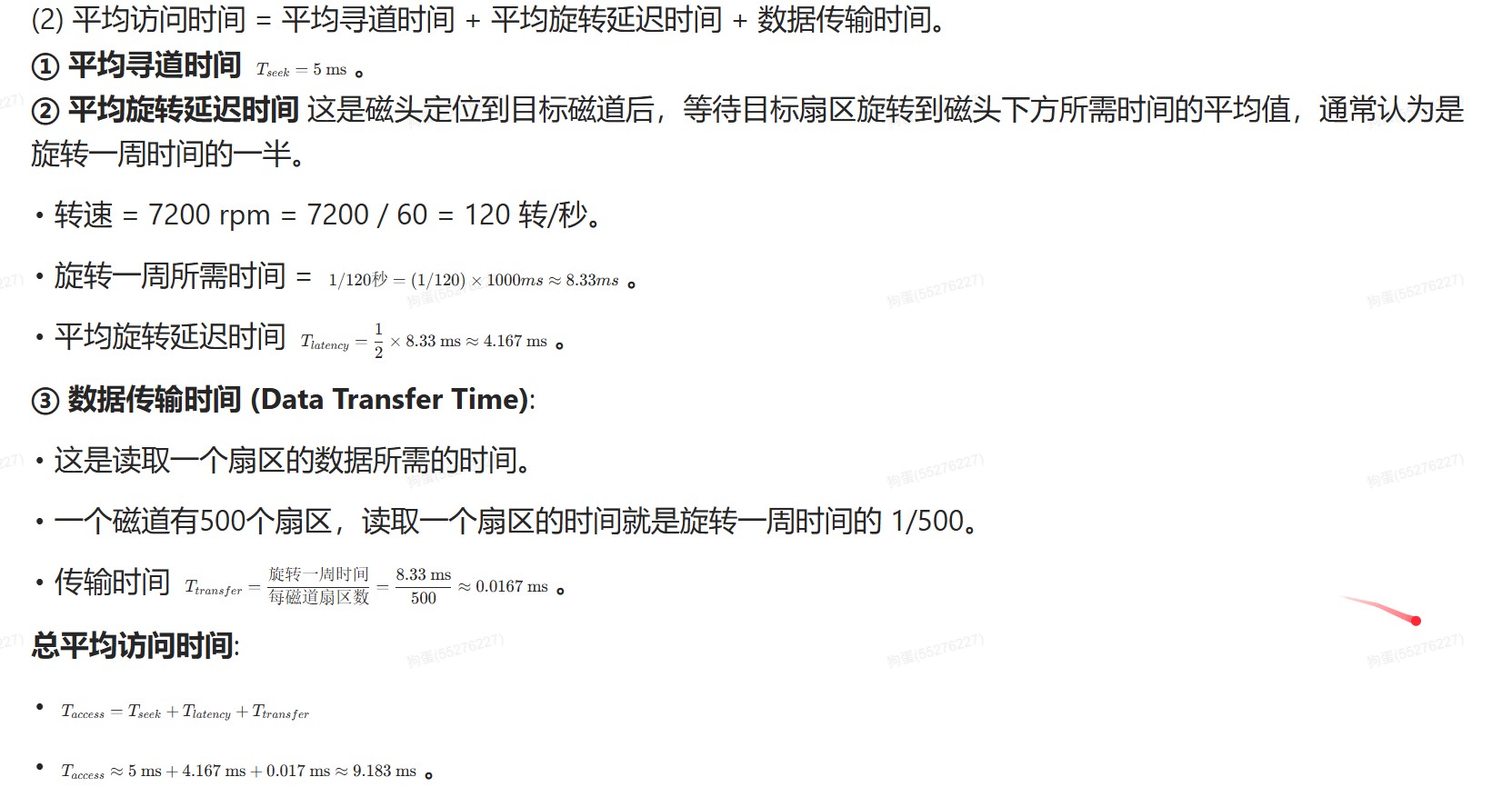

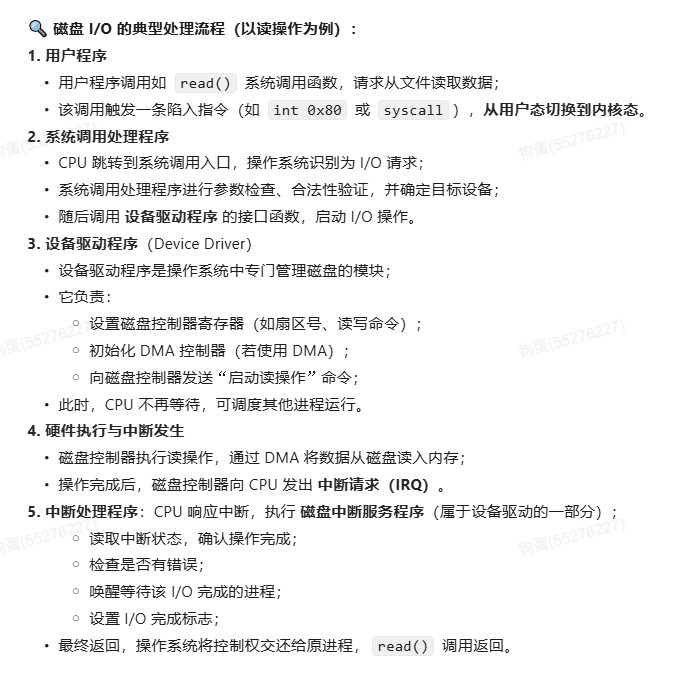

存取时间

- 存取时间由**寻道时间(磁头移动到目的磁道的时间)、旋转延迟时间(磁头定位到要读/写扇区的时间)和传输时间(传输数据所花费的时间)**三部分构成。

- 寻道时间和旋转延迟时间通常取平均值(平均寻道时间取从最外道移动到最内道时间的一半,平均旋转延迟时间取旋转半周的时间)。

-

磁盘读/写操作是串行的,不可能同时读写,也不可能同时读两组数据或者写两组数据

-

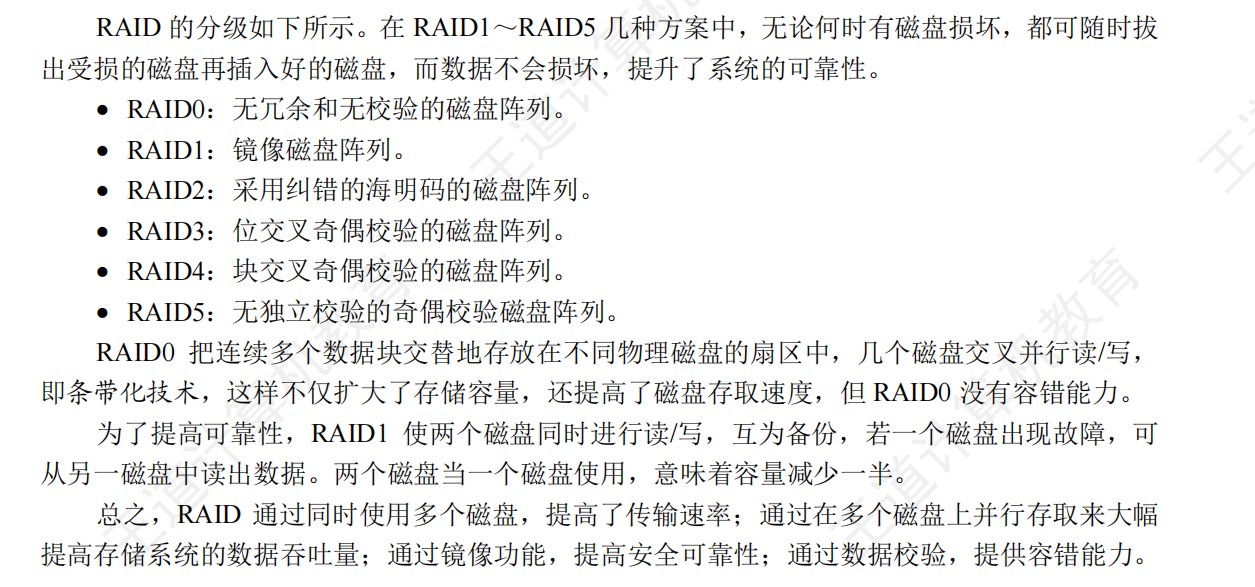

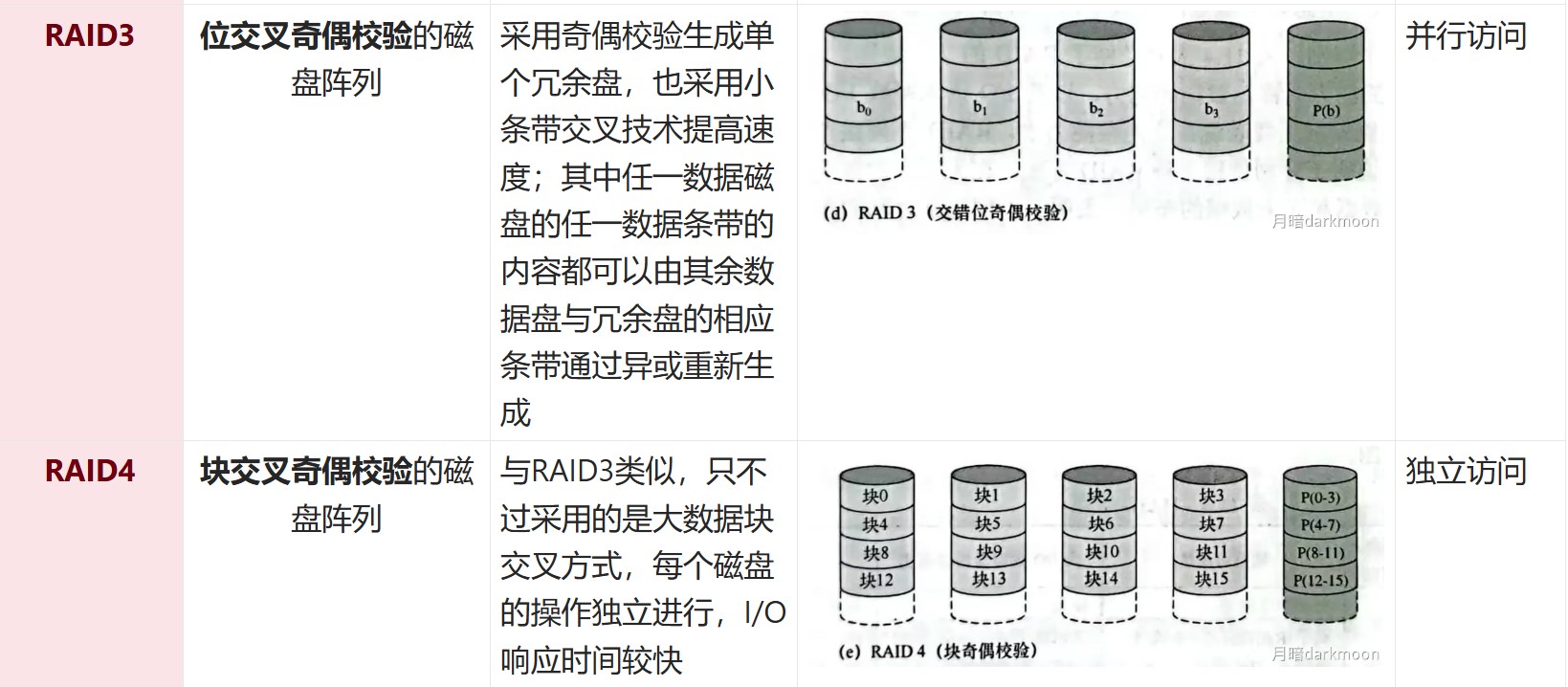

磁盘阵列

-

读取一个磁道数据的时间=磁盘旋转一周的时间-通过扇区间隙的总时间

-

一个扇区的传输时间=(分/转数)/扇区数量

-

序号/一个柱面上的扇区数=柱面号余X

- 磁道号为X/每条磁道上的扇区数

- 扇区号为Xmod每条磁道上的扇区数

-

沿磁盘半径方向单位长度的磁道数称为道密度,道密度是相邻磁道间距的倒数

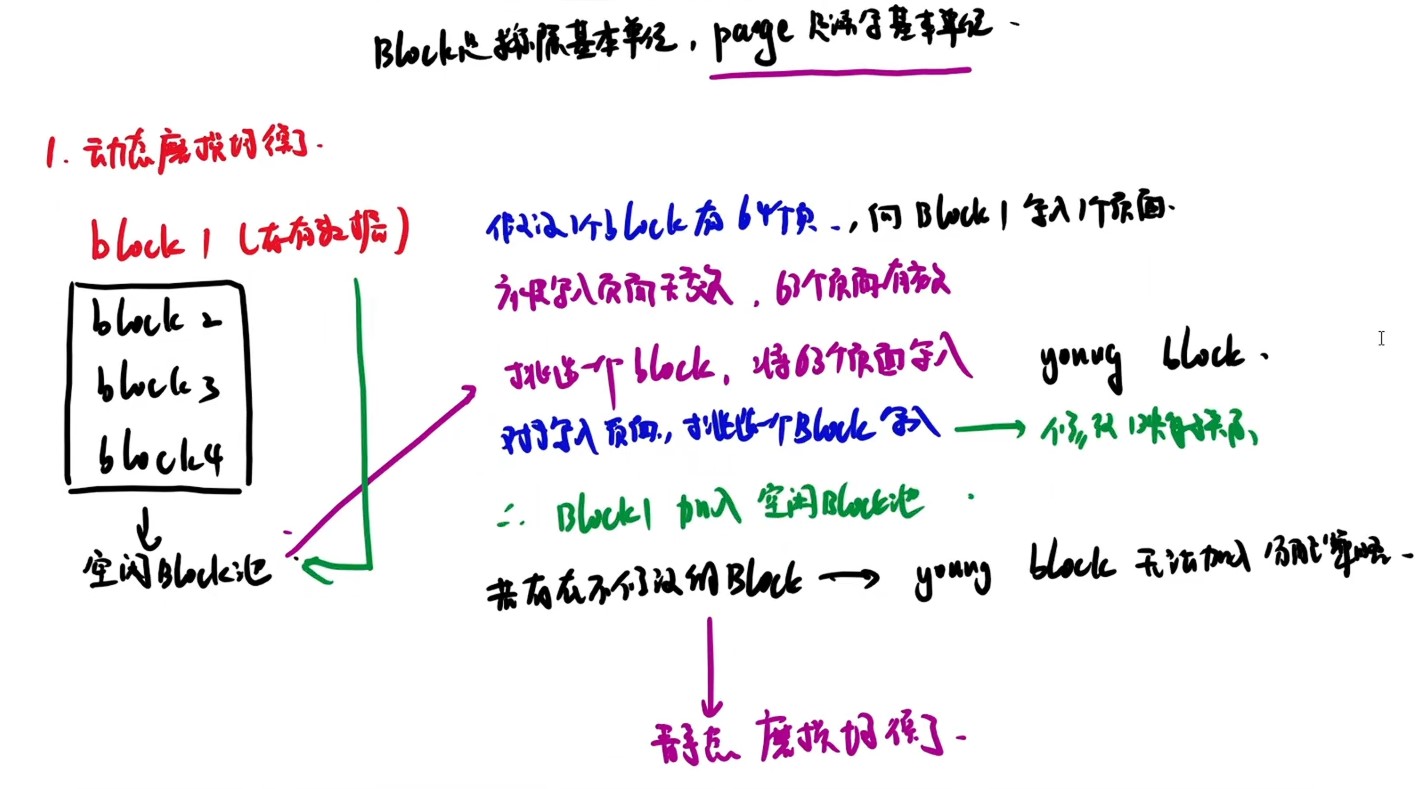

固态硬盘

- 以页为单位进行读写,以块为单位进行擦除,只有在一页所属的块整个被擦除后,才能写这一页。

- 写操作中试图修改一个包含已有数据的页,则这个块中所有含有用数据的页都必须被复制到一个新(擦除过的)块中,然后才能对页进行写操作。

- 固态硬盘比机械硬盘能耗更低、抗震性更好、安全性更高

- 所有存储元最初都是“1"状态,需要改写0的时候才进行改动

- 动态算法每次都挑最年轻的内存块来用,老的内存块尽量不用;静态算法把长期没有修改的老数据从一个年轻内存块里面搬出来,重新找个最老的内存块放着,这样年轻的内存块就能再度进入经常使用区。

- 将磁盘替换位随机访问的Flash半导体存储器后,FCFS调度策略效率最高

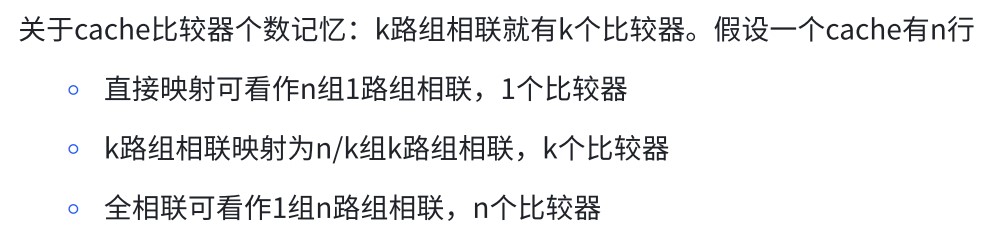

Cache

- cache比较器个数

-

Cache的替换由硬件实现

-

CPU和Cache的数据交换以字为单位,而Cache和主存之间的数据交换则以块为单位

-

未命中时,CPU从主存中读出地址所在的一块信息送到Cache行中,将有效位置1,并在标记设置为地址中的高t位,同时将该地址中的内容送CPU

-

指令Cache与数据Cache分离通常在L1级,此时通常为写分配法和回写法合用

-

标量没有空间局部性

-

评价一段程序的局部性特征时可以参考下列原则:

- 对相同变量有重复访问的程序有良好的时间局部性

- **对于具有步长为k且有引用模式的程序,步长越小,程序具有越好的空间局部性。**具有步长为1的引用模式的程序具有很好的空间局部性,在内存中以大步长跳来跳去的程序空间局部性会很差

- 对于取指令来说,循环体一般具有良好的时间局部性和空间局部性,循环体越小,循环迭代次数越多,局部性越好

-

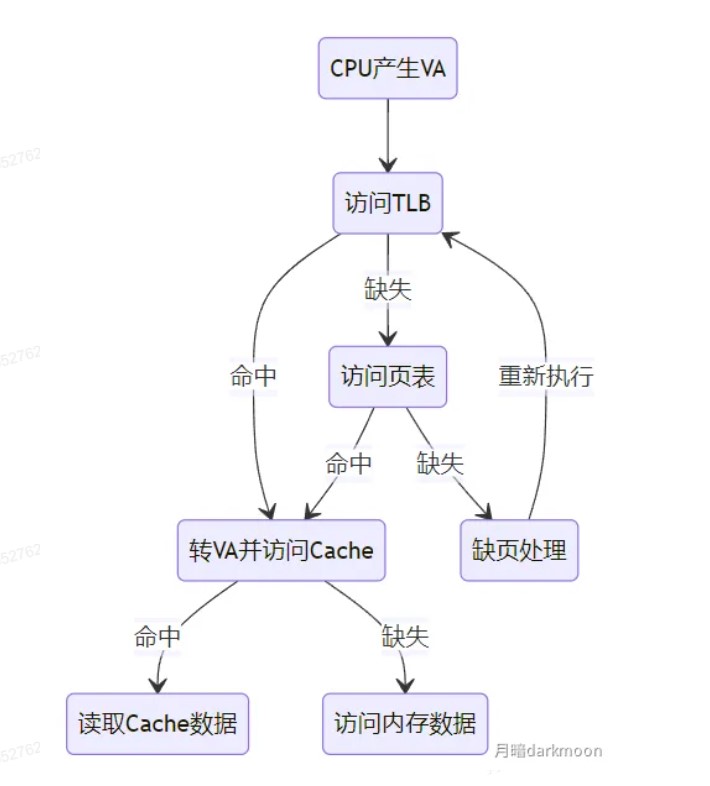

一次Cache访问缺失的时间为一次主存访问的时间和一次Cache访问的时间之和,而不是调入Cache之后再从Cache读

-

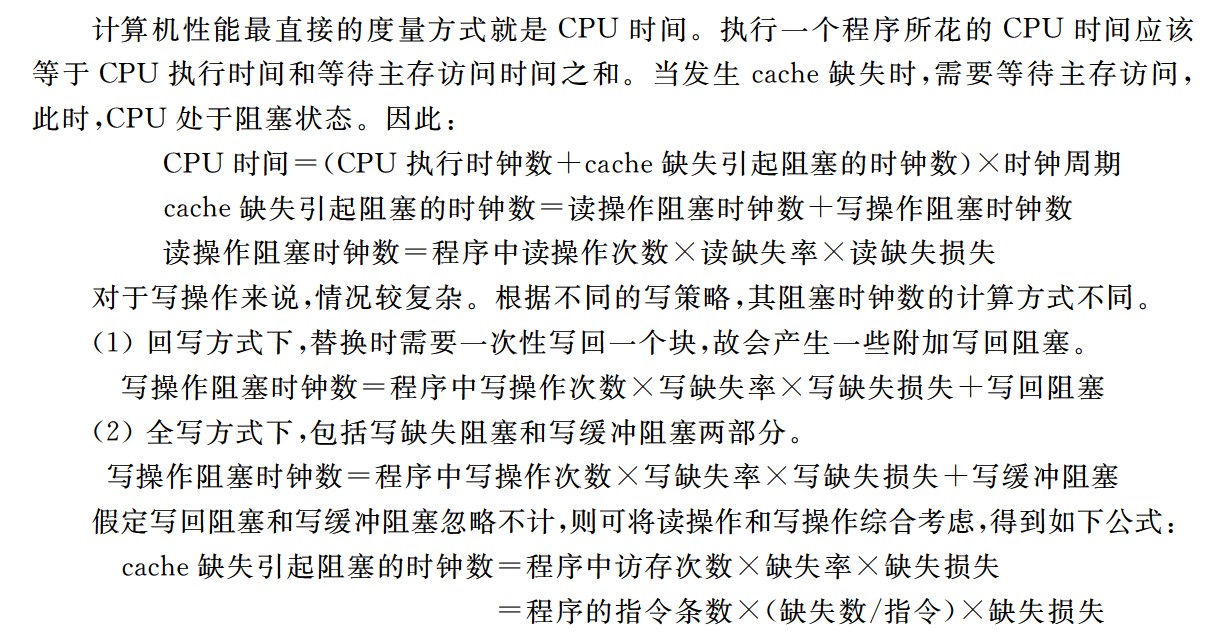

cache存取周期=cache-主存系统效率x平均访问时间

-

取指令 Cache 缺失的处理过程:若在 cache 中取当前指令时发⽣缺失,则处理器必须按如下步骤完成:

① 把程序计数器的值恢复到当前指令的地址,然后通过总线中的地址线送到存储器中的地址缓冲器中,以便存储器对地址译码。

② 控制存储器执⾏⼀次读操作(若⼀个主存块只有⼀条指令,则⼀次读操作读⼀条指令即可;若⼀个主存块占⽤多条指令,则控制⼀次读出多条指令或若干次),对主存的访问要通过总线完成,⼀次总线事务完成⼀次读操作。

③ 读出的指令写到 cache 中,并把主存地址的⾼位写⼊到标记字段,最后设置有效位。

④ 重新执⾏当前指令的第⼀步操作,即取指令,这次在 cache 中取指令时便能命中。显然,cache 缺失不是内部异常,更不是外部中断,不会引起对当前正在执⾏程序的“中断”,因⽽不会调出操作系统内核程序来处理 cache 缺失,即上述处理过程不是由软件完成的,⽽是由 CPU 这个硬件完成的。

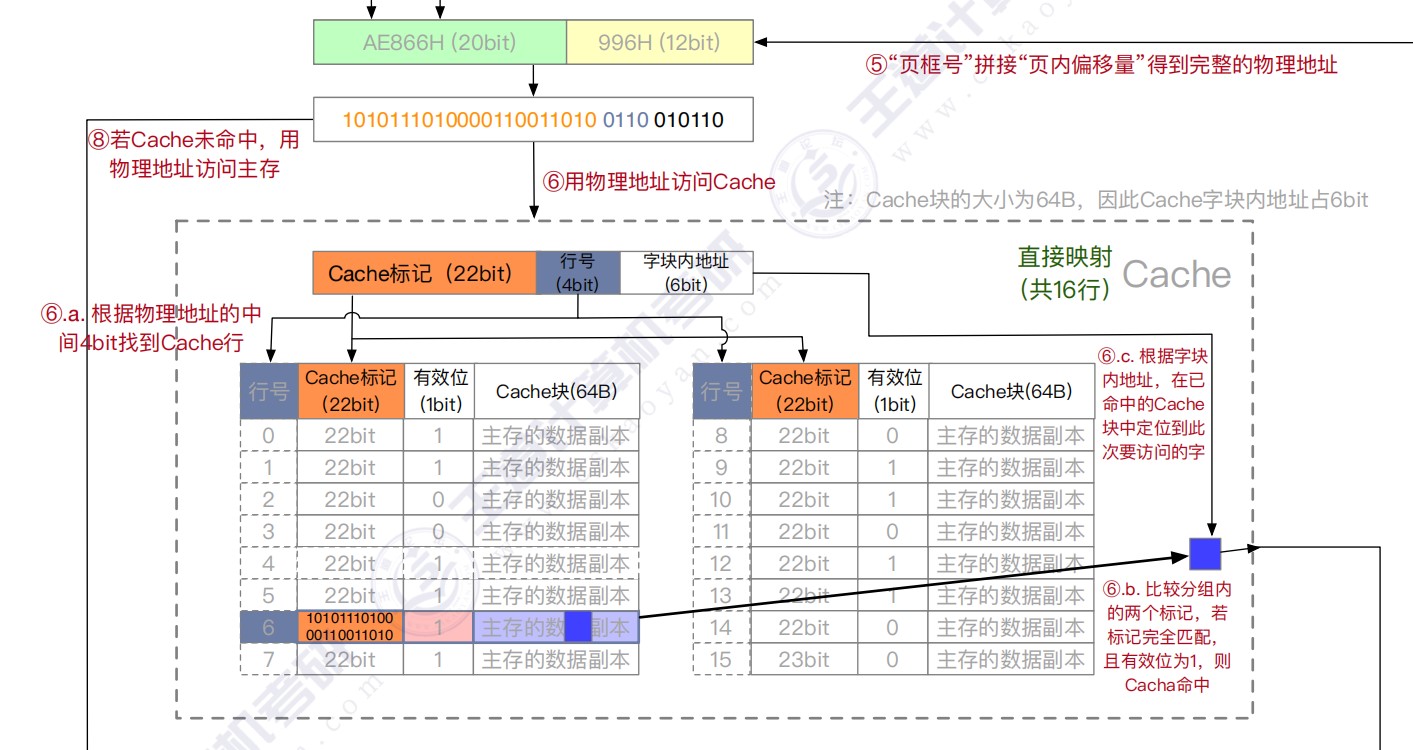

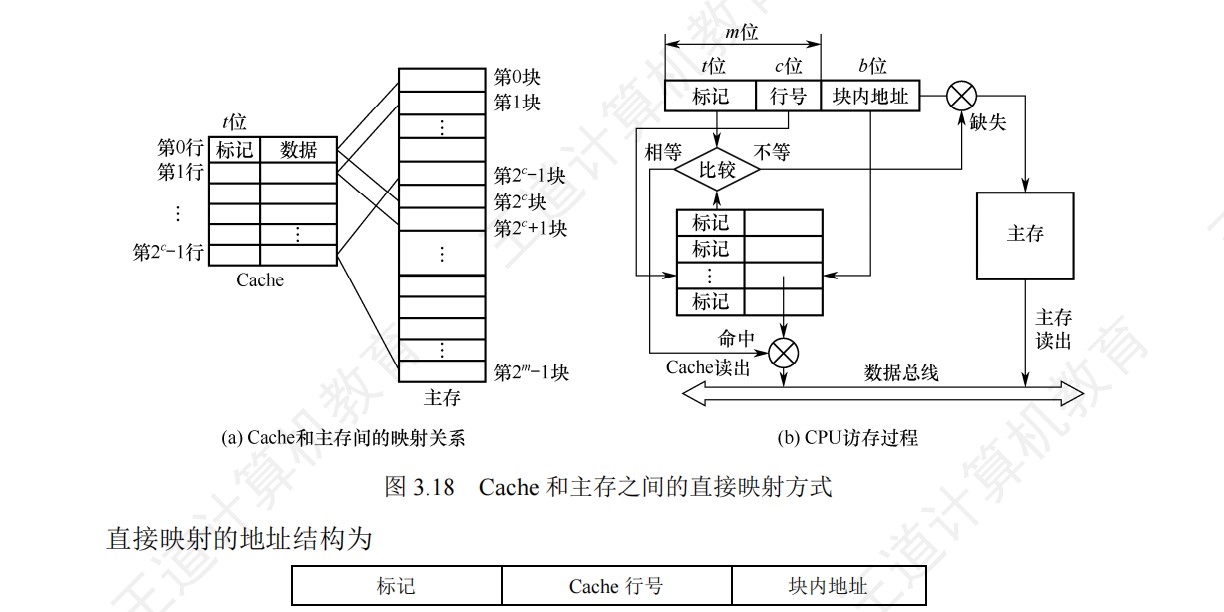

三种映射方式

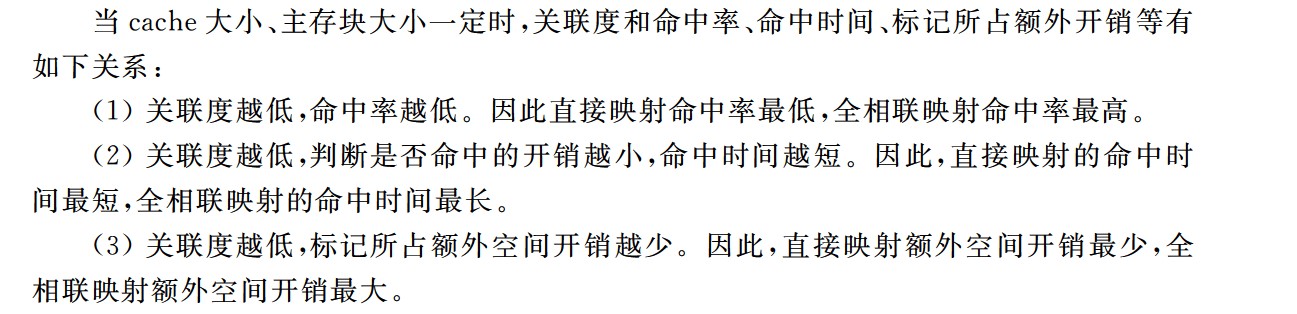

- 直接映射标记所占的额外空间开销最少,全相联映射标记所占的额外空间最大

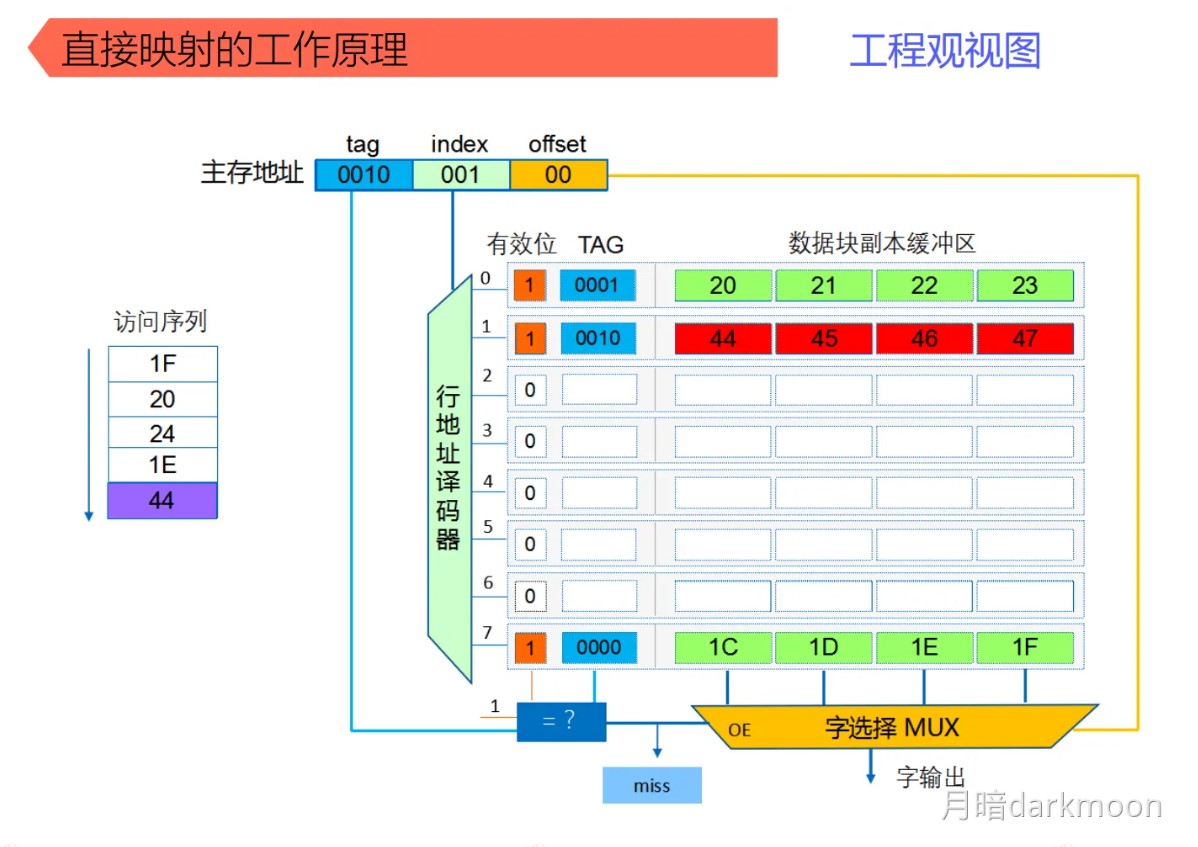

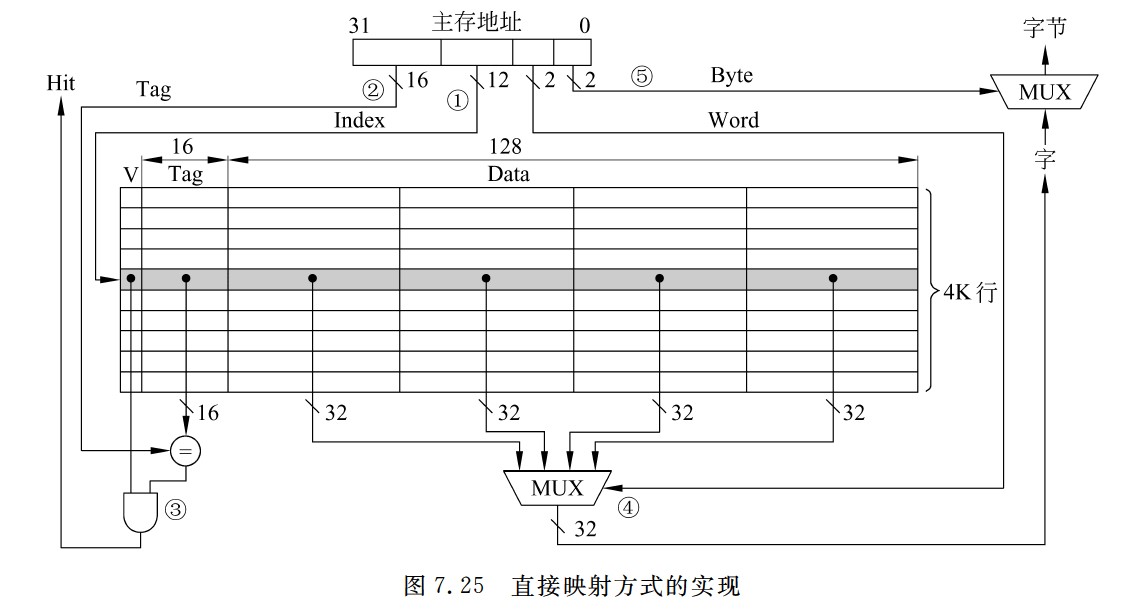

直接映射

-

直接映射无须使用替换算法,发生冲突时,原来的块将无条件被替换出去,冲突概率最高,空间利用率最低

-

容易实现,命中时间短

-

Cache行号=主存块号%Cache总行数

-

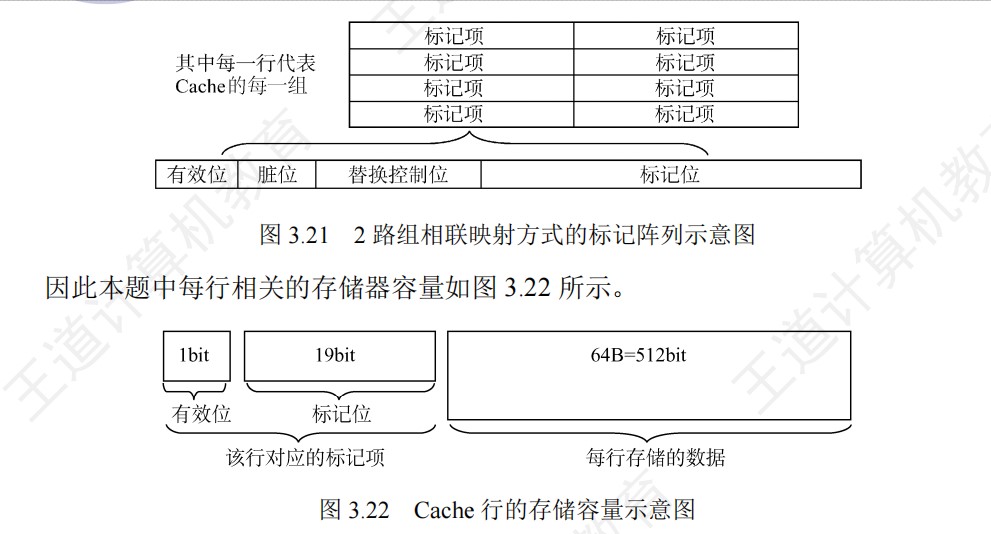

地址映射表的大小=Cache行数 * tag标记阵列bit数

- 主存容量是Cache容量的2^n倍,说明tag+行号=n位

-

直接映射给一个地址,硬件就可以直接得出它在Cache中所对应的行号,因为每个地址只可能映射到Cache中的一个地方(要么是它,要么不是它), 因此这里面比较器只要有一个就够用了,比较器两端的输入分别是地址块里的前n位标记和对应Cache行的地址

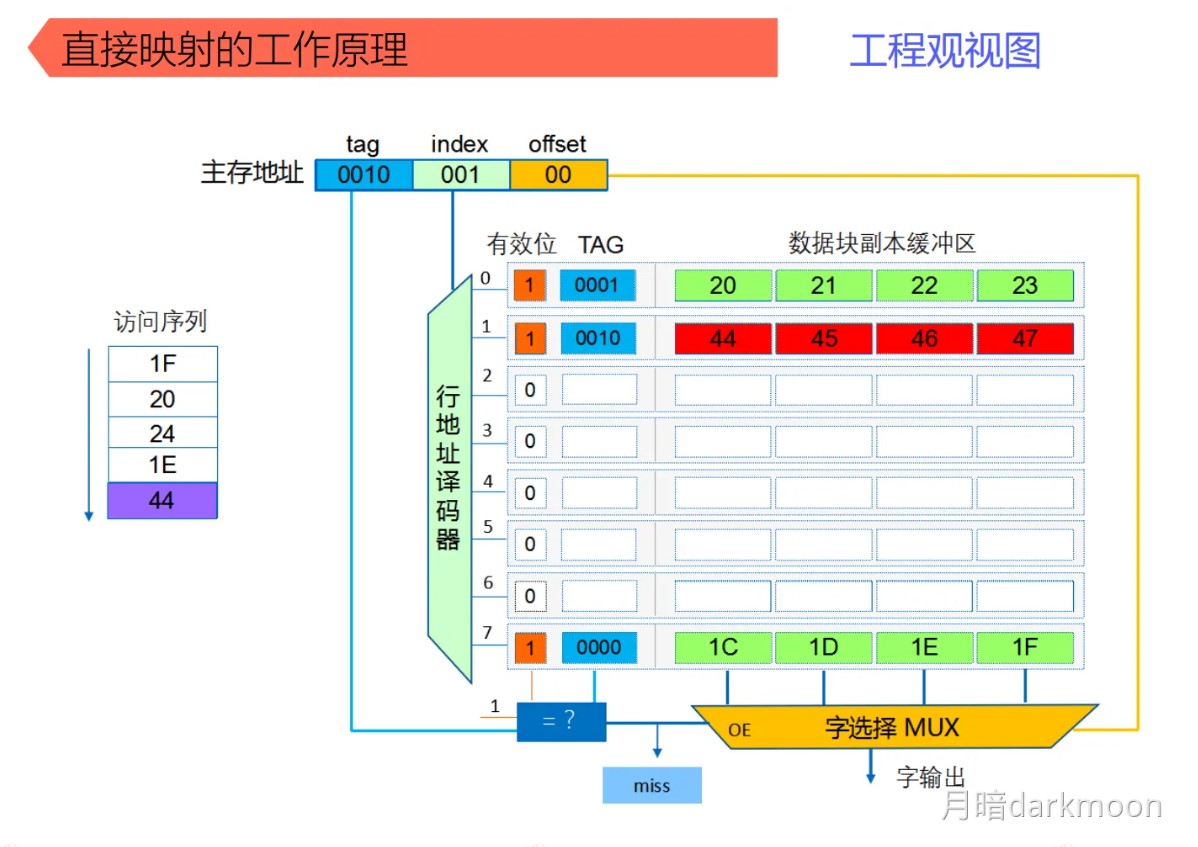

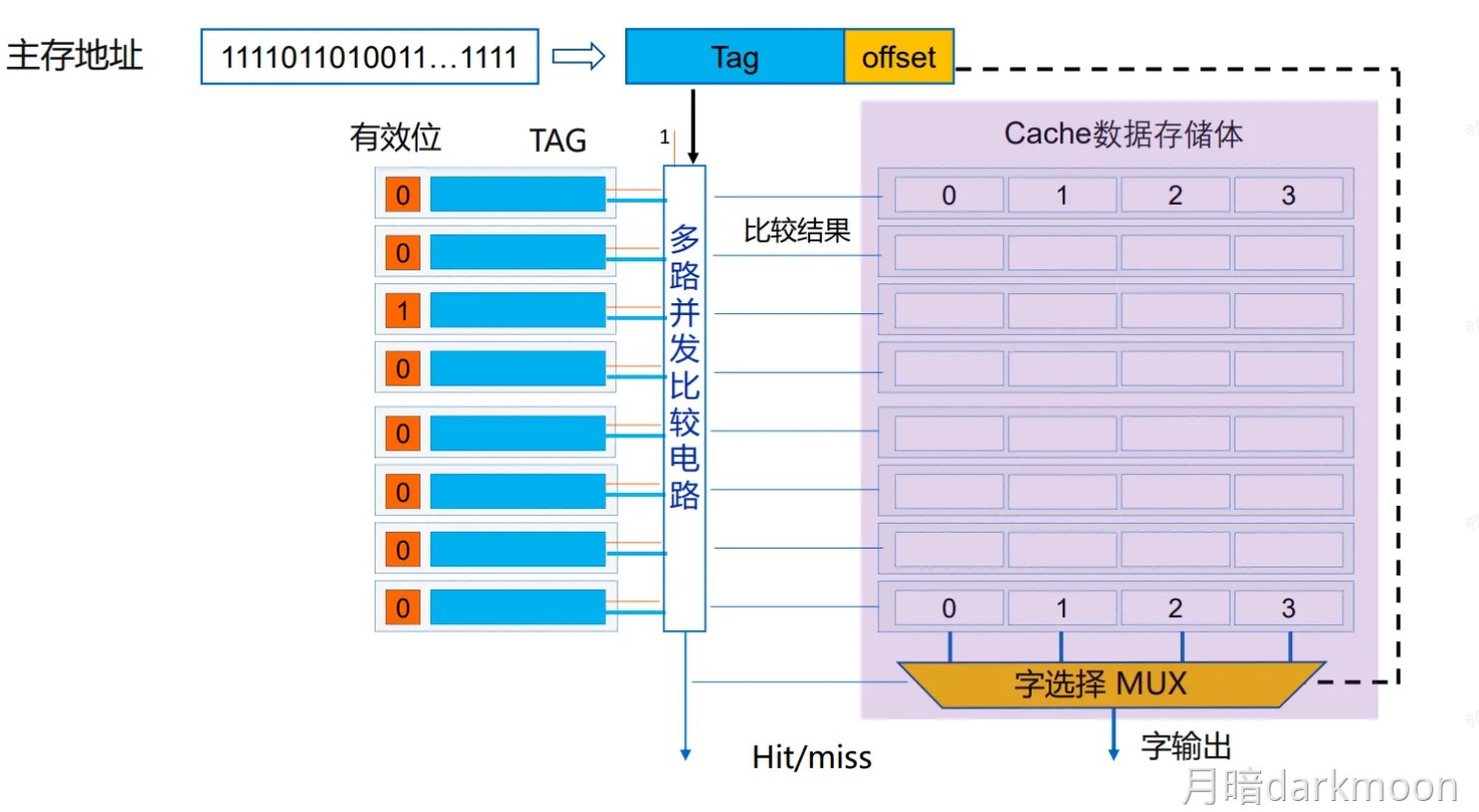

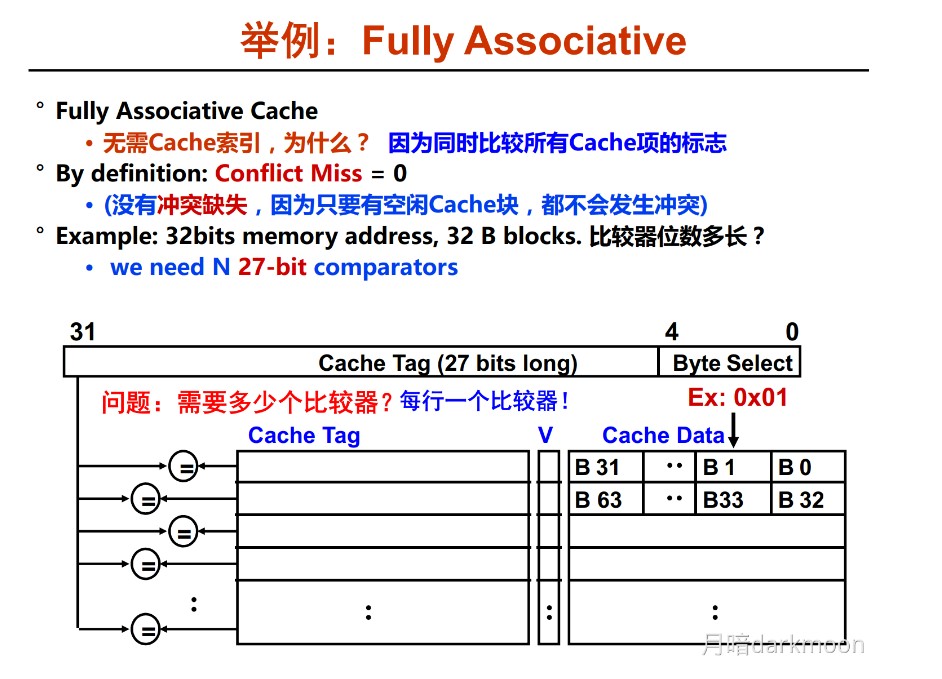

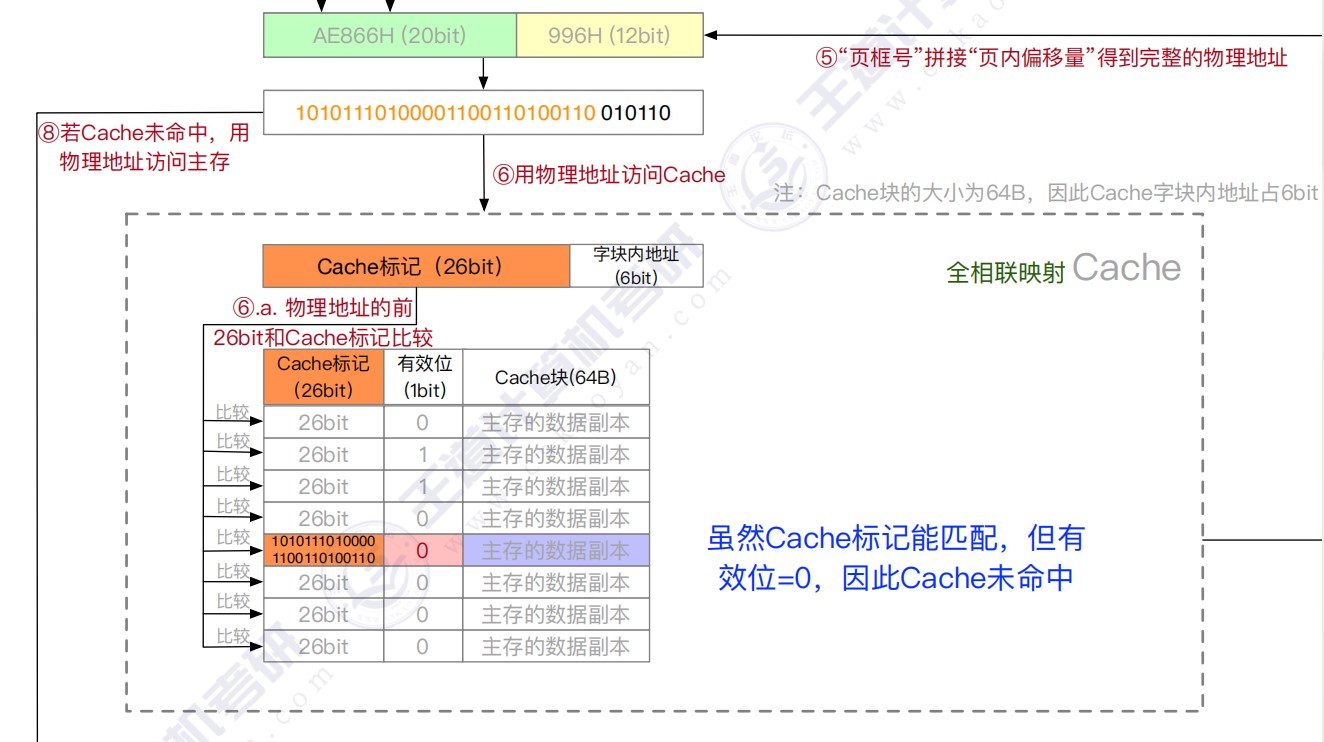

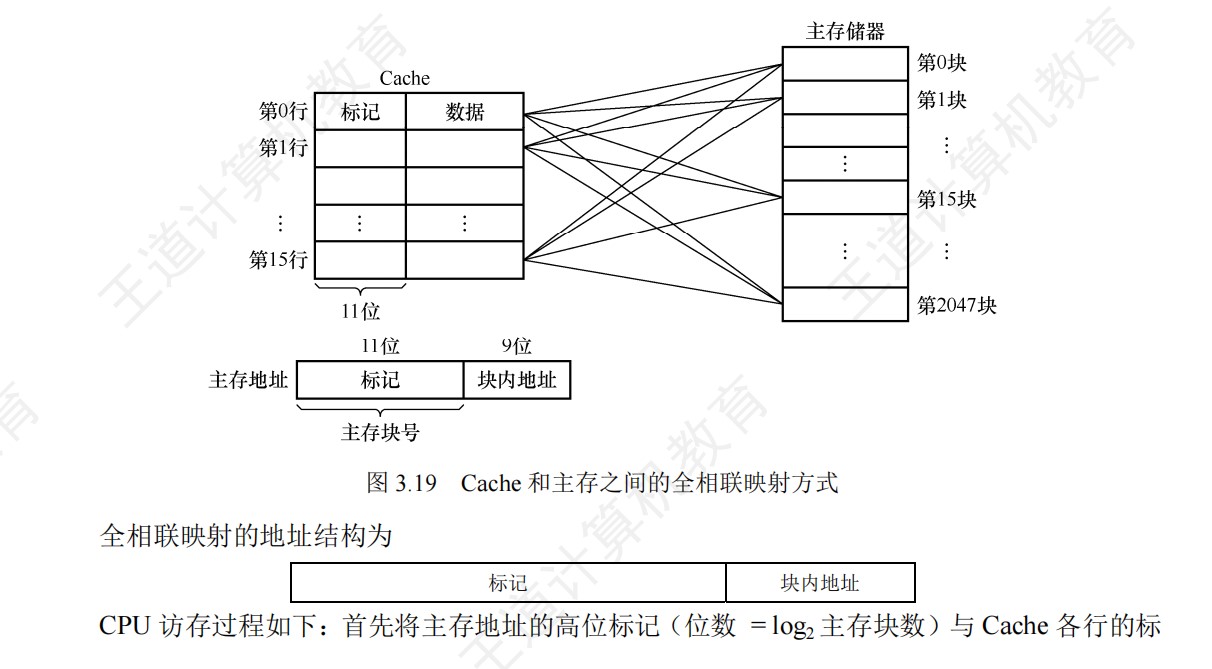

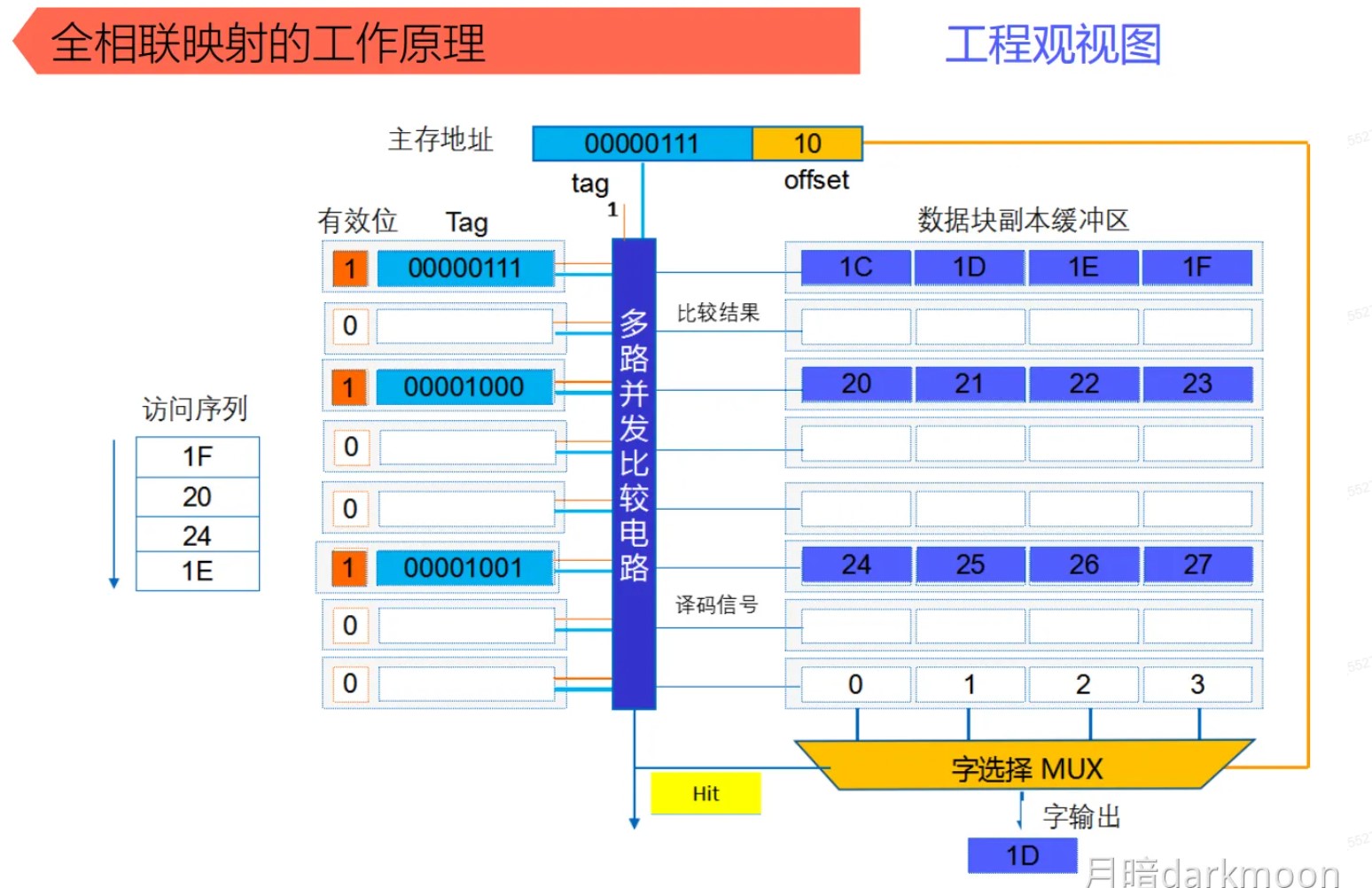

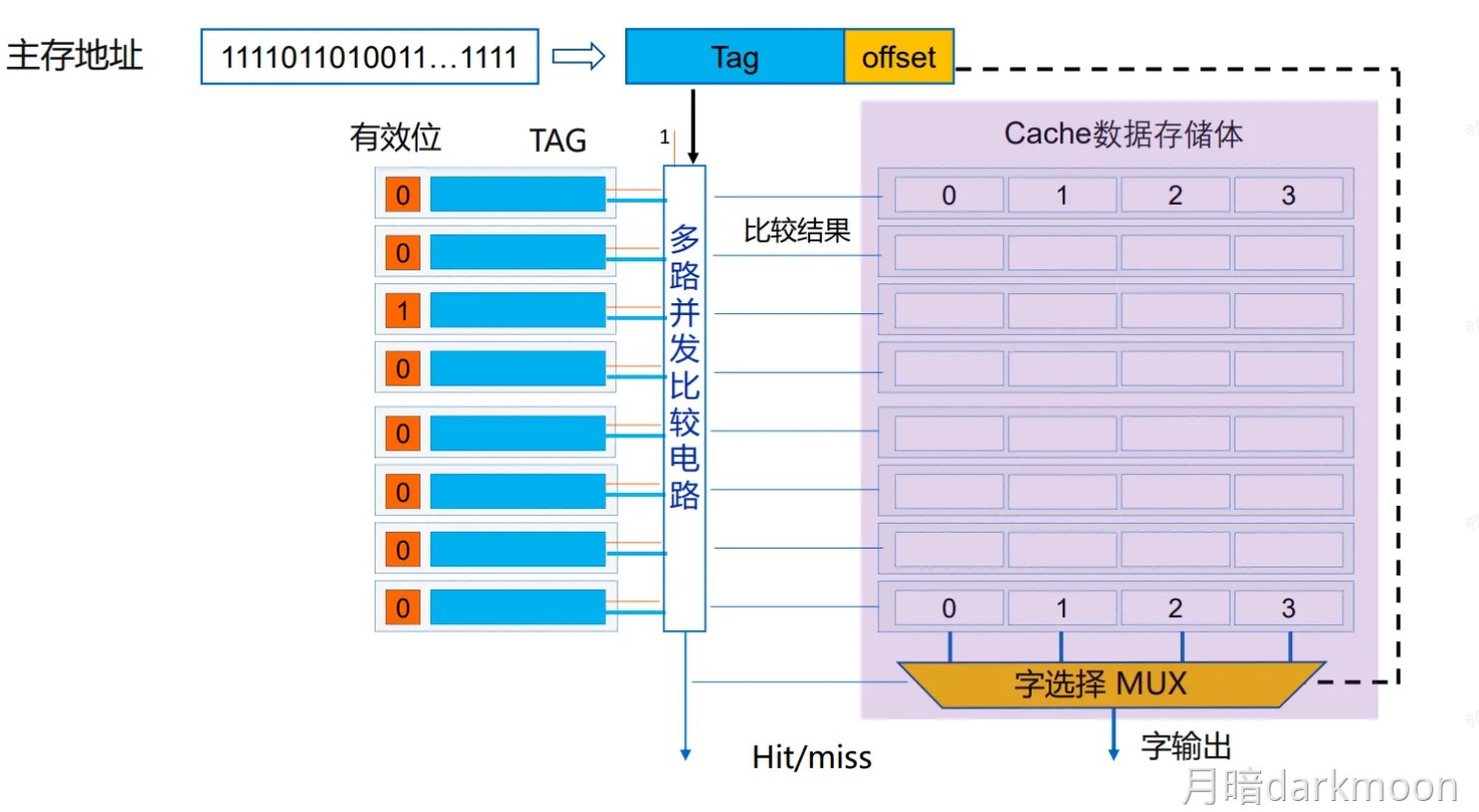

全相联

- 全相联映射,只要有空闲Cache行,就不会发生冲突,可以装入Cache中的任何位置;但是标记的比较速度较慢,通常需要采用按内容寻址的相联存储器

- 每个Cache行都设置一个比较器,比较器位数=标记字段的位数,其查找过程是一种按内容访问,是一种相联存储器,时间开销和硬件开销都很大,不适合大容量Cache

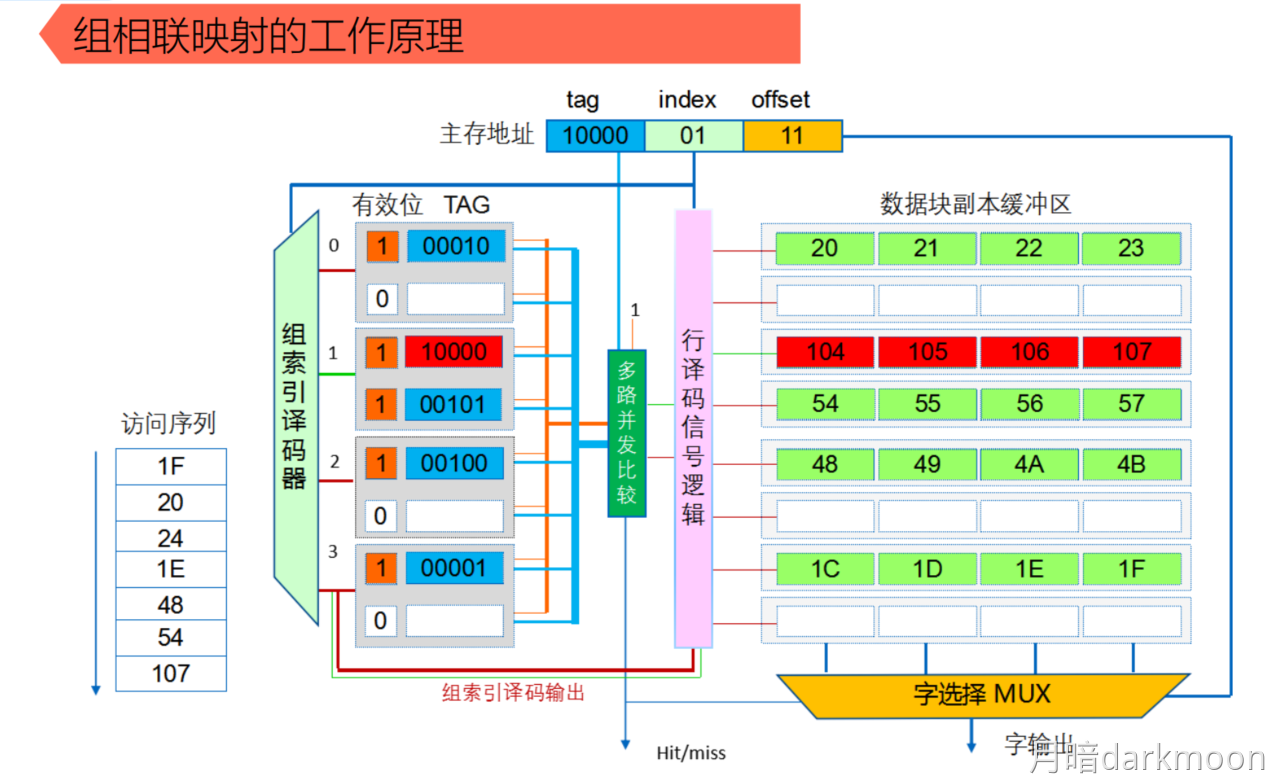

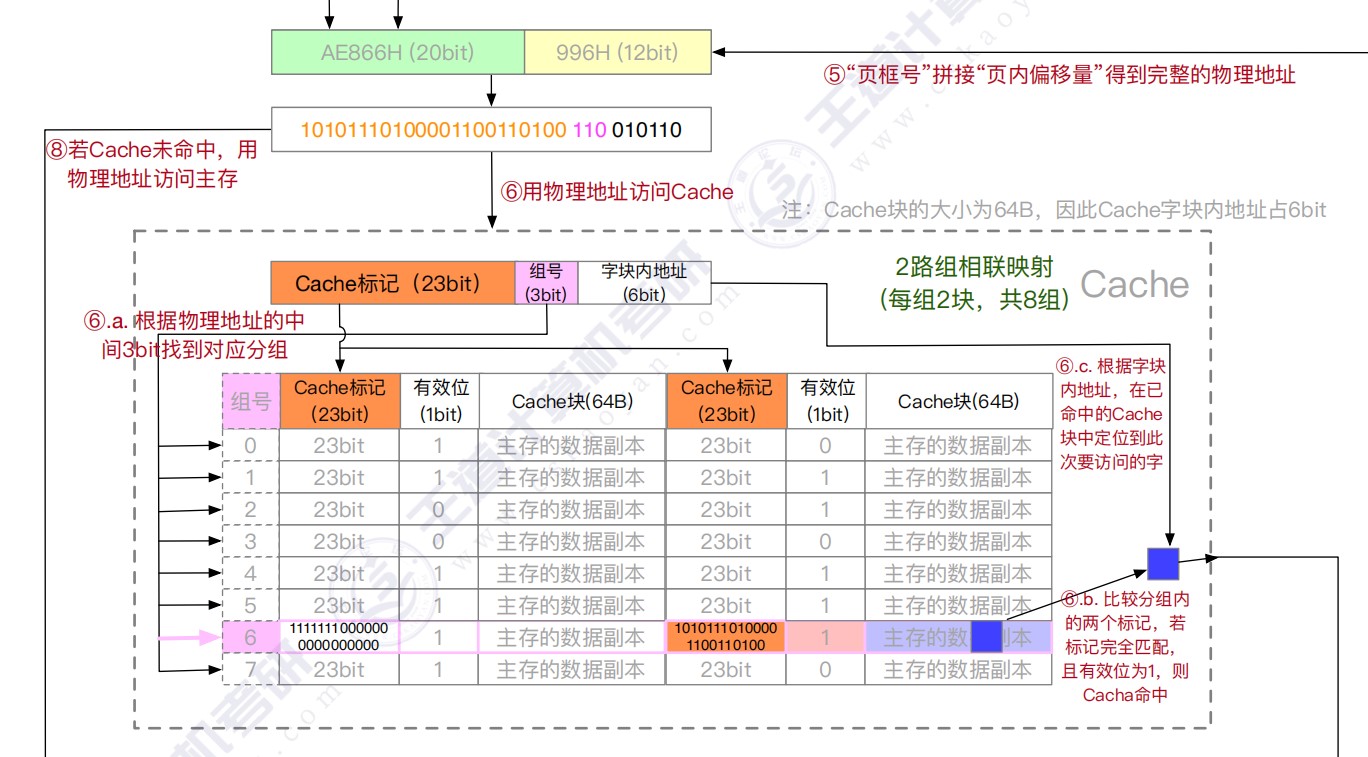

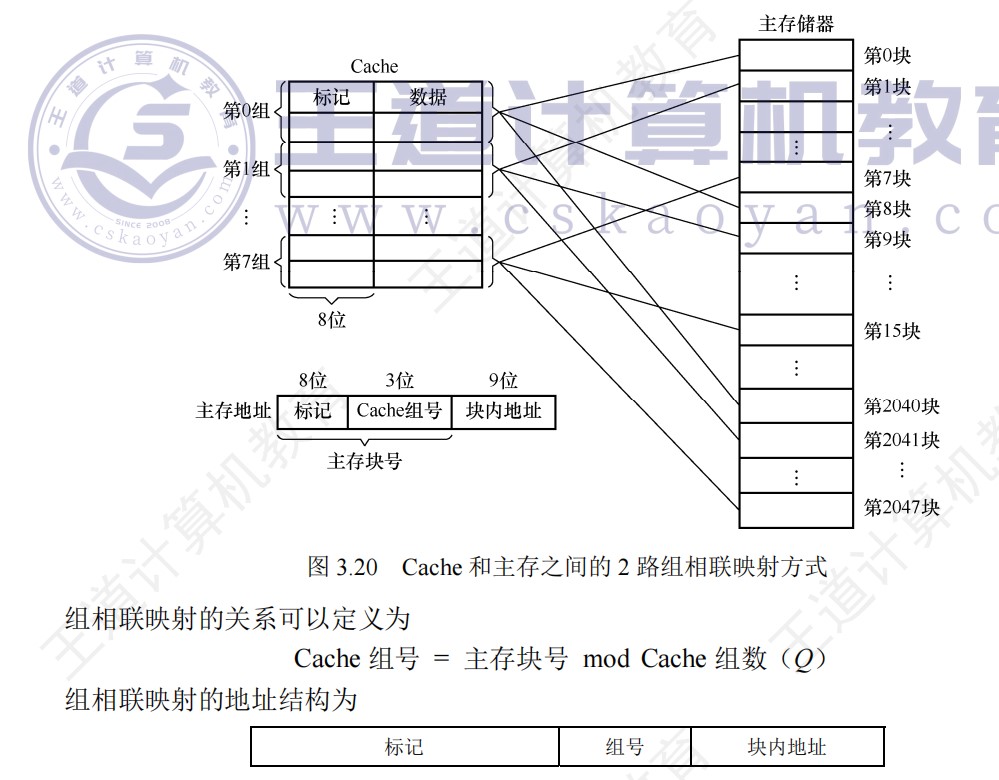

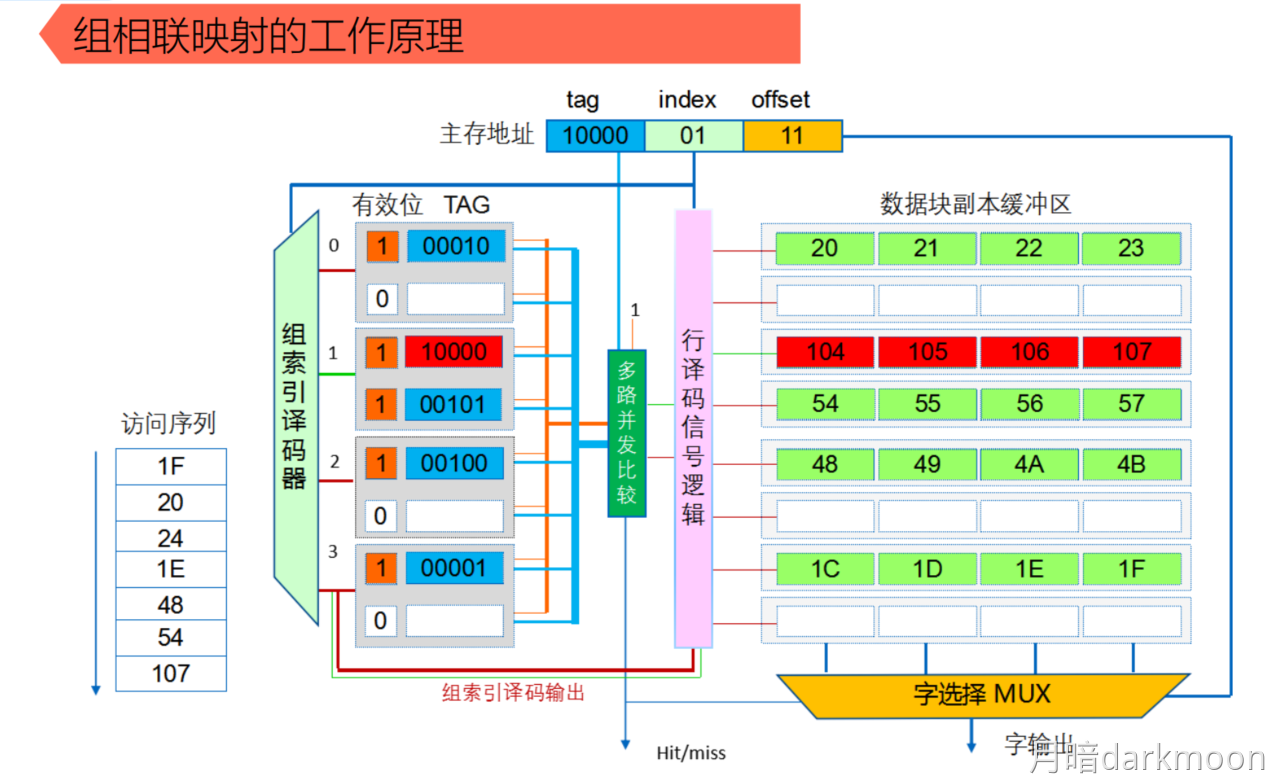

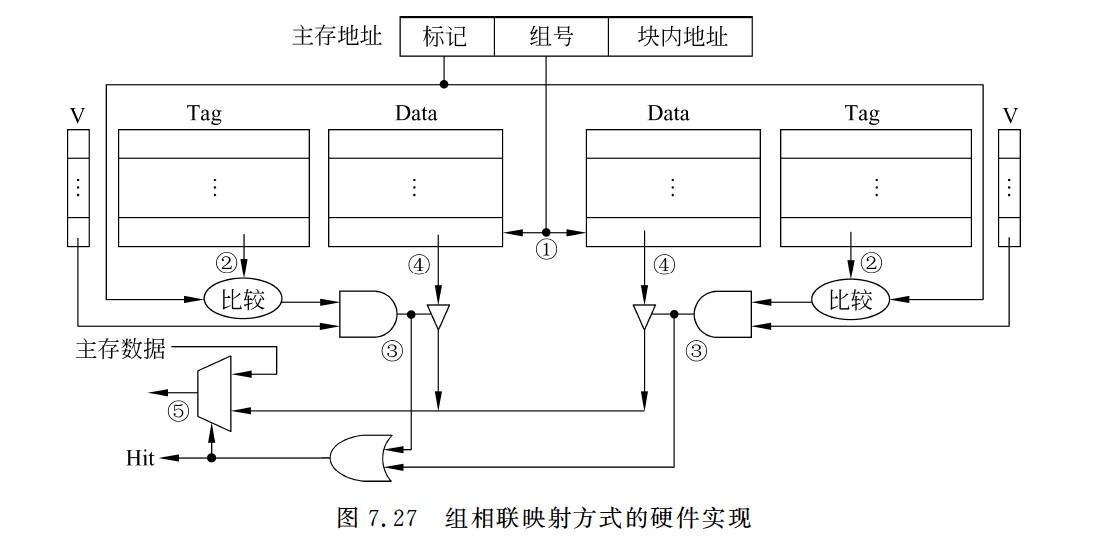

组相联

- Cache组号=主存块号 % Cache组数

- 直接映射只需要1个比较器,r路组相联映射需要在对应分组中与r个Cache行进行比较,因此需要设置r个比较器

- 组间直接映射,组内全映射

LRU和LFU的区别

- LRU替换的依据是时间维度,LFU替换的依据是频率

- LRU有三条计数规则

- LFU只有一条计数规则,即每行设置一个计数器,新装入的从0开始计数,被访问则+1,替换时将最小的换出,计数值只依赖于自己的访问次数

- LFU的计数器的值可能是0到很大的数,需要用比较长的二进制比特位标识

一致性问题

- 为了减少全写法直接写入主存的时间损耗,在Cache和主存之间加一个写缓冲,CPU同时写数据到Cache和写缓冲中,写缓冲再将内容弄个写入主存,写缓冲是一个FIFO队列,可以解决速度不匹配的问题,但是若出现频繁写,会使写缓冲饱和溢出

- 各级Cache间一般用全写法+非写分配法;Cache和主存之间一般用写回法+写分配法

- 全写法+非写分配法适合写操作频繁且对数据一致性要求较高的场景

- 回写法+写分配法适合写操作较少或者写操作集中在特定数据上的场景,可以有效减少对主存的写操作次数,提升缓存利用率

访存相关

- Cache与主存之间交换的是主存块,主存与外存之间交换的是页。

- Cache-主存层次和主存-外存层次的区别在于前者主要解决速度不匹配问题,用软件实现会影响速度,因此Cache-主存层次替换算法由硬件实现;而主存-外存层次替换算法由软件实现。

- Cache-主存层次可采用回写法或全写法;主存-外存层次通常采用回写法,即页面被修改后,仅当被换出时才写回外存,访问外存的代价很大,采用全写法的开销过高。

- 访问外存的代价很大,提高命中率是关键,因此主存-外存层次通常采用全相联映射;而Cache-主存层次可采用直接映射、组相联或全相联。

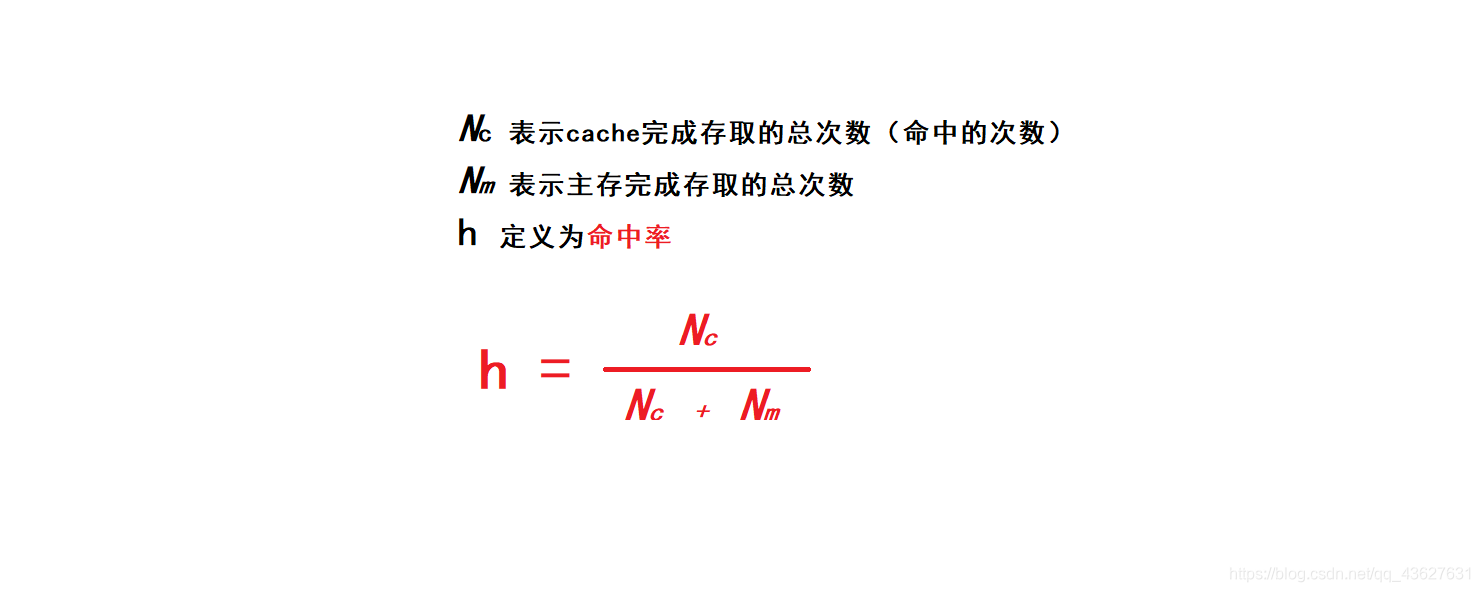

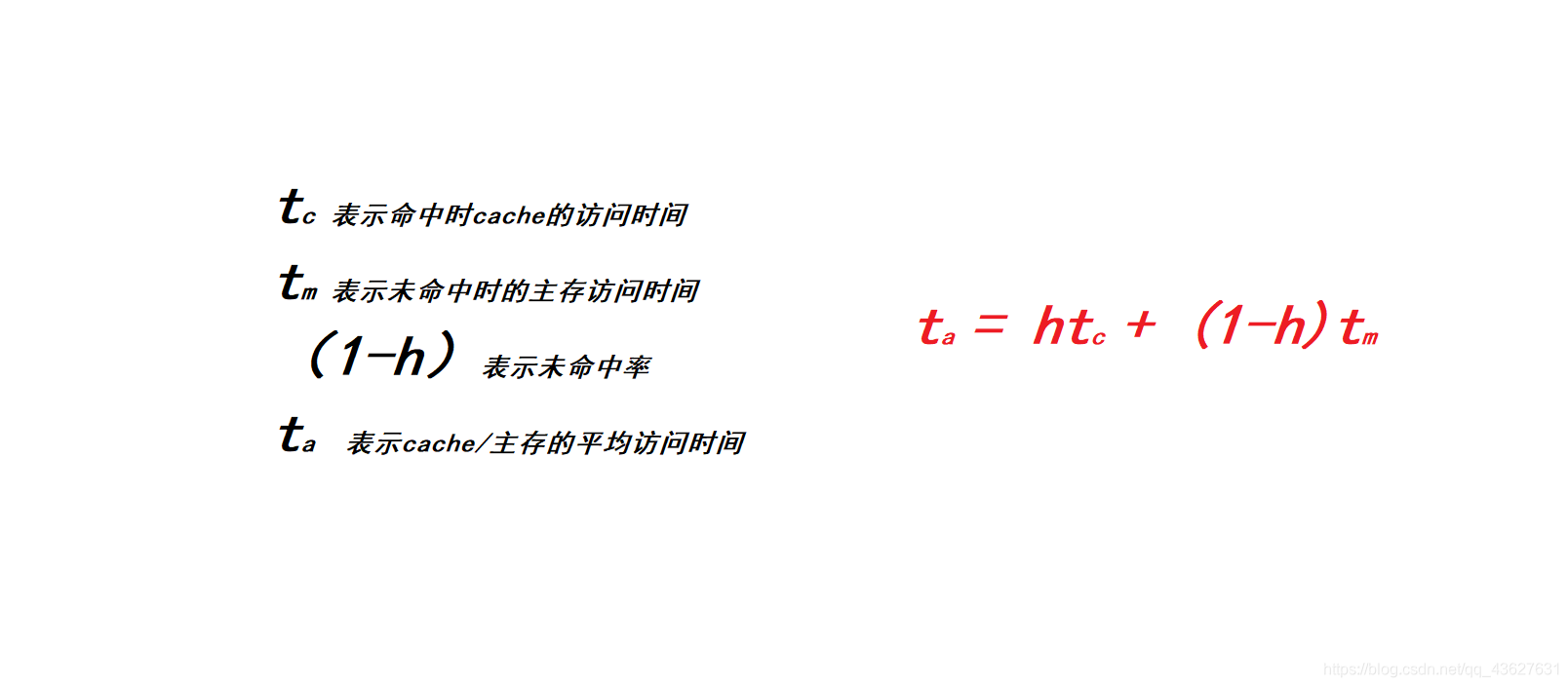

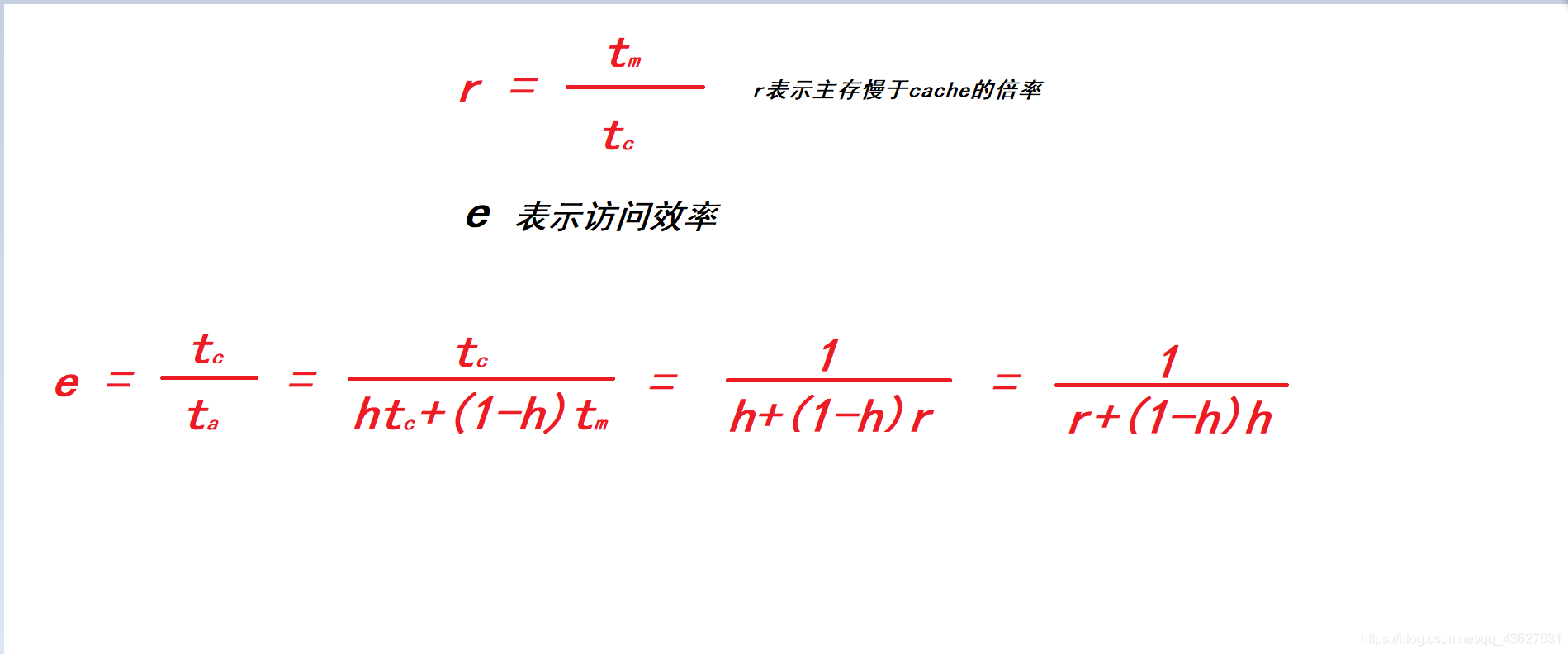

Cache的命中率、平均访问时间、访问效率

- Cache命中率

- Cache平均访问时间

- Cache访问效率

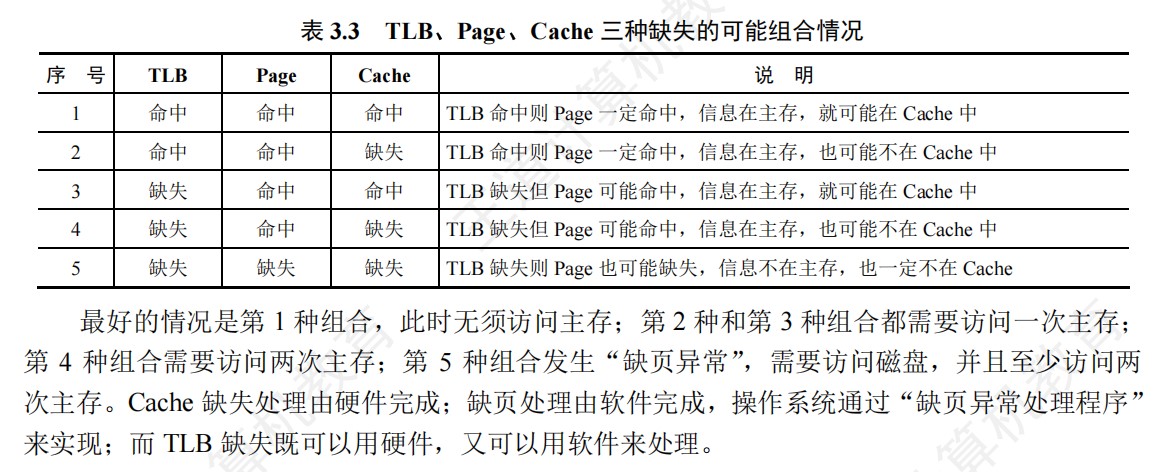

TLB和Cache和页表的内容

TLB

- 全相联TLB

- 组相联TLB

Cache

- 直接映射

- 全相联

- 组相联

页表

- 一级页表

- 二级页表

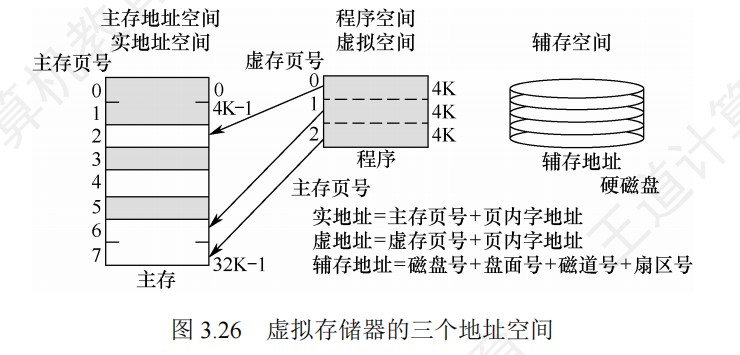

虚拟存储器

-

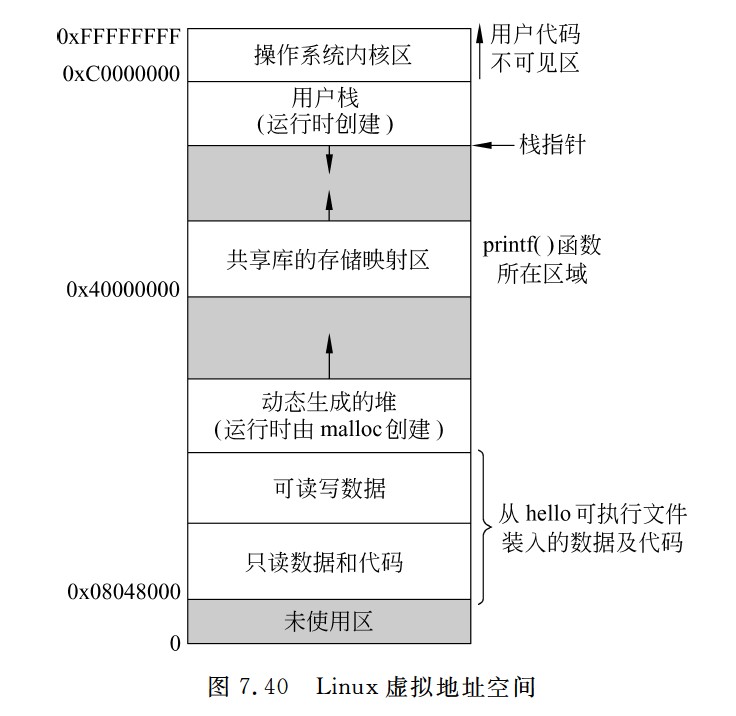

虚拟存储器中,指令本身地址,操作数地址都是虚拟地址,需要转化为物理地址

-

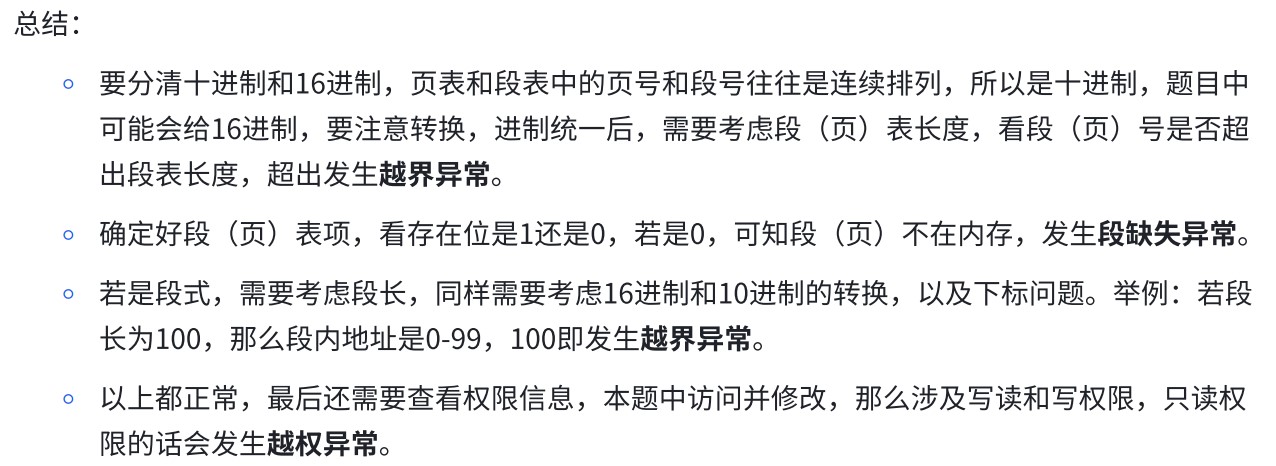

段式的比较先后:

- 越界与否→缺失与否→越权与否

-

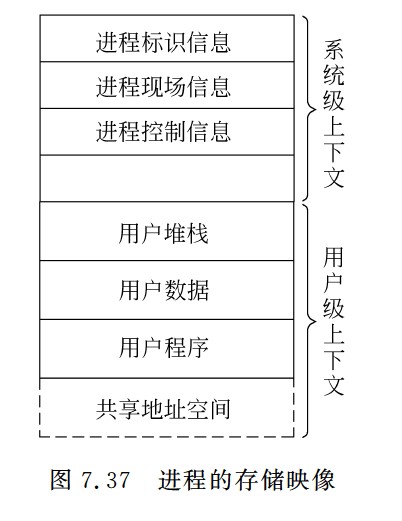

逻辑地址空间的大小受限于CPU的寻址能力(如32位CPU理论上可以寻址4GB,64位CPU则大得多),而这些逻辑地址空间中的内容,一部分在物理内存中,大部分则存放在外存(通常是磁盘的交换区或对换区)上。因此,虚拟存储的总容量可以理解为物理内存和可用外存空间之和,但实际上限更多地由CPU寻址范围和外存大小决定

- 虚拟存储器的大小就是虚拟地址空间的大小,由虚拟地址的位数决定,与系统中的磁盘容量和内存容量没有直接关系

-

对于应用程序员而言,虚拟存储器是透明的

-

虚拟存储器将主存或辅存的地址空间统一编址,形成一个庞大的地址空间,在这个空间内,用户可以自由编程,而不必在乎实际的主存容量和程序在主存中实际的存放位置

-

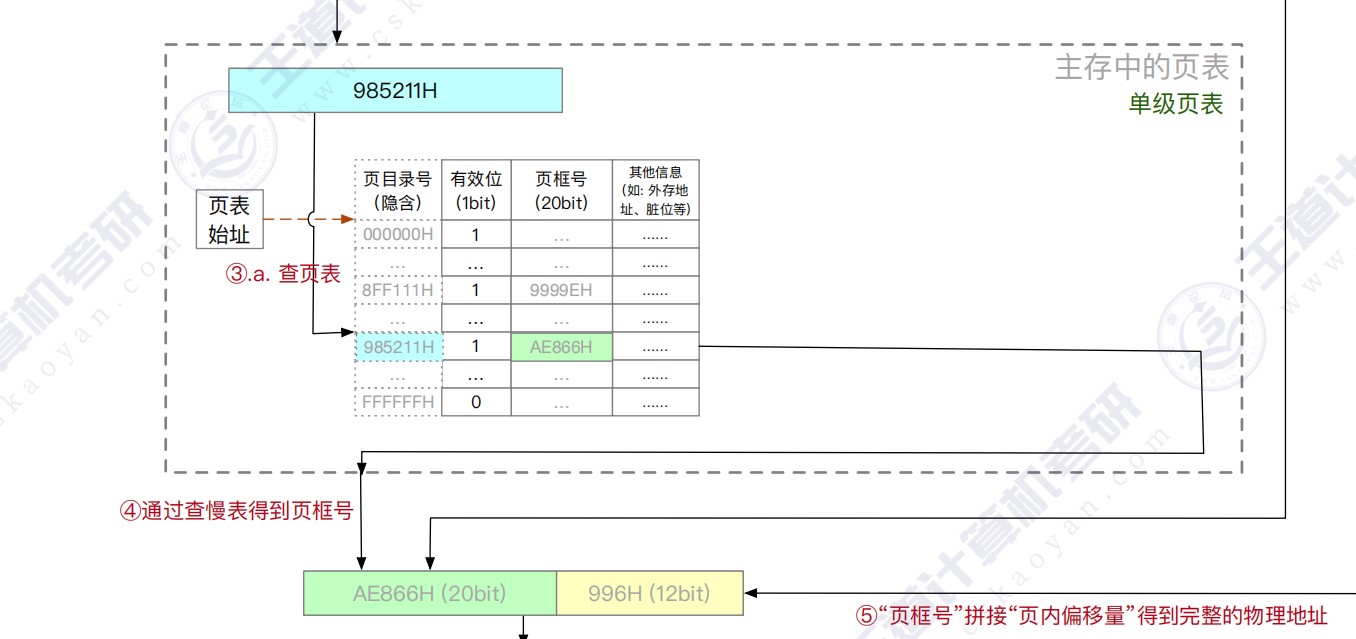

虚拟存储机制采用全相联映射,每个虚页面可以存放到对应主存区域的任何一个空闲页位置。此外,进行写操作时,不能每次写操作都同时写回磁盘,因此,在处理一致性问题上,采用回写法

-

有效位为1,虚拟页已从外存调入主存,此时页表项存放该页的物理页号;若为0,则表示没有调入主存,此时页表项可以存放该页的物理地址

-

引用位也称使用位,用来配合替换算法进行设置,例如是否实现最先调入(FIFO位)或最近最少用(FRU位)策略等

-

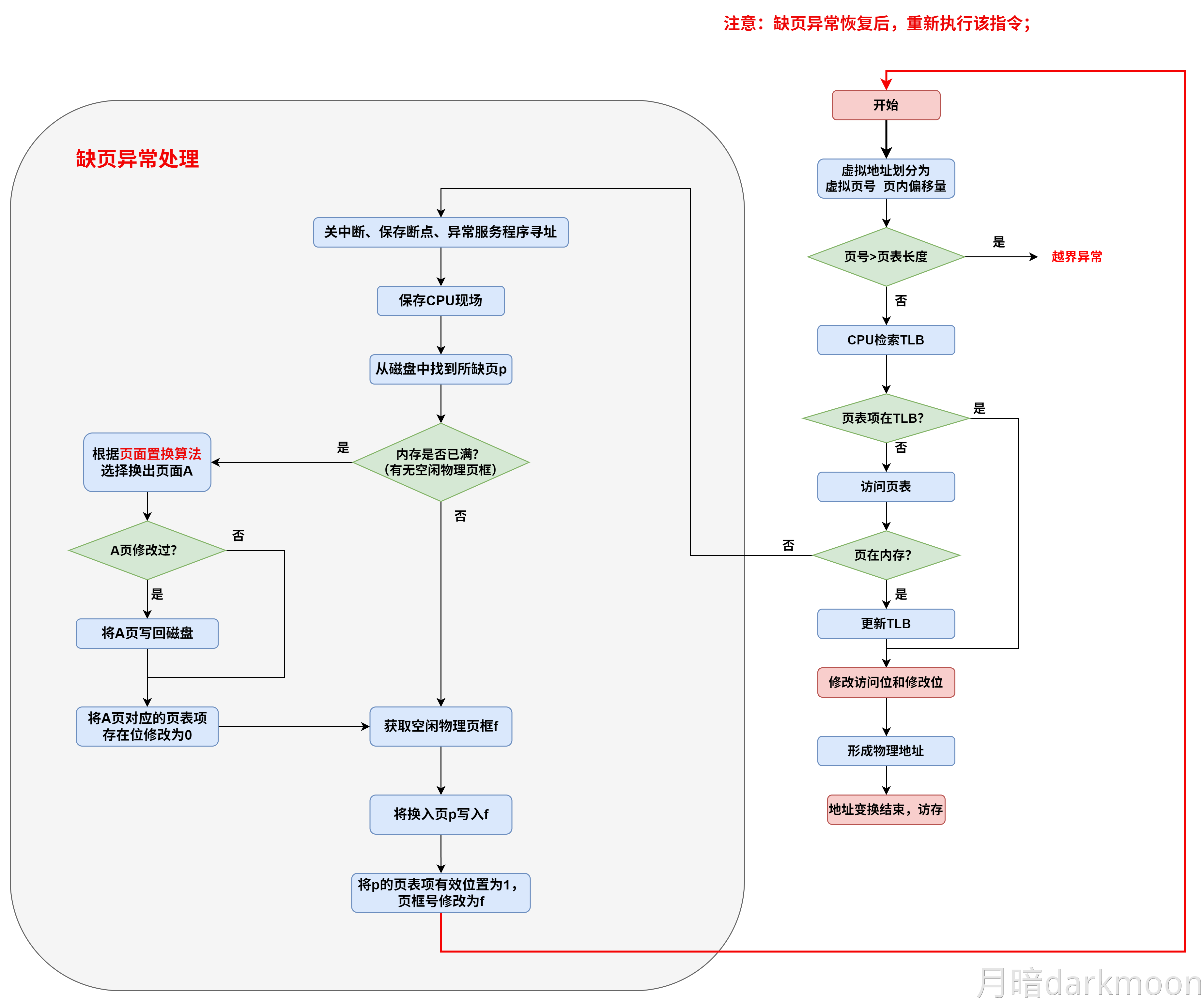

页式存储中,每个进程都有一个页表基址寄存器,存放该进程的页表首地址(物理地址),据此找到对应的页表首地址,然后根据虚拟地址高位的虚拟页号找到对应的页表项,若装入位为1,则取出物理页号,和虚拟地址低位的页内地址拼接,形成实际物理地址。若装入位为0,说明缺页,需要操作系统进行缺页处理

-

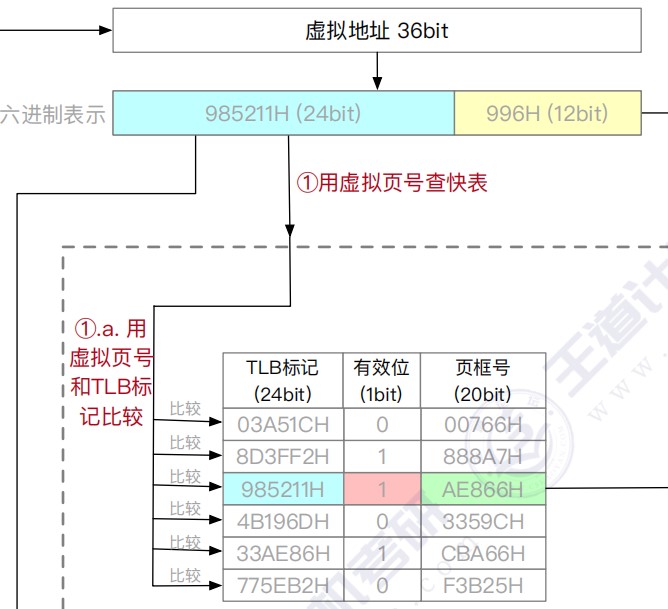

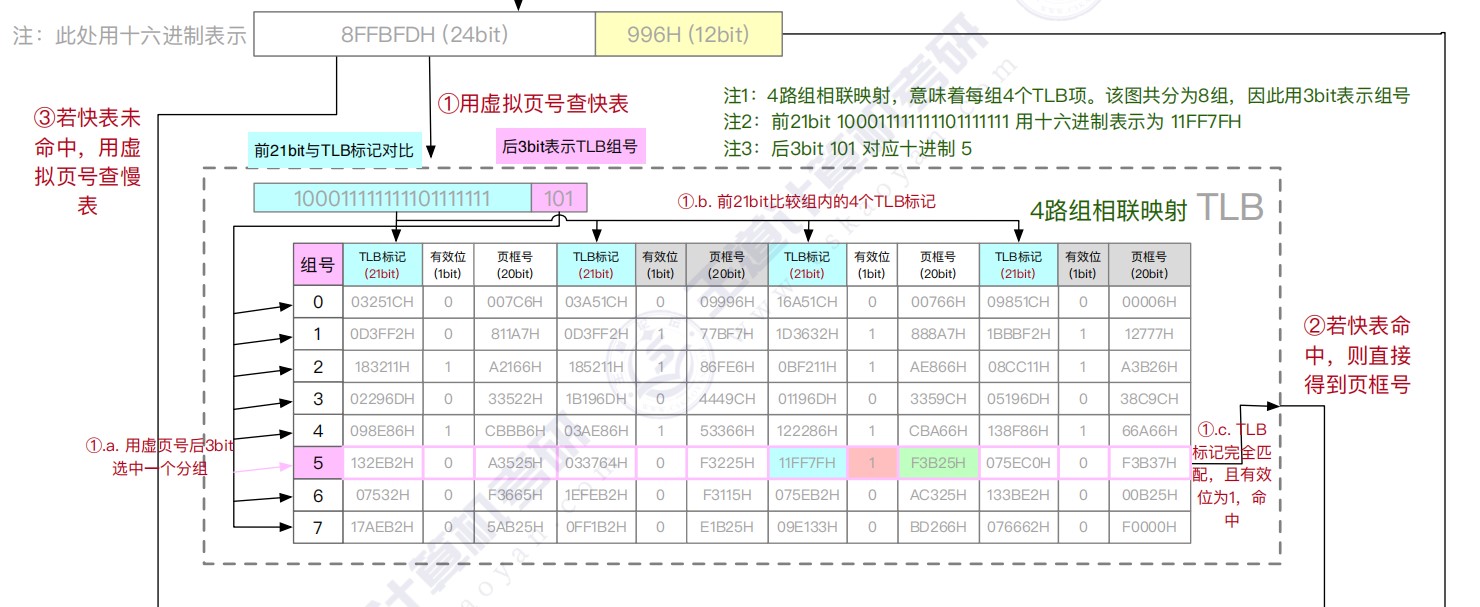

快表用SRAM实现(TLB = CAM(存标签/虚拟页号) + SRAM(存数据/物理页框号)),通常采用全相联或者组相联映射,TLB表项由页表表项内容和TLB标记组成,全相联映射下,TLB标记就是对应页表项的虚拟页号;组相联下,TLB标记则是对应虚拟页号的高位部分,而虚拟页号低位部分作为TLB组的组号

-

段式存储中,首先根据段表基地址与段号拼接成对应的段表项,然后根据该段表项的装入位判断该段是否已调入主存,已调入主存时,从段表读出该段在主存中的起始地址,与段内地址(偏移量)相加,得到对应的主存实地址。

- 段时逻辑结构上相对独立的程序块,因此段是可变长的

- 按程序中实际的段来分配主存,所以分配后的存储块是可变长的

-

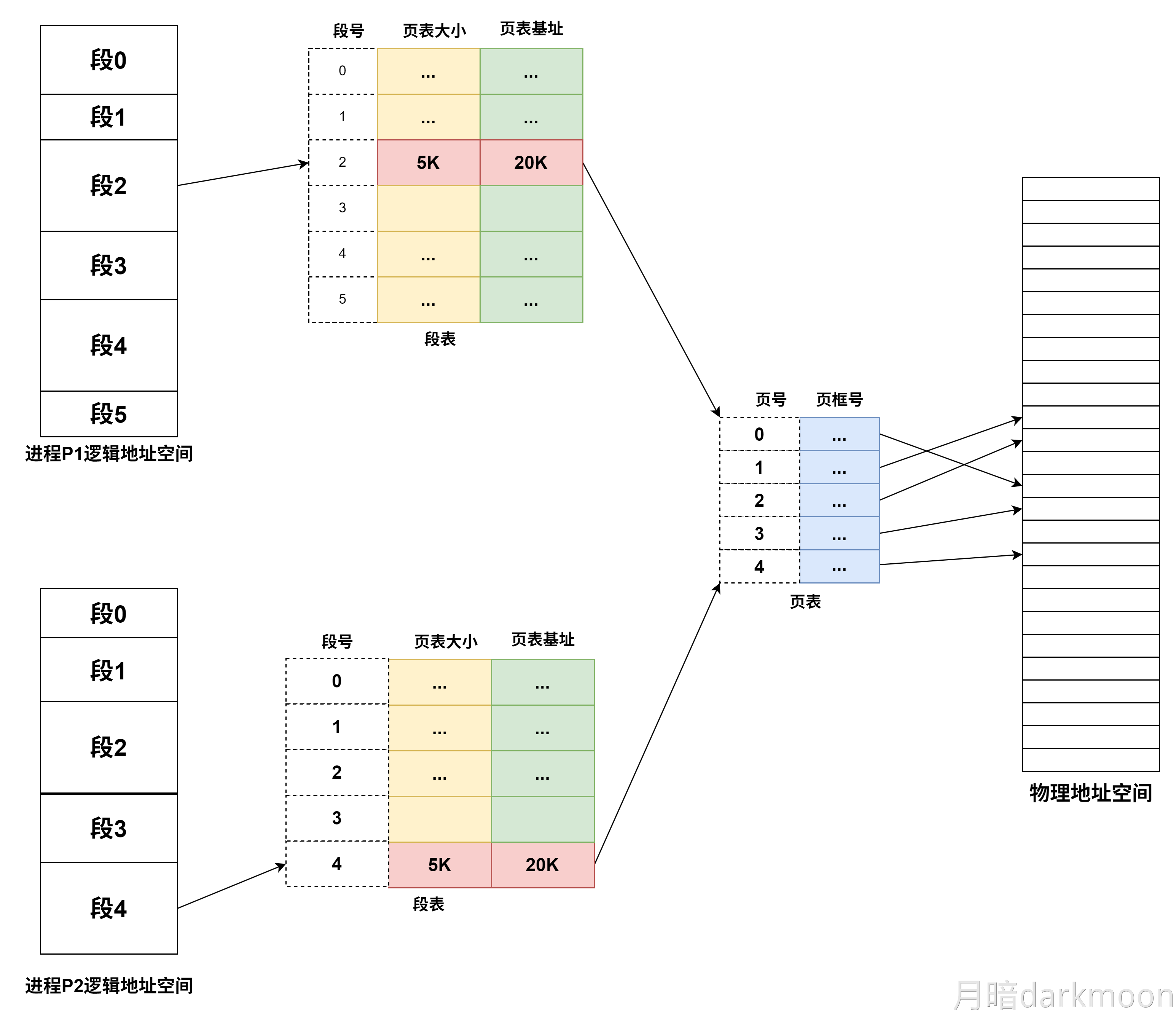

段页式存储中,程序对主存的调入、调出仍然以页为基本交换单位。

- 每个程序对应一个段表,每段对应一个页表;段的长度必须是页长的整数倍,段的起点必须是某一页的起点

- 虚地址分为段号,段内页号、页内地址三部分。

- CPU根据虚地址访存时,首先根据段号得到段表地址;然后从段表中取出该段的页表起始地址,与虚拟地址段内页号核程,得到页表地址;最后从页表中取出实页号,与页内地址拼接形成主存实地址

- 段页式在地址变换过程中需要两次查表,系统开销较大

-

最大容量:地址结构确定;实际容量:min(内存+外存,CPU寻址)

-

堆内存的分配和释放由程序员控制,通常不遵循严格的先进后出或后进先出原则,而是根据程序的需要进行。

-

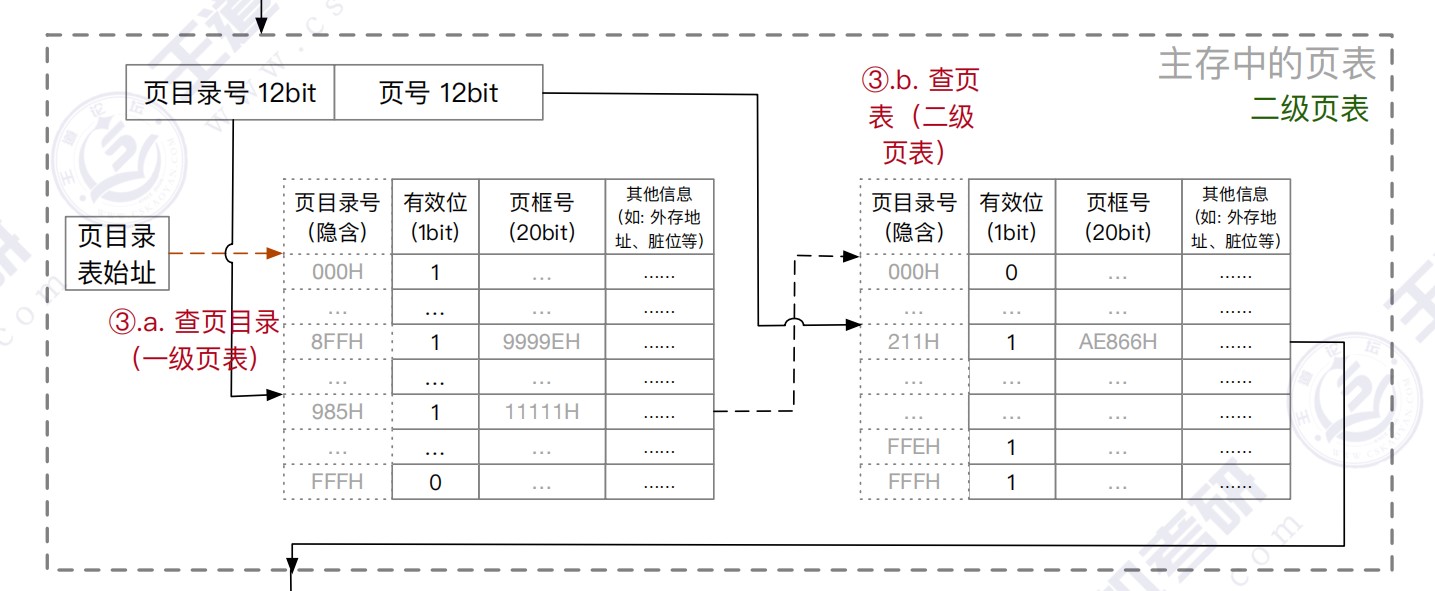

多级页表

- (二级)页表的每个页表项中,存放的是进程的某页对应的物理块号

- 如0号页存放在1号物理块中

- 在外层(一级)页表的每个页表项中,存放的是某个页表分页的始址

- 如0号页表存放在3号物理块中

- 总结:一级页表的一个页表项对应一个页表,二级页表的一个页表项对应一个页框。目录索引指向某个页表,页表索引指向对应页表的某个页表项

- (二级)页表的每个页表项中,存放的是进程的某页对应的物理块号

Cache和虚拟存储器对比

- Cache主要解决系统速度,而虚拟存储器却是为了解决主存容量

- Cache全由硬件实现,是硬件存储器,对所有程序员透明,而虚拟存储器由OS和硬件共同实现,是逻辑上的存储器,对系统程序员不透明,对应用程序员透明

- 虚拟存储器系统不命中时对系统性能影响更大

- Cache不命中时,主存能和CPU直接通信,同时将数据调入Cache;而虚拟存储器系统不命中时,只能先由硬盘调入主存,而不能直接和CPU通信

不同层级之间交换的单位

| 层级 | 交换单位 |

|---|---|

| CPU-Cache | 字 |

| Cache-主存 | Cache块 |

| 页式虚拟主存-外存 | 页 |

| 文件系统主存-外存 | 磁盘块 |

| DMA和设备 | 位/字节 |

| DMA和主存 | 字 |

指令系统

-

调用指令第一条指令必须显式给出转移的目标地址,否则无法调用子程序

-

一条指令的处理时间为:取指令时间+执行指令时间+中断周期时间(关中断、保存断点、中断服务程序入口地址送PC),中断周期时间不包括中断服务程序的执行时间

-

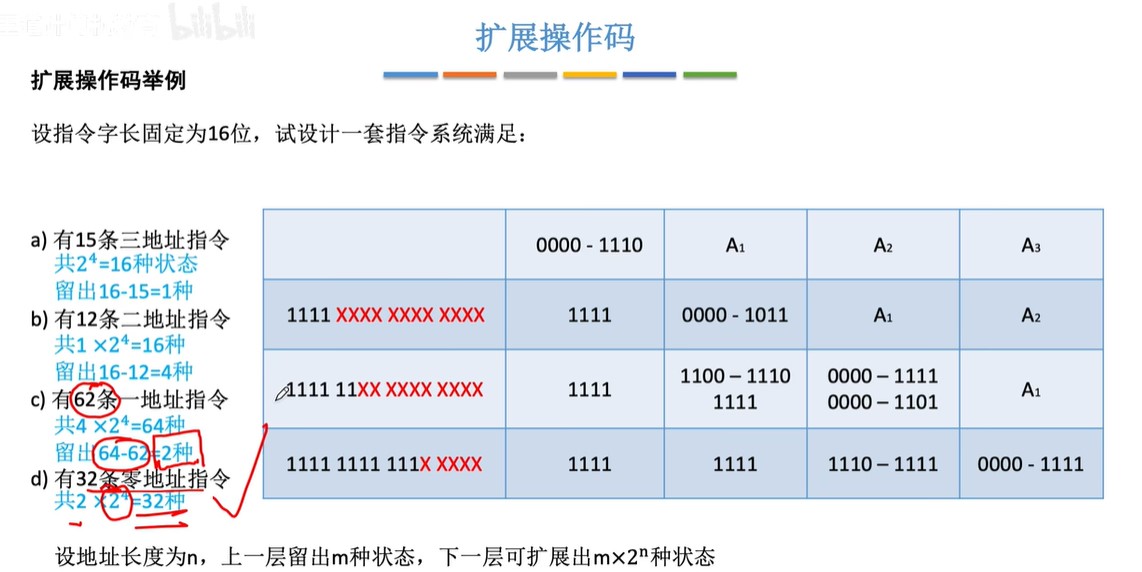

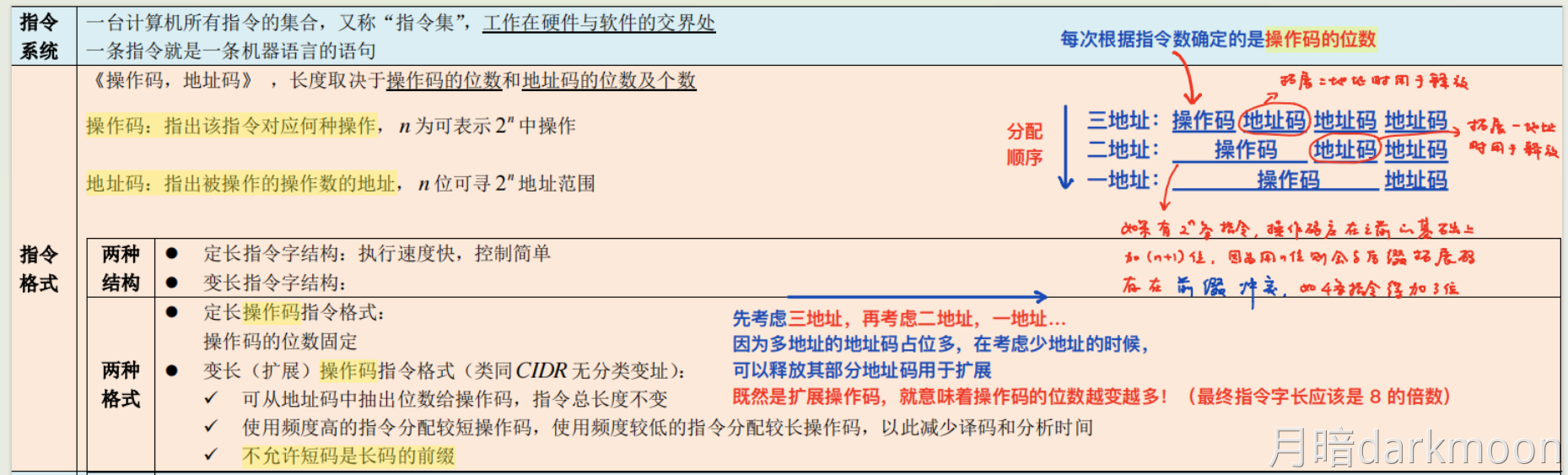

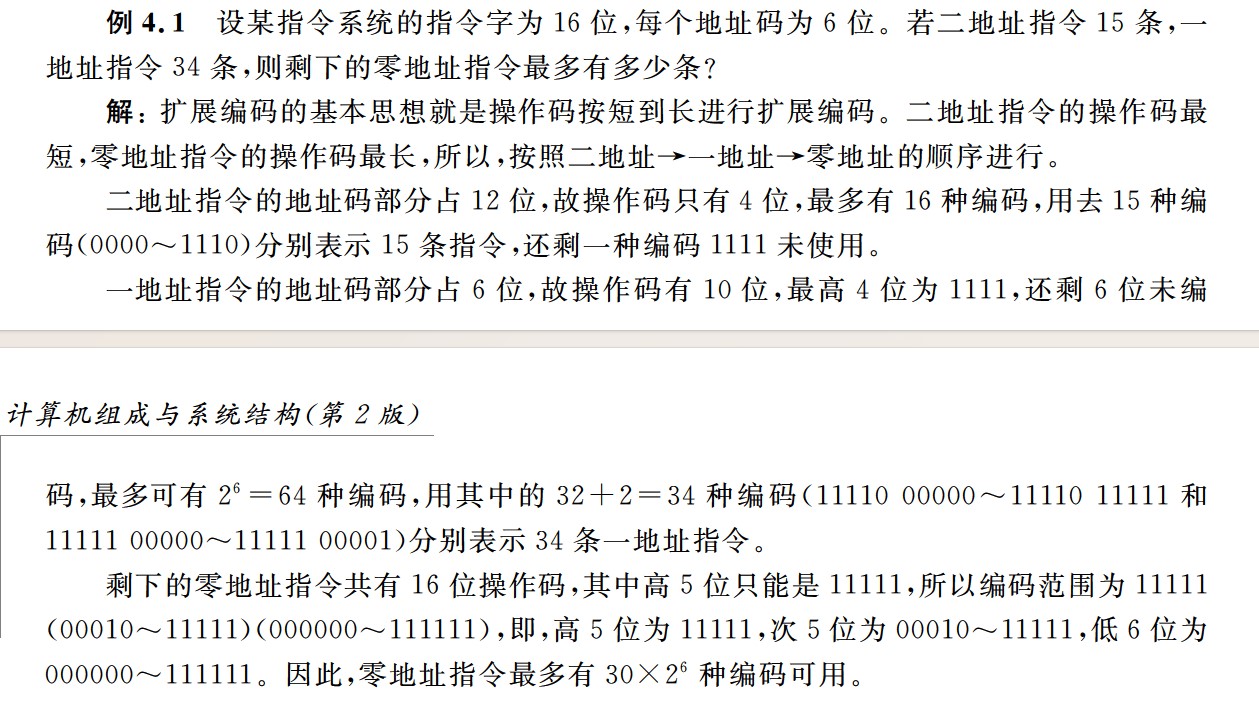

扩展指令码

- 扩展指令码上层是多地址指令,下层是少地址指令,少地址指令

- 前缀不能相同

- 对使用频率较高的指令分配较短的操作码,对使用频率较低的指令分配较长的操作码

- 调用指令和转移指令的区别

- 执行调用指令时必须保存下一条指令的地址(返回地址),当子程序执行结束时,根据返回地址返回到主程序继续执行,而转移指令则不返回执行

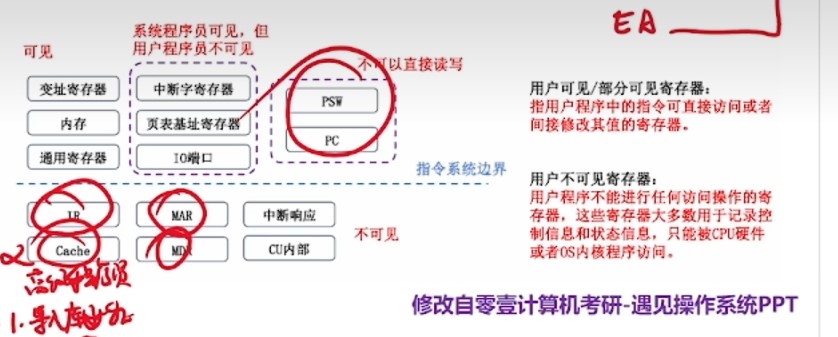

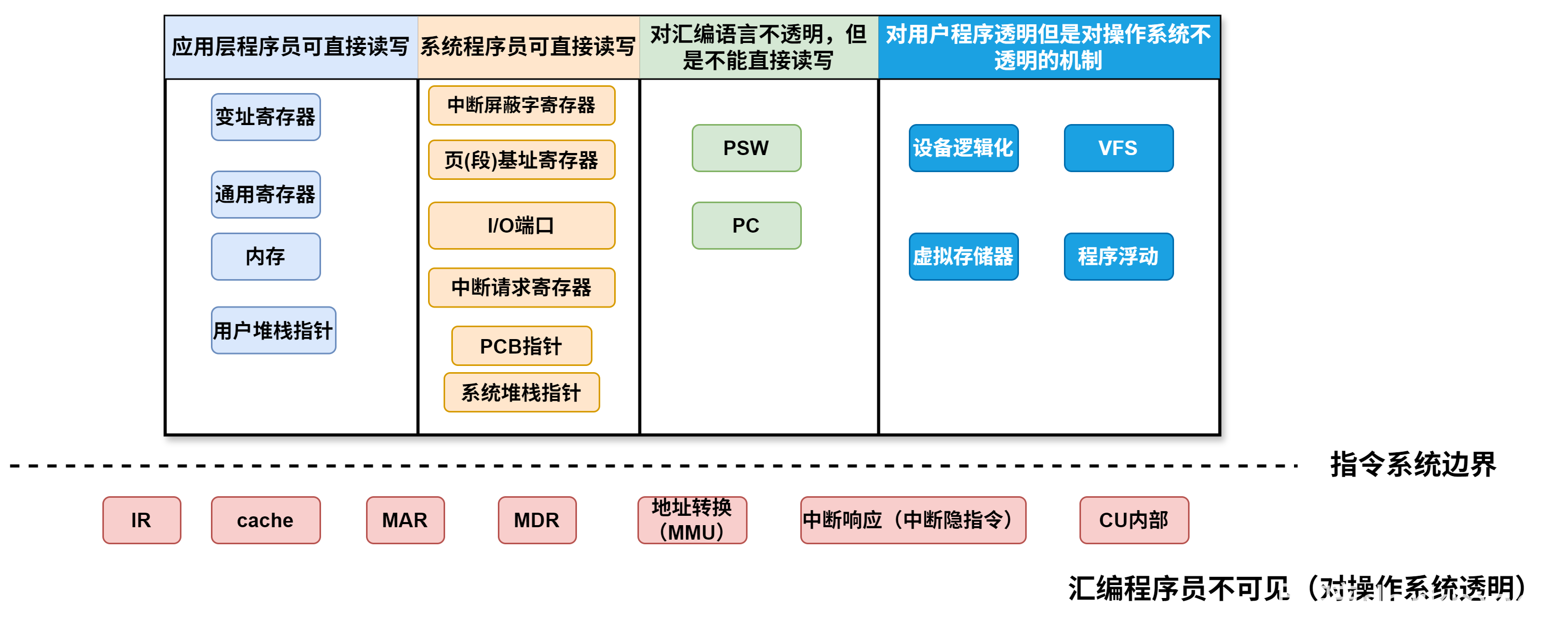

- 通用寄存器、指令指针寄存器(IP)和标志寄存器(PSW),这些都是程序员可见寄存器

- IP(PC)是用户可见的寄存器,汇编程序员可以通过指定待执行指令的地址改变PC的值

- 执行后一定会改变程序的执行顺序的指令

- 无条件跳转指令

- 过程调用指令

- 过程返回指令

- 自陷指令

- 中断返回指令

- 条件跳转指令要根据标志位进行是否跳转的,因此不一定发生跳转

- 定长指令字的每条指令长度固定,可以简单地实现PC的自增功能,不需要专门的PC增量器,变长指令字的每条指令长度不固定,需要一个专门的PC增量其来进行PC自增的计算

- 变长指令字每次可以按照最长的指令长度来读取,然后根据指令中特定位的规定对各个字段进行划分

ISA

- ISA规定的内容

- 异常和中断相关

- 指令

- 操作数

- 寻址方式和地址空间大小

- 寄存器

- 编址方式

- 控存

- 机器工作状态的定义和切换

- 存储保护方式

- 输入/输出结构和数据传送方式

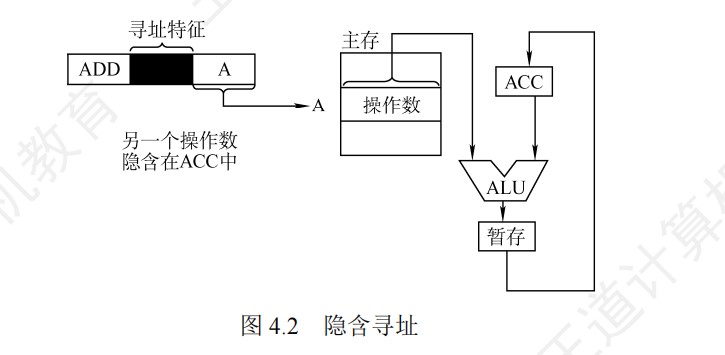

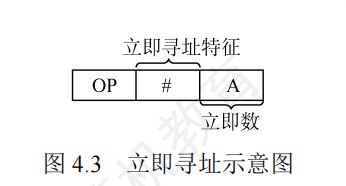

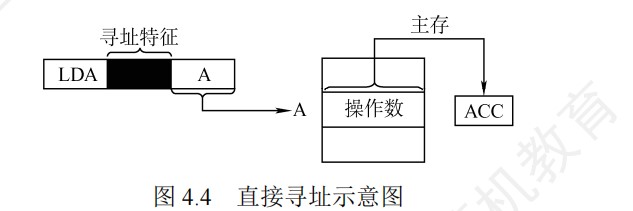

寻址方式

-

遇到基址寻址计算操作数地址的时候,都可以将基址寄存器的内容和形式地址进行符号扩展以后的结果直接相加

-

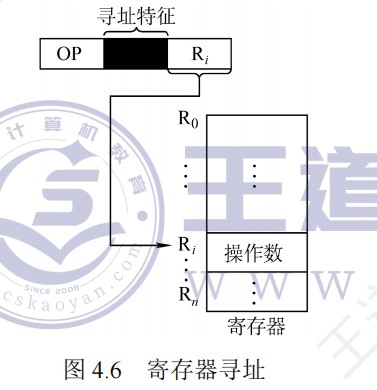

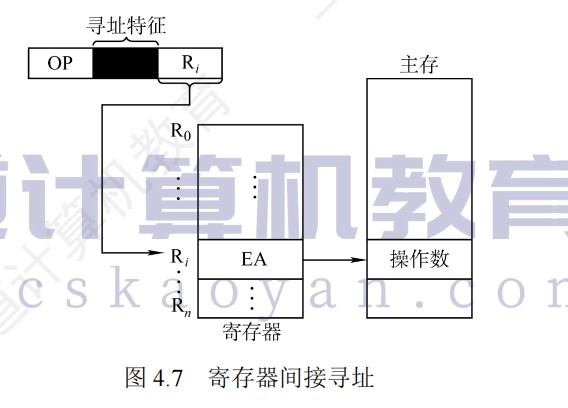

若为寄存器间接寻址,则寄存器的位数决定了可寻址的范围

-

立即数采用补码表示

-

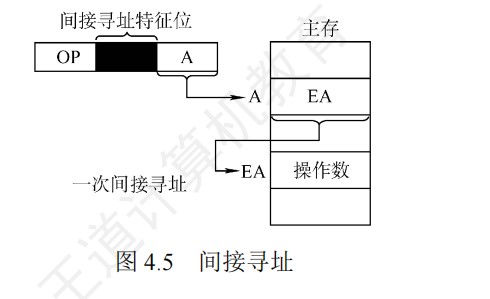

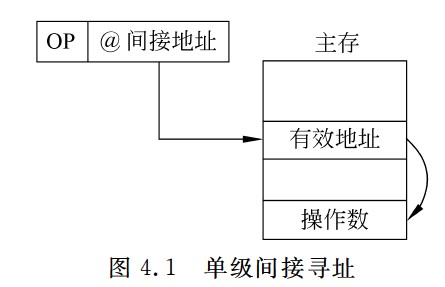

间接寻址可以方便完成子程序返回,但由于执行速度较慢,一般为了扩大寻址范围时,通常采用寄存器间接寻址

-

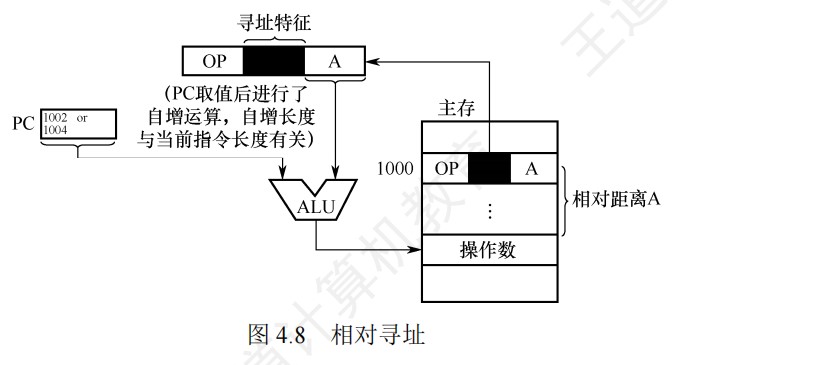

相对寻址中,(PC)+A里的A可正可负,补码表示

- 寻找中断服务程序入口使用相对寻址

-

相对寻址便于程序浮动,广泛应用于转移指令

-

-

基址寄存器是面向操作系统的,其内容由操作系统或管理程序确定,主要用于解决程序逻辑空间与存储器物理空间的无关性。在程序执行过程中,基址寄存器的内容不变(注意,PC的内容是会变的),作为基地址,形式地址可变,作为偏移量。采用通用寄存器作为基址寄存器时,可由用户决定哪个寄存器作为基址寄存器,其内容仍然由操作系统确定。

- 优点:可以扩大寻址范围(基址寄存器的位数大于形式地址A的位数),用户不必考虑自己的程序存于主存的具体位置(pc+a需要考虑a),因此有利于多道程序设计,并可用于编制浮动程序,但偏移量(形式地址A的位数较短)

- 用于程序的动态重定位,为逻辑地址到物理地址变换提供了支持

- 编写程序不必考虑程序位于主存的具体位置

-

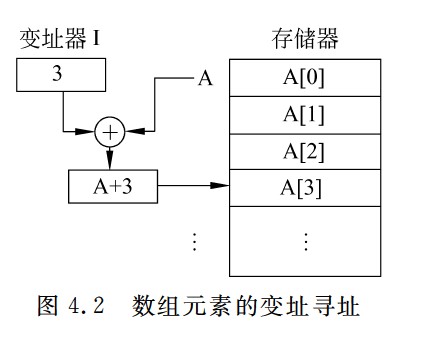

变址寄存器是面向用户的,在执行的过程中,变址寄存器IX的内容(作为偏移量)可由用户改变,形式地址A不变(作为基地址),经典应用是数组和循环程序

-

基址寻址和变址寻址的区别

- 面向对象不同

- 基址寻址面向系统,基址寄存器内容通常由操作系统或管理程序确定,在程序的执行过程中其值不可变,而指令字中的A是可变的

- 变址寻址面向用户,变址寄存器的内容由用户设定,在程序执行过程中其值可变,而指令字中的A是不可变的

- 应用场景不同

- 基址寻址用于多道程序或数据分配存储空间或短地址访问大空间

- 变址寻址用于处理数组、字符串、表格问题

- 操作对象不同

- 基址寻址中,程序员操作的是偏移地址

- 变址寻址中,程序员操作的是变址寄存器

- 面向对象不同

-

基址寻址的程序重定位和相对寻址公共子程序浮动的区别

- 程序重定位:多道程序运行的系统中,每个用户程序在一个逻辑地址空间里编写程序,装入运行时,由操作系统给用户程序分配主存空间,每个用户程序有一个基地址,放在基址寄存器中,在程序执行时,通过基址寄存器的值加上指令中的形式地址,就可以形成实际的主存单元地址

- 程序的起始地址存放在PCB中

- 基址寻址方式下,逻辑地址对应的是偏移量,而这段程序在主存中存储的起始位置就是它的基址寄存器内容;

- 而在相对寻址的情况下,由于公共子程序是共享的,位置不需要发生改变,当有一个程序需要用到该子程序的时候,利用相对寻址即改变PC值跳转到子程序开始执行即可,相当于相对寻址实现函数调用

- 程序重定位:多道程序运行的系统中,每个用户程序在一个逻辑地址空间里编写程序,装入运行时,由操作系统给用户程序分配主存空间,每个用户程序有一个基地址,放在基址寄存器中,在程序执行时,通过基址寄存器的值加上指令中的形式地址,就可以形成实际的主存单元地址

-

直接寻址下,地址只能是正,因此A当作无符号数处理

-

立即寻址通常用于给寄存器赋初值

-

EA是操作数的有效地址,(EA)才是操作数

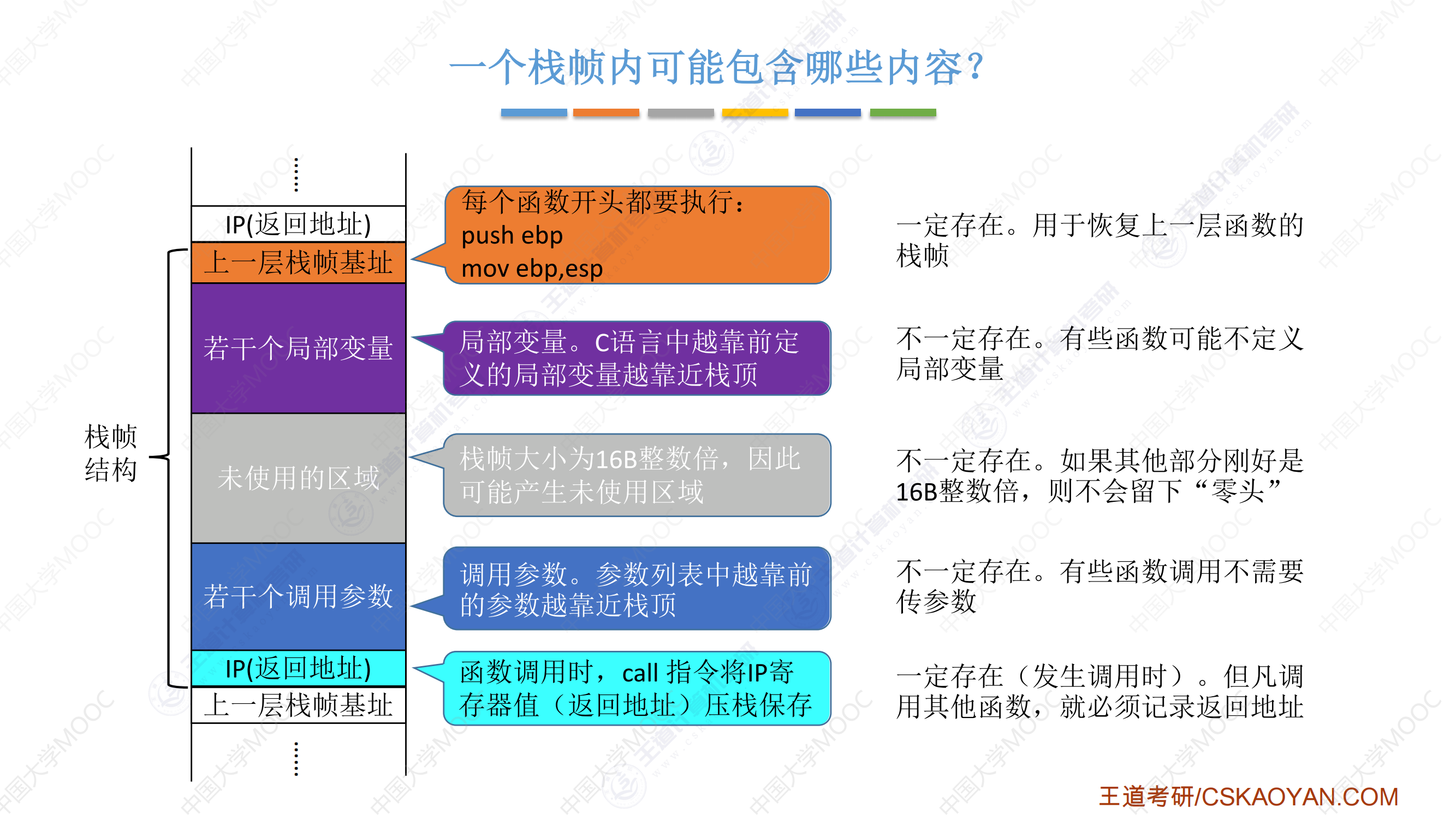

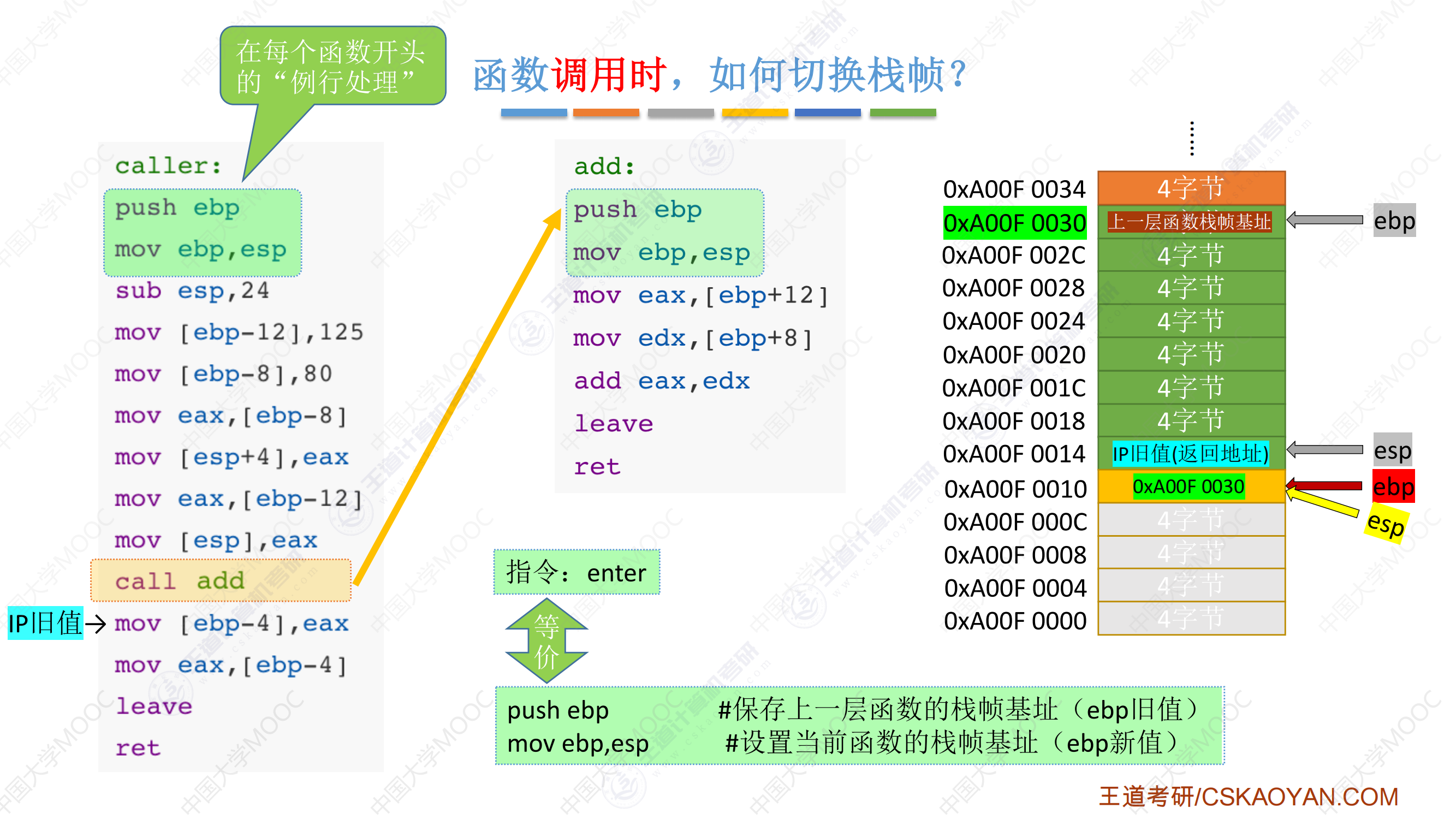

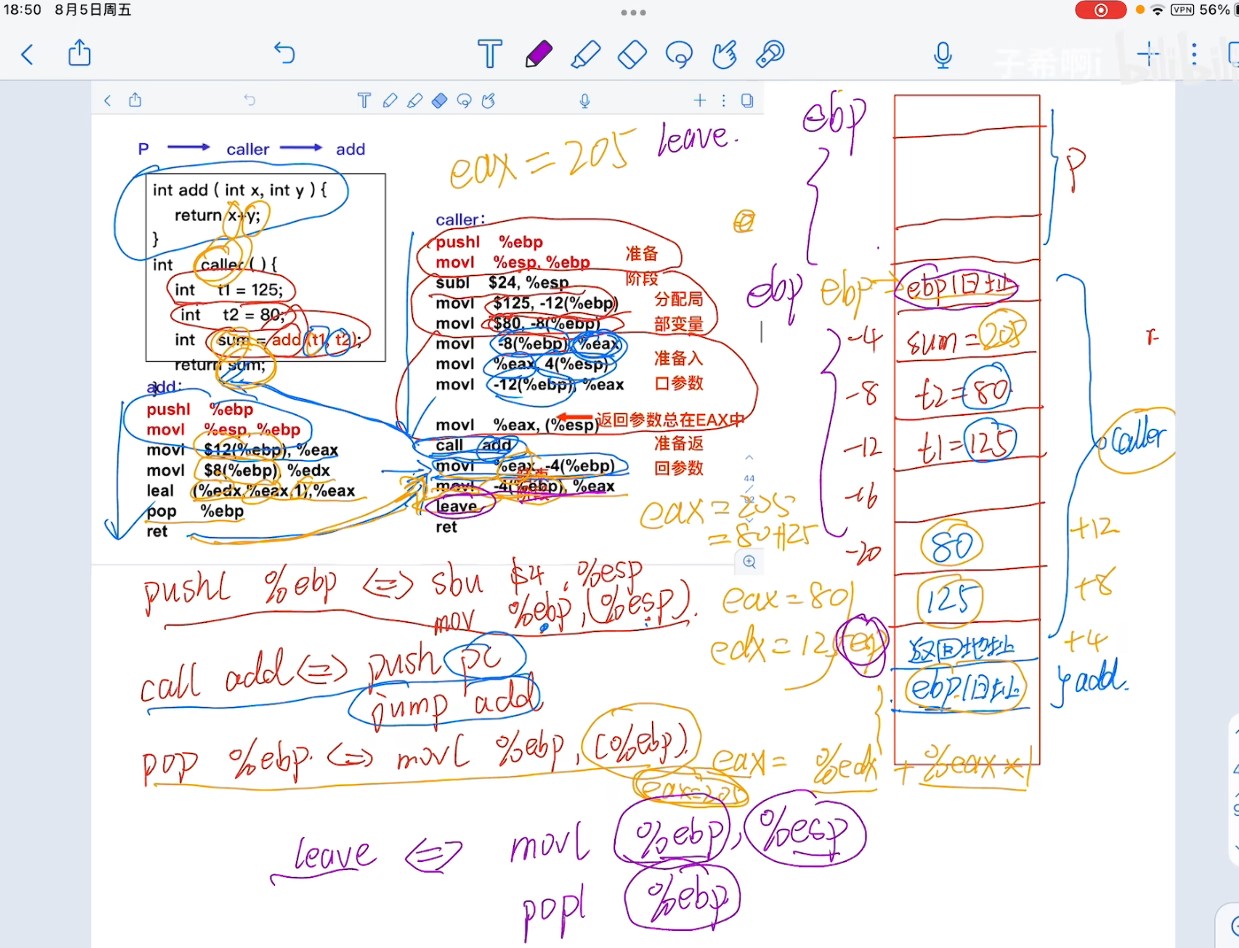

机器级代码表示(函数执行)

超硬核!408考研重点!汇编语言表示程序函数的过程调用!23王道计算机组成原理指令系统-被木窄干了-稍后再看-哔哩哔哩视频

-

双操作数指令的两个操作数不能都是内存

-

栈中元素固定32bit,向低地址方向增长

-

imul有符号整数乘法指令,两个数相乘,结果保存在第一个操作数中,第一个操作数必须为寄存器;三个数相乘,将第二个和第三个数相乘,将结果保存在第一个操作数中,第一个操作数必须为寄存器

-

idiv有符号整数除法指令,只有一个操作数,即除数X,而被除数在edx:eax中,操作结果有两部分:商和余数,商从到eax,余数送到edx

-

cmp指令的功能相当于sub指令,用于比较两个操作数的值,test指令的功能相当于and指令,对两个操作数进行逐位与运算,这两类指令不保存操作结果,仅根据运算结果设置CPU状态字中的条件码

-

常见的算术逻辑运算指令会设置条件码,还有cmp和text指令只设置条件码而不改变任何其他寄存器

-

过程调用中,调用者负责将实参和返回地址压栈保存

- 被调用者负责保存和恢复调用者的现场(通用寄存器的内容),并为自己的非静态局部变量分配空间,放置结果,释放空间,取出返回地址,转移回调用者

-

EAX、ECX和EDX是调用者保存寄存器,当P调用Q时,若Q需要用到这些寄存器,则由P将这些寄存器的内容保存到栈中,并在返回后由P恢复他们的值

- 寄存器EBX、ESI、EDI是被调用者保存寄存器,当P调用Q时,Q必须先将这些寄存器的内容保存在栈中才能使用他们,并在返回P之前先恢复它们的值。

-

push的是要存入的数,pop的是弹出的数要存的地方,一个是数值一个是地址

-

当子程序调用CALL指令时,首先需要将程序断点(PC值)保存在栈中,然后将CALL指令的地址码送入PC。

- 注意:栈地址的增减恒定为1,与指令长度无关

- 入栈的是逻辑地址,取指令的时候系统才按照逻辑地址根据一定的规则转换为物理地址再去访存,因此入栈的是PC的内容,即逻辑地址。

-

IP旧值和上一层函数栈帧基址的区别

-

IP 旧值(返回地址):指的是函数 调用返回后的地址(本来要执行,PC都设置好了,但是遇到了调用),也就是函数执行完毕后,程序应该跳转到的地方。对于

call指令来说,IP 旧值是指向call指令之后的下一条指令。每次call指令都会将这个返回地址压入栈中,以便函数执行完毕后跳转回去。栈帧基址:指的是 当前栈帧的基址(即当前函数栈帧的底部)。它用于帮助访问当前栈帧中的局部变量和参数,并且在函数调用时会被保存在栈中。通过基址指针

EBP,你可以访问当前栈帧中的数据。

-

-

为什么需要分别保存IP旧值和栈帧基址

-

IP 旧值 是函数执行完毕后 返回时的目标地址,它指向调用函数之后的下一条指令,也就是程序调用函数时的“跳转目标”。

栈帧基址(

EBP)是函数调用时保存的栈帧的起始位置,它用于恢复栈的结构,在函数返回时确保栈能够正确地恢复,防止栈指针错误。

-

-

栈帧最底部一定是上一层栈帧基址,最顶部一定是返回地址;越靠前定义的局部变量越靠近栈顶,越靠前的参数越靠近栈顶

- 这里的call函数并没有给出具体的汇编代码,只是执行压入IP旧值,跳转到IP新值

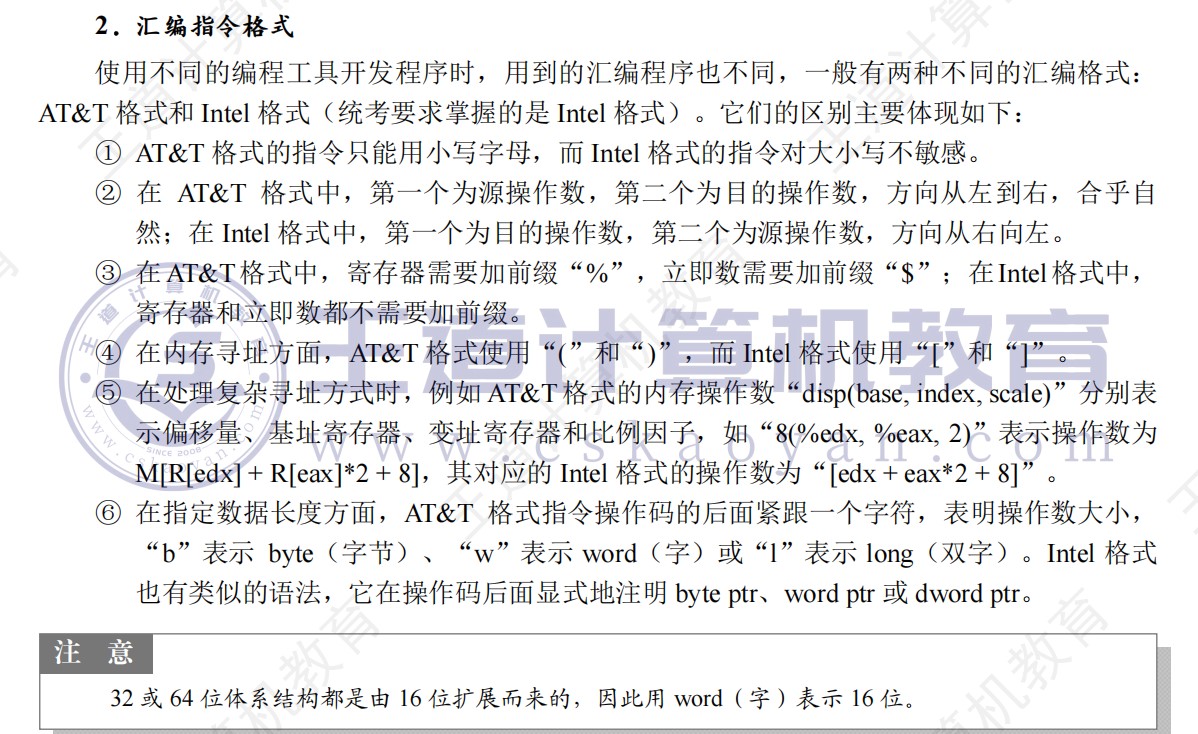

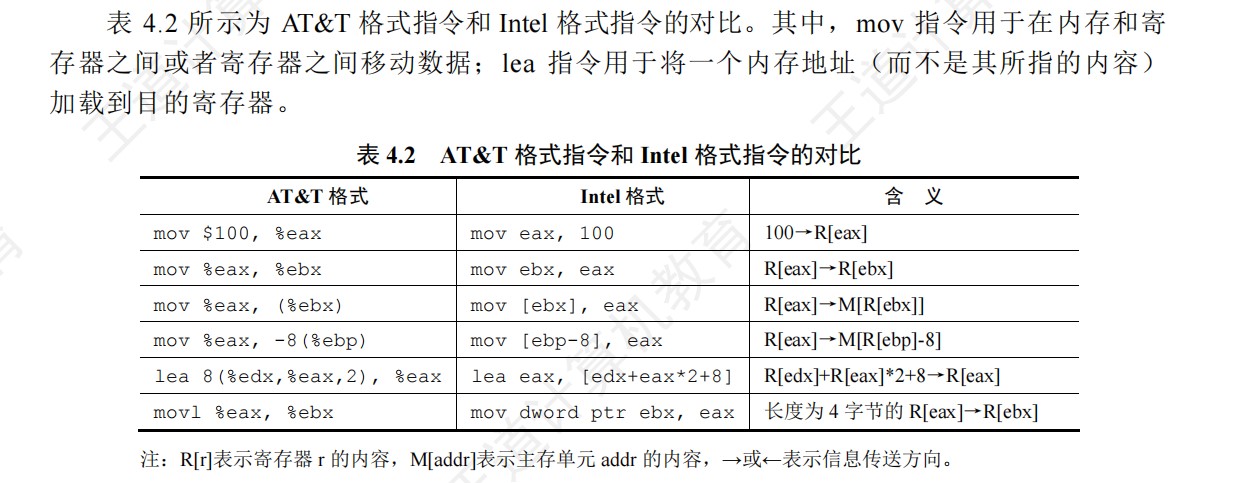

汇编格式

intel下

MIPS情况下

- 在MIPS架构中,

$sp(栈指针)指向的是栈顶元素的地址,而不是下一个位置。

详细解释:

栈操作方式

MIPS采用向下增长的栈(从高地址向低地址扩展),$sp始终指向当前栈顶的有效数据:

text

1 | |

栈操作示例

压栈操作(push):

mips

1 | |

出栈操作(pop):

mips

1 | |

函数调用中的使用

mips

1 | |

关键点总结:

$sp指向当前栈顶的有效数据- 栈向低地址方向增长

- 压栈时先移动指针再存储数据

- 出栈时先读取数据再移动指针

- 这种设计符合直觉,便于直接通过

0($sp)访问栈顶元素

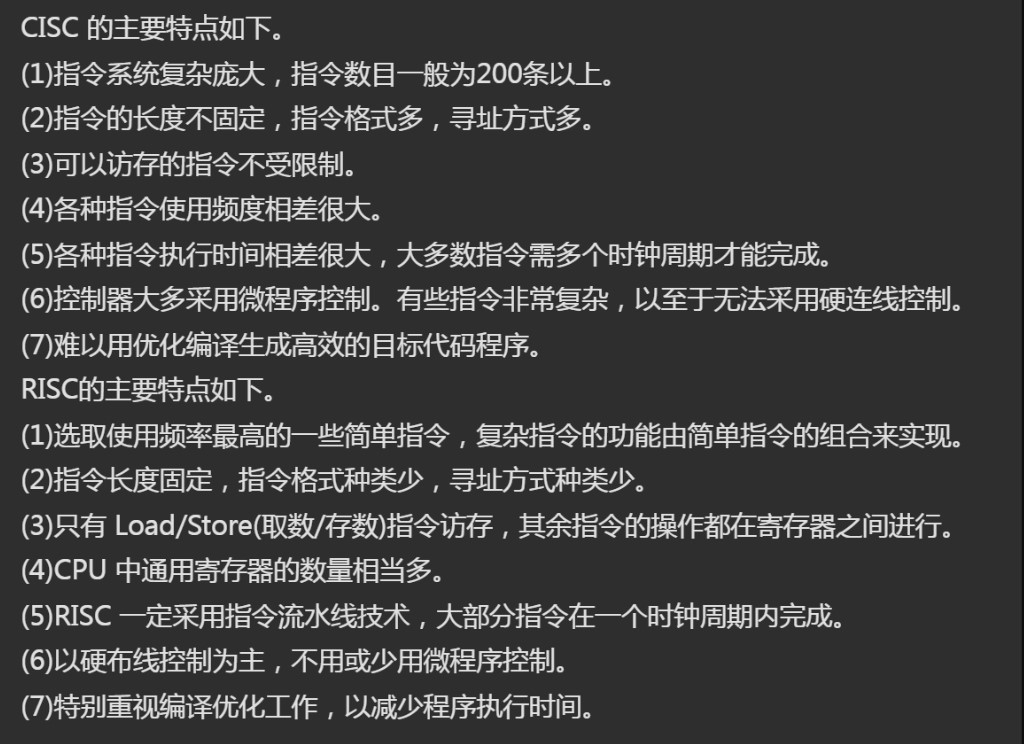

RISC和CISC

- RISC一定采用指令流水线技术,大部分指令在一个时钟周期内完成。

- RISC更能充分利用芯片的面积,便于设计,可降低成本,提高可靠性,机器设计周期短,逻辑简单,出错概率低,可靠性高,有利于编译程序代码优化,大部分用组合逻辑控制

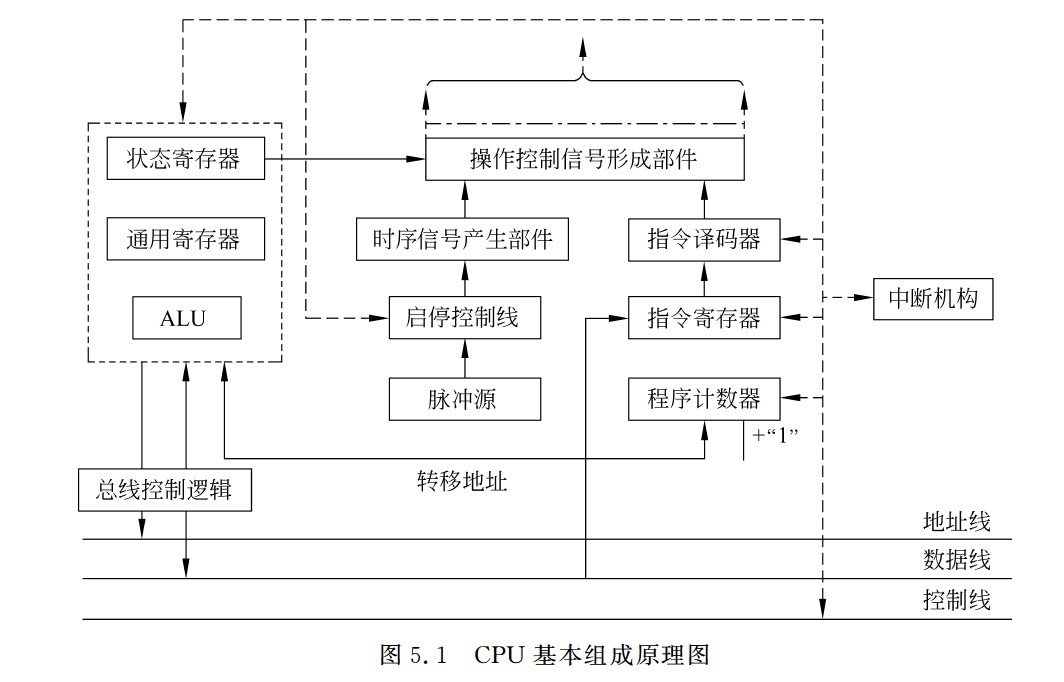

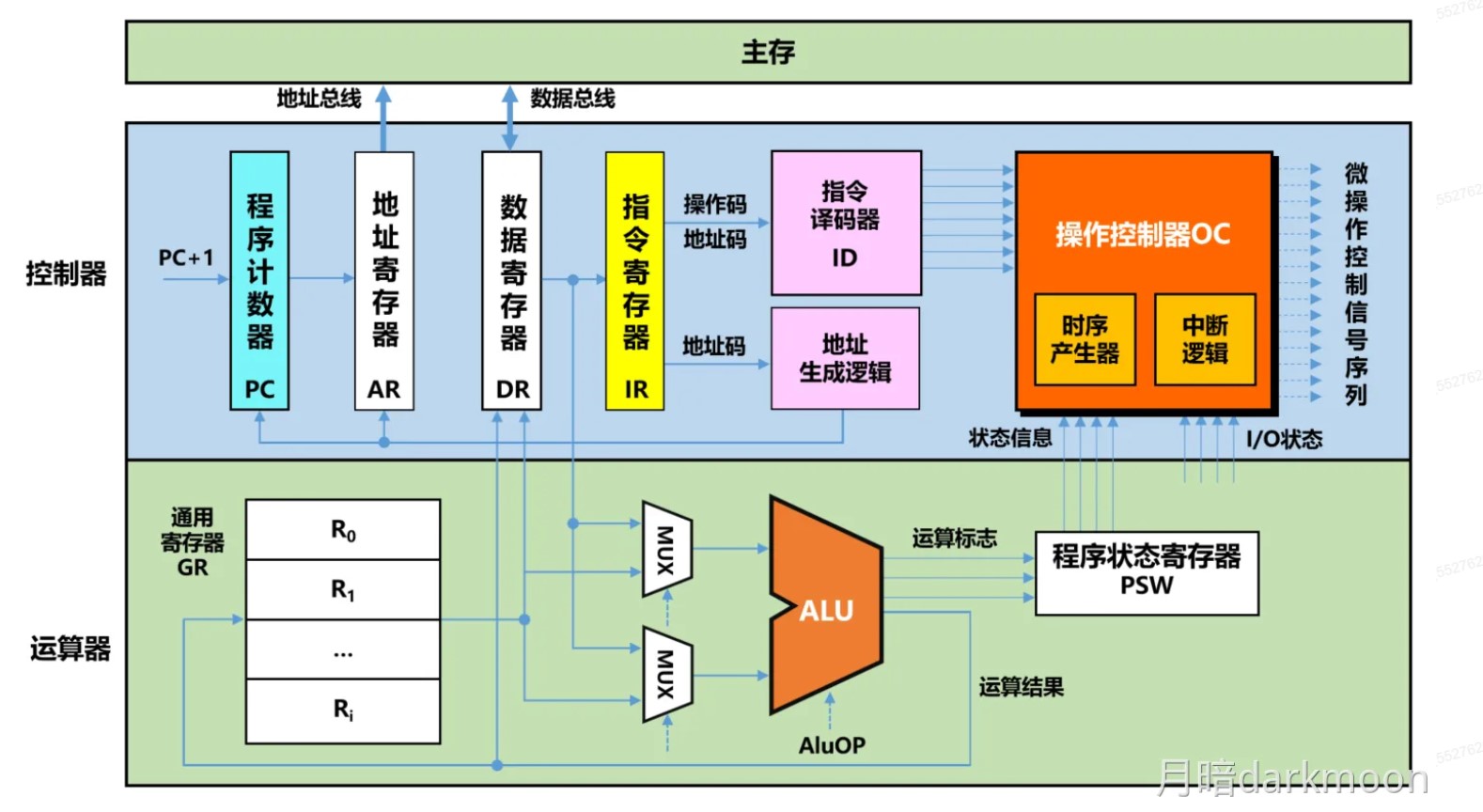

中央处理器

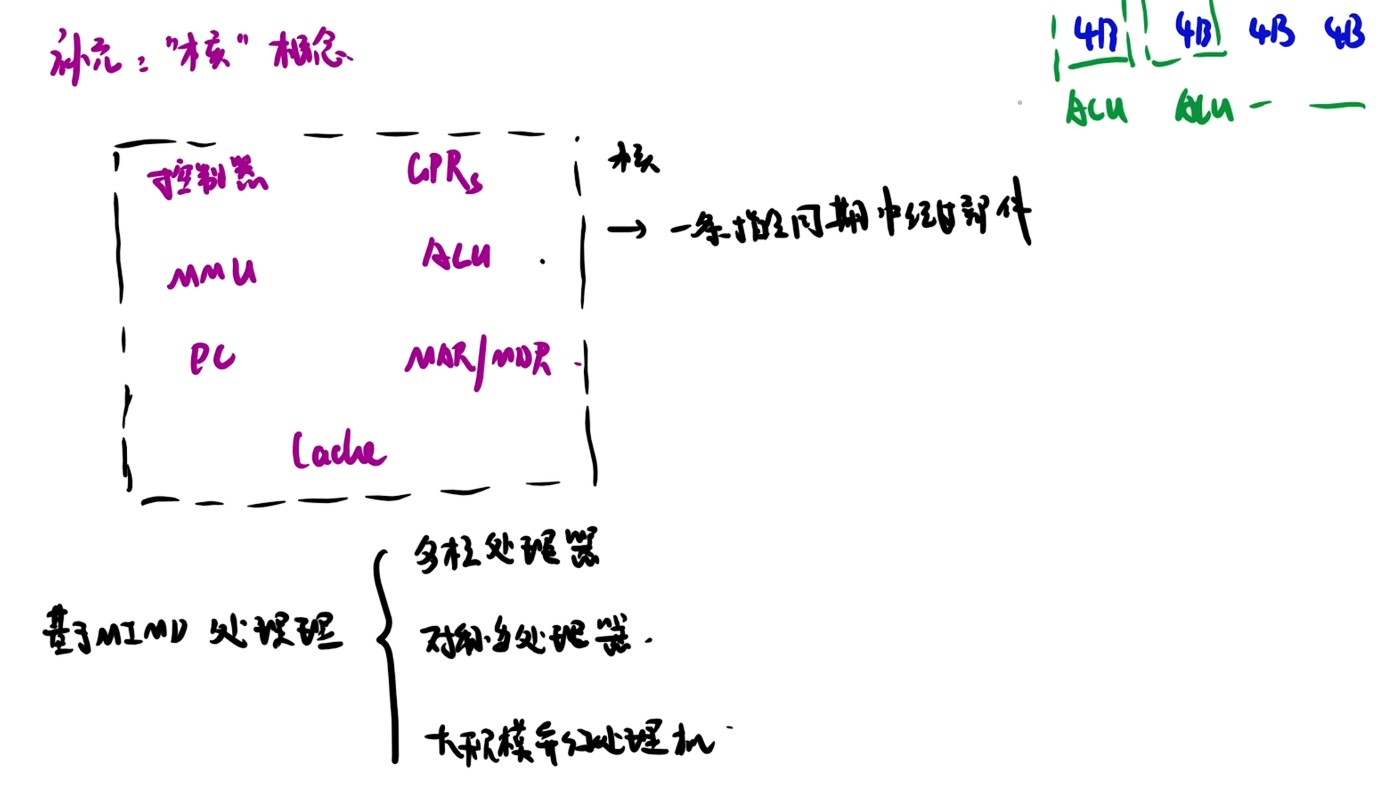

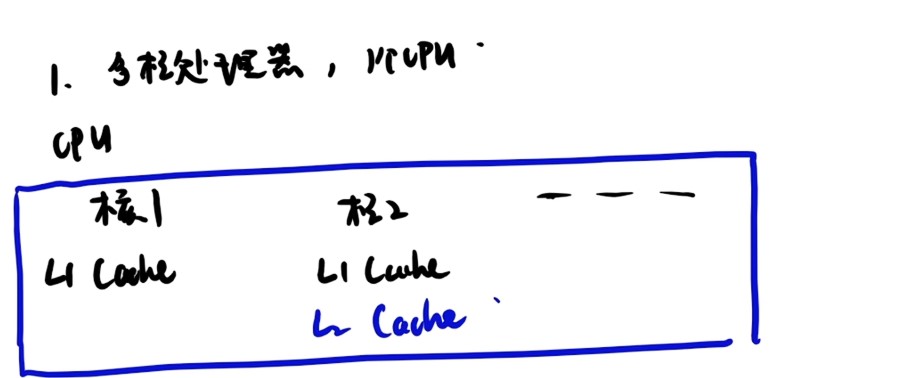

- 硬件多线程的基本思想是在一个处理器中同时维护多个线程的上下文,当一个线程因等待资源而暂停时,处理器可以切换到另一个线程继续执行,提高处理器利用率。

- 若是处于关中断/无中断请求,没有中断需要响应,指令周期就没有中断周期这个阶段

- 异常和中断处理逻辑属于数据通路

- 注意区分中断机构和中断检测和处理逻辑,前者是中断控制器,是硬件,后者属于软件:处理中断的内容,前者属于控制部件,后者属于数据通路

- 所有信号在一个时钟周期内从状态单元1经组合逻辑到达状态单元2,信号到达状态单元2所需的时间决定了时钟周期的长度

- 时钟周期以相邻状态单元间组合逻辑电路的最大延迟为基准确定

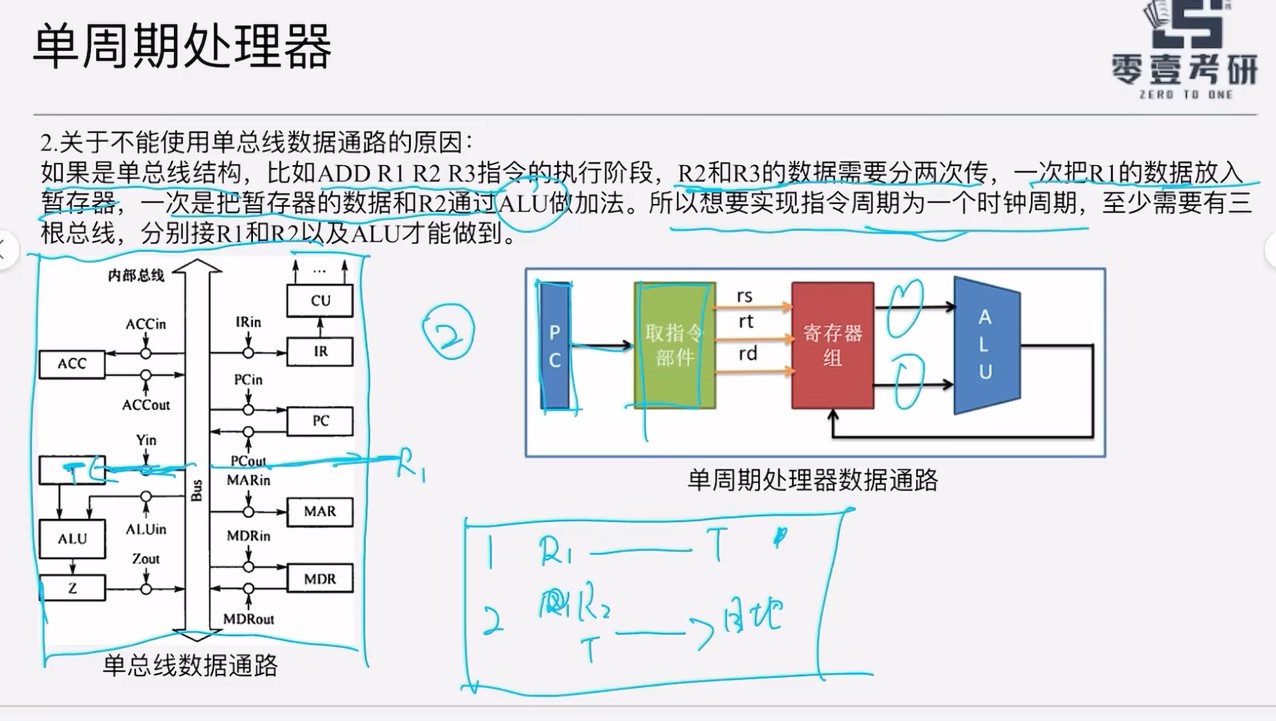

- 若单周期处理器中所有指令的指令周期为一个时钟周期,则可以采用多总线结构的数据通路

- PC的值由CPU在执行指令的过程中进行修改

- 用字地址表示指令地址的情况下,指令必须采用按边界对齐的方式存放,此时PC的位数=存储器地址的位数-log2(指令字长的字节数)

- PC的位数取决于存储器容量和字长

- 机器指令中不能显式使用PC

- 用户不能直接修改PSW的值

- 指令译码器仅对操作码字段进行译码,借以确定指令的操作功能

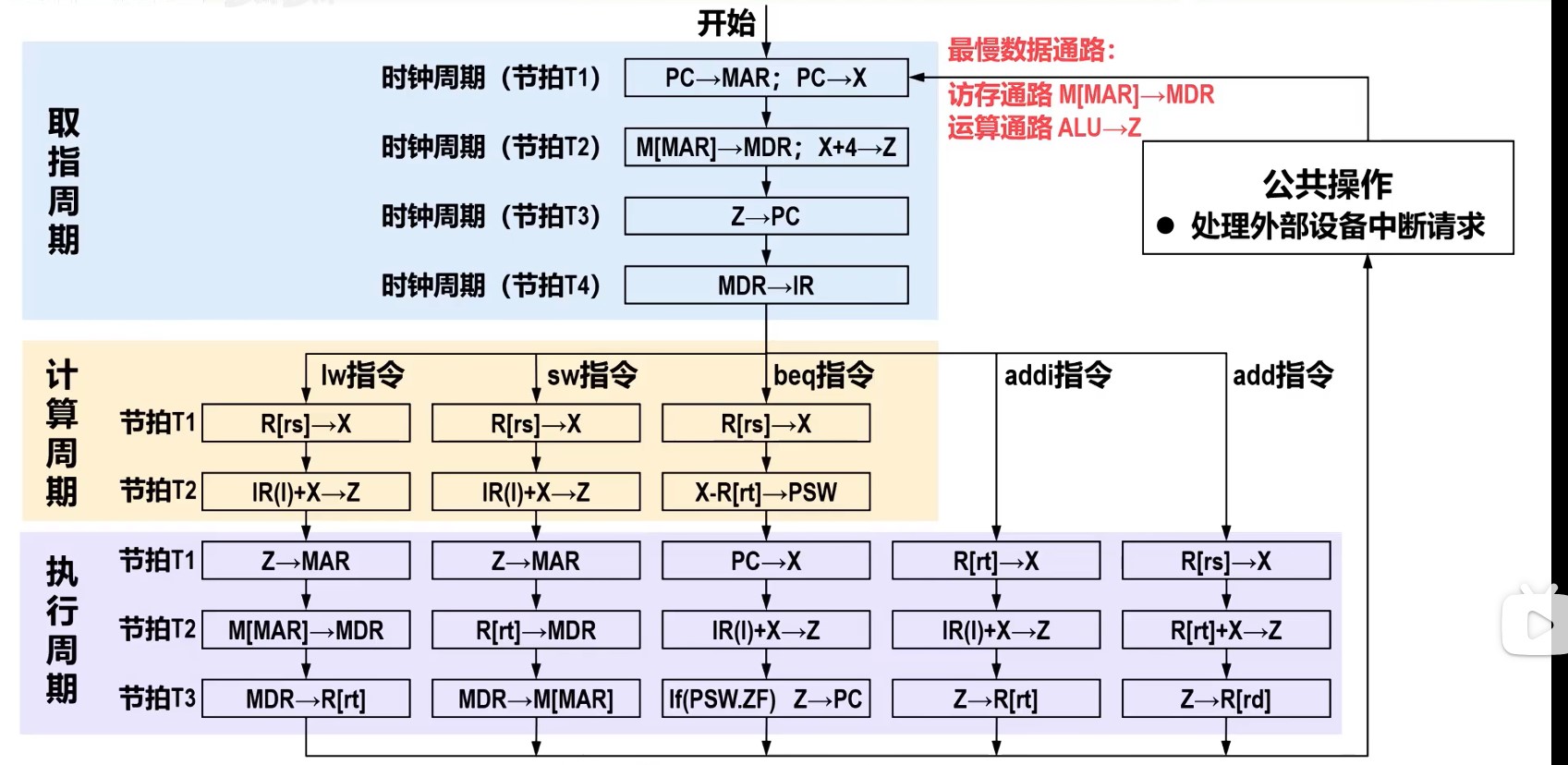

- 指令周期

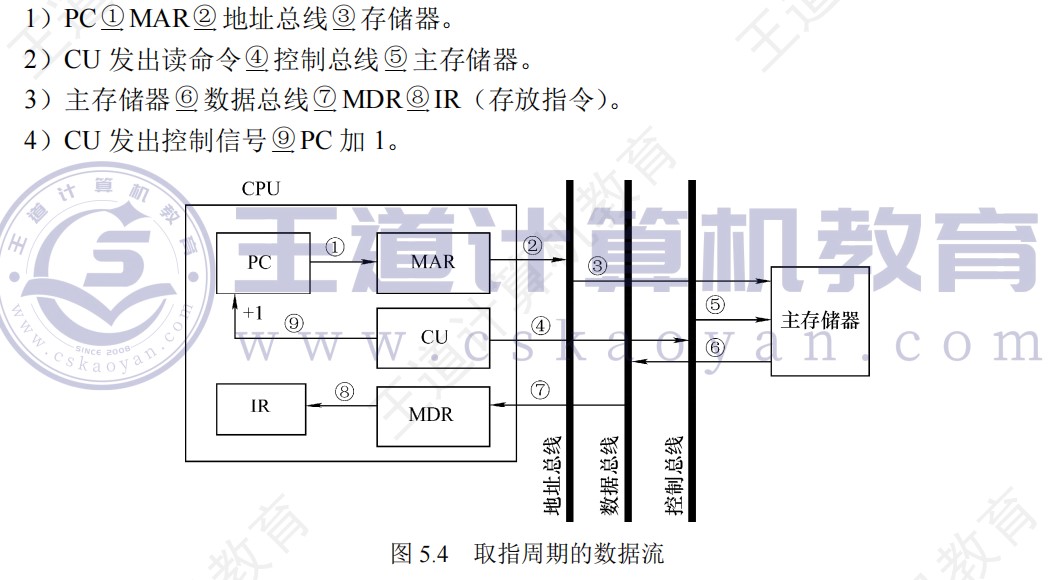

- 取指周期:取出指令

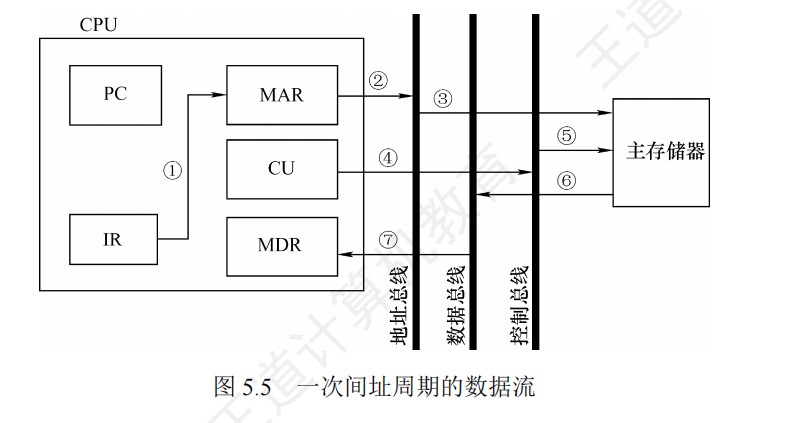

- 间址周期:取出操作数地址

- 执行周期:取出操作数,运算,存结果

- 中断周期:检查和响应中断

- 单周期处理器(CPI=1)不能采用单总线方式,因为单总线将所有寄存器都连接到一条公共总线上,一个时钟内只允许一次操作,无法完成一条指令的所有操作

- 微程序和硬布线控制器的PC和IR是相同的,但确定和表示指令执行步骤的方法及给出控制各部件运行所需要的控制信号的方案是不同的

- 硬布线控制器也有微命令与微操作的概念,并非微程序控制器的专有概念,但微指令为微程序控制器专属

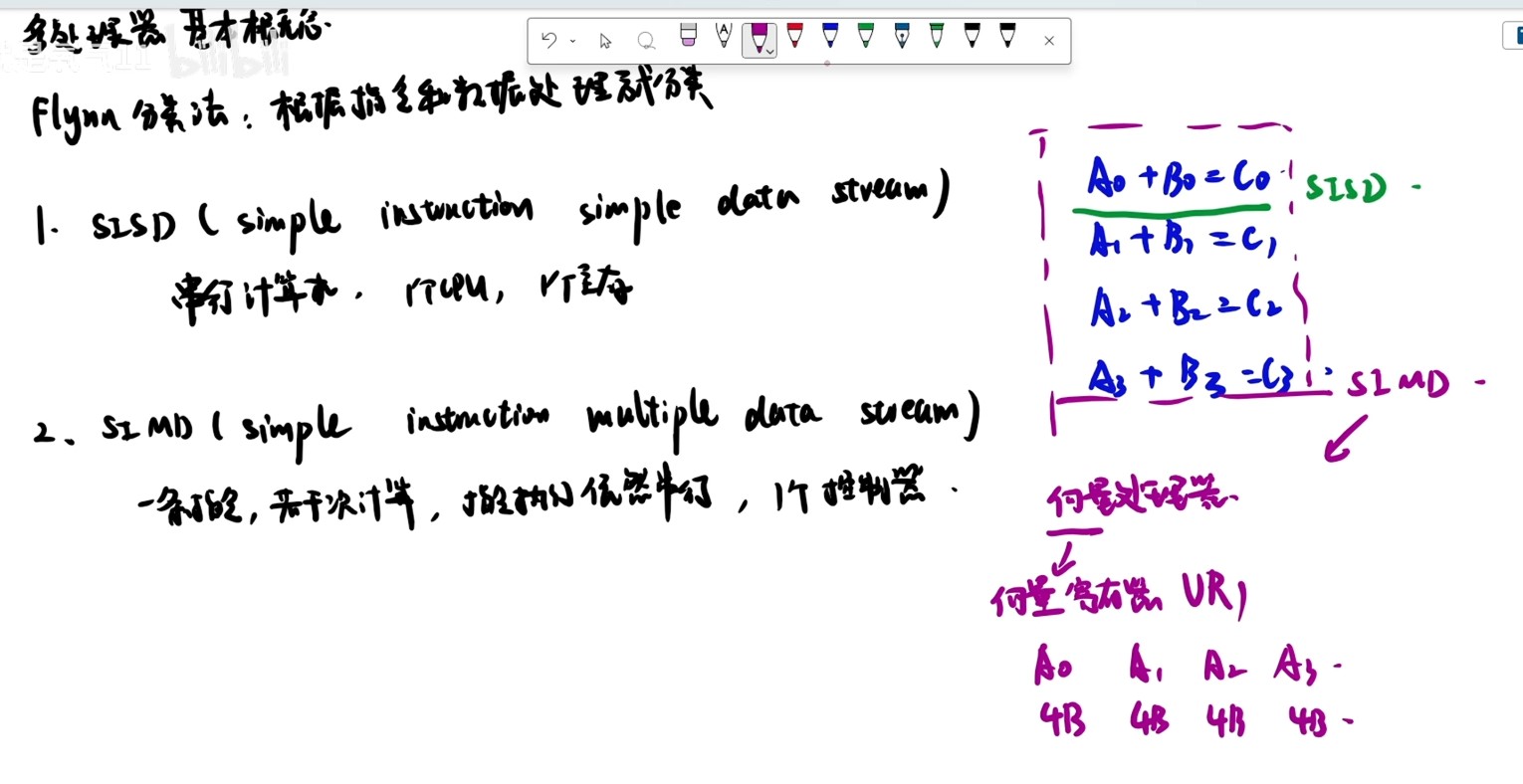

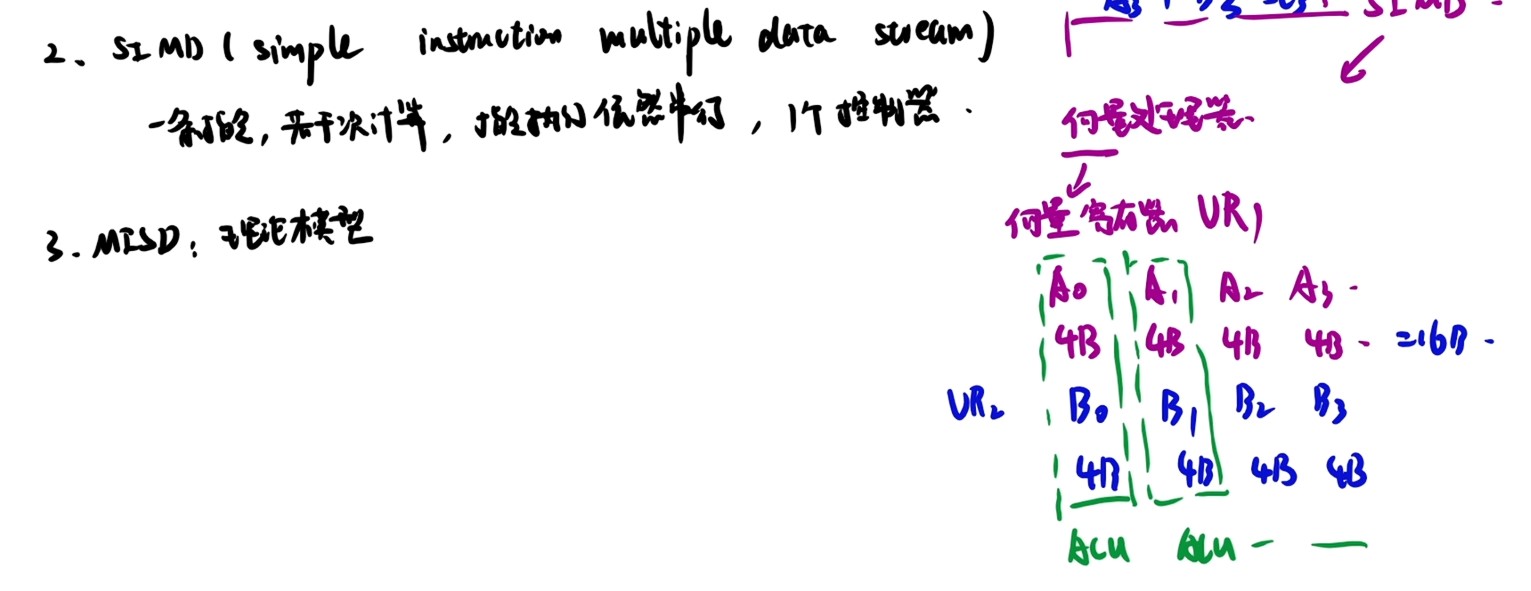

- SIMD组织运行于并行硬件上,SISD组织并运行在串行硬件上

- SIMD在使用for循环处理数组时最有效,在使用case或switch语句时效率最低。

- AR、DR、IR寄存器并不是必须的,另外运算器内部的通用寄存器组GR(又称寄存器堆)和程序状态字寄存器PSW属于用户可见存储器,在汇编编程时可以直接使用。其他寄存器为控制器内部使用,用于控制指令的进行

- PSW还可以用于保存中断和系统工作的状态信息,以便CPU能及时了解计算机运行的状态,从而便于控制程序

- 暂存寄存器用于暂存从主存读过来的数据

- 变长指令系统中指令的字节长度需要指令译码后才能确定

- 指令字中的地址码部分由地址生成逻辑对寻址方式进行译码并生成目标地址或数据,根据寻址方式的不同将目标地址送入程序计数器PC,地址寄存器MAR或运算部件。

- MAR不是必须的,部分计算机可以直接将访存地址加载在地址总线上实现访存

- 用户可见和用户可修改的区别

- 用户可见是指能读,不能保证能写

- PSW和PC可见但不能直接修改

- 中断屏蔽字寄存器可见

- 用户可修改是指能读也能写

- 用户可见是指能读,不能保证能写

- MIPS架构里,通常使用RA寄存器作为程序计数器,此时RA寄存器由于可以通过汇编指令显式保存,因此RA对于汇编程序员来说,可以直接读写

- 变址寄存器面向用户,应用程序员可直接读写

- CPU处于用户态时,SP指向用户栈栈顶,此时应用程序员可直接读写,当CPU处于内核态时,SP指向内核栈栈顶,此时应用层程序员没有权限读写,只有系统程序员可以读写。

- 缓存命中率是缓存系统的固有属性,不受寄存器数量影响

- 程序计数器用来保存下一条要执行的指令的地址,这个是必须的,因为CPU需要知道从哪里取下一条地址,否则无法顺序执行或跳转处理。

- 一条指令周期内PC的值可能改变2次,但是单周期处理器中,PC的值只会改变一次

- 单周期处理器的PC,仅在指令周期结束时被更新一次:

- 如果是顺序指令,PC更新为PC+4(或其他增量)

- 如果是分支/跳转指令,PC直接更新为目标地址

- 整个周期,PC不会在中间阶段被修改,因为所有操作是组合逻辑的组合,PC的更新是原子操作(发生在时钟边沿)

- 单周期处理器没有中间阶段的概念,因此PC只能被修改一次(在周期末尾时钟信号跳变时)

- 单周期处理器的PC,仅在指令周期结束时被更新一次:

- 间接寻址中,Ad(IR)字段的值(地址)可能需要暂存或处理

- 在间接寻址中,Ad(IR)的值可能先被复制到MDR,再用于后序操作(如设置MAR或进行地址计算)

- 单周期处理器里面取数指令里的访存,指的是读数据存储器

- 单周期处理器里面存数指令里,写的是数据存储器

- MIPS架构中,只有lw和sw可以访问内存

时钟周期和指令序列

理想CPI

多线程技术

- 细粒度多线程

- 一个时钟周期切换一次线程,需要硬件支持上下文频繁切换,适合实时系统

- 粗粒度多线程

- 某个线程出现了较大阻塞才切换线程,适合计算密集型指令

- 同时多线程

- 超线程

- 把一个物理核模拟成多个逻辑核,多个线程在一个时钟周期内并行执行。只要两个线程的指令在功能部件上不冲突,就可以并行发射,比如一个机算一个访存,这两个线程就是并行发射执行

- 超线程

- 多线程技术是一种共享单处理器中功能部件的技术。每个线程相当于一个指令序列,为了支持多线程并发执行,必须为每个线程提供单独的通用寄存器组、单独的程序计数器等,并提供快速的线程切换。

- 备份n份现场,n个线程,n个PC,n个通用寄存器组,直接从自己专用的取

硬布线控制器

-

个别指令的操作不仅受操作码控制,而且还受状态标志控制,因此CU的输入来自操作码译码电路、节拍发生器及状态标志,其输出到CPU内部或外部控制总线上。

-

功能由逻辑门组合实现,其速度主要取决于电路

-

采用时序逻辑技术实现,采用组合逻辑电路和状态寄存器进行设计的控制器,纯硬件实现

-

硬布线控制器适合于简单或规整的指令系统

-

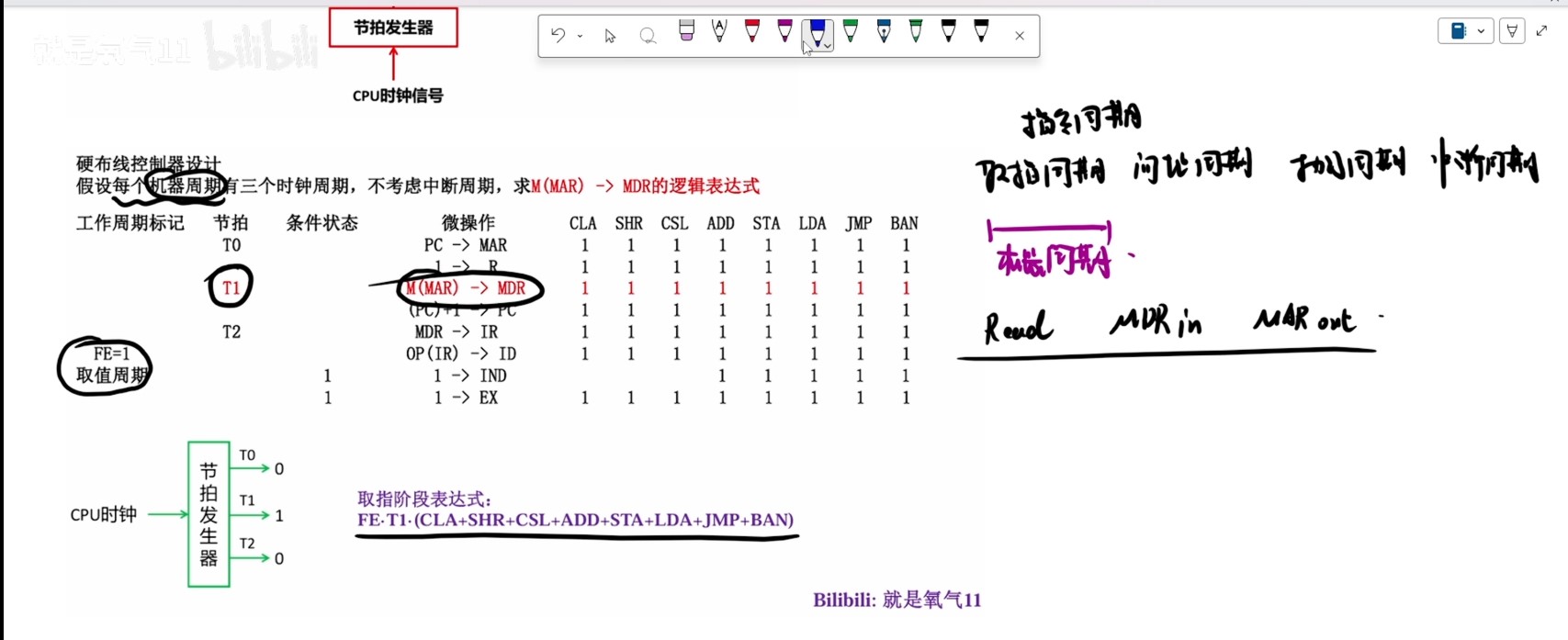

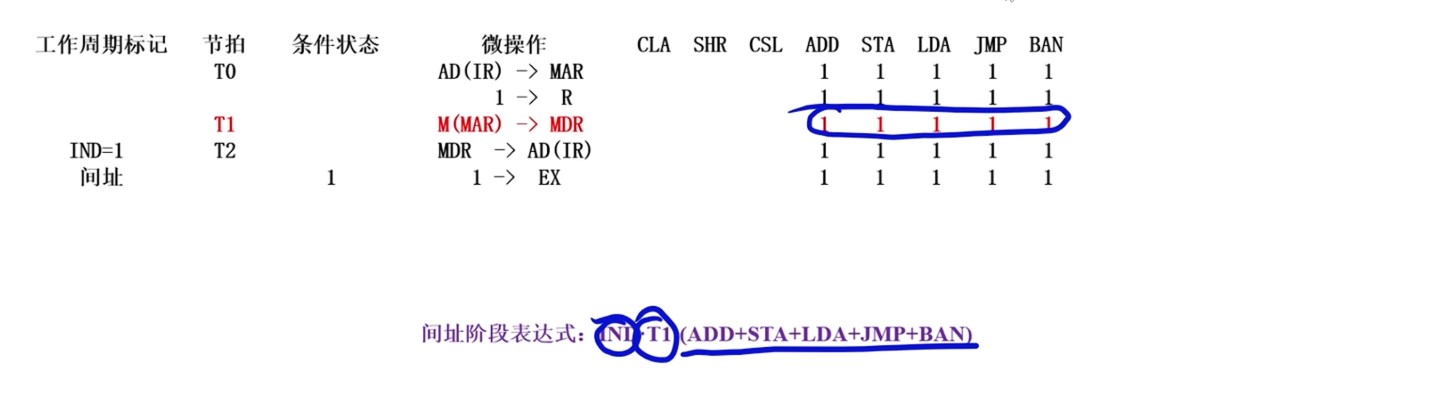

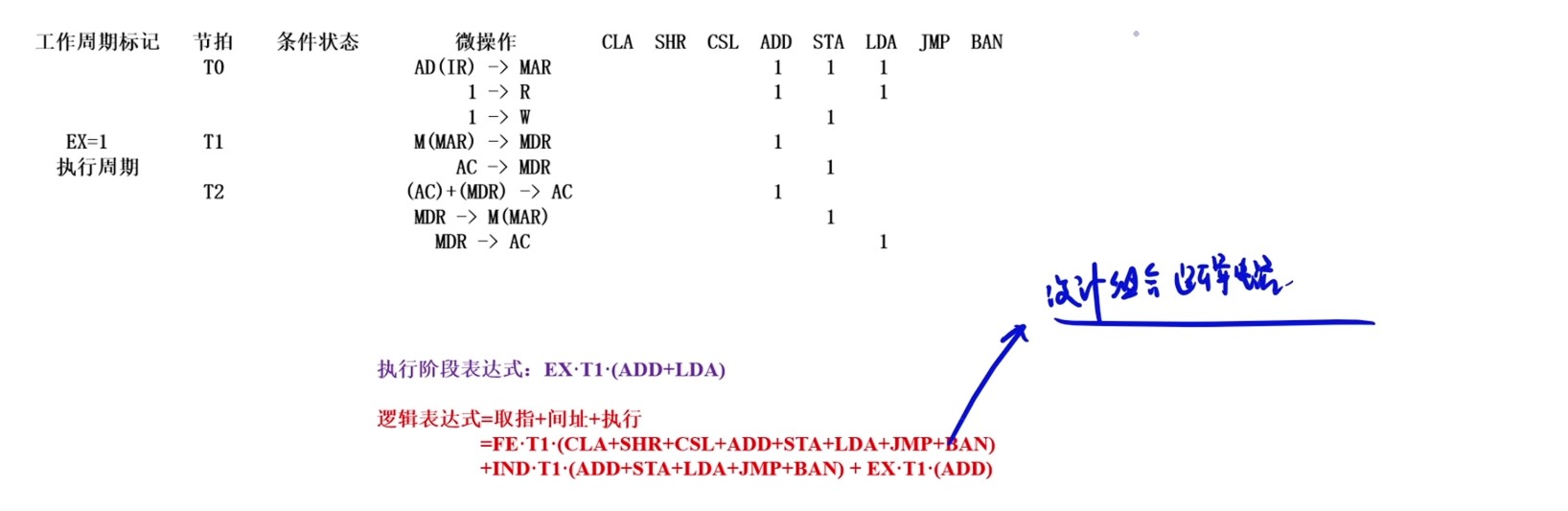

硬布线控制器逻辑表达式的推导

- ①确定在哪一个周期里面

- ②在哪个节拍进行操作

- ③哪些指令会执行这个微操作

- 同时与,并列或

微程序控制器

-

-

在并行微程序控制器中,由于取微指令和执行微指令的操作是在两个完全不同的部件中执行的,因此,可以将这两部分操作同时进行

-

微程序控制器中,执行指令微程序的首条微指令地址是指令操作码译码得到的

- 微指令中的微地址码字段,用于控制产生下一条要执行的微指令地址

- 起始和转移地址形成部件(简称微地址形成部件),用于产生初始和后继微地址,用以保证指令的连续执行

-

硬布线控制器又名组合逻辑控制器

-

取指微程序是每条机器指令公共的微程序,入口地址通常固定(μPC初始置0,即CM中的首条就是取指微程序的首地址,然后执行取指微程序进行取指)

-

控制存储器(CM)用于存放微程序,在CPU内部,用ROM实现。存放微指令的存储控制器的单元地址称为微地址

-

控制存储器中的微程序能解释执行整个指令系统的所有指令

-

每条指令都要访问控制存储器

-

取指微程序和机器指令微程序的关系和区别

-

微程序是计算机设计者事先编制好并存放在控制存储器中的,一般不提供给用户。对于程序员来说,系统中微程序的功能和结构是透明的。

-

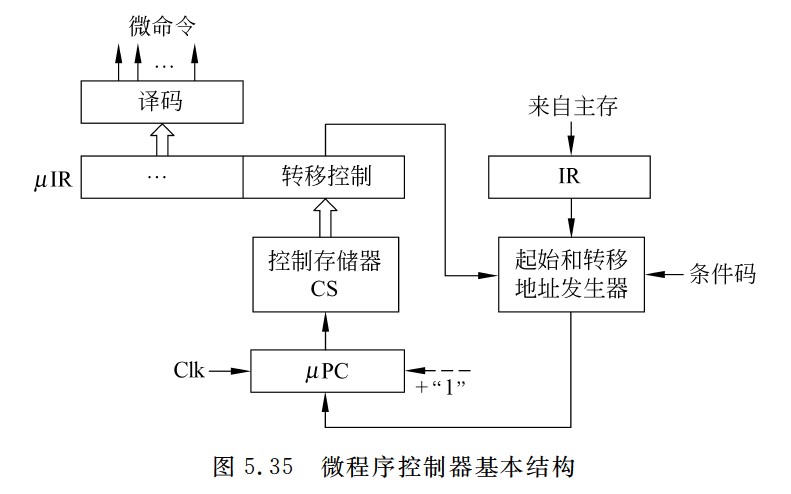

工作过程

-

①取指。机器自动将取指微程序的入口地址送μPC,并从CM中读出相应的微指令并送入μIR。

-

取指微程序:取指操作(Fetch Cycle)是所有指令共享的通用操作,它不属于任何特定指令的执行微程序。取指微程序的入口地址通常是固定的(例如,地址0或某个硬连线的地址),不是由操作码产生的。CPU在复位或开始执行指令时,总是先进入这个固定的取指微程序。

-

在CPU开始运行(例如,上电复位或复位信号触发)时,μPC会被硬件强制初始化为这个固定的取指微程序入口地址。这是通过复位逻辑实现的,而不是由操作码产生的。

-

在指令执行过程中,当一条指令的微程序执行完毕时,地址形成部件会自动将μPC设置为取指微程序的入口地址,从而开始下一条指令的取指周期。这通常是通过一个“返回”机制实现的,例如,在微指令中包含一个字段指定下一个地址源为“取指入口”。

-

假设CPU正在执行一条指令(如ADD)。当ADD指令的微程序完成后,地址形成部件会检测到“指令结束”状态,并自动将取指微程序的入口地址加载到μPC。

-

计数器法下,微指令中没有地址码字段,实际上,取指微程序的入口地址由上一条机器指令对应的微程序最后一条微指令的控制字段给出,下图是一种实现方式,当控制字段为00的时候,直接将0(取指微程序地址)送μPC。

-

也即,开始时是硬件实现,后面是控制字段实现

-

-

-

②由机器指令的操作码字段通过微地址形成部件产生该机器指令所对应的微程序的入口地址,并送入μPC

- 每次把新指令装入IR的时候,微地址形成部件将根据指令内容,生成微程序入口地址放入μPC中

-

③从CM中逐条取出对应的微指令并执行

-

④执行完对应于一条机器指令的一个微程序后,又回到取指微程序的入口地址,继续第①步,以完成取下一条机器指令的公共操作。

-

总结:取指微程序初始化→取出指令→根据取出指令的操作码找到对应的微程序→开始执行

-

微指令中的转移控制部分被送微地址形成部件,根据条件码和相应微命令产生新的微指令地址送入μPC

-

若当前执行的是某条机器指令对应微程序的最后一条微指令,则下一条微指令就是取指令微程序的第一条微指令

- 若执行完取指令微程序的最后一条微指令,则下一条微指令就是当前指令对应微程序的首条微指令

- 若在某个微程序执行过程中,则可能按顺序取出下一条微指令执行,或者无条件转到另一处微指令执行,或根据条件码或指令操作码选择不同分支处的微指令执行。

-

-

控制存储器中的微程序个数应为机器指令数再加上对应取指、间址和中断周期公共的微程序数

-

计数器法转移执行时,在当前微指令后添加一条转移微指令,并在微指令中添加专门的转移控制字段,将转移微指令或转移控制字段中的控制信息送到微指令地址发生器,与相应的指令操作码以及条件码等组合,生成转移地址送μPC。

- 当转移分支很多时,相应的微地址生成逻辑电路很复杂。为简化微地址生成逻辑,通常采用PLA或ROM来实现。

-

微程序相对固定,通常不放在主存内

微指令地址的确定

-

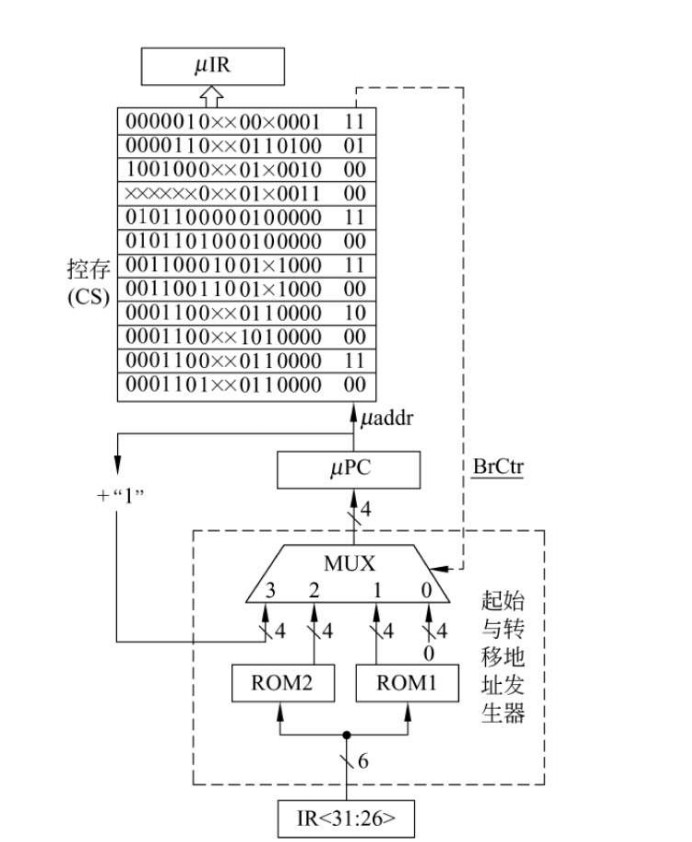

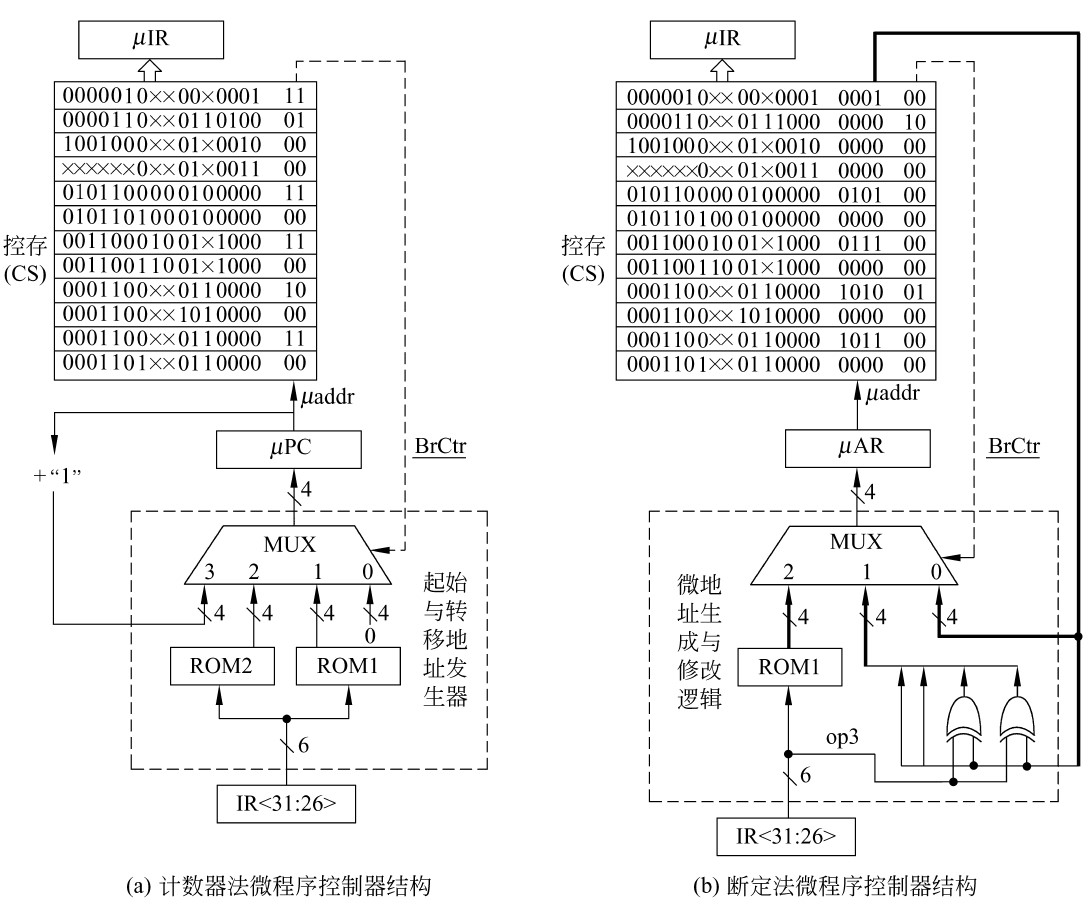

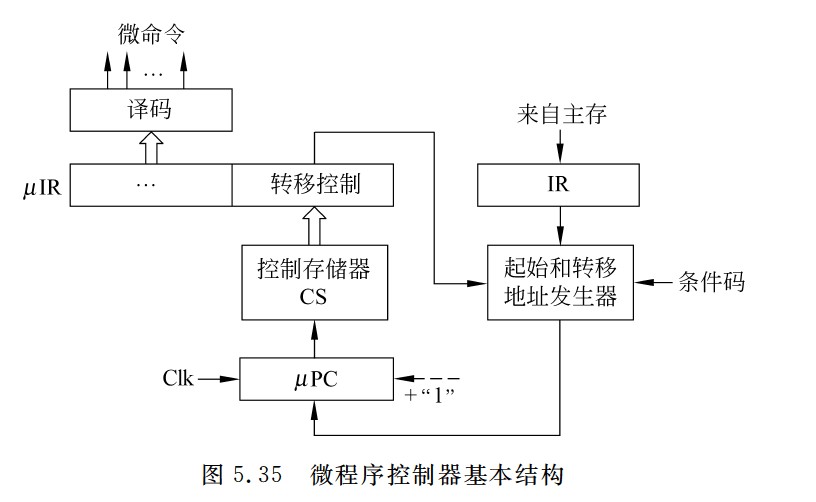

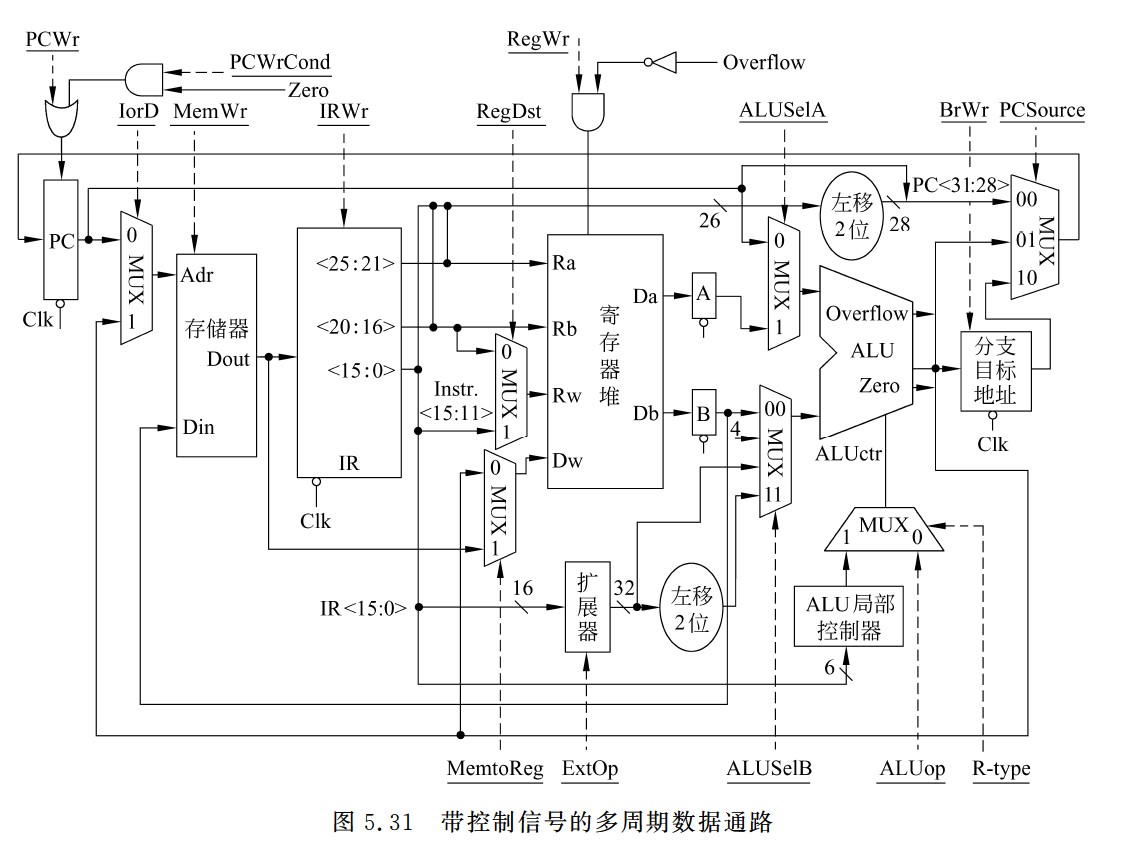

计数器法

- 使用一个专门的微程序计数器μPC,将下条微指令地址隐含地存放在μPC中,因此,这种方法称为计数器法。

- 顺序执行时,根据μPC+1→μPC,得到下一条微指令地址;转移执行时,在当前微指令后添加一条转移微指令,并在微指令中添加专门的转移控制字段,将转移微指令或转移控制字段中的控制信息送到微指令地址发生器,与相应的指令操作码以及条件码等组合,生成转移地址送μPC。

- 图5.35所示的就是采用计数器法的微程序控制器基本结构。当转移分支很多时,相应的微地址生成逻辑电路很复杂。为简化微地址生成逻辑,通常采用PLA或ROM来实现。

-

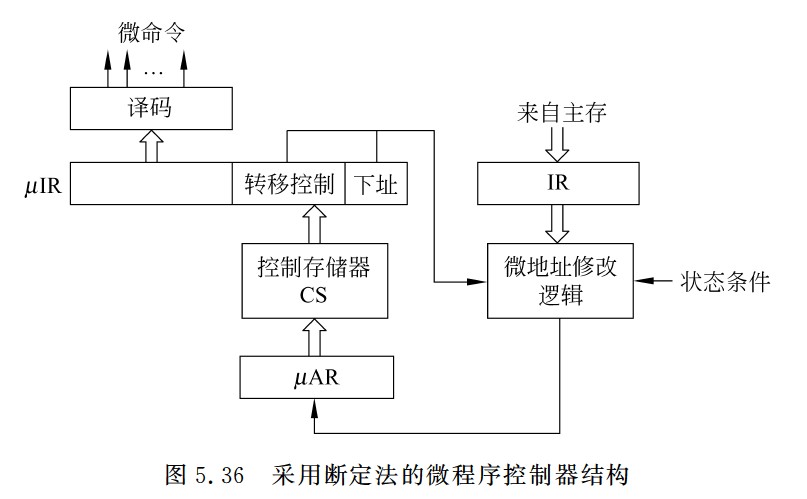

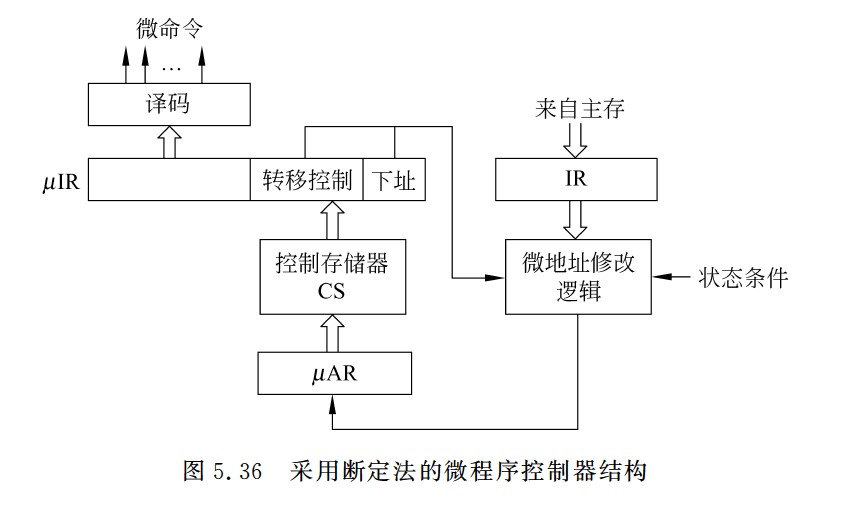

断定法

- 计数器法的缺点是必须在不连续执行的微指令之间加入转移微指令,这样,在增加微指令条数的同时,还严重影响指令执行速度。如果在微指令中直接明确指定下一条微指令地址,这样,相当于每条都是转移微指令,即使不连续执行也没有关系。这种方法称为断定法,也称为下址字段法。断定法虽然加快了指令执行速度,但因为增加了微指令的长度,从而影响控制存储器的有效利用。例如,假定一个采用微程序控制器的处理器的控存容量为4KB,共有500条左右的微指令,这意味着下址字段至少有9位,微指令长度为64位左右,其中除了下址字段以外,还有一些其他如控制多分支转移的条件测试和转移控制字段等,也都用于控制微指令的寻址,因此,大约有五分之一的控存空间用于微指令寻址,真正用来存放微命令的空间只有五分之四左右。

此方法最明显的优点是消除了专门的转移微指令,而且在给微指令分配地址时不需要考虑如何排列,也不需要对μPC增量,而用一个简单的微指令地址寄存器(μAR)来存放当前微地址。采用断定法的微程序控制器结构如图5.36所示,其中,微地址修改逻辑根据当前指令、状态条件、下址字段和转移控制字段来确定微程序的执行顺序。

- 计数器法的缺点是必须在不连续执行的微指令之间加入转移微指令,这样,在增加微指令条数的同时,还严重影响指令执行速度。如果在微指令中直接明确指定下一条微指令地址,这样,相当于每条都是转移微指令,即使不连续执行也没有关系。这种方法称为断定法,也称为下址字段法。断定法虽然加快了指令执行速度,但因为增加了微指令的长度,从而影响控制存储器的有效利用。例如,假定一个采用微程序控制器的处理器的控存容量为4KB,共有500条左右的微指令,这意味着下址字段至少有9位,微指令长度为64位左右,其中除了下址字段以外,还有一些其他如控制多分支转移的条件测试和转移控制字段等,也都用于控制微指令的寻址,因此,大约有五分之一的控存空间用于微指令寻址,真正用来存放微命令的空间只有五分之四左右。

计数器:

- BrCtr=00:转到取指令微程序首条微指令执行。

- BrCtr=01:转到由**ROM1的输出所指的微指令(执行微程序的第一条指令)**执行。

- BrCtr=10:转到由R**OM2的输出所指的微指令(lw/sw指令的分支跳转)**执行。

- BrCtr=11:按顺序执行。

断定法:

- BrCtr=00:转到微指令的下址字段指出的微指令执行。

- BrCtr=01:转到由op3修改后的微地址所指的微指令执行。

- BrCtr=10:转到由ROM1的输出所指的微指令执行。

- ROM1:存放的是各指令微程序的首地址。取指令微程序的首地址为0000,地址0001处的为指令执行结束后,可能会转到不同指令(执行微程序)对应的微程序指令,其分支转移功能由ROM1实现

- ROM2:两个单元,分别存放1001和1010,lw和sw指令的微程序中有一个分支转移点,需要根据当前指令是lw还是sw来决定1000处的微指令执行后是转到1010处执行还是1001处执行。lw/sw指令微程序中的分支功能由ROM2实现。

- 第一条微指令的地址是根据当前指令从

μIR中取得的,并由μPC指向。 - 后续的微指令则由

μPC自动递增,指向下一个微指令的地址。

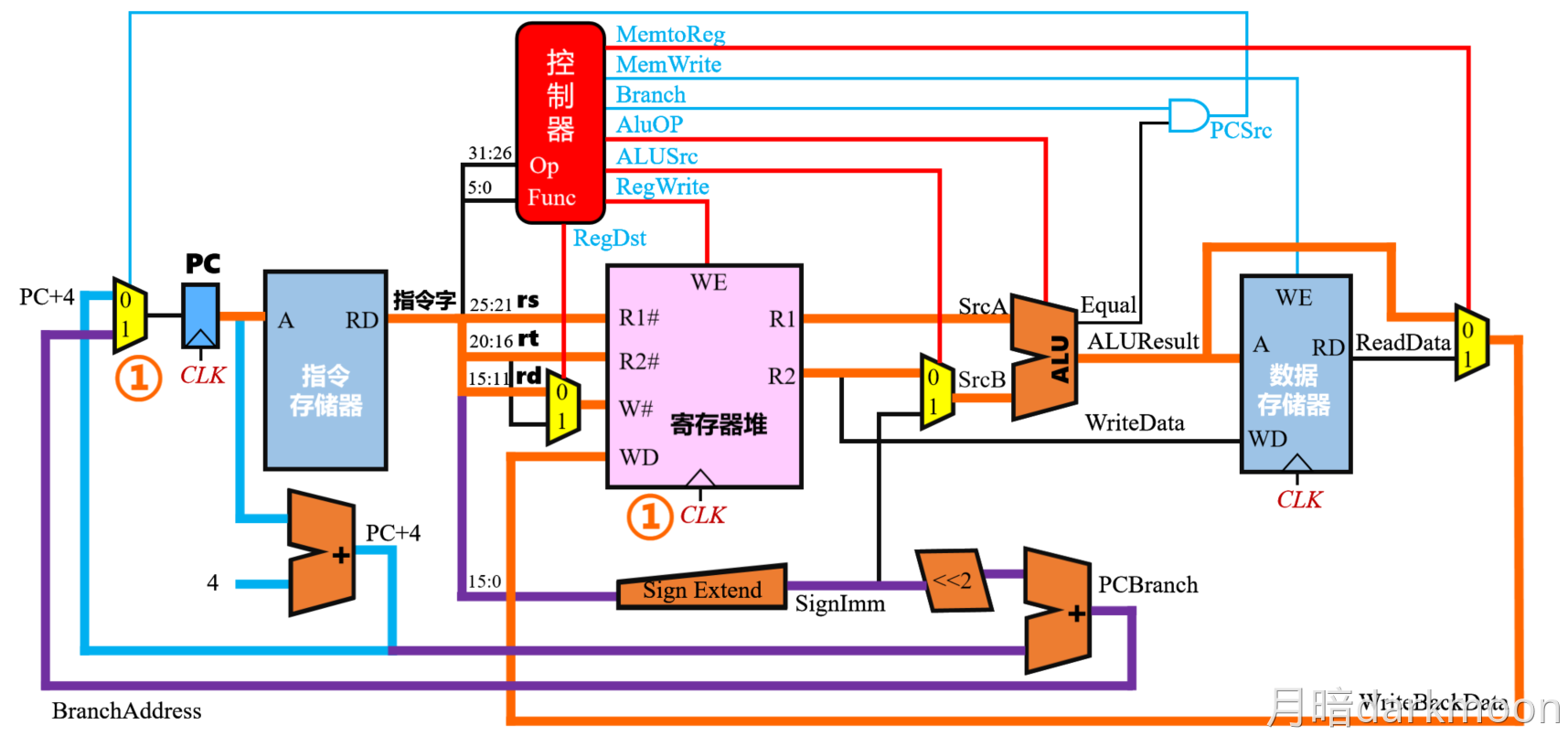

单周期处理器

华科大计组配套视频 单周期mips数据通路_哔哩哔哩_bilibili

-

单周期处理器使用硬连线控制和非总线结构(如直接控制和多路选择器),是专用数据通路而非多总线。总线式结构更常见于多周期或微程序控制处理器中。

-

单周期处理器的整个数据通路中只可以存在两个状态单元,因此,指令Cache被设计成只读的组合逻辑单元,CPU不能对指令Cache进行写操作,只能执行读操作。

-

由于指令寄存器是只读的,因此单周期处理器将其设计为无需控制信号的控制,只需要给出指令地址,经过一定的取数时间后,指令被送出

-

单周期处理器中,取指阶段并不会直接将指令输出。而是将指令的控制信号,源操作数和目的操作数输出

-

要想实现指令周期为一个周期,至少需要有三根总线,分别接R1和R2以及ALU才能做到

-

寄存器组在单周期处理器中,既允许执行读操作,也允许执行写操作。若执行读操作时,寄存器组当作组合逻辑部件。若需要写寄存器时,CPU给出写信号,寄存器组此时变成状态逻辑部件

-

单周期处理器,指令执行过程中控制信号不变

-

单周期处理器在取指令的时候,并不会将指令取出,而是根据 PC中的值,由取指部件经过一段取指时间后,直接输出指令的控制信号和需要的操作数。

-

寄存器堆的读操作,被设计成自动执行的操作,不需要其他的控制信号,但是写寄存器必须明确写控制信号

-

单周期处理器的数据通路中,除了存在有效的数据流,还同时存在无效的数据流。这是单周期处理器本身无法避免的一个缺陷。

-

红色有效数据流,蓝色无效数据流

-

ADD指令的计算结果会从ALU输出。这个结果也会被当作成主存地址,并且数据存储器会将地址中的数读出,这个操作是十分危险,却无法避免的。因为数据寄存器Adr并不知道ALU输出的是地址还是计算结果,只会机械地将所有ALU输出的值当作主存地址,并将对应的数据读出

-

Store指令的功能是通过计算得到主存地址,然后将寄存器里面的数据写到主存地址中

- 会把无效数据写入计算机中

-

对于多路选择器来说,0和1均表示有效信号,以选择不同的输入作为输出

-

指令执行的过程中,所需要使用的功能部件都应该能够完全并发,同一功能部件需要多次使用时,就应该设置多个相同的功能部件

- 每个控制信号被送到向相应的控制点,一直作用在数据通路中,每个部件只完成一种功能,不会被多次使用。

-

取指令操作的延时主要由存储器的取数时间决定

-

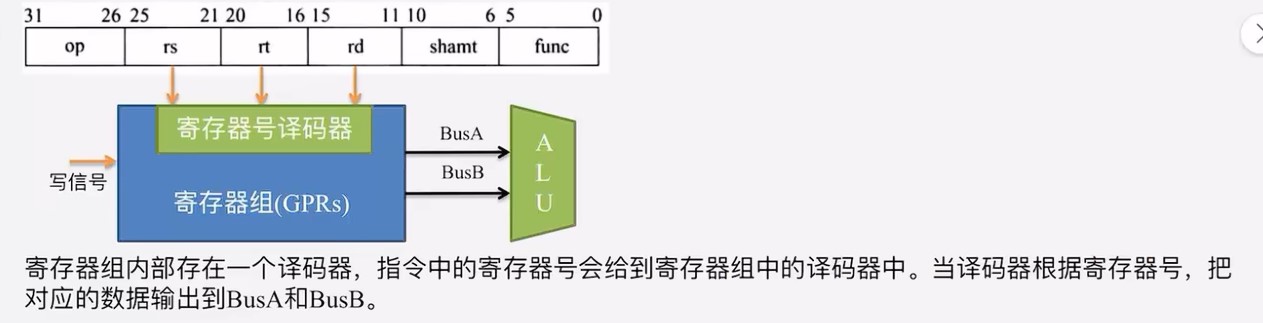

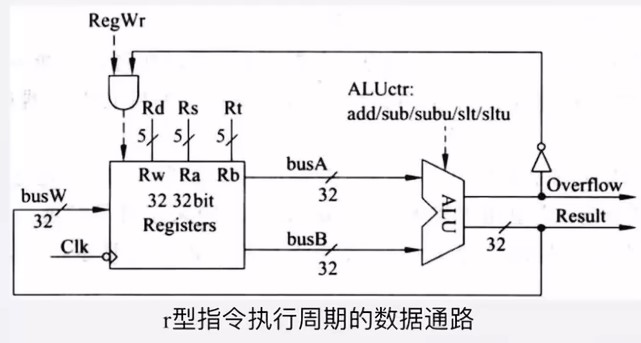

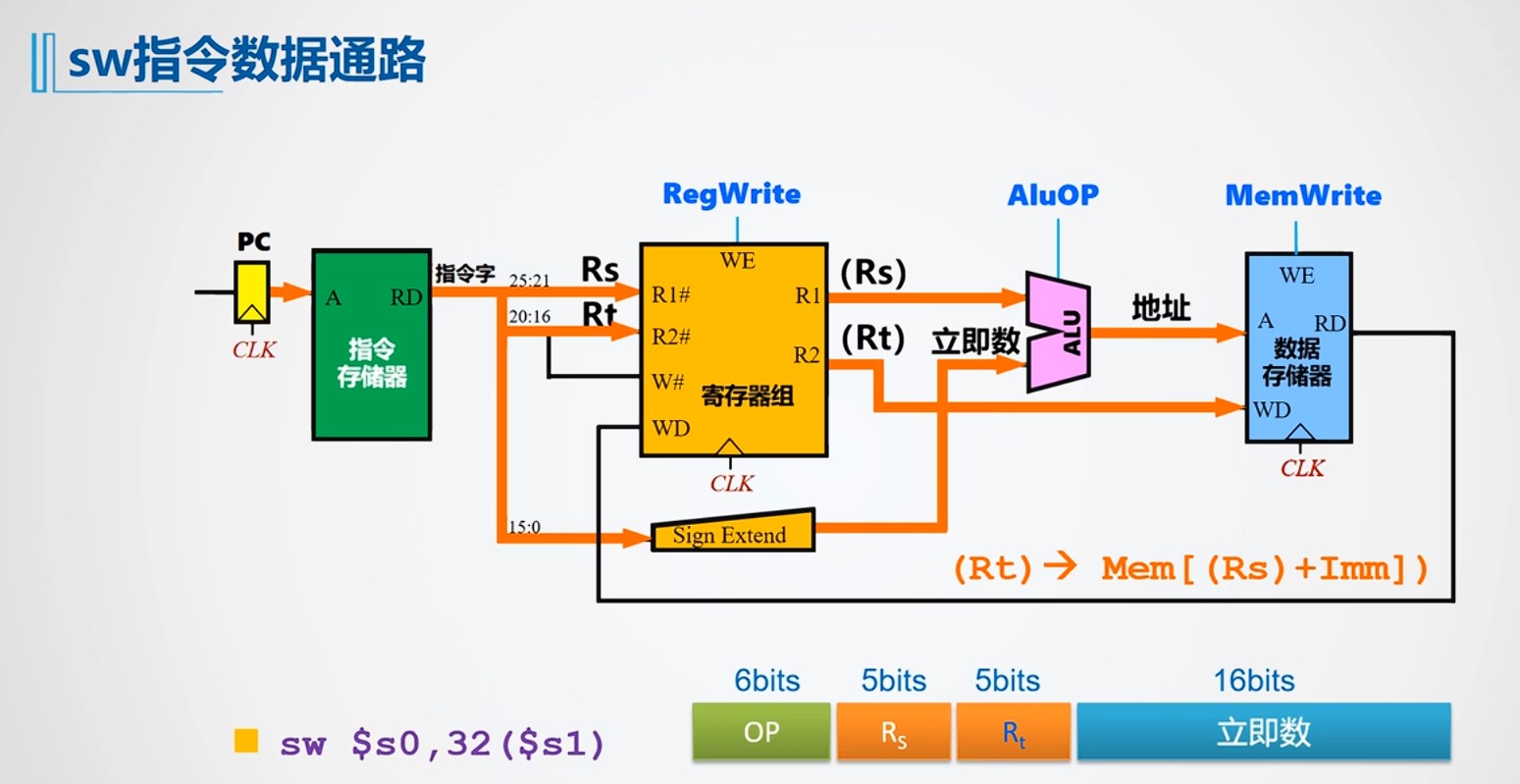

寄存器组的作用:同时提供两路读一路写

- 图中Rs,Rt前面的25:21是指指令中读取哪几位,根据指令格式,对应的是寄存器的编号

-

寄存器组(Register File)

R1#、R2#:读端口寄存器号(由指令的 rs、rt 字段决定)。R1、R2:对应的 Read Data(RD),即读出的源操作数。W#:写寄存器号。WD:Write Data,要写回目标寄存器的内容。

数据存储器(Data Memory)

A:访问地址。RD:Read Data,存储器取出的内容(比如 lw 指令读出的数据)。WD:Write Data,要写进存储器的内容(比如 sw 指令写进去的寄存器值)。

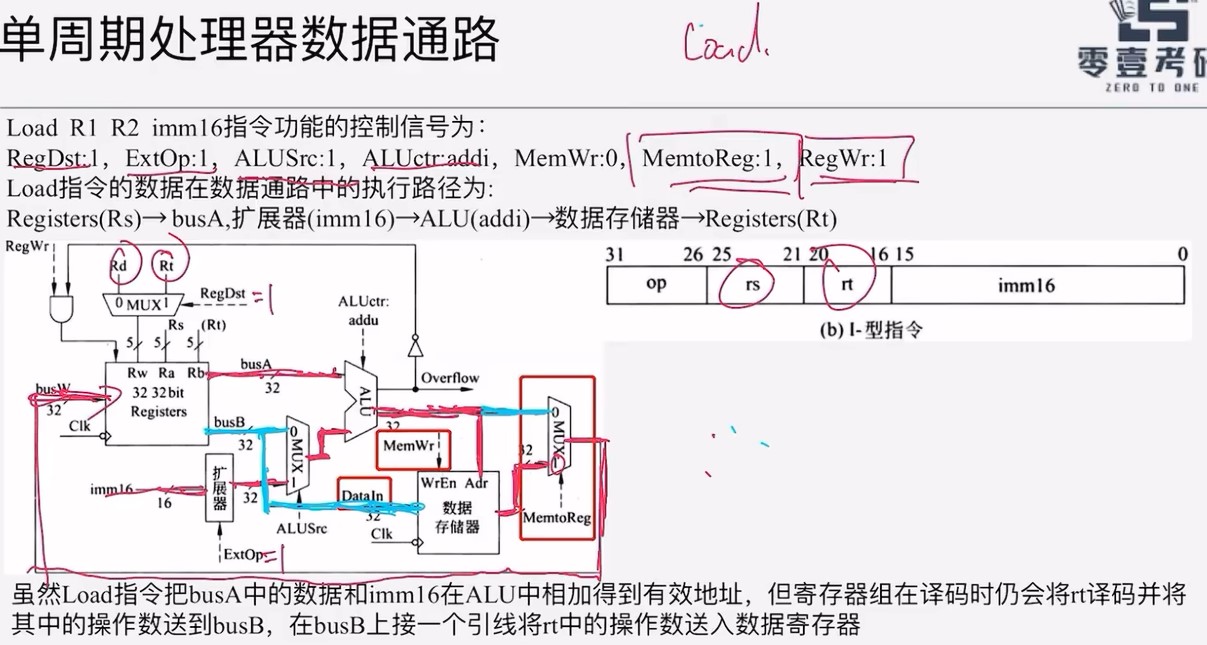

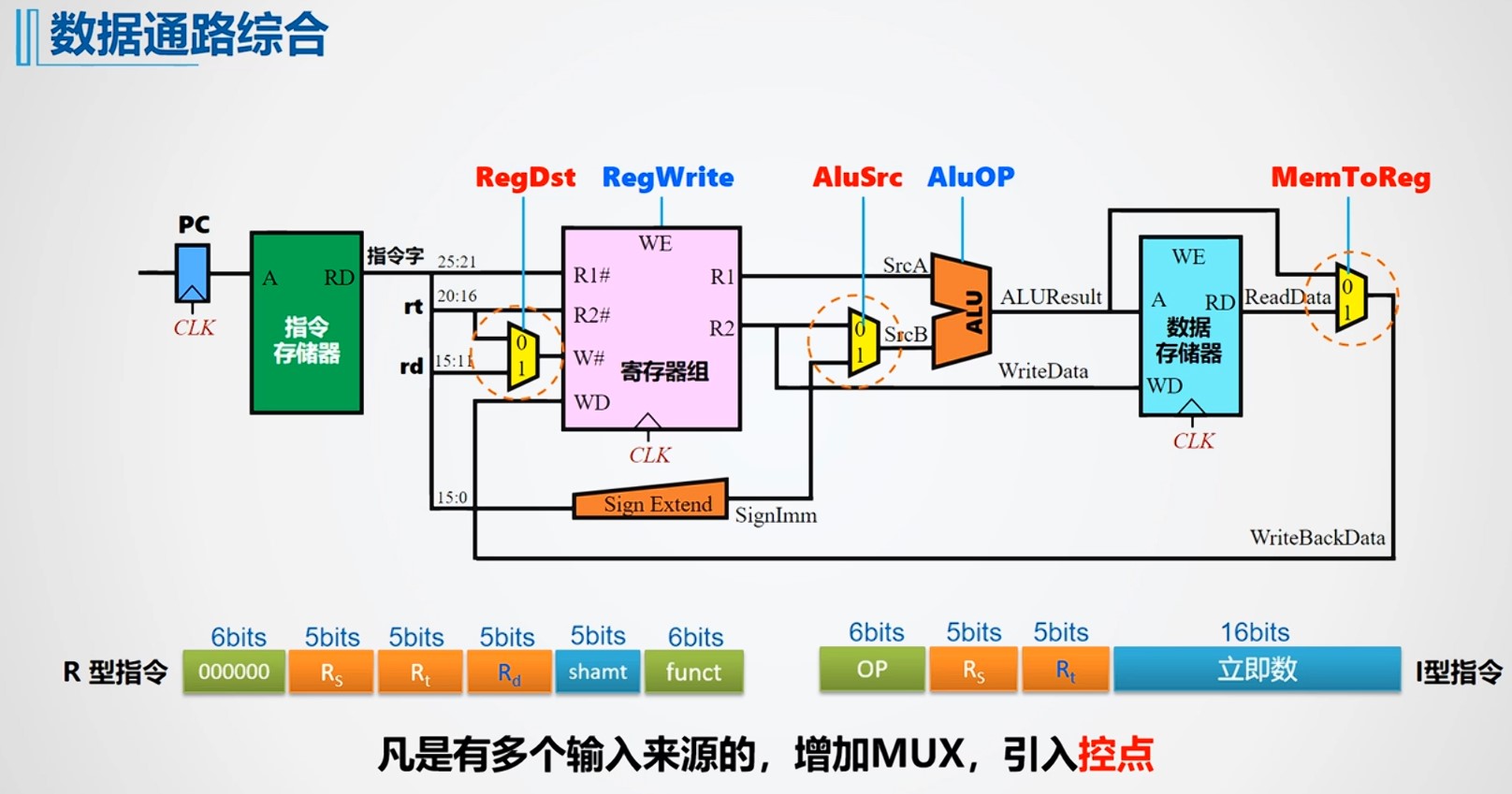

- RegDst:由于在I型指令和R型指令中,目的寄存器的不同,所以当数据通路综合的时候,需要一个MUX多路控制器控制选择RD还是RT作为写入寄存器编号

- AluSrc:第二个操作数既可能来自寄存器也可能是操作数扩展的结果,因此需要一个多路选择器进行选择

- MemToReg:写回的时候,对应的数据有可能来自数据存储器,也有可能来自ALU的运算结果,因此需要一个多路选择器

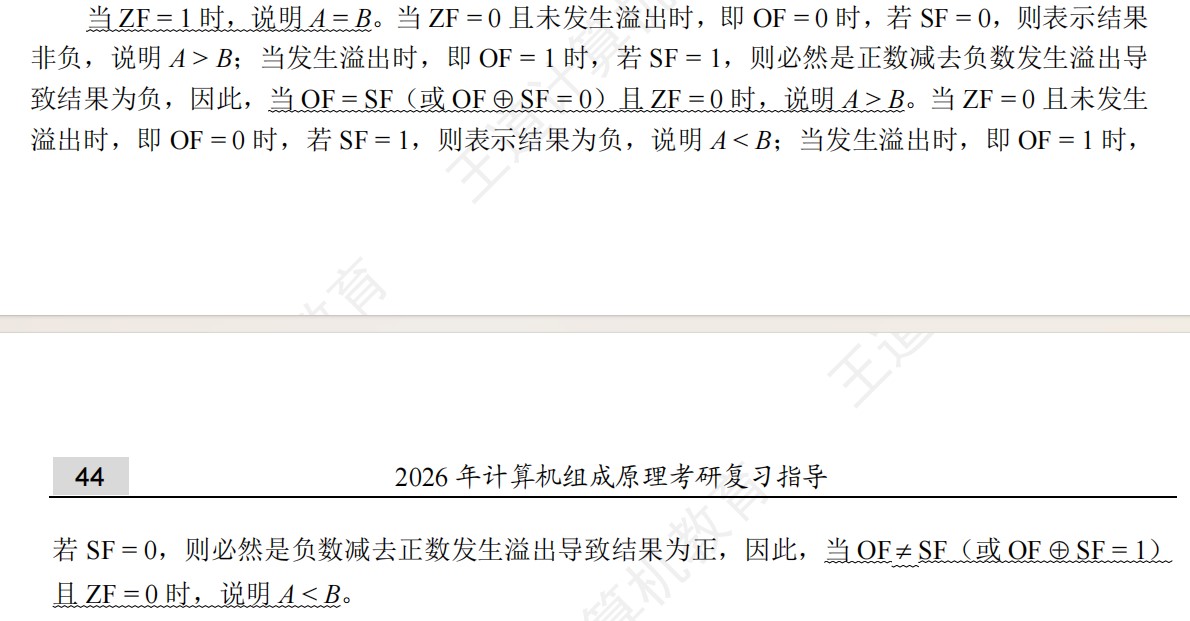

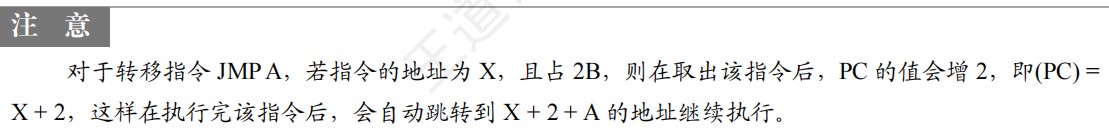

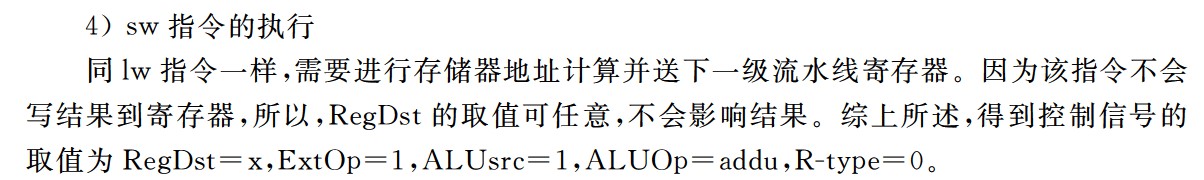

单周期数据通路指令的运算/时钟周期的选择

单周期数据通路延迟参数统一总结如下(取指/数据存储器=3ns;ALU/加法器=2ns;寄存器读=1ns;寄存器写=1ns;忽略MUX/控制/传输延迟)。

| 指令类型 | 典型形式 | 执行流程(顺序) | 用时计算 | 总用时 |

|---|---|---|---|---|

| RR型运算(R型) | add rD, rS, rT |

取指(3) → 读寄存器rS,rT(1) → ALU运算(2) → 写回rD(1) | 3 + 1 + 2 + 1 | 7 ns |

| 立即数运算(I型算术) | addi rT, rS, imm |

取指(3) → 读寄存器rS(1) → 立即数符号扩展(≈0,忽略) → ALU运算(2) → 写回rT(1) | 3 + 1 + 2 + 1 | 7 ns |

| Load(取数) | lw rT, off(rS) |

取指(3) → 读寄存器rS(1) → 符号扩展off(≈0) → ALU算有效地址(2) → 读数据存储器(3) → 写回rT(1) | 3 + 1 + 2 + 3 + 1 | 10 ns |

| Store(存数) | sw rT, off(rS) |

取指(3) → 读寄存器rS,rT(1) → 符号扩展off(≈0) → ALU算有效地址(2) → 写数据存储器(3) | 3 + 1 + 2 + 3 | 9 ns |

| Branch(条件分支) | beq rS, rT, off |

取指(3) → 读寄存器rS,rT(1) → ALU比较/零检测(2) → 加法器形成分支目标地址(2) | 3 + 1 + 2 + 2 | 8 ns |

| Jump(无条件跳转) | j target |

取指(3) → 形成目标地址/更新PC(拼接/移位,忽略延迟) | 3 | 3 ns |

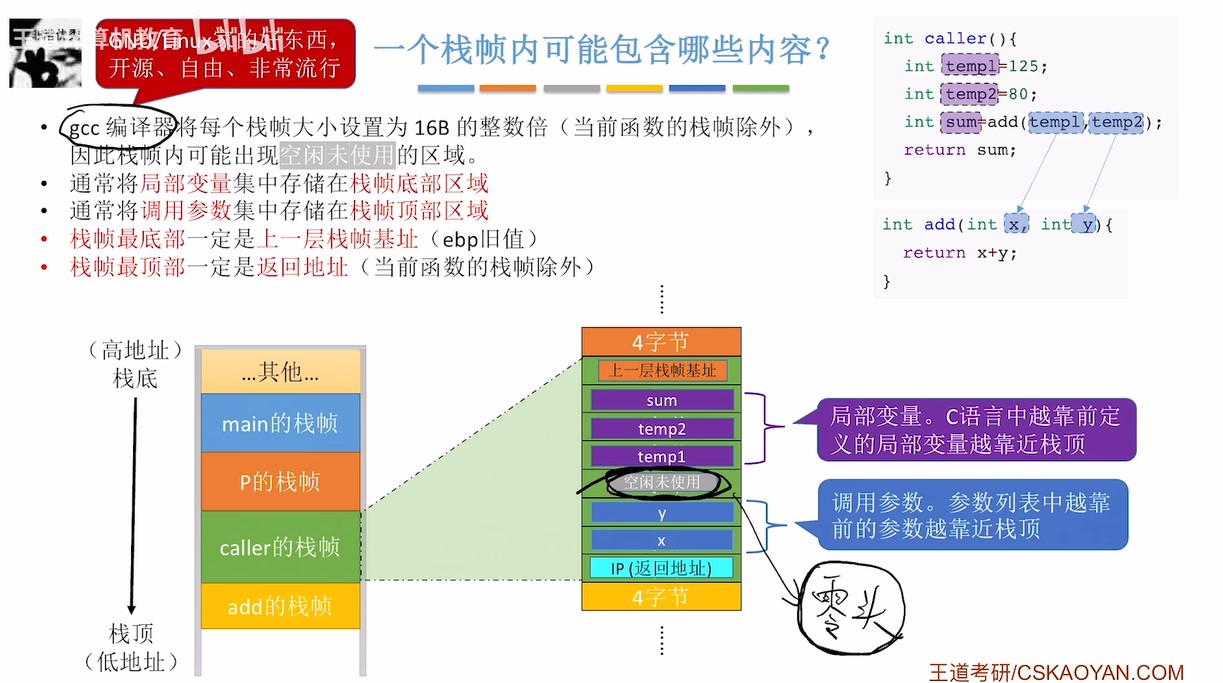

时钟信号

.png)

数据通路和控制器的组成

| 分类 | 部件 |

|---|---|

| 数据通路 | ALU、通用寄存器、状态寄存器、Cache、MMU、浮点运算逻辑、异常和中断处理逻辑 |

| 控制部件 | PC、IR、ID、MAR、MDR、控制单元(CU)、时序信号产生部件 |

可见/不可见

- 写代码的时候感觉不到它的存在的,就是不可见的,如何实现我们不知道,那就是不可见的

硬件指令周期

指令流水线

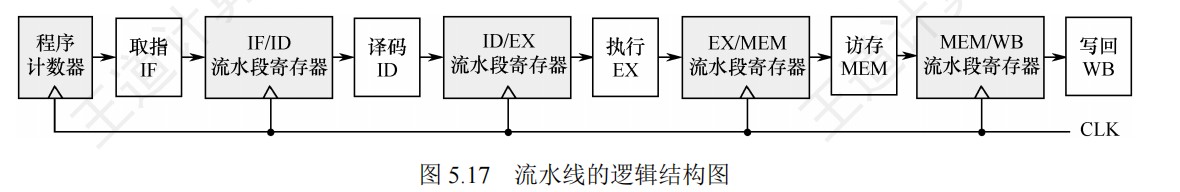

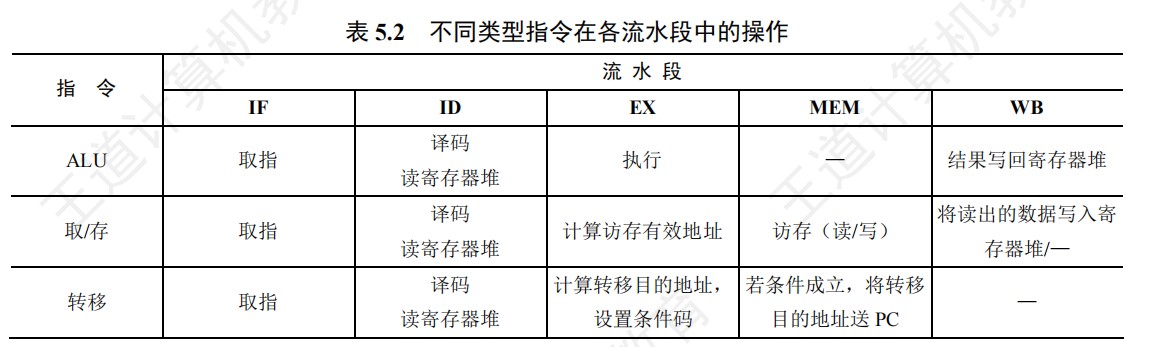

-

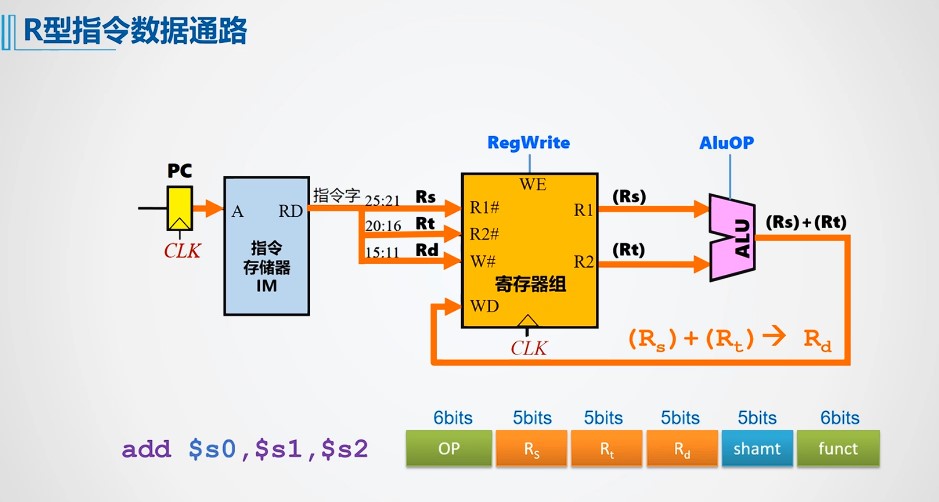

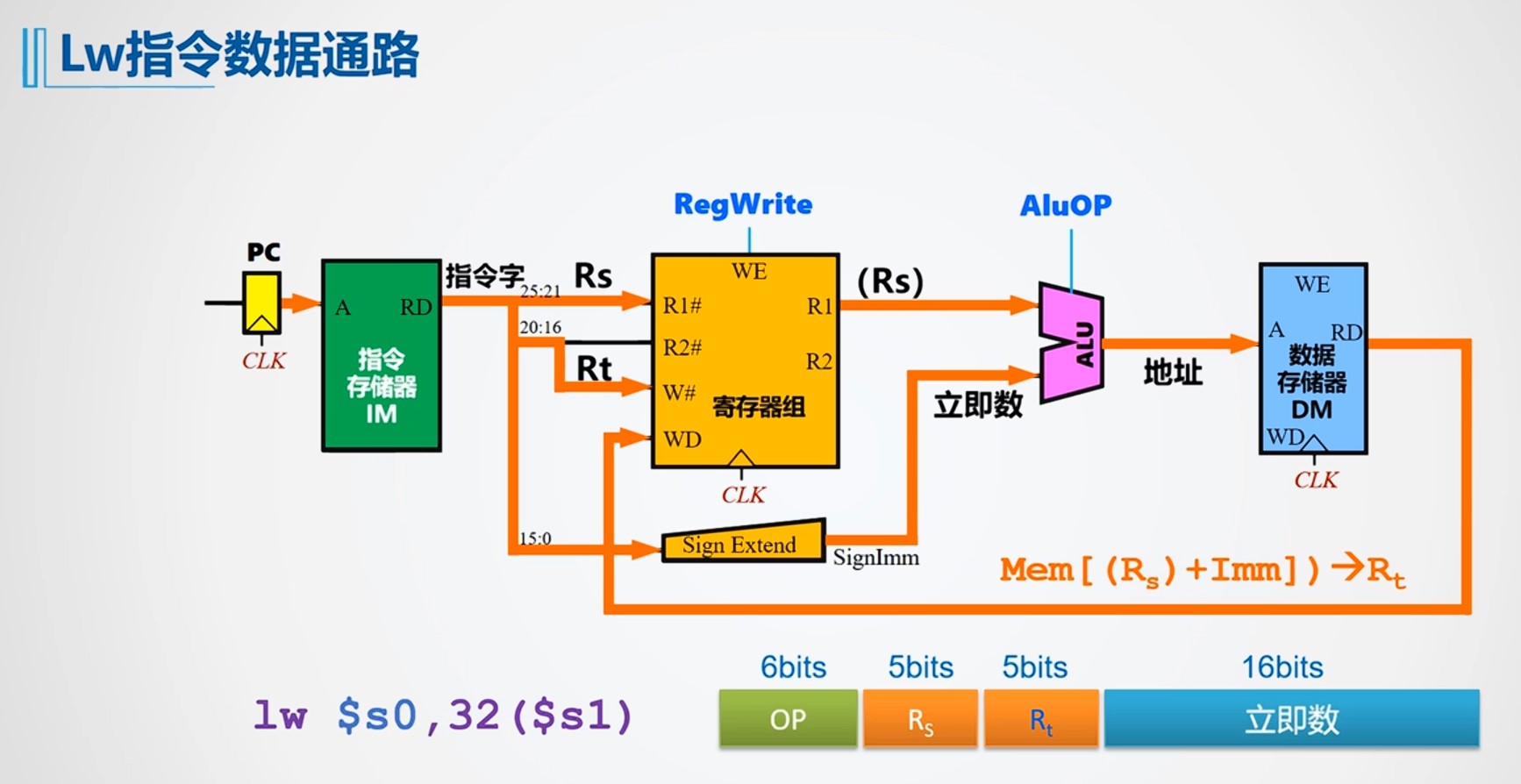

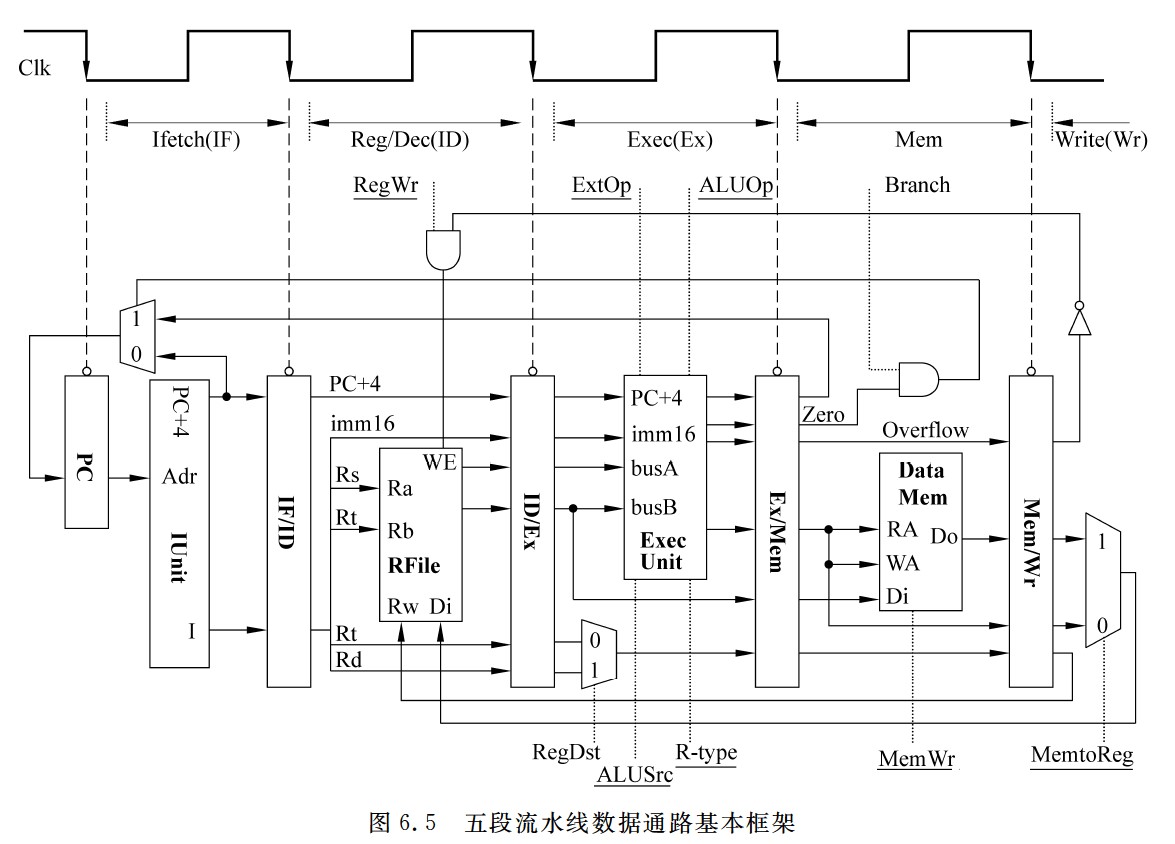

指令流水线一般指RISC即MIPS架构的指令周期,所以除了Lw和Sw指令在M阶段访问内存,其他阶段的取数都是在寄存器中获取,结果写回寄存器

-

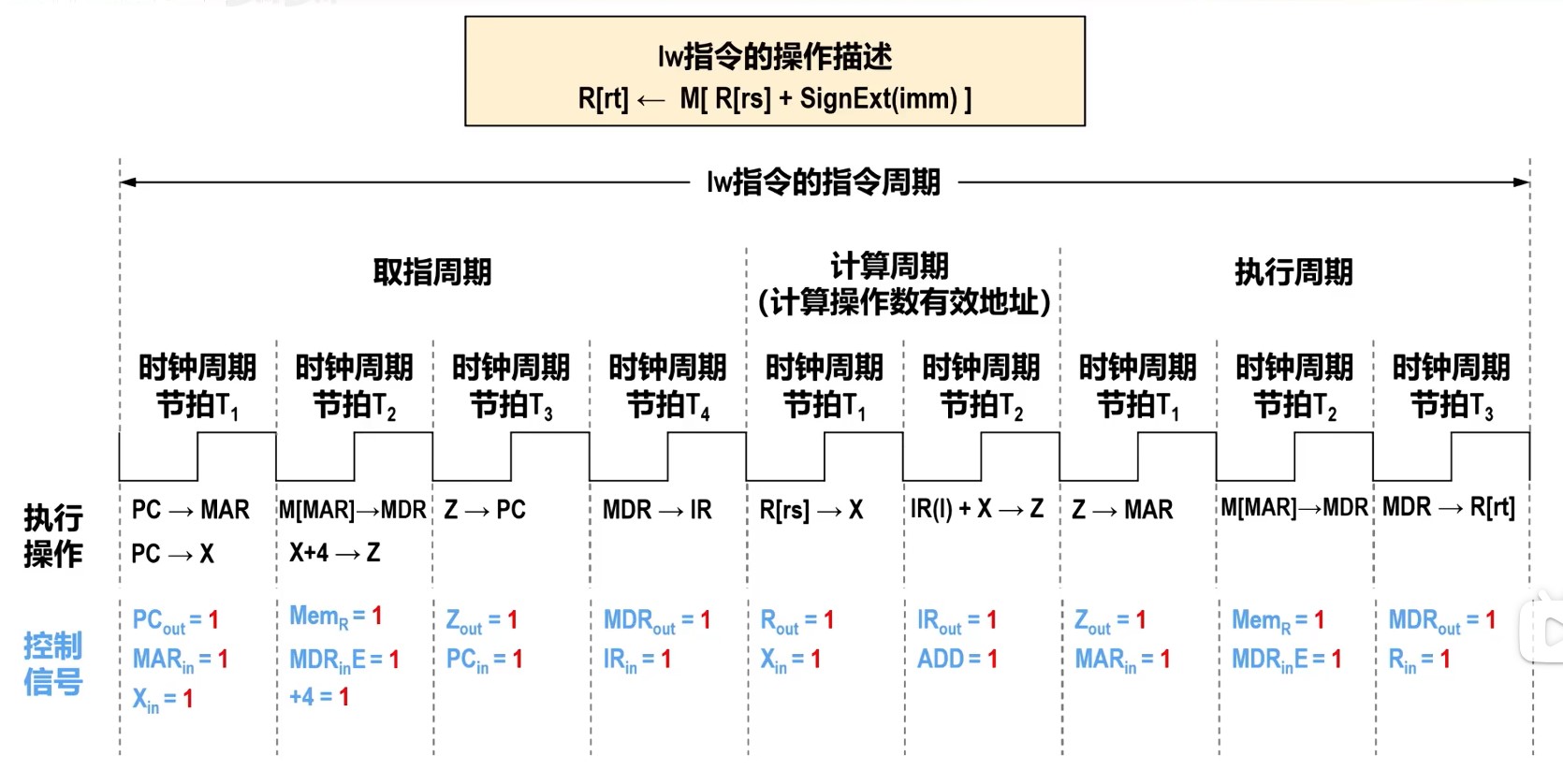

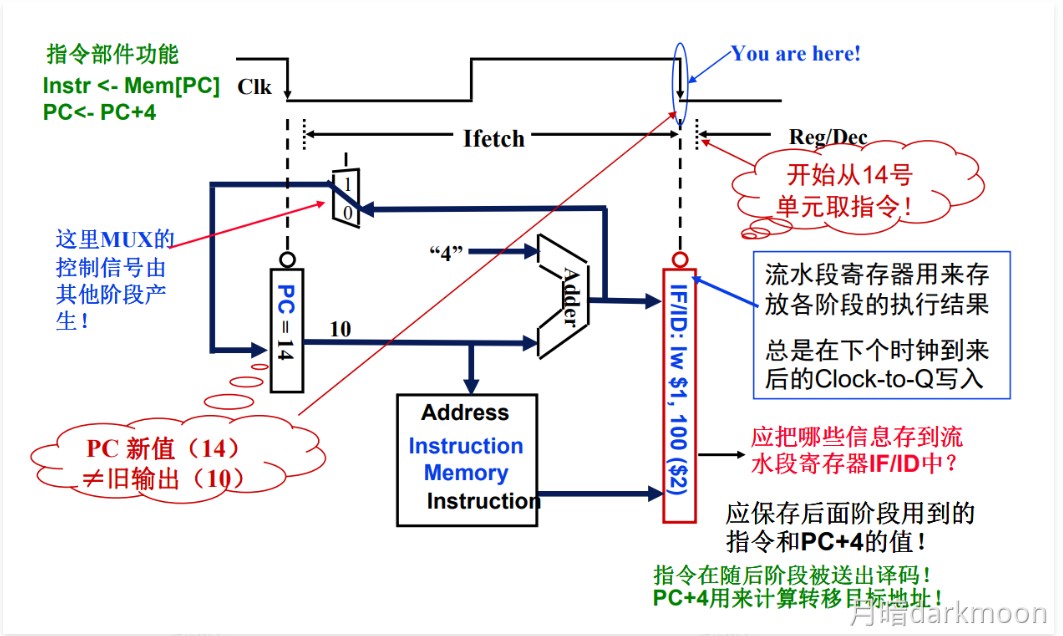

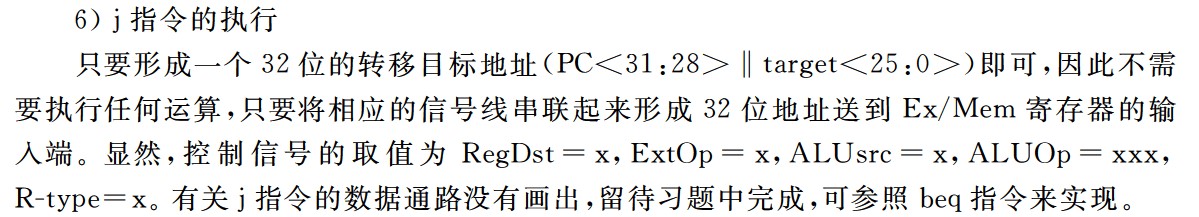

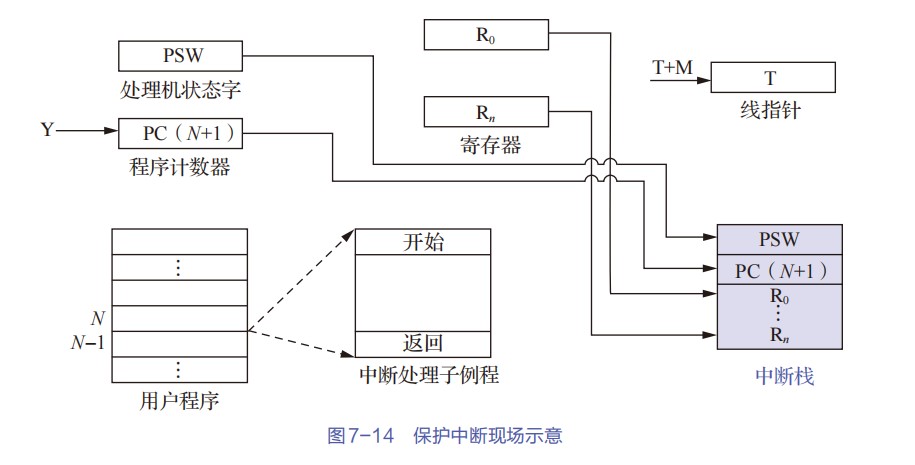

指令流水线的五个阶段功能

-

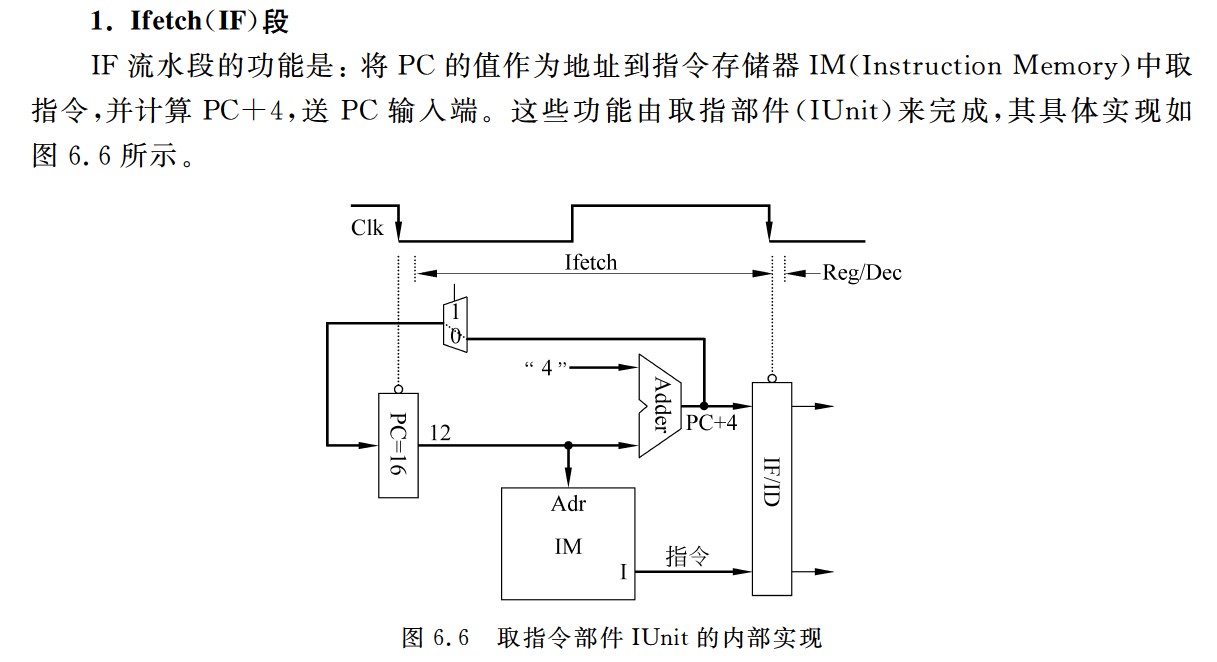

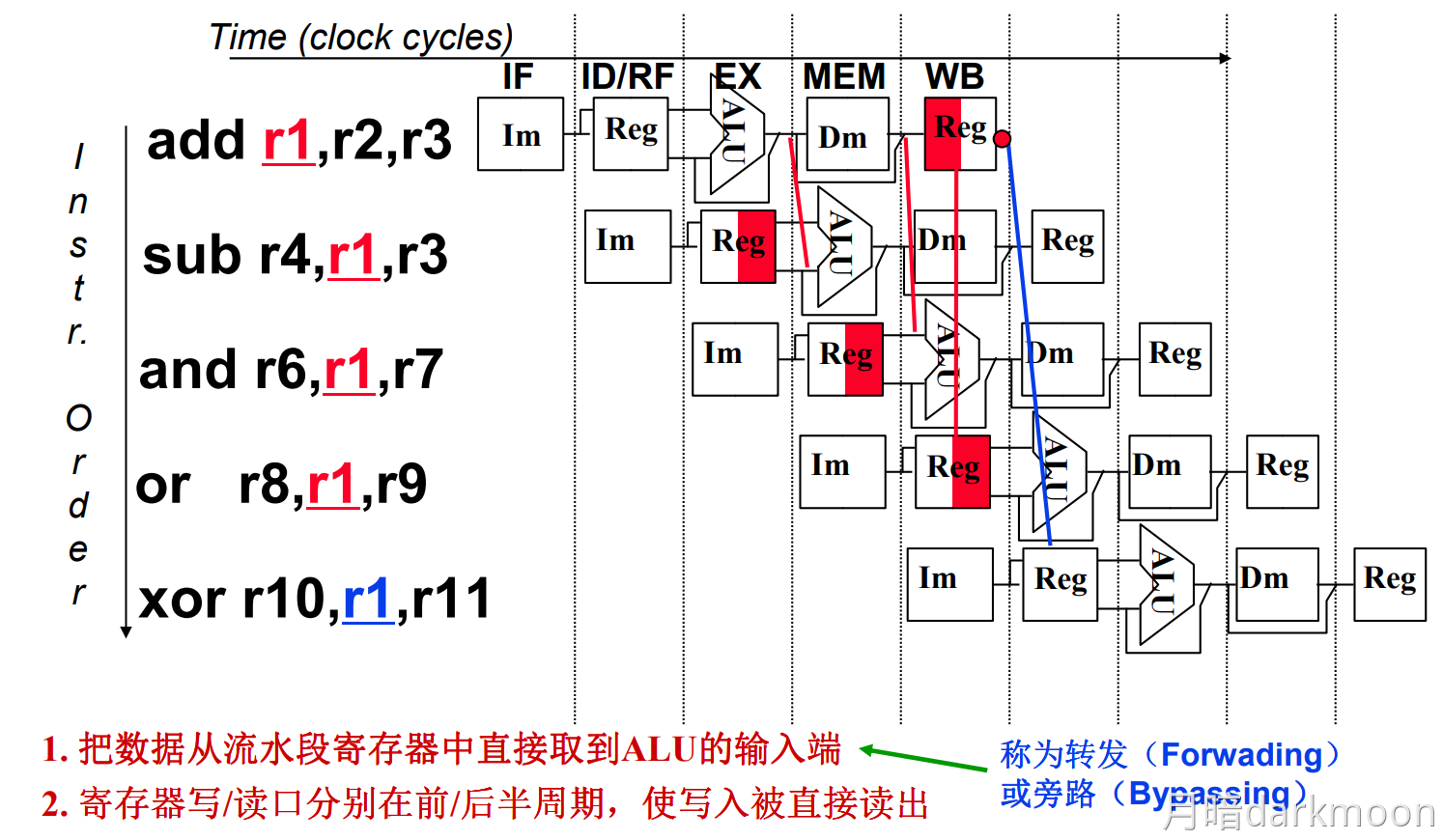

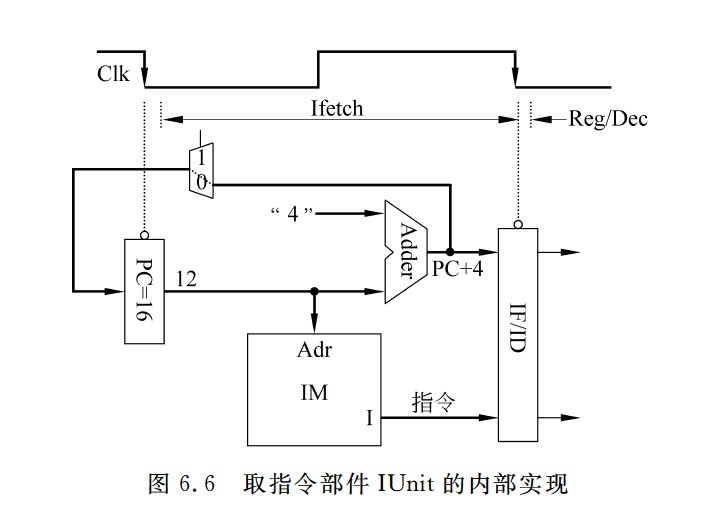

取指(IF):从指令存储器或Cache中取指令

- IF-ID寄存器中需要保存的结果:

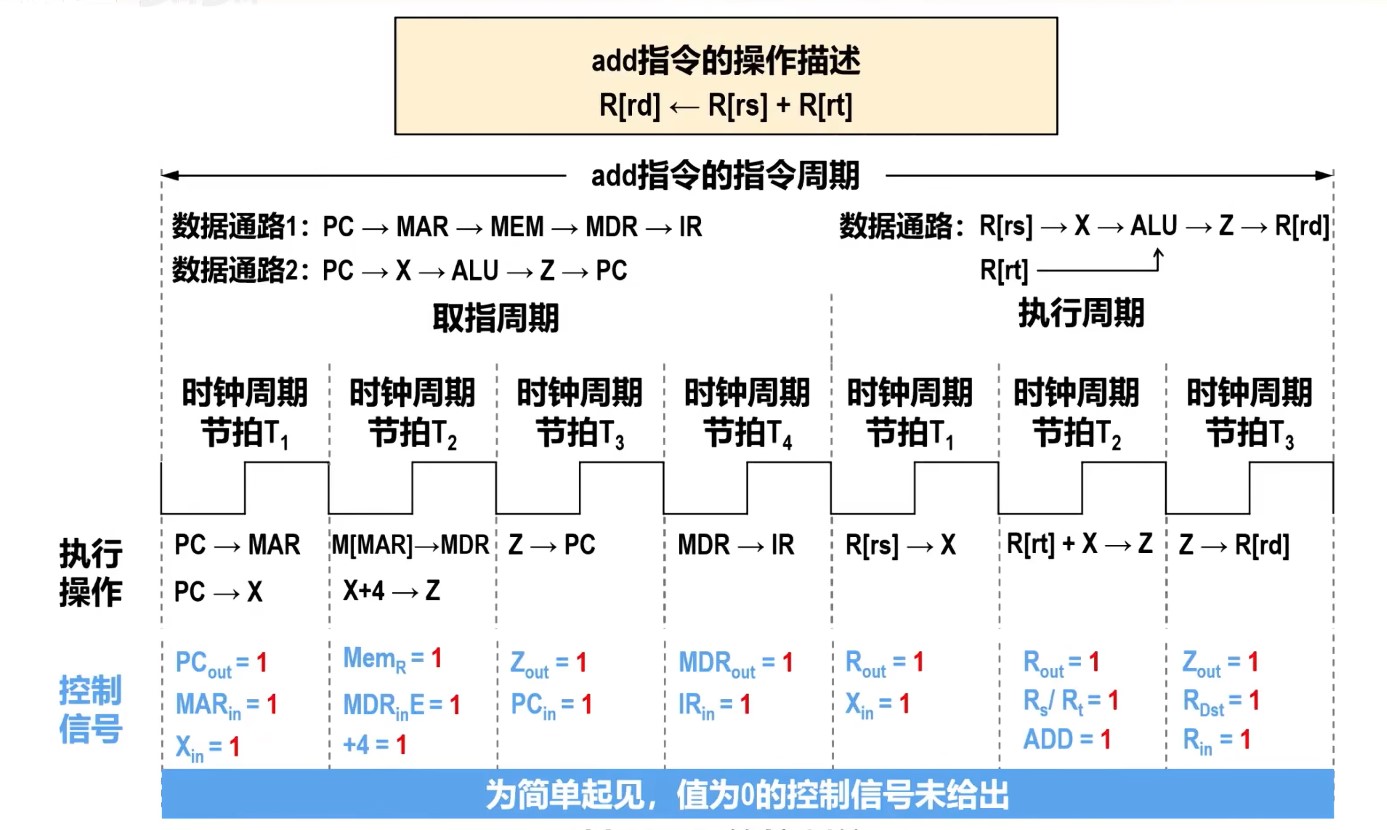

- 从IM中取出的指令

- 如果是分支指令,PC+4的值要在后面用来计算相对地址,因此也要保存。

- 多路选择器MUX的控制端,在Mem阶段产生的Branch信号和Zero标志来控制

- branch信号只有在对分支指令beq译码后才取值为1,其他情况下,branch总是为0

- 在执行beq指令时,在M段将得到转移目标地址,此时,若Zero=1,则将转移目标地址选择送到PC的输入端

- IF-ID寄存器中需要保存的结果:

-

译码/读寄存器(ID):操作控制器对指令进行译码,同时从寄存器堆中取操作数

- 也就是说,只有当操作数存在寄存器中的时候,才需要从寄存器中读数,如果是从内存中取数,这一段只是用来取用于地址运算的寄存器里面的数,即下面的计算地址

- 指令本身就不再需要保存在ID/EX寄存器中

-

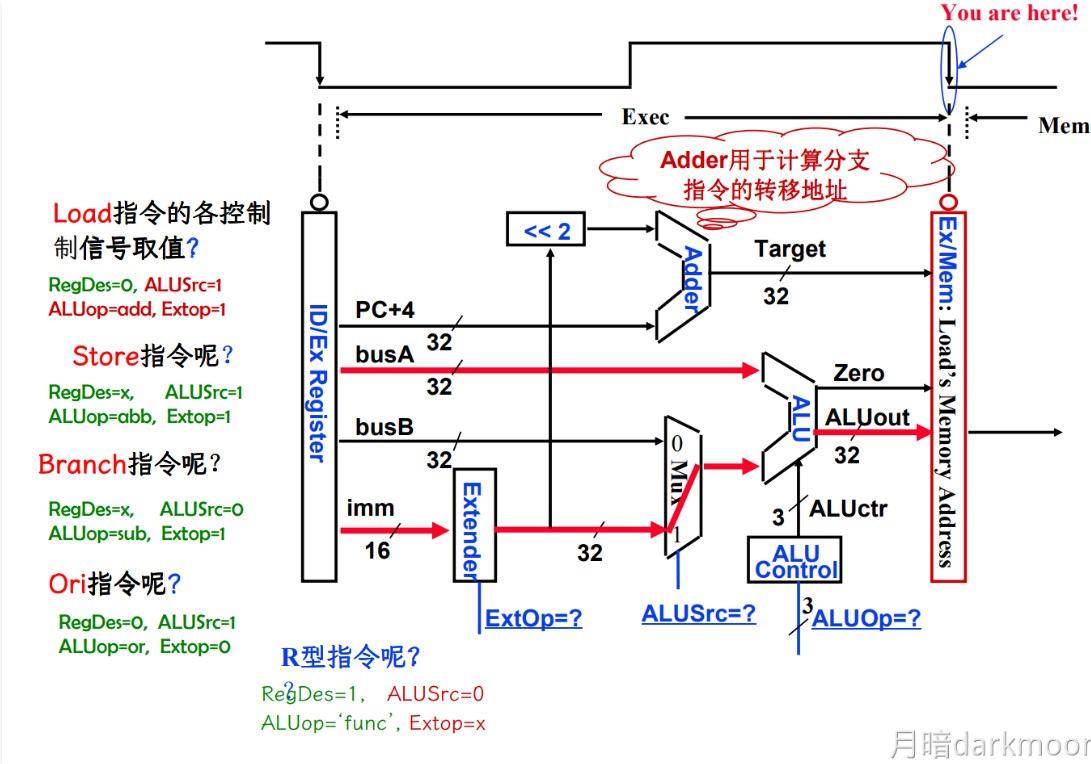

指令/计算地址(EX):执行运行操作或计算地址

-

功能:

- 计算内存地址

- 计算转移目标地址

- 一般ALU计算

-

控制信号

-

-

访存(MEM):对存储器进行读/写操作

-

间接寻址中根据EX段计算出来的有效地址,进行访存

-

条件转移指令的情况下,在该阶段将EX段生成的转移目标地址更新到PC中

-

无条件转移指令在该阶段将目标PC值写回PC

-

-

写回(WB):将指令执行结果写回寄存器堆

-

这里的结果写回的是寄存器,取数时也是取回寄存器

-

读寄存器发生在ID(译码/读寄存器),写寄存器发生在WB(写回)

-

-

-

虽然增加流水线级数可能缩短每级延迟,但“必然”提高主频的说法过于绝对。实际中,流水线级数增加会引入额外的寄存器延迟(如建立时间、保持时间),且若各阶段延迟不均衡,最慢阶段仍会限制主频。此外,过深的流水线可能导致控制复杂度上升,反而影响性能。因此,当段数达到一定数量时,流水线技术增加不一定会提高主频了。

-

流水线的时钟周期必须覆盖最慢阶段的延迟(包括组合逻辑延迟和流水线寄存器延迟),否则会导致数据无法正确传递。因此,CPU的最高频率由流水线中最关键路径(即延迟最大的阶段)决定。

-

流水线技术的核心优势在于提高吞吐率(单位时间内完成的指令数),而非减少单条指令的执行时间。由于流水线寄存器延迟的存在,单条指令的总执行时间可能反而略有增加(如从单周期变为多周期)。虽然主频提高可能缩短时钟周期,但单条指令仍需经历多个阶段,其总执行时间并未减少

-

流水线级数的核心思想正是通过指令级并行(ILP)实现多条指令的不同阶段同时执行。

-

控制冲突的情况下,比较指令在EX阶段通过计算设置条件码,并在MEM阶段确定是否将PC值更新为转移地址

-

Cache缺失的处理过程也会引起流水线阻塞

-

超流水线CPU的CPI=1,但主频更高

-

多发射流水线CPI<1,但成本更高、控制更复杂

-

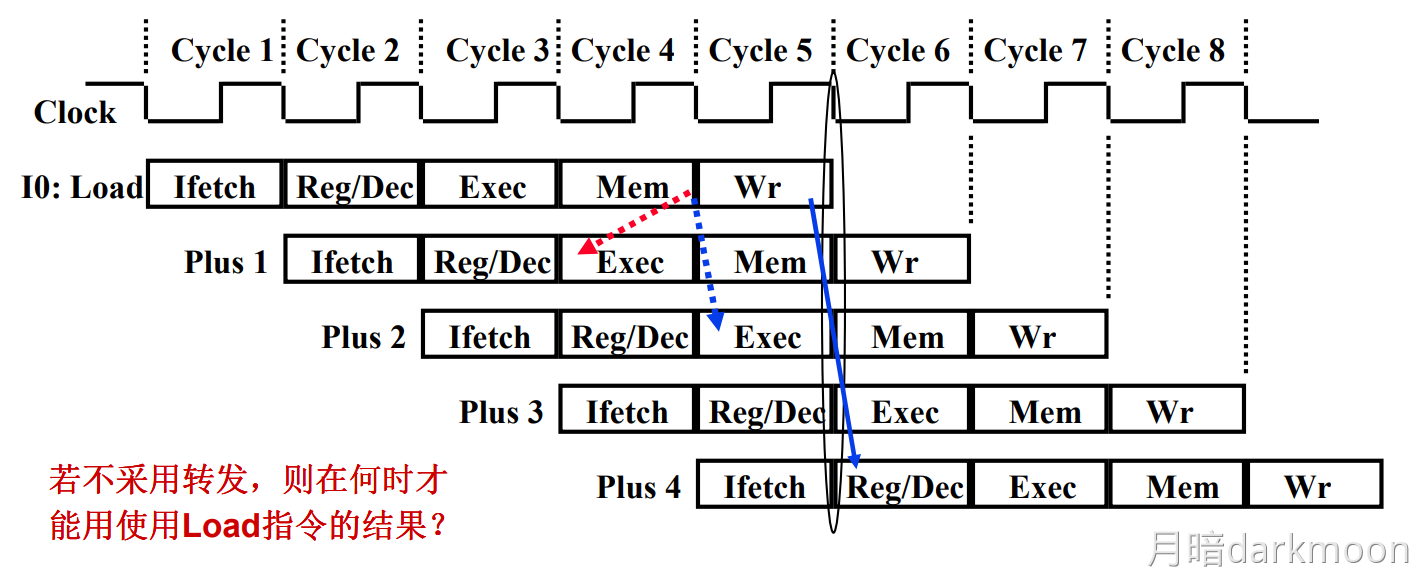

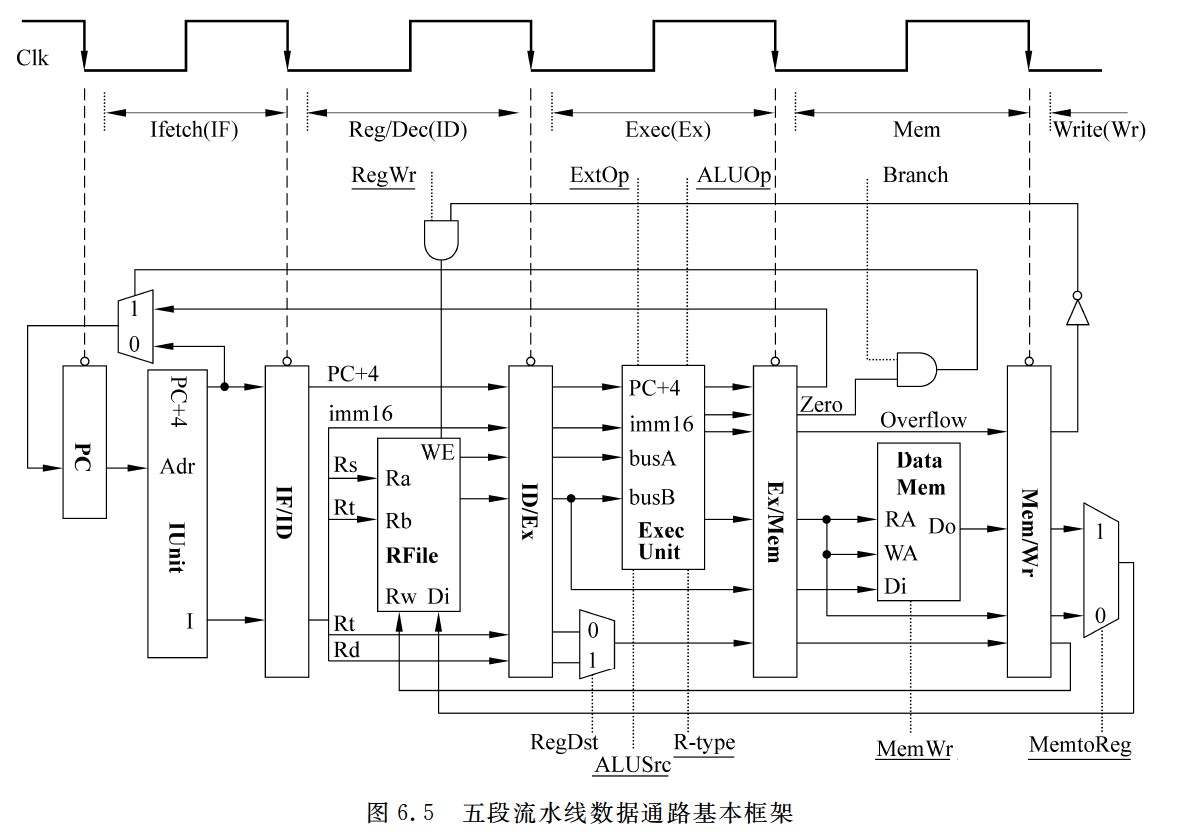

指令译码得到的控制信号需要通过流水段寄存器传递到下一个流水段,每个流水段之间的寄存器位数不一定相同,流水段寄存器对用户透明

-

避免结构冒险的基本做法是使每个指令在相同流水段中使用相同的部件

- 解释:Load指令在第四个时钟周期即它的M阶段使用DM;同样在第四周期,下一条指令在EX阶段,仅使用ALU,下下条指令在ID阶段,只用到了存储器堆的写口;由此可见,若遵守每条指令在相同流水段使用相同部件,这样可以保证在同一个时钟周期下,由于各指令分别处于不同的流水段,因此不会使用到同一个部件。

-

PC和各个流水段寄存器都没有写使能信号,因为每个时钟都会改变PC的值,所以PC不需要写使能控制信号。

- 每个流水段寄存器在每个时钟都会写入一次,因此,流水段寄存器也不需要写使能控制信号。

- 前两个流水段的功能每条指令都相同,是公共流水段,因此,也不需要控制信号

-

结构冒险对浮点运算的性能影响较大,控制冒险更多出现在整数运算程序中

-

超标量技术通过指令相关性检测和动态分支预测手段,当指令阻塞时,可以到后面找指令来执行

- 超标量技术不依赖于编译器,主要靠硬件在执行过程中优化

-

指令预取

- 在指令执行前,预先把指令取到CPU的指令缓冲器中。这样,在指令执行时,不需要再去取指令,可以很快地直接执行指令。流水线指令执行方式通常采用指令预取。

-

超流水线技术时间上并行

-

多发射技术空间上并行

-

五段式流水线CPU的时钟周期=最长的功能部件时间+流水段寄存器的时间

五段流水线数据通路基本框架

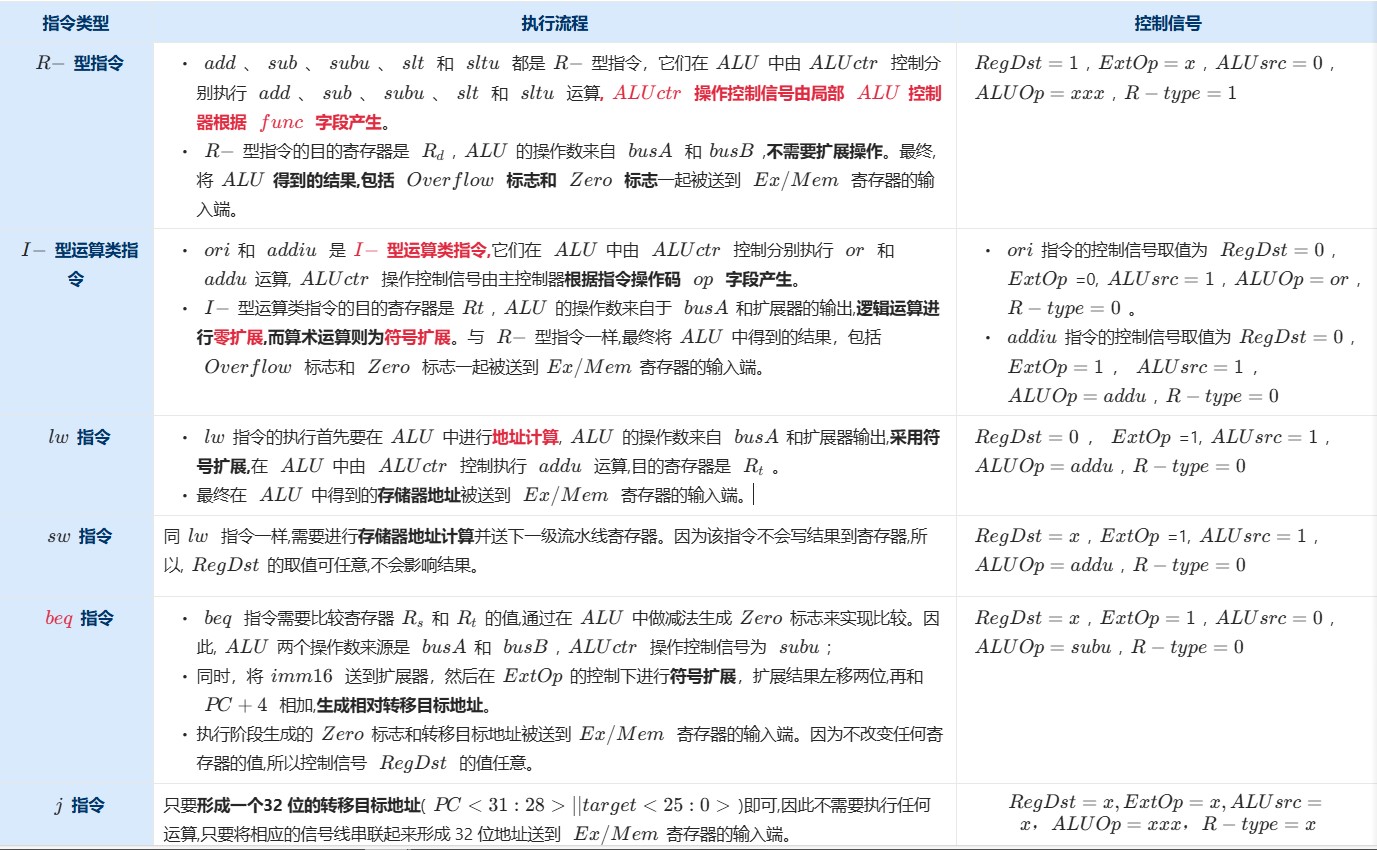

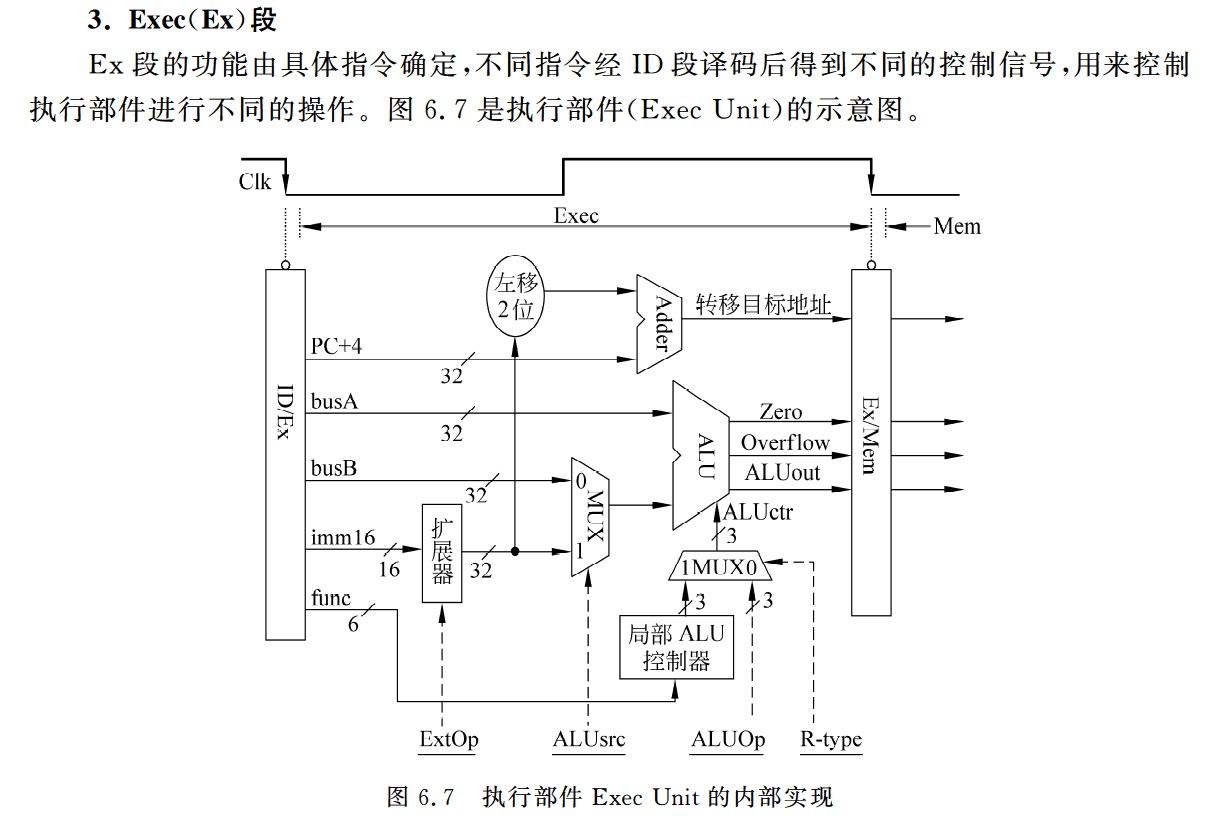

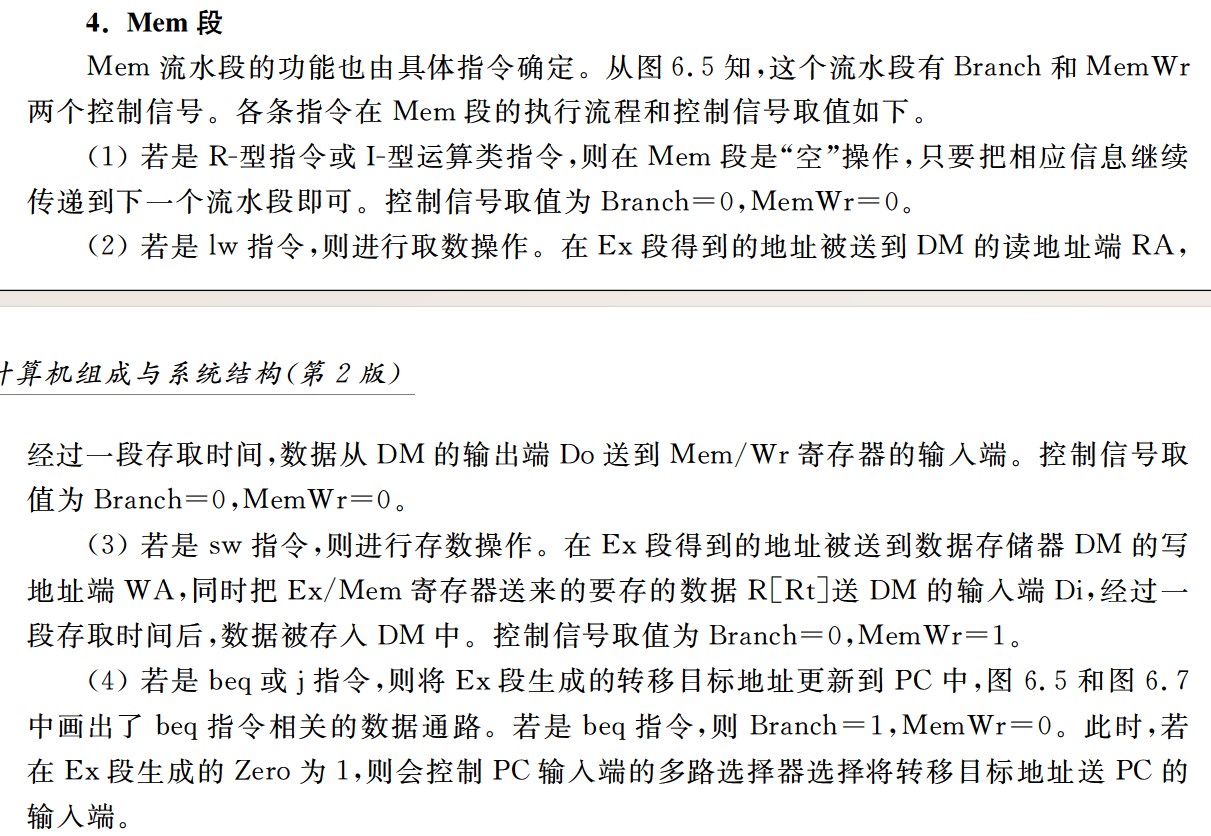

- 图6.5中给出了数据通路用到的所有控制信号,用点虚线连到所控制的功能部件。可以看出,PC和各个流水段寄存器都没有写使能信号。这是因为每个时钟都会改变PC的值,所以PC不需要写使能控制信号;每个流水段寄存器在每个时钟都会写入一次,因此,流水段寄存器也不需要写使能控制信号。此外,前两个流水段的功能每条指令都相同,是公共流水段,因此,也不需要控制信号。其余段的控制信号如下。

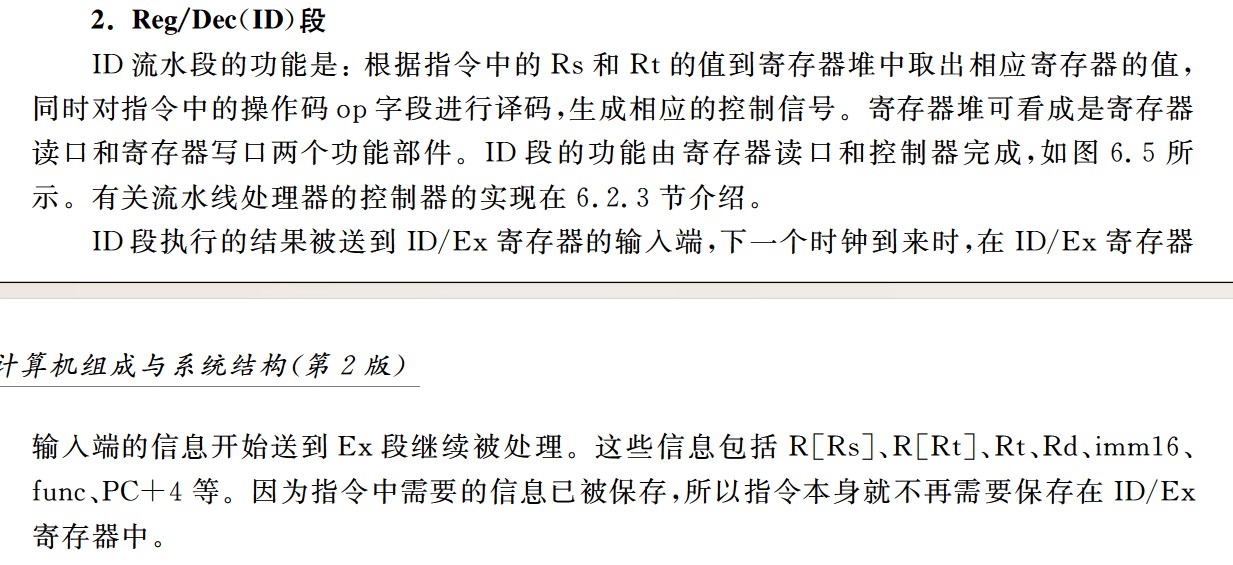

- Exec段的控制信号有以下5个。

IF

ID

EX

R-型指令

I-型运算类指令

lw/sw指令

beq指令

j指令

M

WB

数据冒险

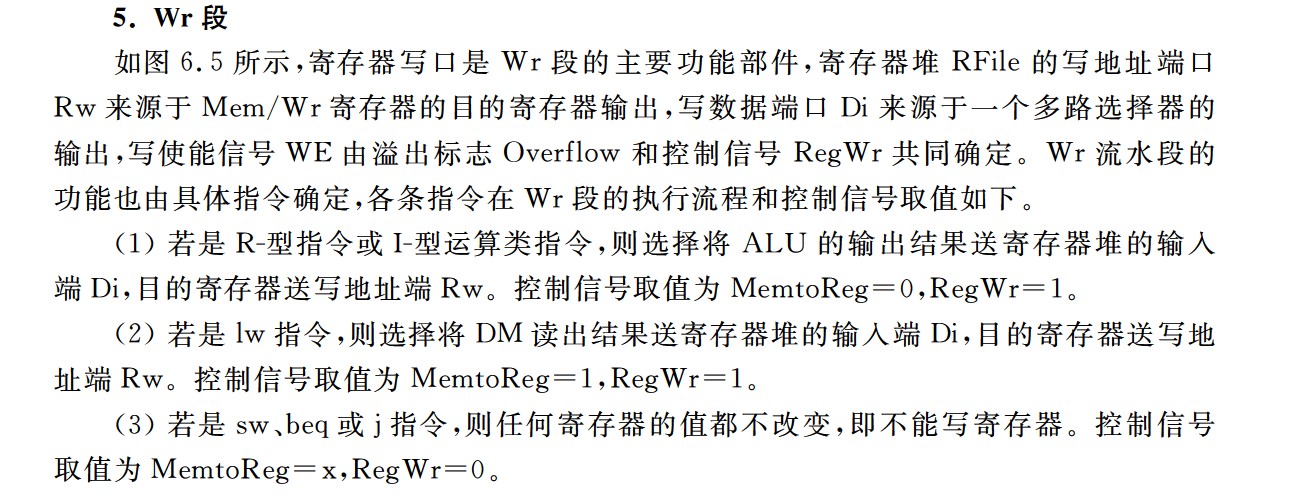

-

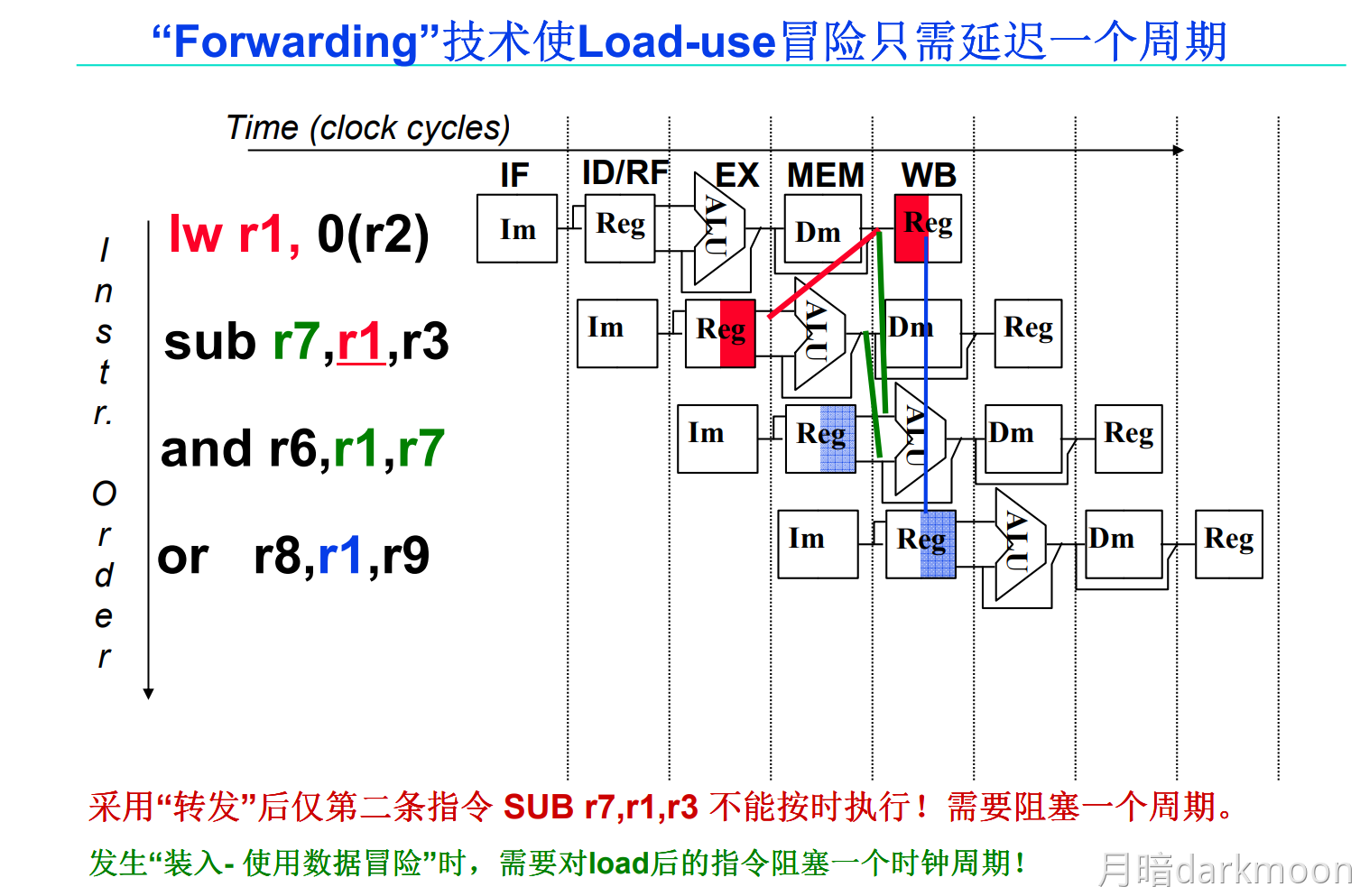

旁路转发技术和load-use冒险:

- load指令在第四周期即M访存阶段结束时,数据在流水段寄存器中已经有值,在此时可以采用数据转发技术可以使load指令后面第二条指令得到所需的指,但不能解决load指令和随后的第一条指令之间的数据冒险,要延迟执行一条指令

- 普通数据冒险采用旁路转发技术不需要阻塞,而load-use需要阻塞一个时钟周期的根本原因是所需数据产生的阶段不同,使用ALU计算获得结果(所需数据)的在EX阶段可以产生所需数据,而load指令在M阶段从内存中获取所需数据

- load指令中的ID和EX是在获取所需数据的内存地址,M访存获得所需数据

-

lw指令:从内存中读取一个字,并将其放在一个寄存器中

sw指令:将一个寄存器中的字写入内存中

控制冒险

-

分支延迟槽

在分支指令后面,通常会有一个或多个 延迟槽,用来放置那些 与分支指令无关 的指令。这样,即使 分支指令 会影响程序的执行流,延迟槽中的指令仍然可以按顺序执行,从而有效地利用流水线,减少停顿。

-

静态预测一般是默认不跳转

指令流水线的实现

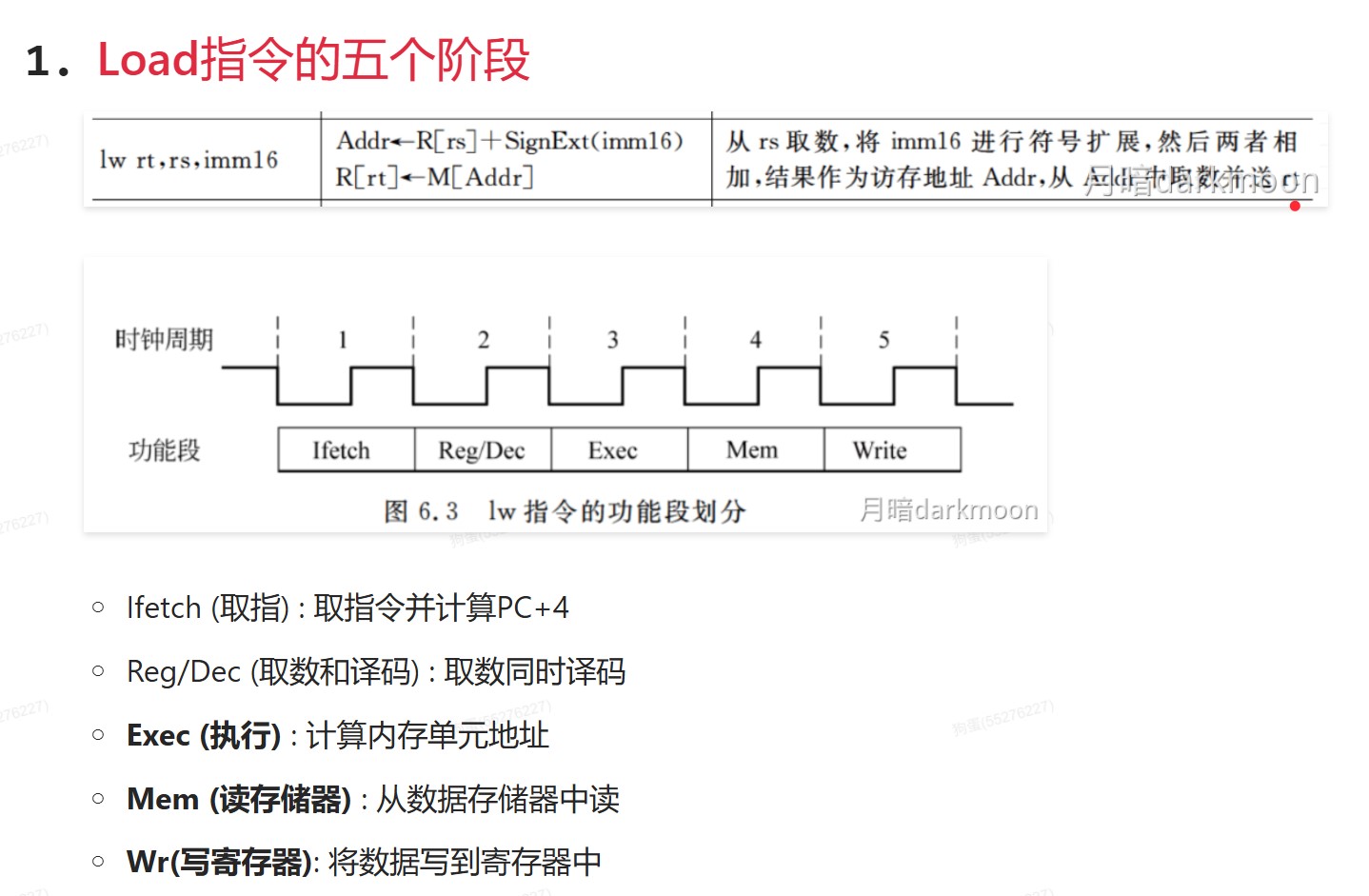

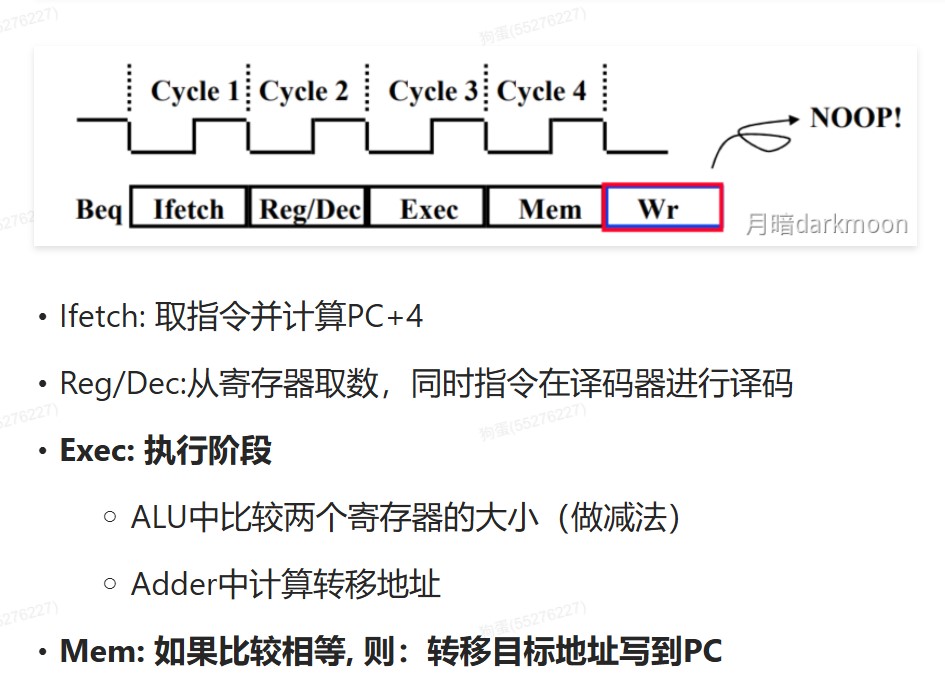

- Load指令的五个阶段

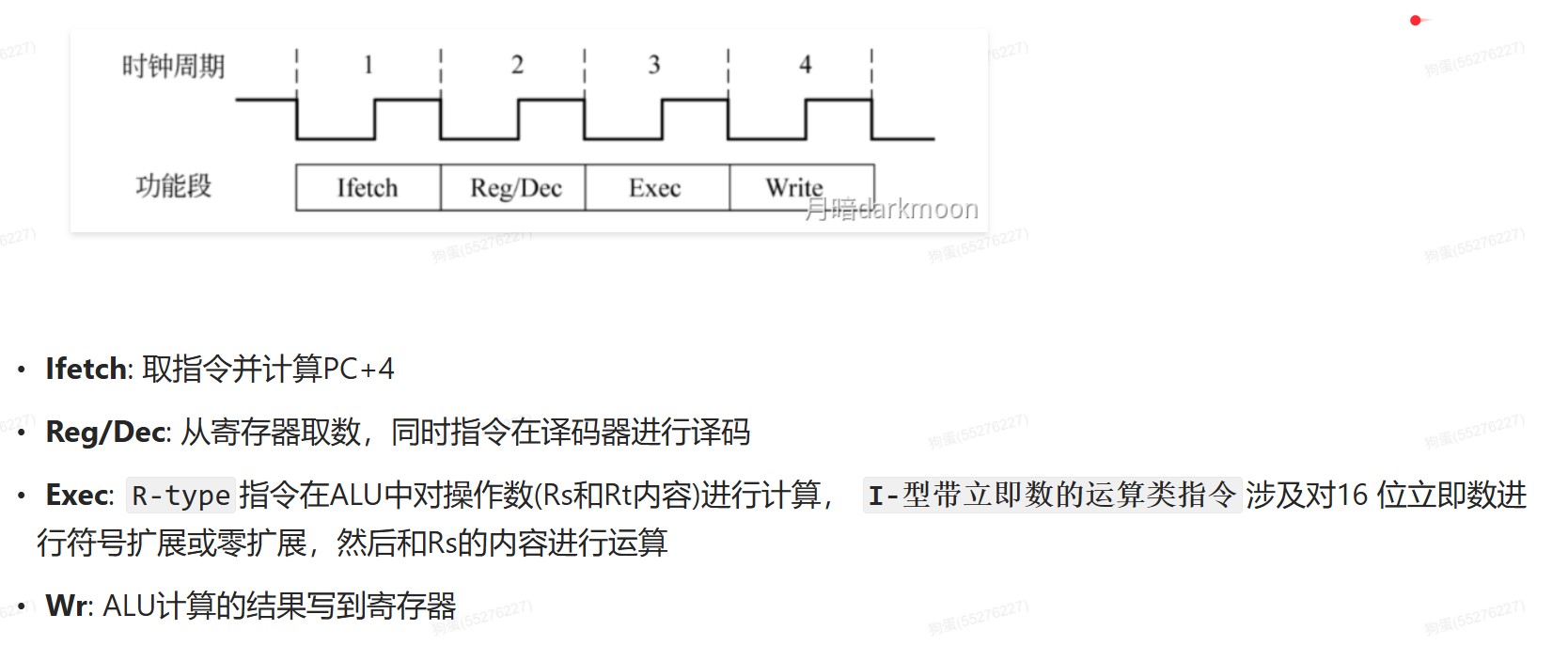

- R和I型运算类指令的4个阶段

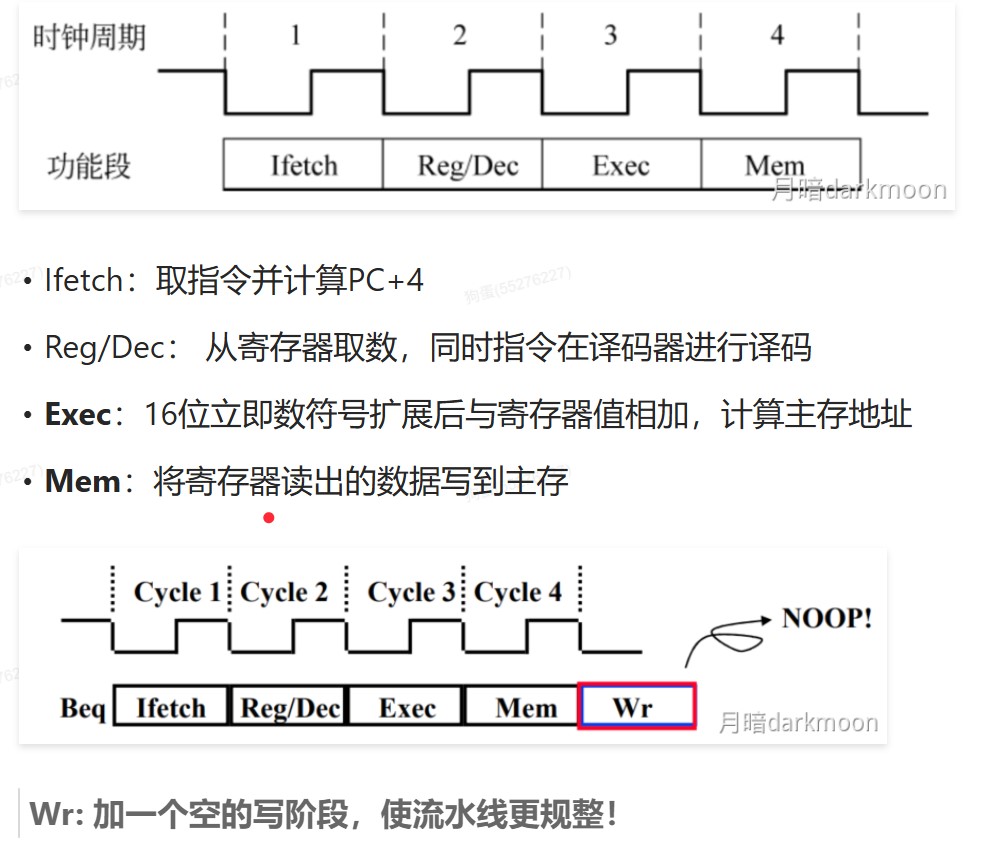

- store指令的四个阶段

- Beq指令

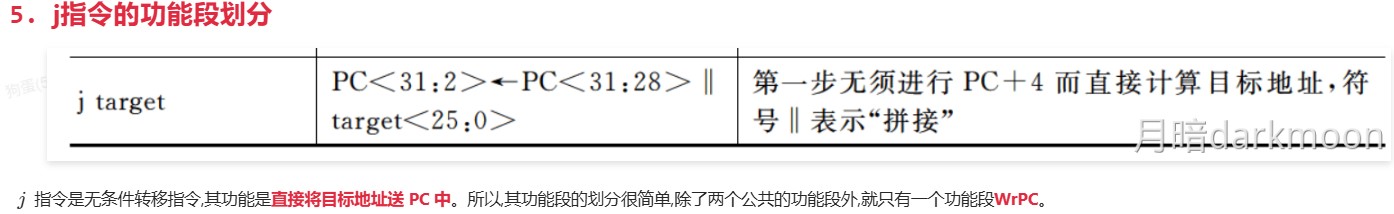

- j指令

总线

- 采用数据/地址总线复用技术,总线中保留数据线,地址经过数据线传输

- 数据总线传输中断类型号

- 地址总线传输I/O端口地址

- 控制总线传输定时信号、总线请求、允许、中断请求、回答、传输确认

- 总线工作频率是指1s内传送几次数据,总线周期=N个时钟周期,则总线的工作频率=时钟周期/N;此外,若一个时钟周期可以传送K次数据,则总线工作频率是总线时钟频率的K倍

- 总线带宽(最大数据传输率)是理想情况(所有总线周期都在传送数据)下,不需要考虑每个总线事务的具体情况,而计算(平均)数据传输率才需要考虑每个总线事务的具体情况

- 总线带宽指总线的最大数据传输率,即总线在进行数据传输时单位时间内最多可传输的数据量,不考虑其他如总线裁决、地址传送等所花的时间

- 总线带宽=总线宽度 x 总线时钟频率 x 每个时钟周期传送数据的次数

- 同步通信仅在数据块的开头和结尾添加开始和结束标记,异步通信每个字符都要用开始位和停止位作为字符开始和结束的标志

- 三总线结构多见于专用的CPU结构,而个人计算机中并没有专门的DMA总线这种结构,设备与主存之间的DMA传输都是通过系统总线完成的

- 三总线下,高速设备靠近CPU,慢速设备远离CPU

- 不同层次总线之间采用桥接方式连接和缓冲

- 多总线结构的发展趋势

- 采用分层次的多总线结构,不同层次总线之间采用桥接方式连接和缓冲

- 将I/O设备与主存之间的通信与处理器的活动分离开来

- 高速设备靠近CPU,低速设备远离CPU

- 桥接芯片高度集成,形成了经典的南北桥架构。南桥芯片就是I/O控制芯片

- QPI总线是一种基于包传输的串行高速点对点连接协议,采用差分信号与专门的时钟信号进行传输。QPI总线有20条数据线,发送方(TX)和接收方(RX)有各自的时钟信号,每个时钟周期传输两次。一个QPI数据包包含80位,需要两个时钟周期或4次传输才能完成整个数据包的传送。在每次传输的20位数据中,有16位是有效数据,其余4位用于循环冗余校验,以提高系统的可靠性。

- 由于QPI是双向的,在发送的同时也可以接收另一端传输来的数据,这样,每个QPI总线的带宽计算公式如下:

每秒传输次数×每次传输的有效数据×2

- 由于QPI是双向的,在发送的同时也可以接收另一端传输来的数据,这样,每个QPI总线的带宽计算公式如下:

- 总线连接结构的优点:

- 灵活和成本低

- 部件可以在使用相同总线的计算机系统之间互换

- 有些总线没有单独的地址线,地址信息通过数据线来传送,这种情况称为数据线和地址线复用

- 如何使各个部件在需要时使用总线,需靠控制线来协调

- 控制信息可以双向传输,但是一根控制线通常只传一类控制信号,且方向固定,比如读写命令是CPU传给内存或者外设(I/O接口),外设(I/O接口)传输握手信号和中断请求信号给CPU

- 同步总线事务可以是突发传输方式,这种情况下,一个总线事务中可以传输多个连续的数据,每次传输的数据位数不超过总线宽度

- 同步总线由时钟信号定时,时钟频率不一定等于工作频率

- 异步总线由握手信号定时,每次握手的过程完成一次通信,但一次通信往往会交换多位而不是一位数据

- 传统的并⾏总线(如PCI)在提⾼频率时会遇到信号串扰和时钟偏斜(即多条线路的信号到达时间不⼀致)等问题,这限制了其速度的进⼀步提升。现代⾼速总线,如PCI Express (PCIe)、SATA、USB等,都采⽤了串⾏传输技术。虽然每次只传输⼀位数据,但它们可以通过极⾼的传输频率来获得远超并⾏总线的总带宽,并且使⽤的引脚更少,抗⼲扰能⼒更强。

- 处理器总线和存储器总线都⽐ I/O 总线快,多总线结构正是为了将不同速率的设备挂载在不同的总线上,避免慢速设备拖慢整个系统。多总线结构的⼀个核⼼优势就是通过桥接器等设备实现总线间的并发操作。

- 同步总线⽀持猝发传输模式。在猝发模式下,主设备只需发送⼀个起始地址,就可以在后续连续多个时钟周期内连续传输多个数据字。这整个过程被视为⼀次总线事务,但它完成了多次数据交换。这种⽅式在连续读写存储器块时效率很⾼。

总线的基本特性

- 控制线每根单向,但是两根实现双向,所以控制信息双向传输,控制线单向传输

总线事务

总线定时

| 定时方式 | 应用场景 | 优点 | 缺点 | 工作原理 | 特点 |

|---|---|---|---|---|---|

| 同步总线定时 | 适用于对传输速率要求较高的场景。 | 设备协调简单,传输速率较高。 | 对时钟偏移问题敏感,可能导致时序错误。 | 所有设备与一个时钟同步,数据传输根据时钟周期进行。 采用并行传输方式。 |

总线适用于时间敏感的系统,如实时数据处理系统。 |

| 异步总线定时 | 适用于设备不需要同步时序的系统。 | 无需严格时钟同步,设备间工作速度可不同。 | 传输效率较低,可能导致延迟增加和复杂性上升。 | 不依赖固定时钟信号,而是使用设备间的握手信号进行数据传输。 | 避免时钟偏移问题,但需额外协议进行时间控制。 |

| 半同步总线定时 | 适用于需要部分同步,其他部分灵活的系统。 | 结合了同步和异步的优点,保证同步部分的同时允许灵活。 | 若设备速度差异大,可能出现传输效率低下。 | 使用同步信号控制关键组件,其他部分异步控制,使用等待信号控制数据流。 | 适用于数据传输速率和时序不同的系统。 |

| 分离式总线定时 | 适用于多阶段数据处理或多个设备访问总线的系统。 | 提高资源利用率,多个设备可同时使用总线,避免冲突。 | 实现和管理复杂,需要协调设备访问。 | 总线分为两个阶段,分别用于数据传输和接收。 | 允许多个设备高效使用总线,减少空闲时间。 |

- 半同步方式就是在时钟的同步下控制发出和采样异步应答信号

- 同步

- 异步

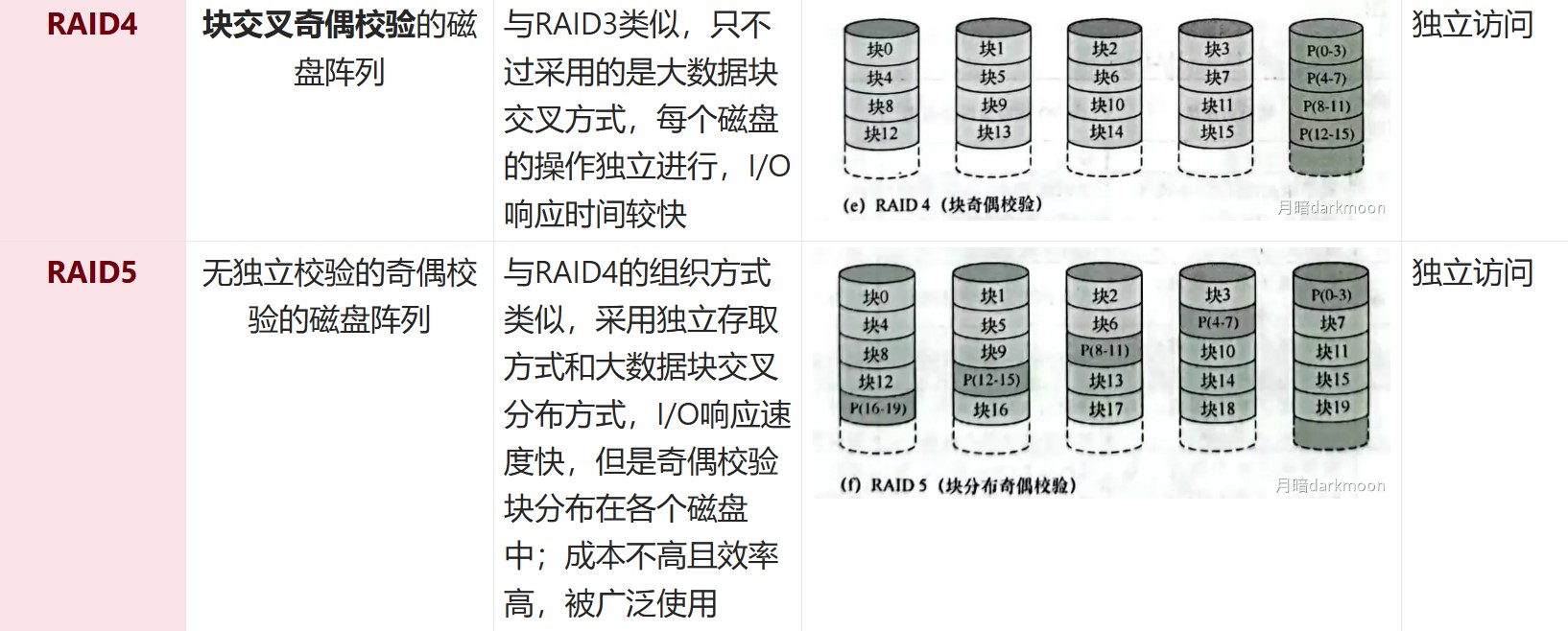

I/O接口

- 对数据缓存寄存器、状态/控制寄存器对的访问操作是通过相应的指令来完成的,通常称这类指令为I/O指令,I/O指令只能在操作系统内核的底层I/O软件中使用,它们是一种特权指令

- 通常,DMA接口与主存之间的传送单位为字,而DMA与设备之间的传送单位可能为字节或位

- CPU通过设备驱动程序设置DMA控制器的参数

- 可编程的中断控制器属于I/O接口

定时查询的计算

-

最多间隔查询时间=数据缓冲器大小/数据率

- 每秒查询次数=1s/最多间隔查询时间

- 每秒CPU用于外设I/O时间=每秒查询次数*查询1次所用时钟周期数

- 占整个CPU时间的百分比=每秒用于外设I/O的时钟周期数/总的时间周期数

-

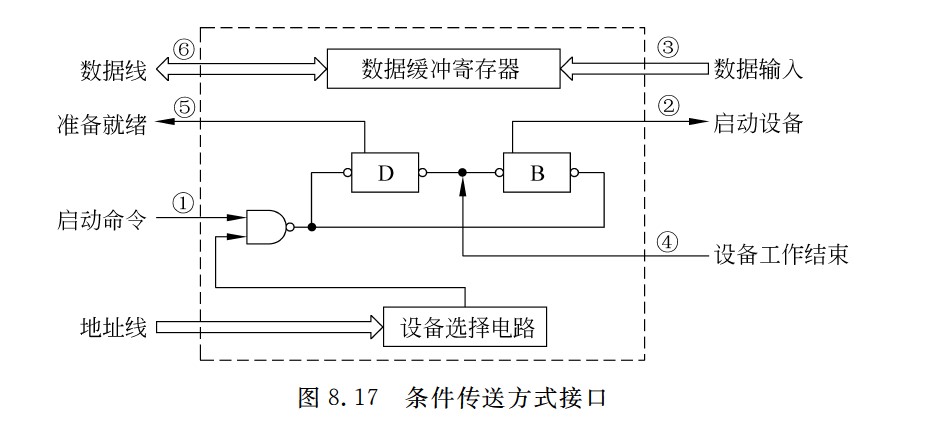

定时查询的流程

- ①CPU执行相应的I/O指令向该接口送出“启动”命令,设备选择电路对CPU送出的地址进行译码,选中本I/O接口,这样,与非门输出信号使“完成”状态触发器D清零,而使“启动”命令触发器B置1

- ②I/O接口通过连接电缆向外设发送“启动设备”命令;

- ③外设准备好一个数据,通过电缆向I/O接口中的数据缓冲寄存器输入数据;

- ④外设向I/O接口回送“设备工作结束”状态信号,使状态触发器D置1,使命令触发器B清零;

- ⑤CPU通过执行指令不断读取I/O接口状态。因触发器D已经被置1,所以,查询到外设“准备就绪”;

- ⑥CPU通过执行I/O指令从数据缓冲寄存器读取数据。通过以上6个步骤,CPU和外设之间完成一次数据交换过程。

程序中断的计算

- 如何判断外设能否用中断I/O方式?

- ①计算出中断处理所用的时间A

- ②计算出外设准备好数据的时间B

- ③如果A>B,则不可以

DMA方式的计算

-

外设每秒的DMA次数为外设数据率/每次DMA传送块大小

-

CPU用于外设I/O的总时间为每秒DMA次数*DMA处理的时钟周期数

-

占CPU总时间的百分比=CPU用于外设I/O的时钟周期数/计算机每秒的时钟周期数

-

DMA响应时间应该少于一个总线周期

-

dma接口与主机之间的数据传输以块为单位,dma接口与i/o设备的传输以字为单位

-

无论采用何种 DMA 方式,当整个数据块传输完成后,DMA 控制器均会向 CPU 发送中断请求,通知传输结束

-

DMA控制器占⽤总线时,CPU只是暂时不能访问主存,但如果CPU正在执⾏的指令不涉及访存操作(例如,在内部寄存器之间进⾏运算),CPU仍然可以继续执⾏。只有在“停⽌CPU访存”模式下,或者CPU恰好需要访存时,CPU才会进⼊等待状态。

-

发生缺页中断时,若在缺页处理程序中将缺页调入内存采用 DMA 方式,则需要把磁盘物理地址写入 DMA 控制器中的设备地址寄存器 DAR,需要在预处理的初始化中将交换数据的主存起始位置(即该页面的页基址)写入DMA 接口中的主存地址寄存器。

-

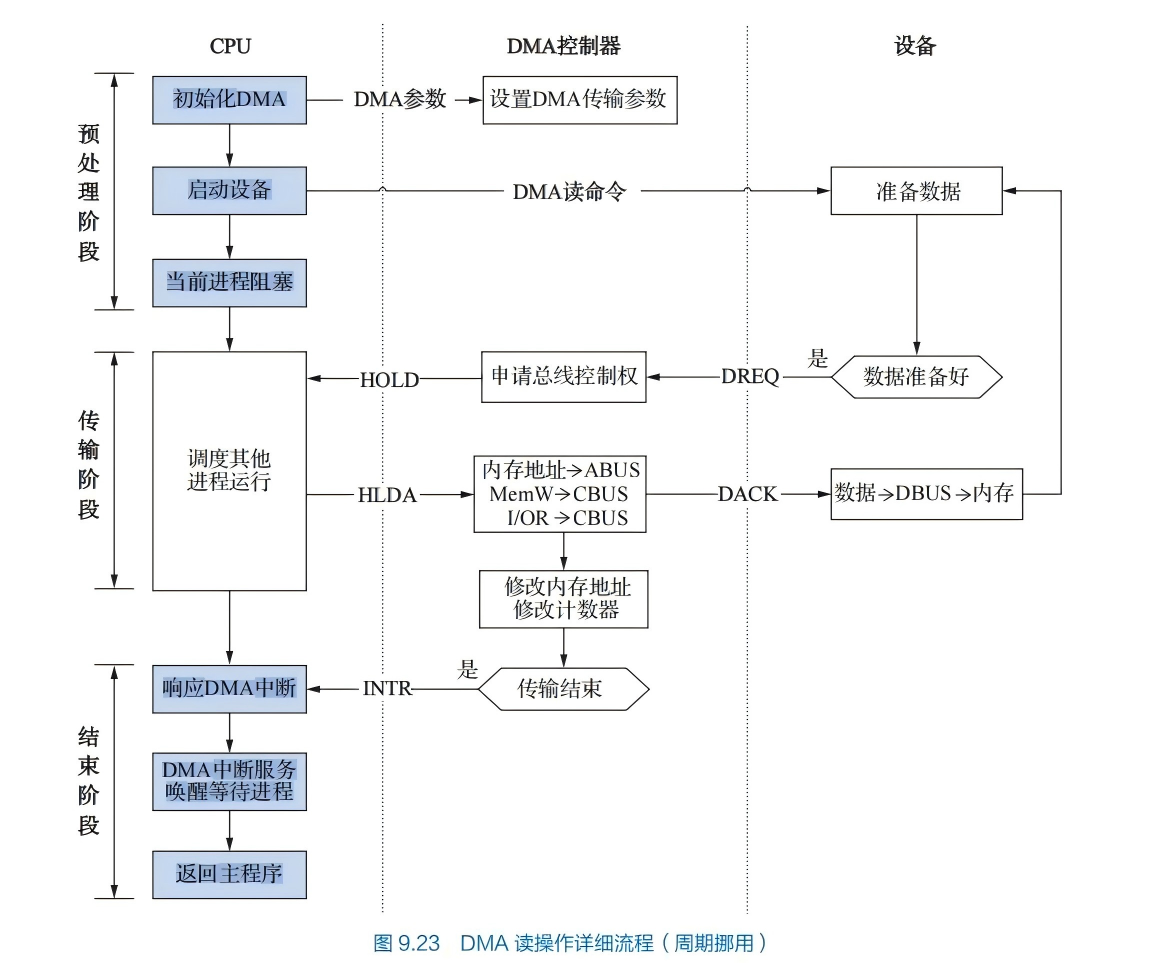

三个阶段:

- 预处理阶段:确定数据传输方向、选择并启动设备、初始化主存地址寄存器和字计数器。

- 传送过程:

- 设备发送一个字至DMA的数据缓冲寄存器中,作为选通信号

- 设备向DMA控制器发送DMA请求(DREO)

- DMA接口向CPU申请总线控制权(HRO)

- CPU发回总线应答信号(HLDA)

- DMA控制器发送主存地址到总线

- DMA控制器向设备发送DMA应答信号(DACK)

- 传送数据至内存,同时修改主存地址寄存器和字计数器的值、检查数据块是否传送结束。

- 后处理:校验已传输的数据是否正确、决定是否用DMA传输其他数据块

-

周期挪用方式中,I/O 设备每挪用一个主存周期都要申请和归还总线控制权。传输一个字的数据时,数据传输本身可能只需要 1 个主存周期,DMA 接口需要占用多个主存周期。因此适合I/O 设备的读写周期大于存取周期的情况

- DMA 与 CPU 交替访存适用于 CPU 的工作周期比主存存取周期长的情况。将一个 CPU 工作周期分为两个部分,分别用于 DMA 访存和 CPU 访存

- 周期挪用是一种单字传输方式

- 这里的字指的是I/O接口的数据缓冲寄存器宽度/存储器总线宽度

中断和异常

-

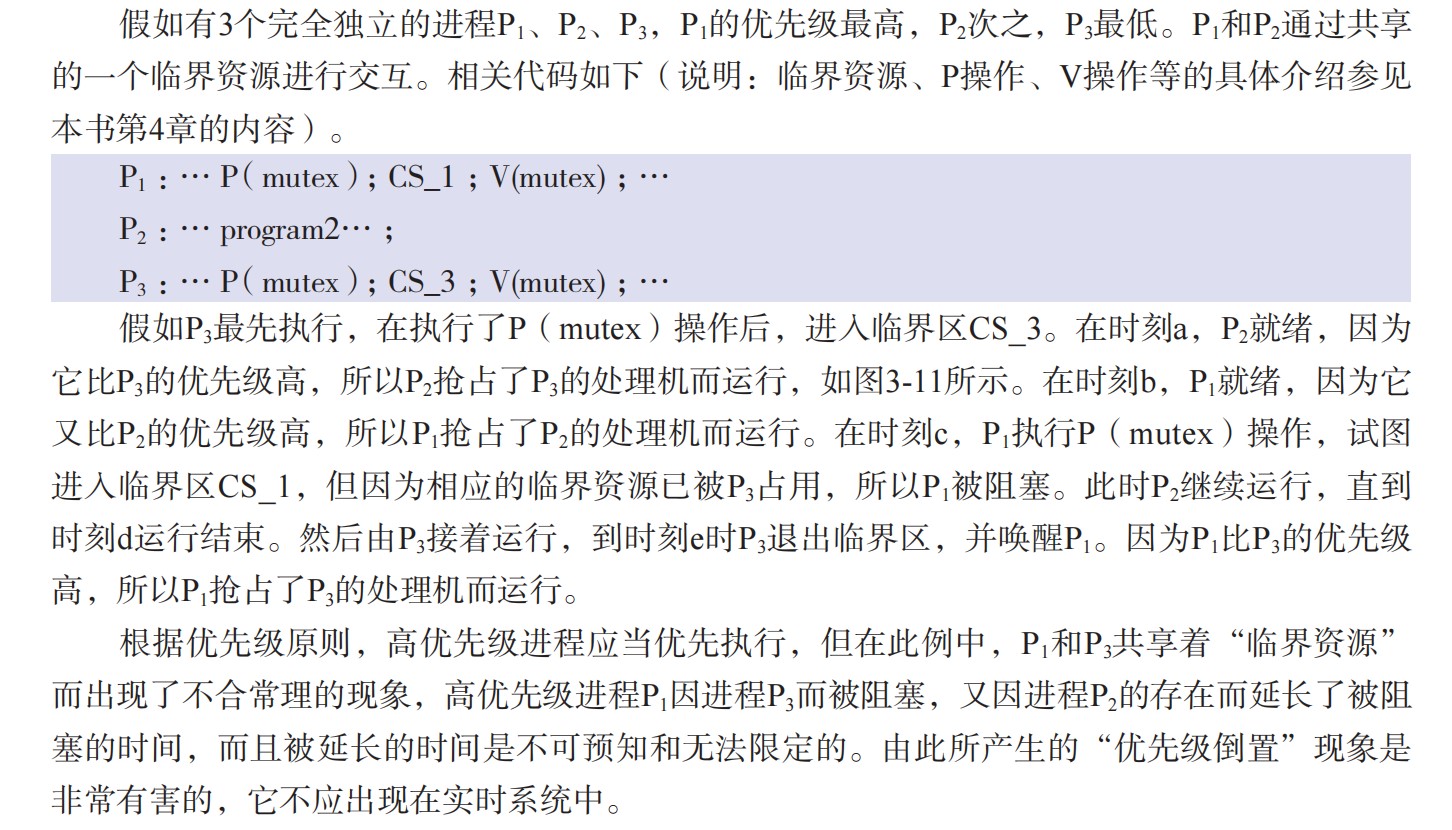

概念厘清

- 中断向量

- 中断处理程序的入口地址(首地址)

- 中断类型号

- 标识中断类型的编号

- 中断向量地址

- 保存中断向量的内存地址,在中断响应阶段由中断向量地址形成部件(硬件)生成

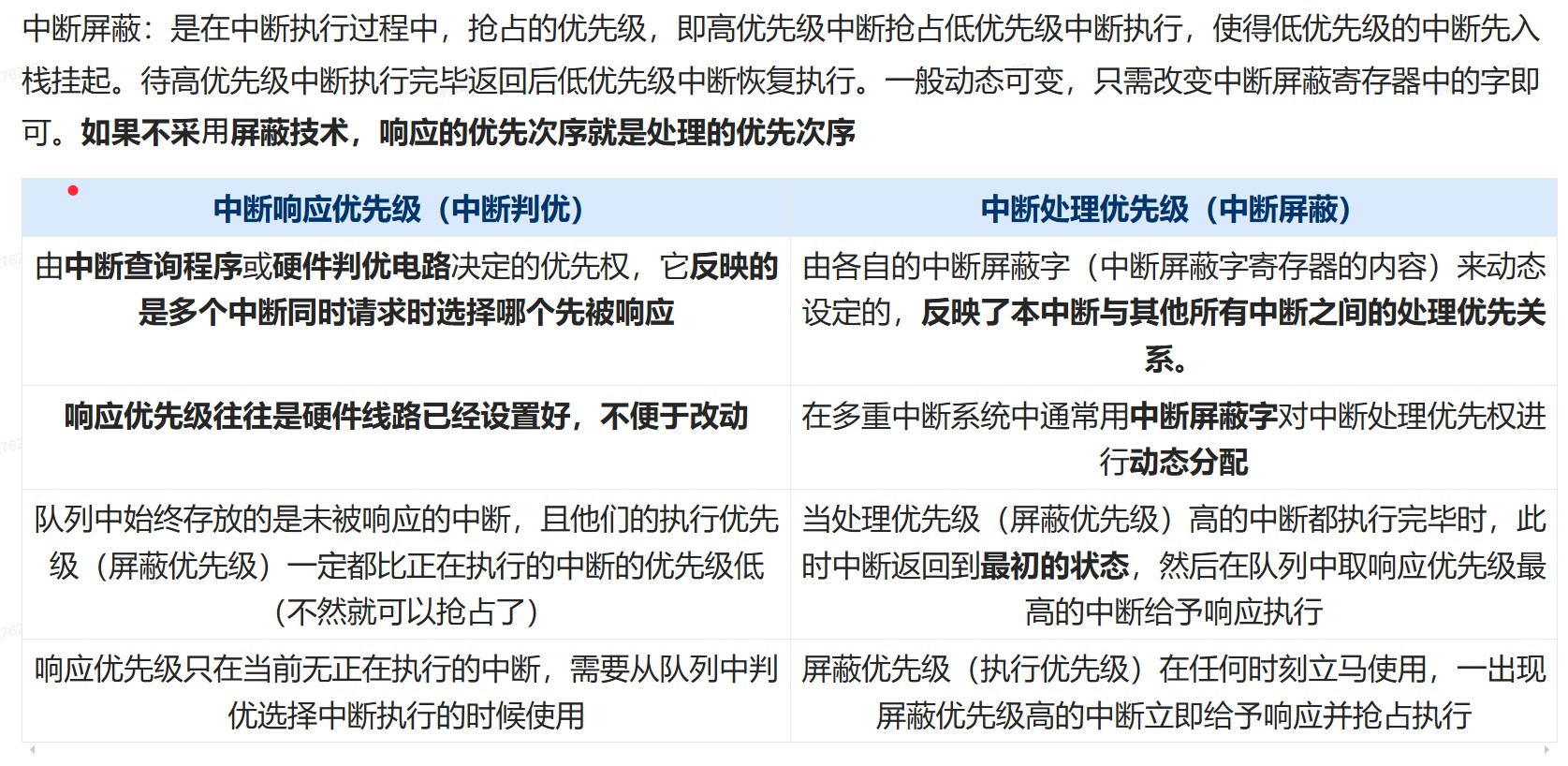

- 中断优先级

- 中断响应优先级

- 硬件产生且不可更改

- 中断处理优先级

- 由排队器、中断屏蔽字等硬件决定

- 中断响应优先级

- 中断向量表

- 记录了中断编号和中断向量的对应关系

- 中断向量

-

可屏蔽中断指通过可屏蔽中断请求线INTR向CPU发出的中断请求,CPU可以通过在中断控制器中设置相应的屏蔽字来屏蔽它或不屏蔽它,被屏蔽的中断请求将不被送到CPU

- 不可屏蔽中断指通过专门的不可屏蔽中断请求线NMI向CPU发出的中断请求,通常是非常紧急的硬件故障

-

所有的异常和中断事件都是由硬件检测发现的

-

优先级:

- 不可屏蔽中断>内部异常>可屏蔽中断

- 内部异常中,硬件故障>软件中断

-

中断允许(IF)触发器设置为1,开中断,设置为0,关中断

-

异常的识别大多采用软件识别方式,而中断可以采用软件识别方式或硬件识别方式

- 软件识别方式:

- CPU设置一个异常状态寄存器,用于记录异常原因。操作系统使用一个统一的异常或中断查询程序,按优先级顺序查询异常状态寄存器,以检测异常和中断类型,先查询到的先被处理,然后转到内核中相应的处理程序

- 硬件识别方式(向量中断):

- 异常或中断处理程序的首地址称为中断向量,所有中断向量都存放在中断向量表中。每个异常或中断都被指定一个中断类型号。在中断向量表中,类型号和中断向量一一对应,因此可以根据类型号快速找到对应的处理程序。

- 整个响应过程是不可被打断的,中断响应过程结束后,CPU就从PC中取出对应中断服务程序的第一条指令开始执行,直至中断返回,这部分任务是由CPU通过执行中断服务程序完成的,整个中断处理过程是由软/硬件协同完成的

- 异常/中断的响应由硬件完成,后续中断服务程序是软件完成

- 软件识别方式:

-

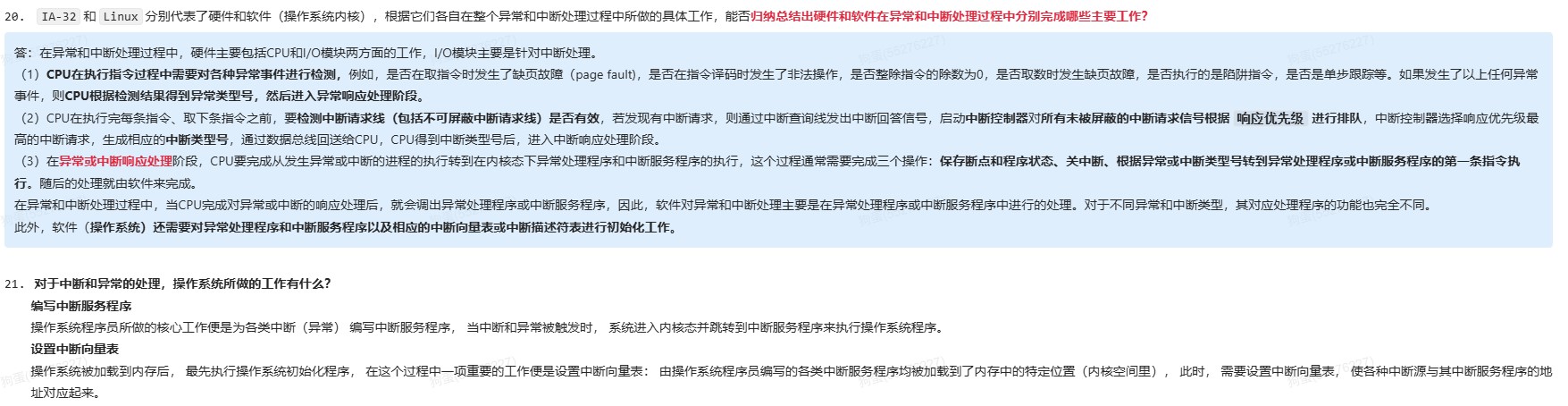

中断响应(硬件):

-

关中断

-

PC/PSW(压入内核栈)(保存在中断保留区/中断栈中)

-

中断向量寻址

-

-

OS:

-

保存现场和屏蔽字(有多重中断就保存)

- 现场是包括PC/PSW的,但是为什么让硬件保存PC/PSW,因为指令没有办法直接读写PC/PSW

-

更新中断屏蔽字(多重中断下)

-

开中断

-

中断处理

-

关中断

-

恢复旧的现场和屏蔽字

- 从内核栈中弹出之前保存的通用寄存器等上下文(除了PC和PSW)

- 操作系统用普通指令(

pop/mov)从当前进程的内核栈中恢复通用寄存器、段寄存器等。 - 恢复中断屏蔽寄存器(如x86的

IF标志、APIC的中断优先级)

-

清除中断请求

- 向中断控制器发送EOI(End Of Interrupt)

- 清除设备的中断挂起位

- 注意:在某些设计中,这可能在更早阶段完成

-

开中断

-

中断返回

-

执行特殊的返回指令(如x86的

IRET),该指令会从内核栈中弹出PC和PSW,并可能切换特权级和栈。 -

执行特权返回指令(x86的

IRET/IRETQ,ARM的ERET等)。此时硬件自动:a) 检查并弹出内核栈上的硬件保存帧

从当前内核栈弹出:

- PC(

EIP/RIP) - 代码段选择字(

CS) - PSW/标志寄存器(

EFLAGS/RFLAGS)

b) 特权级检查

比较返回后的

CS选择子中的CPL与当前CPL:- 如果特权级不变(如内核->内核):直接使用当前内核栈

- 如果特权级降低(如内核->用户):需要切换栈

c) 用户栈恢复(当特权级降低时)

从内核栈额外弹出:

- 用户栈指针(

ESP/RSP) - 用户栈段选择字(

SS)

至此,栈指针自动切换到用户栈,中断返回完成。

- PC(

-

-

-

在中断处理程序结束后的执行iret指令过程中,会从内核栈中弹出异常/中断响应时保存的PC和PSW信息(即断点信息),并且会检查异常/中断响应前、后系统是否处于同一个特权级,如果检查出响应前、后处于同一个特权级(即异常/中断是在内核程序执行时发生的,若是中断即表示发生了多重中断),则不需要从内核栈中弹出用户栈指针,因为在这种情况下,异常/中断响应时并没有在内核栈中保存用户栈顶指针。如果检查出前、后不是同一个特权级,则需要弹出用户栈指针。

-

中断返回指令(IRET)的工作

在x86架构中,IRET指令用于从中断或异常处理程序返回。它会根据当前特权级和从栈中弹出的内容进行以下操作:弹出返回地址和标志寄存器:从栈中依次弹出EIP、CS和EFLAGS。

特权级检查:如果返回的目标代码段特权级与当前特权级不同(例如从内核态返回用户态),则还会弹出用户栈的指针(ESP和SS)。

切换栈:如果特权级改变,CPU会自动切换栈,即使用弹出的SS:ESP作为栈指针,从而从内核栈切换到用户栈。

内核栈指针的管理

在整个中断处理过程中,内核栈指针(ESP)始终指向当前中断上下文保存的位置。在中断发生时,硬件会自动将SS、ESP、EFLAGS、CS、EIP等压入栈(如果发生特权级切换,还会压入用户栈的SS和ESP)。然后,操作系统软件再压入其他寄存器。在返回前,操作系统软件会先恢复通用寄存器,并将栈指针调整到合适的位置,使得执行IRET时,栈顶正好是硬件保存的上下文。这样,IRET就能正确地弹出所有硬件保存的信息。

特权级切换的栈操作

如果中断发生在用户态(特权级3),而中断处理程序运行在内核态(特权级0),那么:中断发生时:硬件会自动从当前任务的TSS(任务状态段)中加载内核栈的SS和ESP,然后将用户态的SS、ESP、EFLAGS、CS、EIP依次压入内核栈。

中断返回时:当执行IRET时,CPU会从内核栈中弹出EIP、CS、EFLAGS,然后检查CS中的特权级。如果发现特权级变化(从0变为3),则会继续弹出用户栈的ESP和SS,从而切换回用户栈。

-

-

异常和中断的差异:异常指令通常并没有执行成功,异常处理后要重新执行,所以其断点通常是当前指令的地址。中断的断点则是下一条指令的地址

-

中断处理优先级是利用中断屏蔽技术动态调整,若不使用中断屏蔽技术,则处理优先级和响应优先级相同。

-

通过配置中断屏蔽字,可以动态改变中断处理优先级,但不能改变中断响应优先级,屏蔽字改变的是能否被响应,而不是响应顺序

-

中断屏蔽字寄存器的内容只有在执行中断服务程序时才会被更新,所以中断屏蔽只在CPU运行中断服务程序时才有用

- 其并不能改变CPU运行主程序时的中断响应优先级。即使在CPU运行中断服务程序时,同时到达的多个未屏蔽中断请求的处理也只能按中断判优电路的响应优先级进行处理。

- 因为是进入前看响应优先级,进入后再看处理优先级,所以在响应优先级A>B,处理优先级B>A的情况下,AB同时到达,先响应A,B排队中。A关中断,保存PC和PSW,找到中断向量入口,响应完毕,B等待响应,A保存现场然后开中断准备处理的时候,B由于处理优先级更高,所以当响应完以后,B进入处理。

- 注意,此处的响应只是排队,每次处理的时候还要走一遍响应(保存当前程序的断点)+执行中断服务程序

-

中断或异常处理执行的代码不是一个进程,而是内核控制路径,它代表异常或中断发生时正在运行的当前进程在内核态执行一个独立的指令序列

-

异常由CPU内部硬件(如控制单元、运算单元、MMU等)检测并触发,不可屏蔽,需立即处理

-

定时器超时属于外部中断

-

缺页可以回到发生故障的指令重新执行

- 上溢出、除数为0、非法指令、内存保护错等:终止当前进程

-

对于除数为0的情况,根据是定点除法指令还是浮点除法指令有不同的处理方式

- 对于浮点数除0,异常处理程序可以选择将指令执行结果用特殊的值(NaN或∞)表示,然后返回到用户进程继续执行除法指令后面的一条指令

- 对于整数除0,则会发生整除0故障,通常调用abort例程来终止当前用户进程

-

若一个I/O设备的中断请求被屏蔽,则它的中断请求信号将不会被送到CPU,一般外设中断源引起的中断都是可屏蔽中断

-

当CPU处于开中断状态,且在当前指令执行完毕时,若检测到有效的可屏蔽中断请求,将立即启动中断响应流程(即使是多重中断,CPU正在处理某个中断的过程中,由于中断屏蔽字的存在,CPU检测不到处理优先级更低的中断请求信号,若检测到中断请求信号,则说明其处理优先级更高,会优先相应)

-

中断结束是由CPU(通过软件)通知中断控制器,而不是外设或控制器主动发给CPU

-

处理器在响应非屏蔽中断时,通常不需要像常规中断那样从外部硬件获取中断向量号。在很多处理器中,不可屏蔽中断所对应的中断向量号固定为2(因此它在被响应时无中断响应周期)

-

硬件判优方法

- 除数为0异常在ID周期进行检测

- 溢出、无效数据地址异常在EX周期进行检测

- 无效指令在ID周期进行检测

- 无效指令地址、缺页和访问越权异常在IF周期检测

- 缺页和访问越权异常在M周期检测

- 中断可在每条指令的最后一个周期的最后进行检测

- 除了在中断响应阶段可以由CPU对中断允许位进行设置外,也可以在异常或中断处理程序中执行相应的指令来设置或清楚中断允许位

- 为了能够支持异常或中断的嵌套处理,大多数处理器将断点保存在栈中,如果系统不支持多重中断嵌套处理,则可以将断点保存在特定寄存器中,而不需要送到栈保存

- 通常是由CPU外部的中断控制器根据I/O设备的中断请求和中断屏蔽情况,结合中断响应优先级,来识别当前请求的中断类型号,并通过数据总线将中断类型号送到CPU

- 中断不会发生地址空间的切换,进程切换才会切换进程地址空间,需要切换页表基址寄存器PTBR的内容,而TLB的内容也无需保存,因为其本来就是内存中页表的副本,进程切换后,把TLB里的内容冲刷即可(把有效位都清0)

- 保护现场和旧屏蔽字和恢复现场和旧屏蔽字分别通过压栈和出栈指令或取数指令来实现,设置新屏蔽字和清除中断请求通过执行I/O指令来实现

- 屏蔽字1表示屏蔽,0表示正常申请,开中断IF1表示开中断,0表示关中断

- 外设准备数据的时间应大于或等于中断处理时间,否则会导致数据丢失

- 无论中断处理还是子程序调用,为了保证执行流能正确返回并恢复执行,都需要保存当前执行上下文:

- 程序寄存器PC

- 中断由中断隐指令完成

- 子程序调用由CALL指令完成

- 执行call指令时,处理器先将当前的PC值压入栈,再将PC设置为被调用子程序的入口地址

- 部分通用寄存器

- 对于子程序调用,通用寄存器的保存通常由软件(编译器生成的代码或程序员显式编写的代码)根据调用约定来完成。硬件的call指令本身不负责保存所有通用寄存器

- 程序寄存器PC

- 中断可能引起处理器状态变化(如从用户态进入内核态、中断被屏蔽),因此必须保存程序状态字寄存器(PSW),而子程序调用通常在同一特权级内进行,不改变系统状态,无须专门保存PSW

- 进程切换一般也不保存PSW

- CPU的数据通路中有相应的异常和中断的检测和响应逻辑,在外设接口中有相应的中断请求和控制逻辑,操作系统中有相应的中断服务程序。

- 中断控制器负责接收外设设备控制器中的中断并进行排队和判优,所以和外设的设备控制器直接相连,当选中中断后,会把该中断的中断类型号放入CPU特定的寄存器中

- 断电是外部因素(如电源故障)引起的,通常由计算机硬件(如电源监控电路)检测并向CPU发出中断信号,属于外部中断

- 中断服务程序的最后一条指令是中断返回指令,当其执行结束时,即中断返回至原程序的断点处

- 中断技术使得多道批系统和I/O设备可以与CPU并行工作

- 缺页异常的断点是当前PC值减去后面那条指令的长度,因此在发生缺页时,已经在取指令状态执行了PC+“1”,所以需要减去“1”才能重新执行发生异常的指令

- 终止是一种硬件故障,无法确定哪条指令出现问题

- 中断控制器是一个单独的硬件或者说I/O控制器,连接到各个外设

时钟中断全流程

- 时钟和时间片(分配给进程的时间)是OS用来感知时间的,可以通过软件方式设置

- 时钟中断全流程

- ①用户程序执行ing

- ②CPU时钟到达

- ③时钟中断处理

- ④中断响应阶段

- ⑤保存现场和屏蔽字

- ⑥开中断(允许多重中断)

- ⑦中断服务程序执行(更新进程时间片)

- ⑧可能进程切换

- ⑨关中断

- ⑩恢复现场

- 11、开中断

- 12、中断返回

- 13、返回用户态继续执行

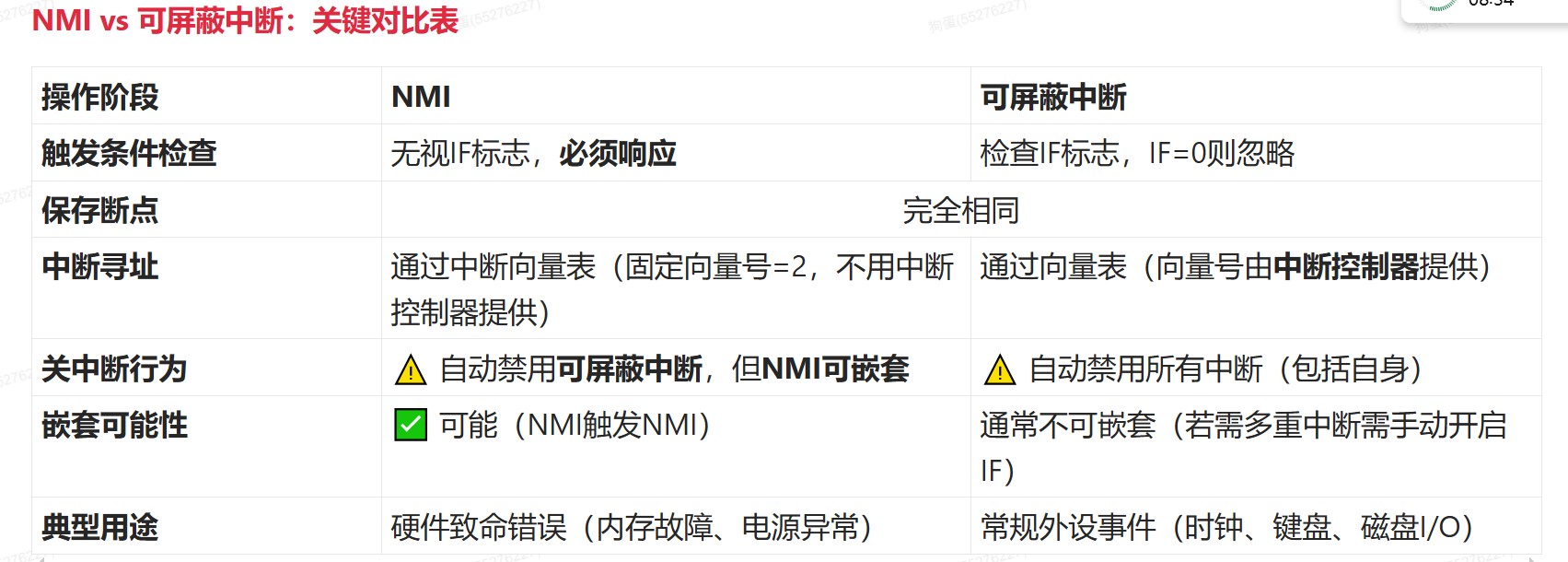

两种中断对比

- 需不需要检测IF(中断使能标志),是可屏蔽中断和不可屏蔽中断的关键区别

- 非可屏蔽中断的优先级高于所有可屏蔽中断,因此不需要检查INTR是否有请求

- 非可屏蔽中断自动禁用可屏蔽中断:CPU在响应时自动清除IF标志

- 不屏蔽非可屏蔽中断,允许非可屏蔽嵌套

- 即使是不可屏蔽中断,CPU仍需在指令边界响应中断,原因是CPU内部执行机制决定

- NMI 优先级高、不可屏蔽,但并不是瞬间中断 CPU,而是 最快在当前指令执行完毕后响应。

- NMI 不受中断屏蔽标志控制,但仍然需要等到 CPU 到达 中断检测点(通常在指令完成后) 才能响应。

- 不可屏蔽仅指跳过IF标志检查,但不改变CPU的原子执行原则

- 非可屏蔽中断是多重中断系统中的概念

- 不可屏蔽中断需要保存断点和中断服务程序寻址,NIM的向量号固定且不可配置,但必须通过向量表跳转,否则CPU无法知道处理程序位置

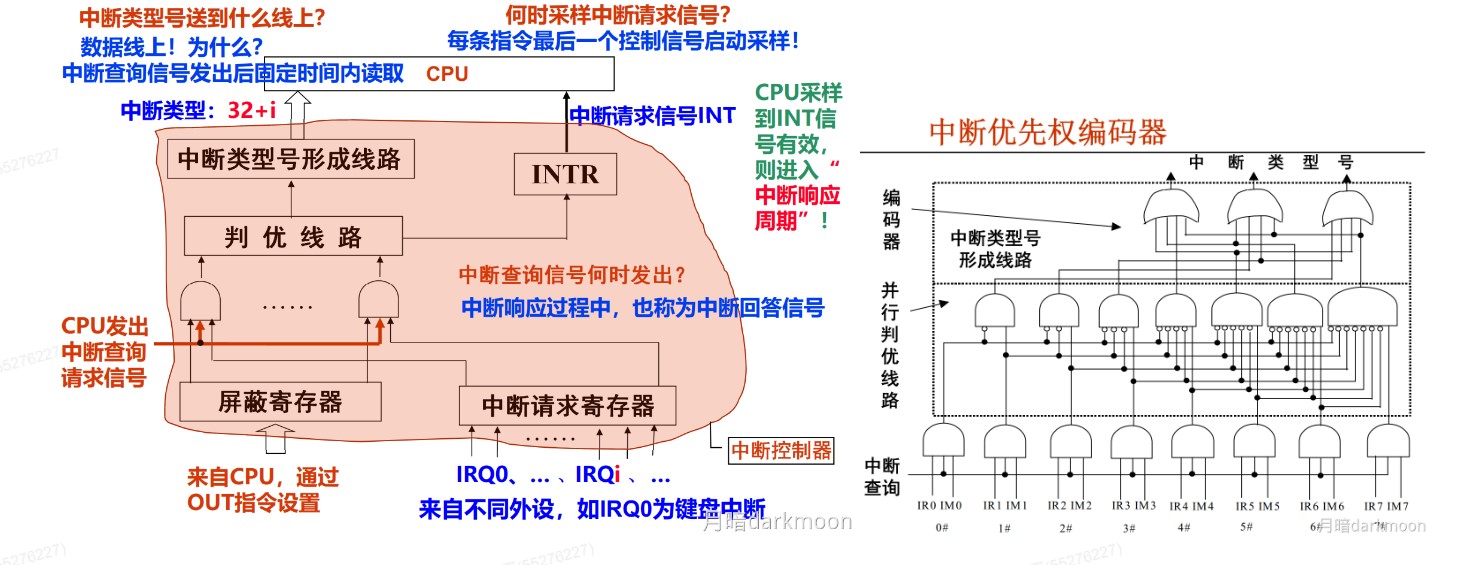

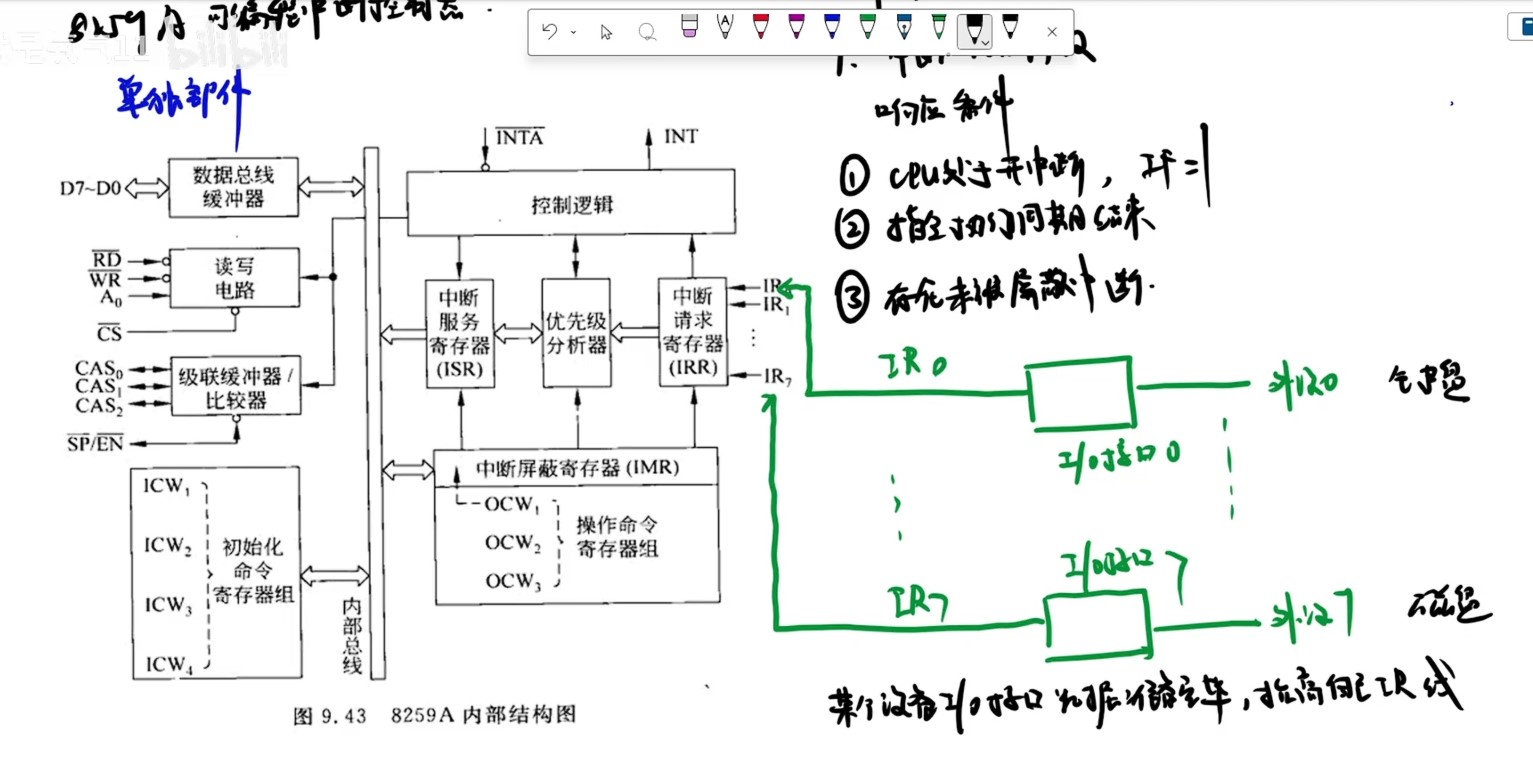

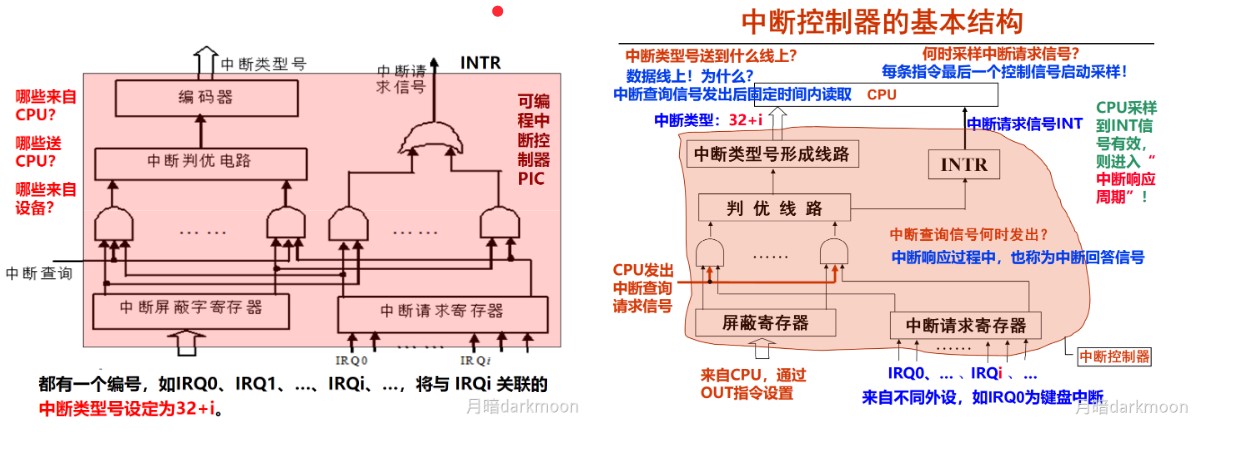

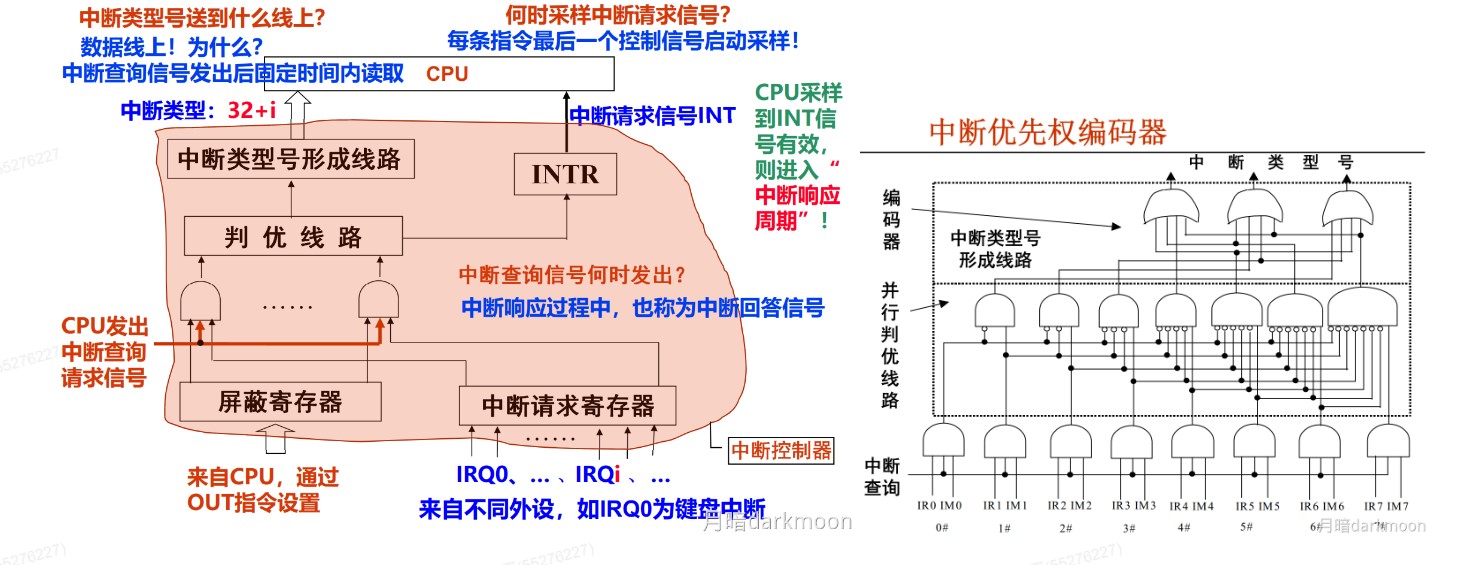

中断控制器

- 中断服务寄存器ISR里面存的是中断类型号

两种优先级的比较

- 支持多重中断的系统,当CPU响应了第一个外部中断,进入中断服务程序以后会设置中断屏蔽字,就是写入中断屏蔽字寄存器,之后 开中断,后面在执行中断服务程序的过程中,如果来了一些外部中断,中断控制器会根据中断屏蔽字寄存器里的内容选择屏蔽一些外部中断请求,然后没有被屏蔽的被送到中断排队器根据响应优先级排队,最高优先级的先响应

- 如果CPU刚执行完一条指令,这时中断控制器来了很多中断请求,这时候中断屏蔽字寄存器里面没有内容,所有中断请求都不会被屏蔽,都一起送过去中断判优,看谁响应优先级最高先响应谁

- 然后响应优先级最高的中断被选中处理了,之后设置中断屏蔽字,这时候才用到处理优先级

- 若当前正在执行主程序,发生中断,只检查中断响应优先级

- 若当前正在执行中断处理程序,先检查中断处理优先级,如果有若干个(>1个)更高级中断到达,再检查中断响应优先级

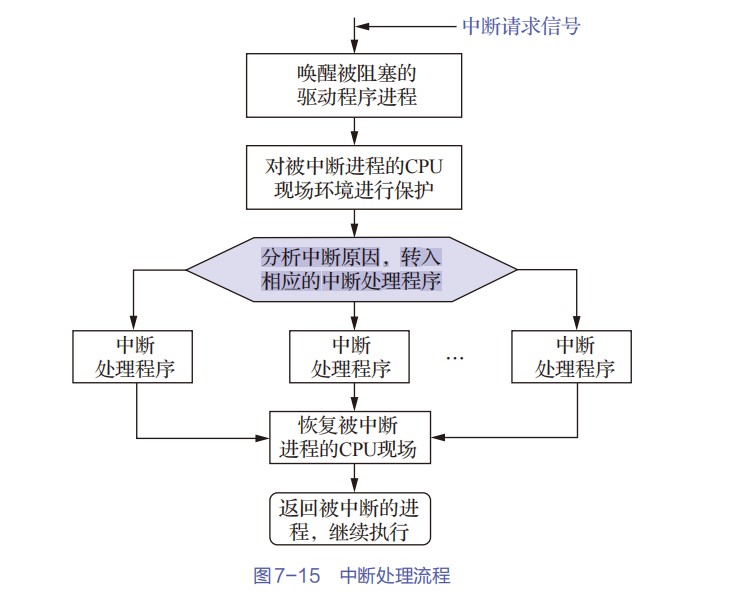

中断处理过程

- 上图为中断系统的基本结构图,从图中可以看出,来自各个外设的中断请求记录在中断请求寄存器中的对应位,每个中断源有各自对应的中断屏蔽字,在进行相应的中断处理之前它被送到中断屏蔽字寄存器中。

- 在CPU执行程序代码时,每当完成当前指令的执行、取出下一条指令之前,都会通过采样中断请求信号引脚(如IA-32中的re)来自动查看有无中断请求信号。

- 若有,则会发出一个相应的中断回答信号,启动图中的“中断查询”线

- 在该信号线的作用下,所有未被屏蔽的中断请求信号一起送到一个中断判优电路中

- 判优电路根据中断响应优先级选择一个优先级最高的中断源,然后用一个编码器对该中断源进行编码,得到对应的中断源设备类型号(即中断源的标识信息,称为中断类型号)。

- CPU取得中断源的标识信息后,经过一系列相应的转换,就可得到对应的中断服务程序的首地址(中断向量),在下一个指令周期开始,CPU执行相应的中断服务程序。

- 若有,则会发出一个相应的中断回答信号,启动图中的“中断查询”线

- “保护现场和旧屏蔽字”、“恢复现场和旧屏蔽字”分别通过**“压栈”和“出栈”指令**来实现

- “设置新屏蔽字”和“清除中断请求”通过执行I/O指令来实现,这些I/O指令将对可编程中断控制器(PIC)中的中断请求寄存器和中断屏蔽字寄存器进行访问,以使这些寄存器中相应的位清零或置1。

- 在设备驱动程序和中断服务程序中使用到的I/O指令、“开中断”和“关中断”指令都是特权指令,只能在操作系统内核程序中使用。

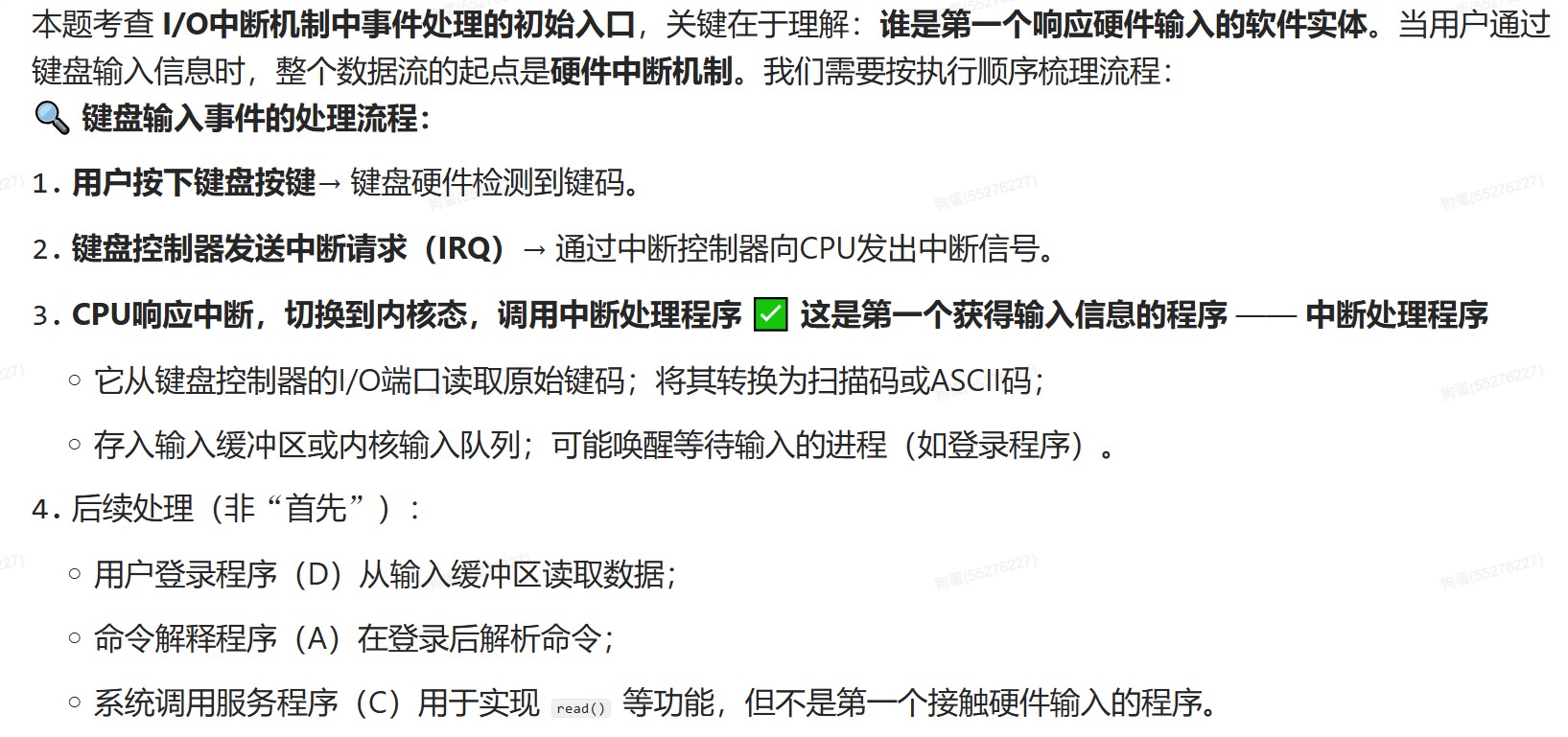

I/O中断机制中事件处理的初始入口

常见中断问题

- 禁止中断和屏蔽中断是同一个概念吗?

- 不是

- 禁止中断就是关中断,即将中断允许触发器置为0,此时,任何中断请求都得不到响应。

- 屏蔽中断是多重中断系统中的一个概念,是指某个中断正在被处理的时候,如果有其他新的中断请求发生,那么,通过设置中断屏蔽位,可以确定是否允许响应新发生的中断。它反映了正在处理的中断与其他各中断之间的处理优先级顺序,所以每个中断都有一个中断屏蔽字,其中的每一位对应一个中断的屏蔽位。响应某个中断后,就会把该中断的中断屏蔽字送到中断屏蔽字寄存器中,在中断排队前,其中的每一位和中断请求寄存器中的对应位进行“与”操作,因而,只有未被屏蔽的中断源进入排队线路,才有可能得到响应。

- DMA方式下,在主存和外设之间有一条物理通路直接相连吗?

- 没有

- 通常所说的DMA方式下数据在主存和外设之间直接进行传送,其含义并不是说在主存和外设之间建立一条物理上的直接通路,而是在主存和外设之间通过外设接口、系统总线以及总线桥接部件等连接,建立起一个信息可以互相通达的通路。“直接通路”是逻辑上的含义,物理上磁盘和主存不是直接相连的。

- 两句话的对错

- 系统处于开中断时,检测到中断请求就会立即响应(正确)

- 系统处于开中断时,有中断请求就会立即响应(错误)

- 谁发送中断结束信号?

- 关键误解:谁发送“中断结束信号”?

- 外部设备不会直接或间接向CPU发送“中断结束信号”。

- 实际流程如下:

- a.外设产生中断请求→通过中断控制器向CPU发送INTR信号;

- b.CPU响应中断,执行中断服务程序(ISR);

- c.在ISR结束前,由软件(操作系统)向中断控制器发送“中断结束命令”(EOI,End of Interrupt);

- d.中断控制器收到EOI后,清除当前中断状态,允许后续中断。

- “中断结束”是由CPU(通过软件)通知中断控制器,而不是外设或控制器主动发给CPU。

键盘输入的完整数据流

键盘输入

用户先输入的情况

- ①用户按键

- ②键盘硬件将键码发送至键盘控制器的数据寄存器

- ③控制器触发中断请求

- ④CPU响应中断,执行键盘中断服务例程

- ⑤中断服务例程从数据寄存器读取键码

- ⑥将数据存入内核缓冲区(如输入缓冲区)

- ⑦中断服务例程执行结束

- ⑧后续由用户程序通过系统调用(如read)从内核缓冲区读取数据,复制到用户缓冲区A

进程通过执行系统调用从键盘接收一个字符

这个情况是数据未就绪的情况,即用户在请求后输入

- ①将进程p插入阻塞队列

- 进程p执行read()等系统调用等待键盘输入,但输入尚未到达

- 操作系统将其状态设为阻塞,并插入阻塞队列(或等待队列)

- CPU调度其他进程运行

- ②用户在键盘上输入字符

- 用户按下按键,键盘硬件产生键码

- ③启动键盘中断程序

- 键盘控制器向CPU发出中断请求

- CPU响应中断,切换到内核态,启动键盘中断处理程序

- ④将字符从键盘控制器读入系统缓冲区

- 中断处理程序从I/O端口读取键码

- 存入内核缓冲区

- 属于键盘驱动程序的职责

- ⑤将进程P插入就绪队列

- 中断处理程序发现有进程P正在等待输入

- 将其从阻塞队列移出,插入就绪队列

- 表示进程P已具备继续执行的条件

- ⑥进程P从系统调用返回

- 当进程P被调度执行的时候,从系统调用的阻塞点恢复

- 返回用户态,继续执行后续指令(如printf输出读到的字符)

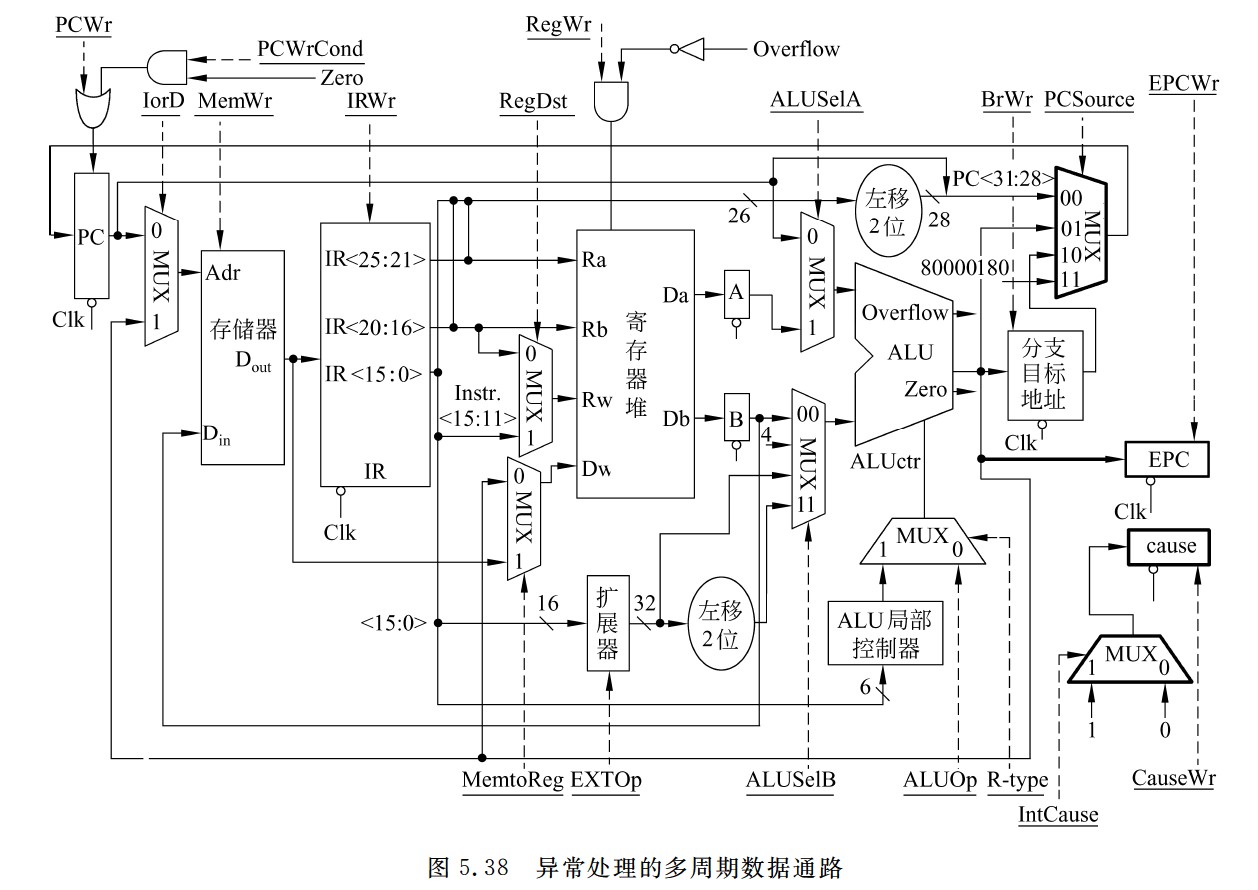

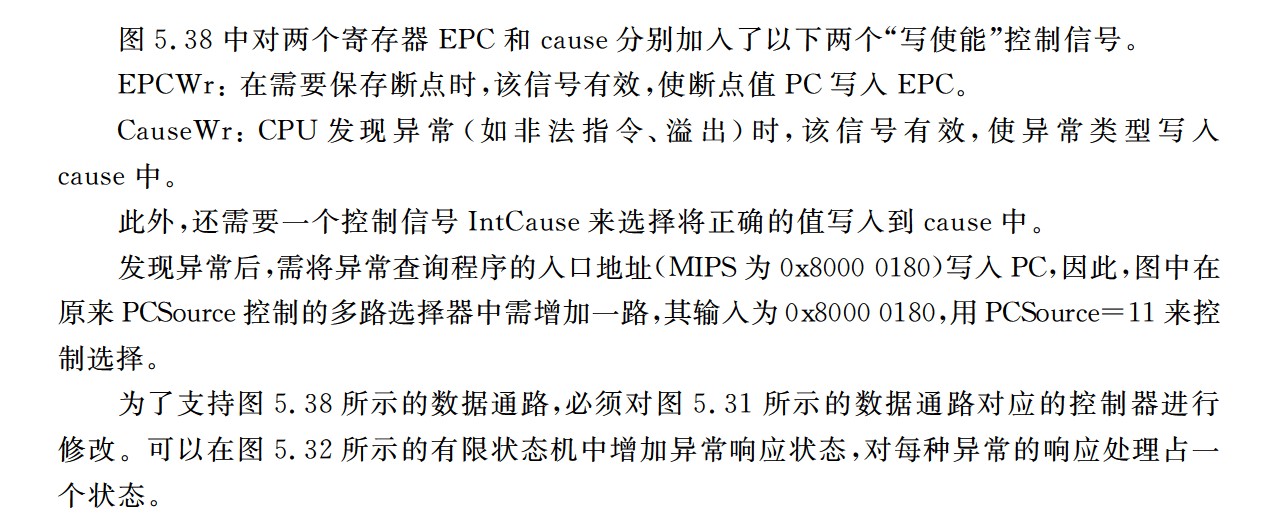

异常处理的多周期数据通路

计组常用硬件图

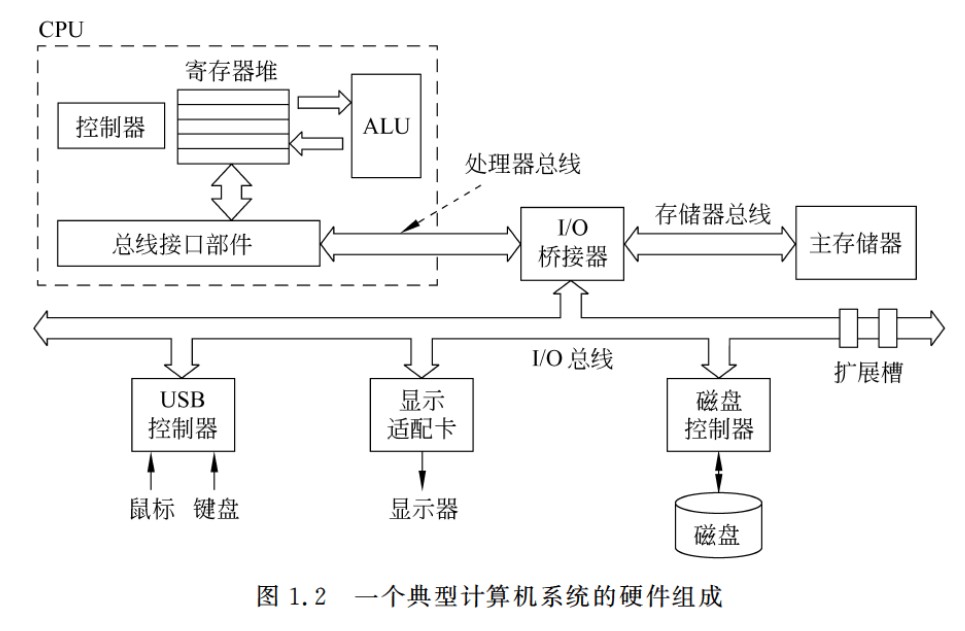

经典计算机系统的硬件组成

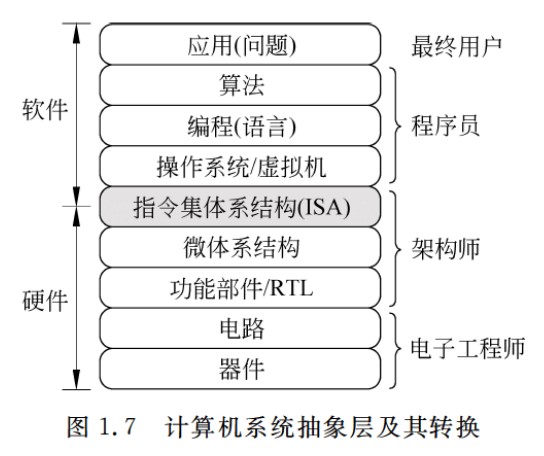

计算机系统抽象层的转换

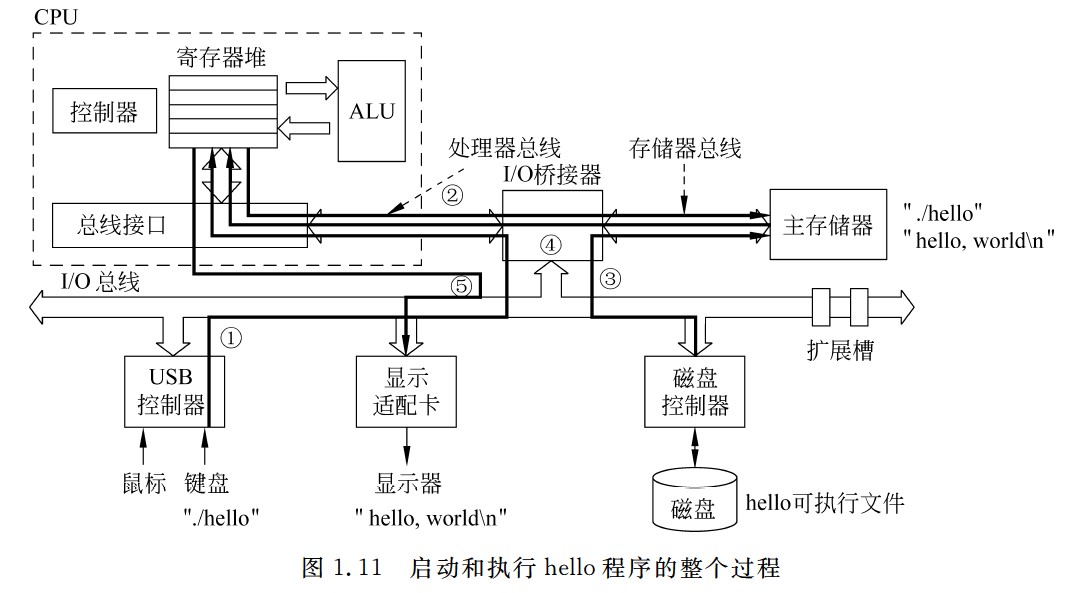

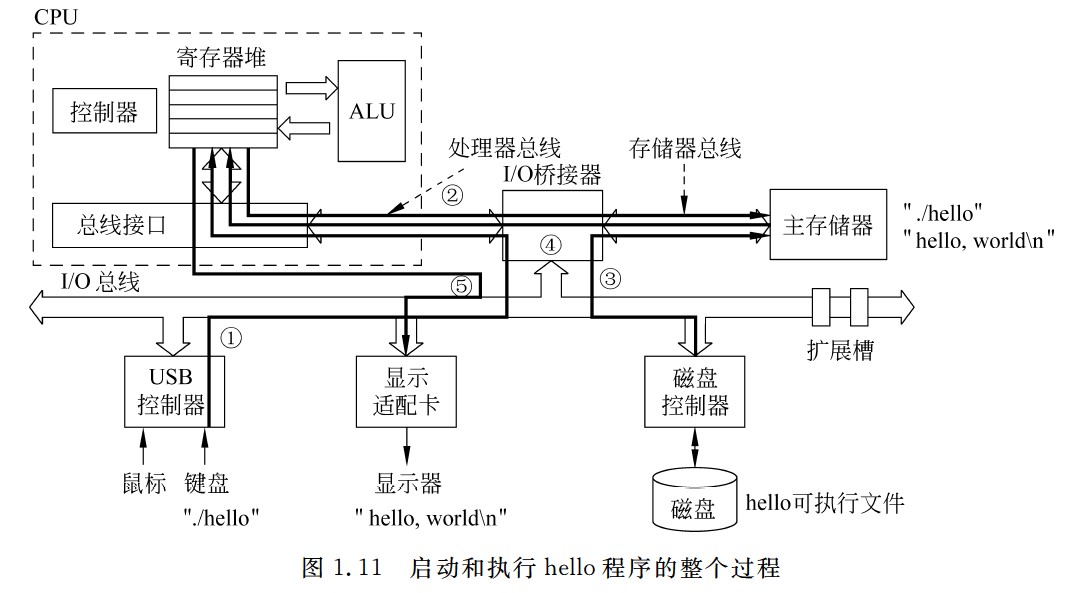

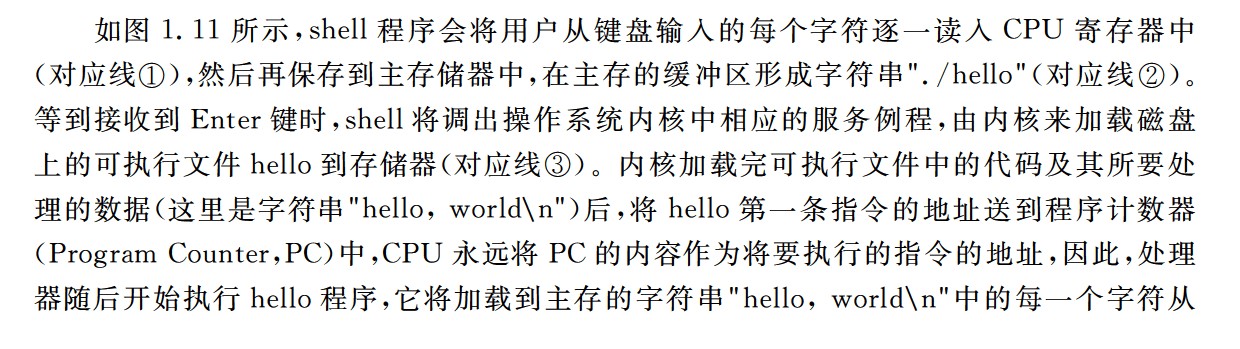

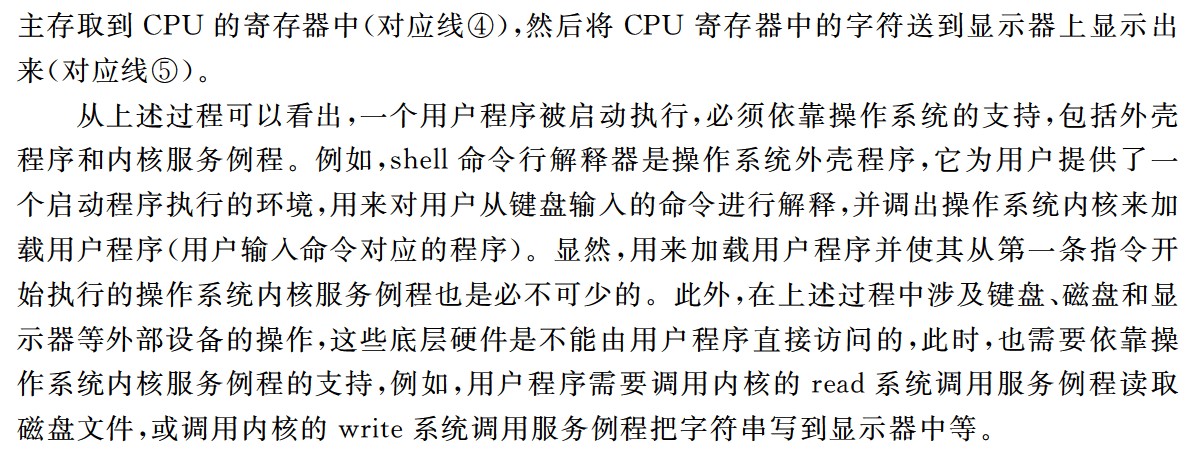

启动和执行hello程序的整个过程

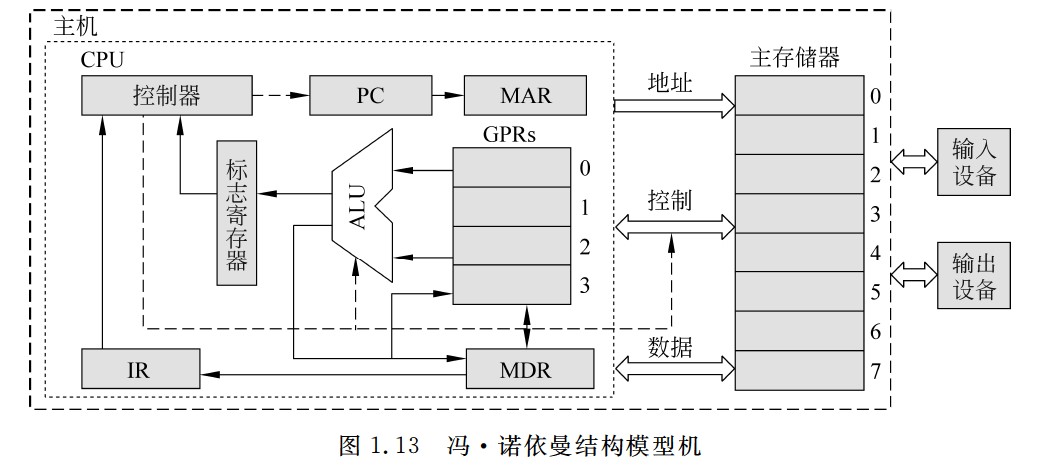

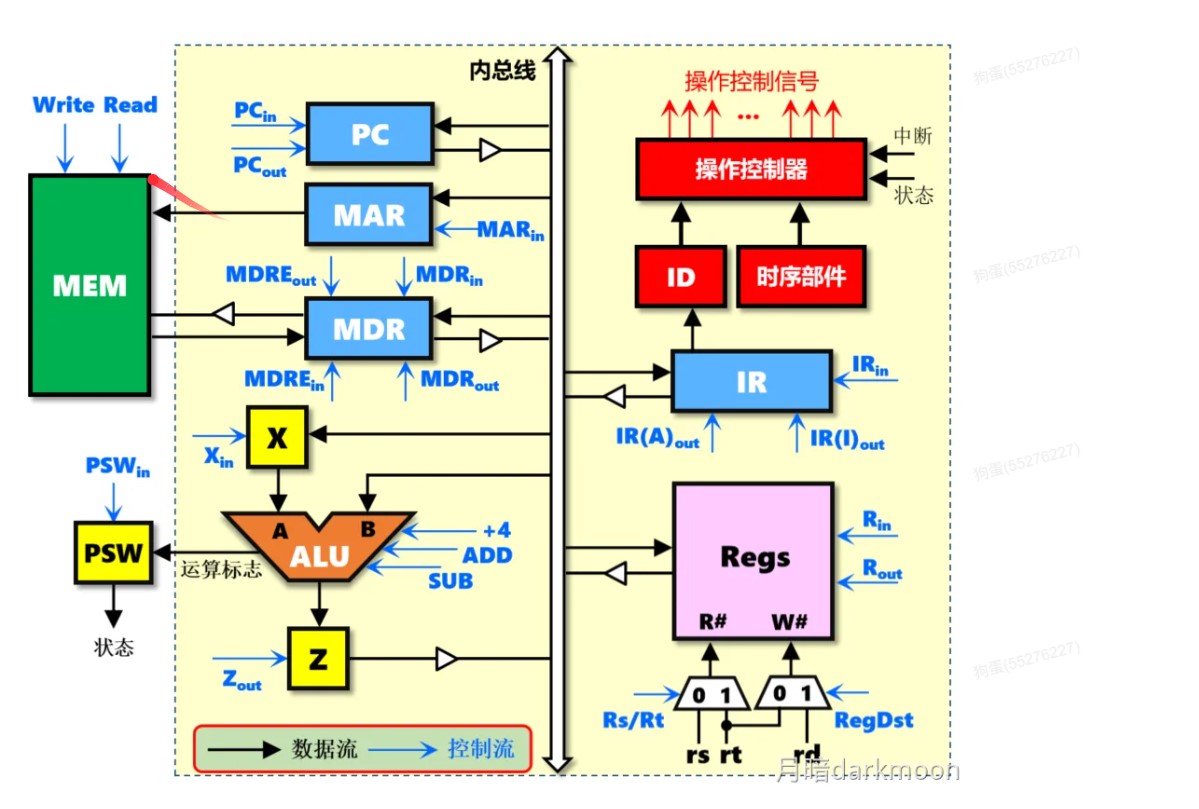

冯诺依曼结构模型机

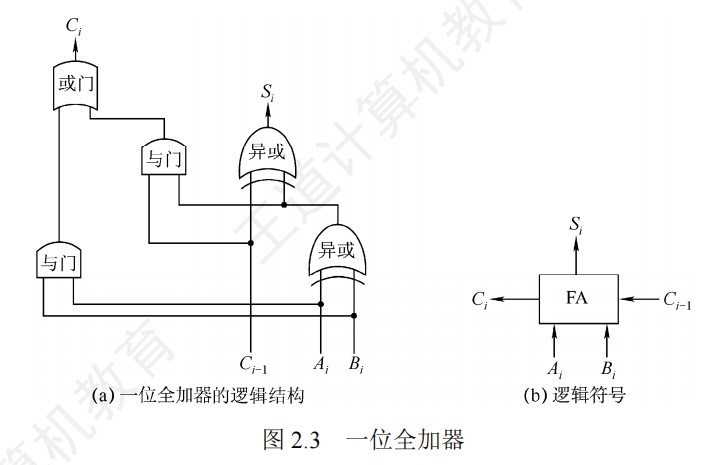

一位全加器

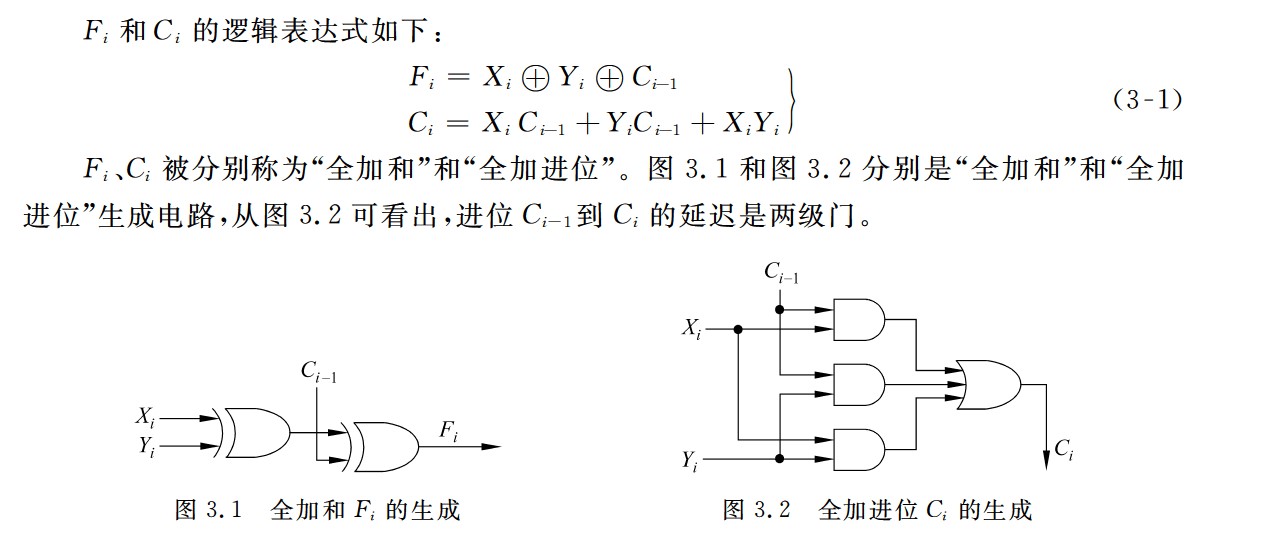

全加和和全加进位

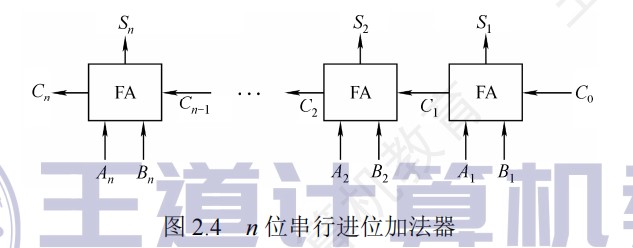

串行进位加法器

- 计算速度主要取决于进位产生和传递的速度

- 每一级进位直接依赖于前一级的进位

- 最长运算时间:由进位信号的传递时间决定

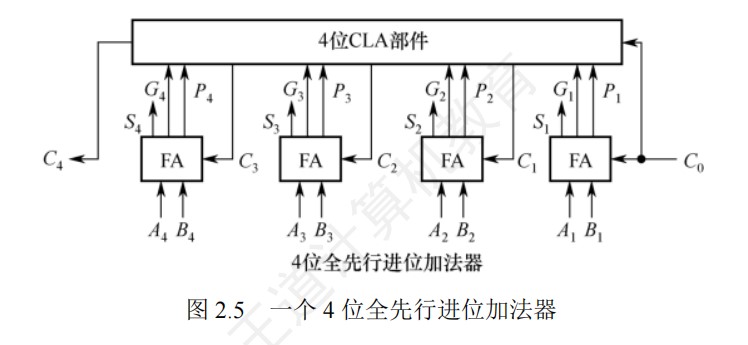

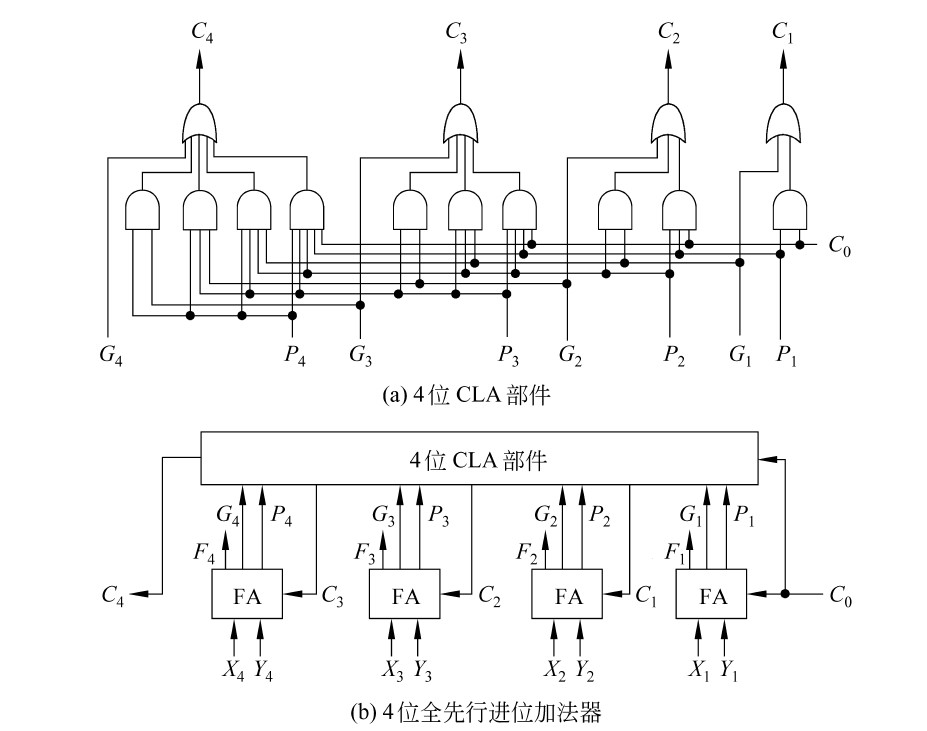

4位全先行进位加法器

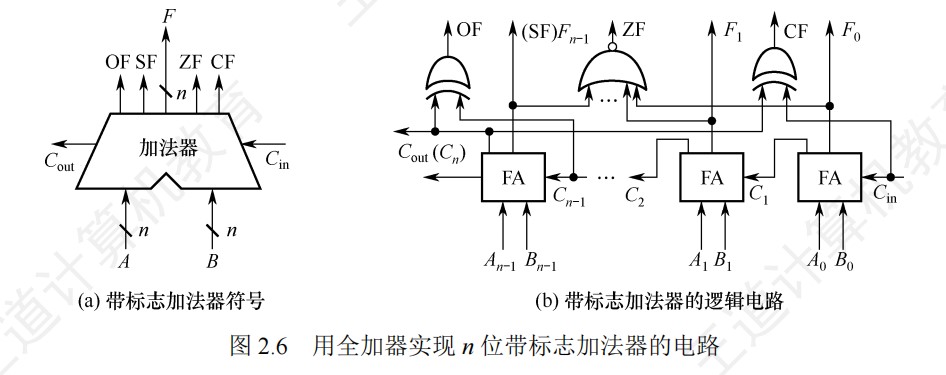

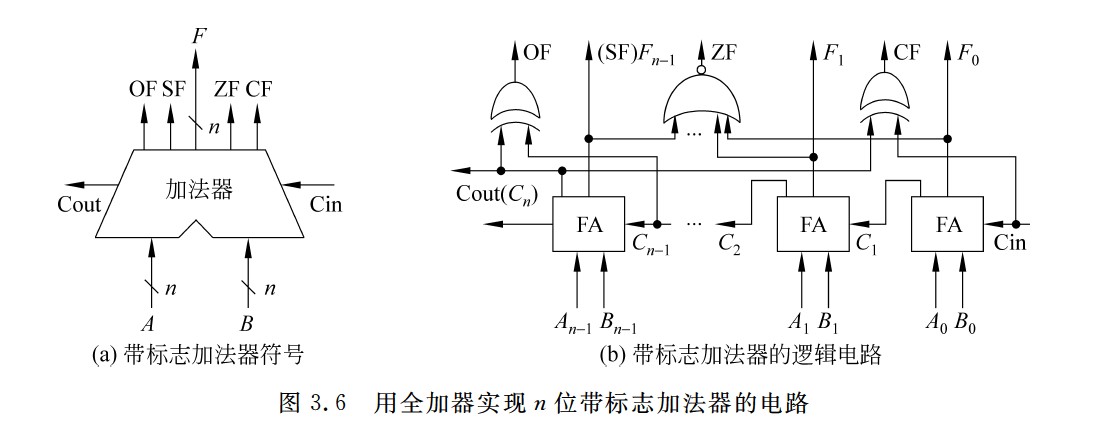

n位带标志加法器

ALU

加减运算部件

32位无符号数乘法的逻辑电路

32位无符号数除法的逻辑电路

32位无符号数除法和乘法的逻辑电路对比

补码一位乘和原码一位乘的电路对比

DRAM芯片的内部结构

主存储器的基本结构

单体多字存储器

高位交叉编址

低位交叉编址

字扩展示意图

位扩展示意图

字位同时扩展示意图

磁盘驱动器

Cache的工作原理

直接映射

全相联映射

组相联映射

Cache行的存储容量示意图

虚拟存储器的三个地址空间

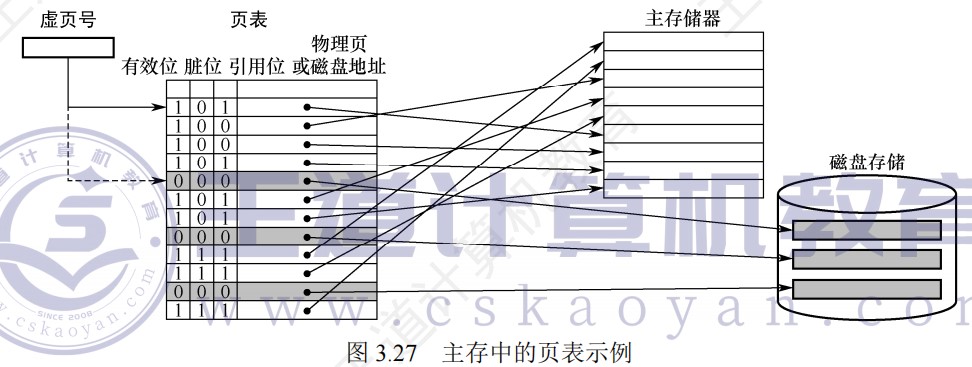

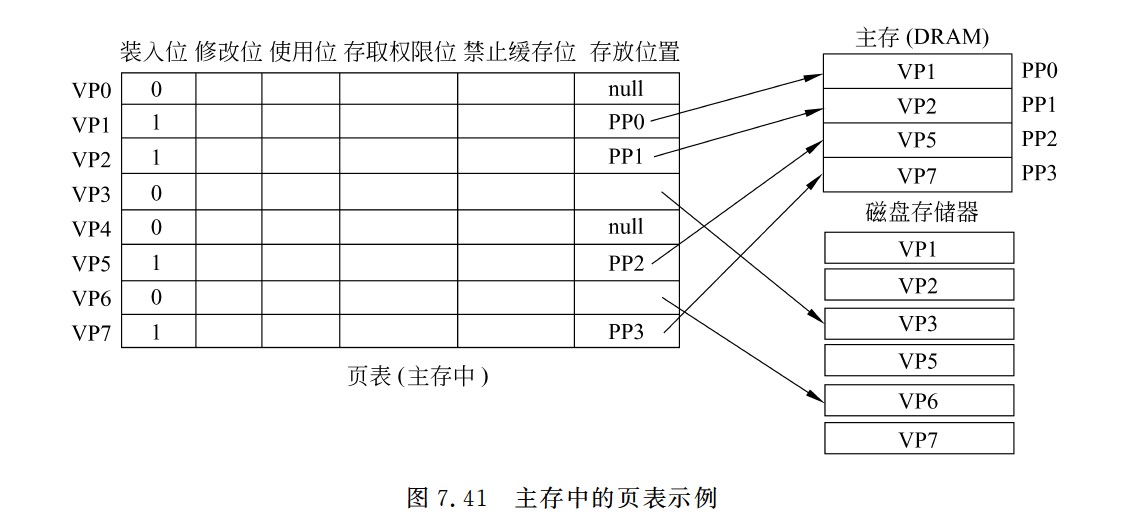

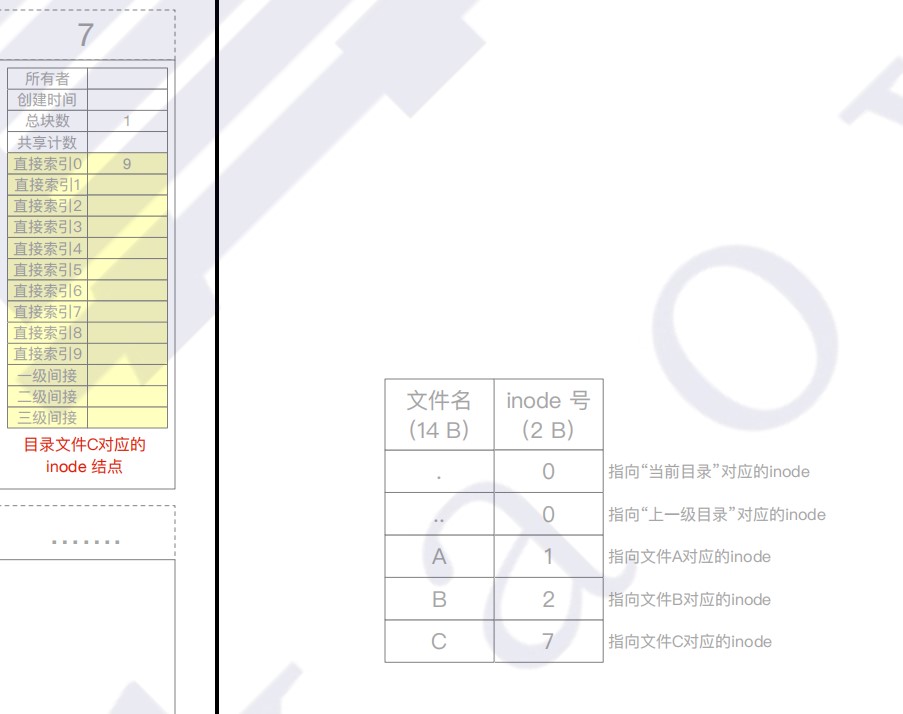

主存中的页表示例

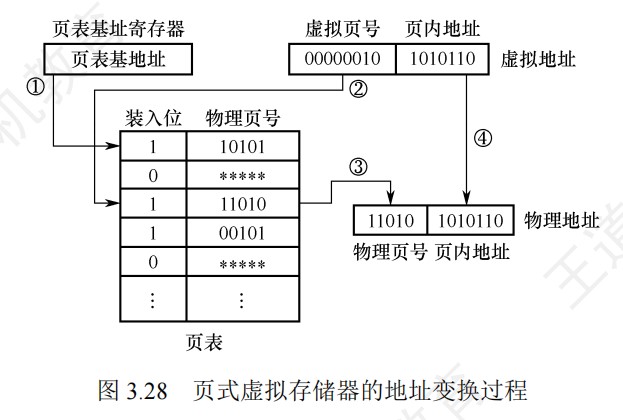

页式虚拟存储器的地址变换过程

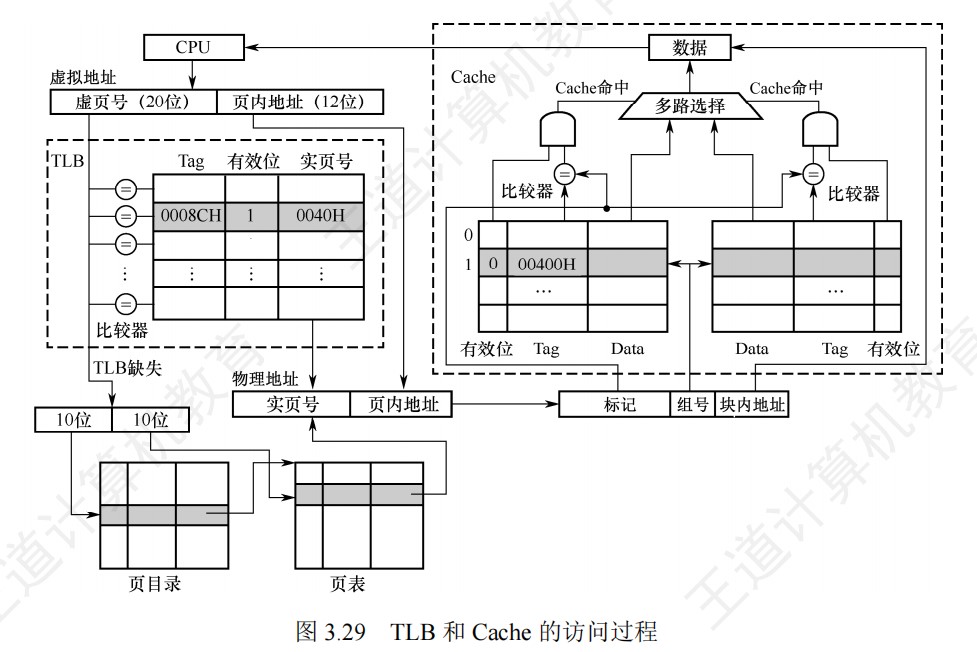

TLB和Cache的访问过程

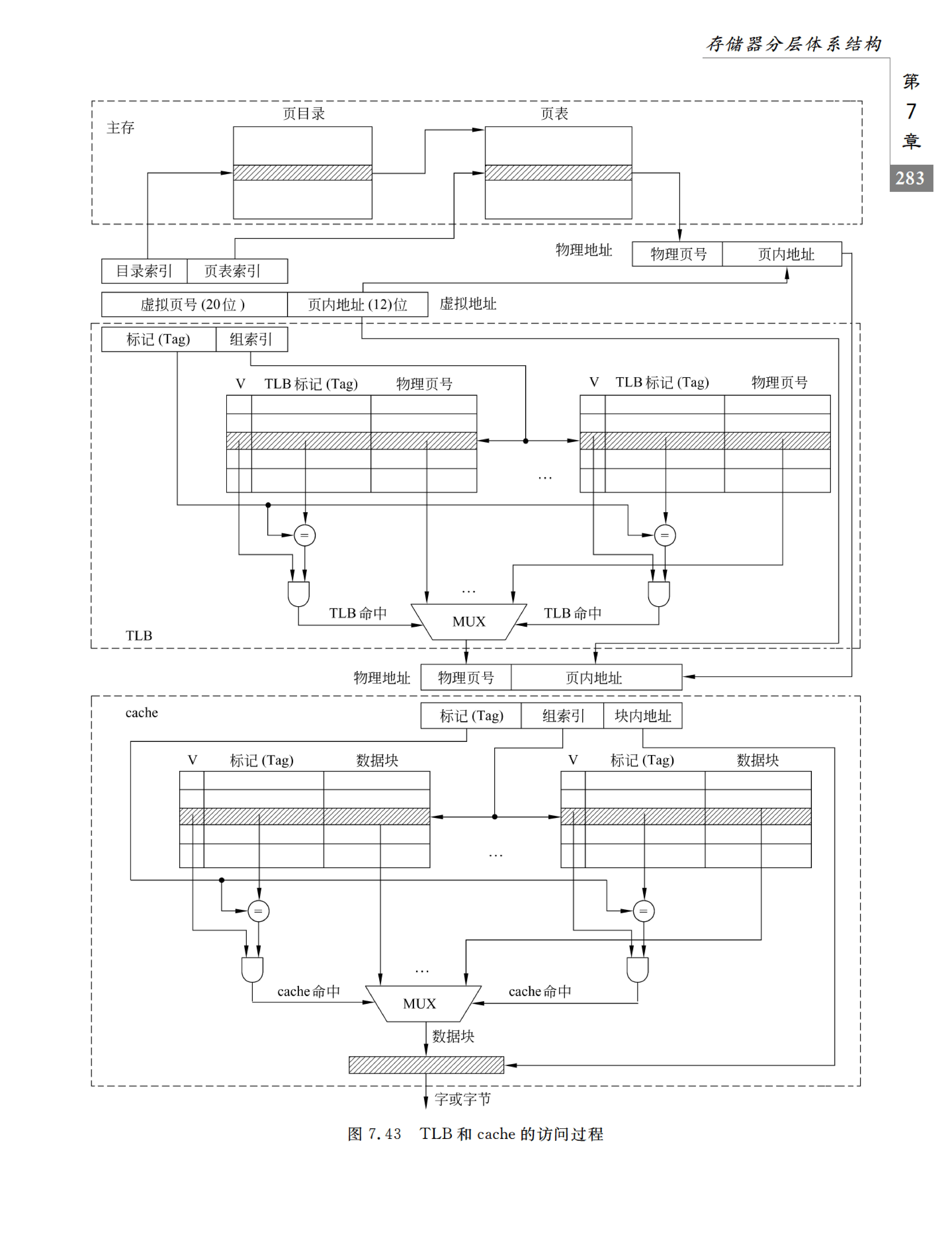

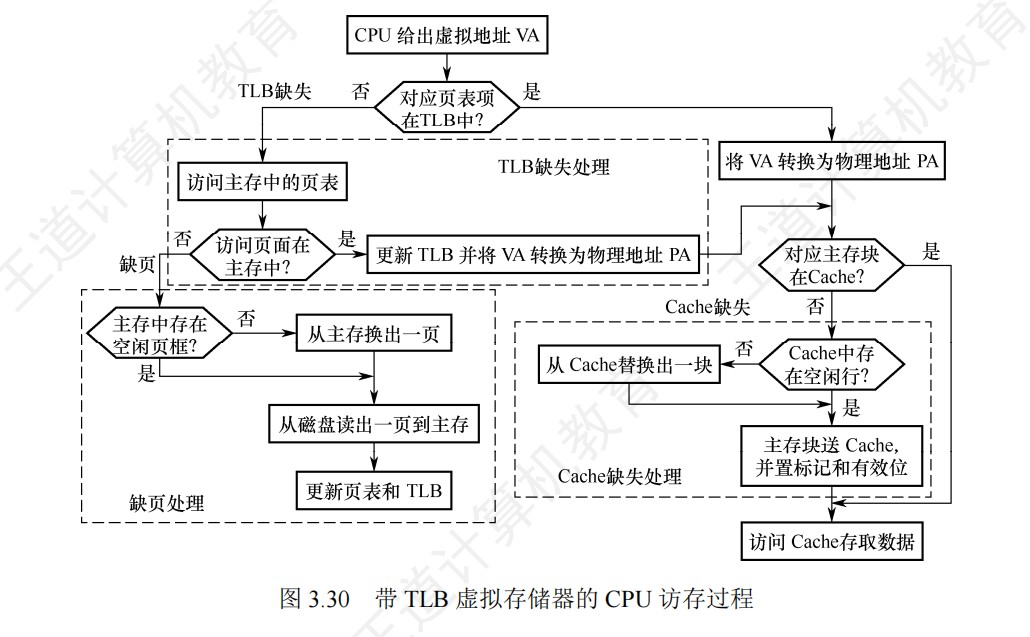

带TLB虚拟存储器的CPU访存过程

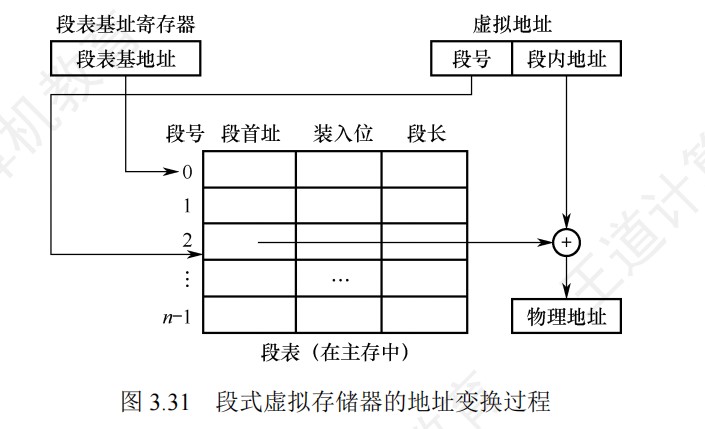

段式虚拟存储器的地址变换过程

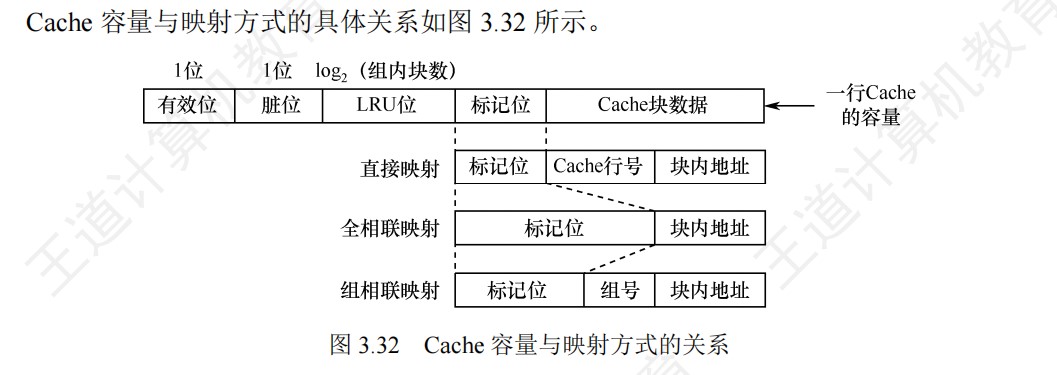

Cache容量与映射方式的关系

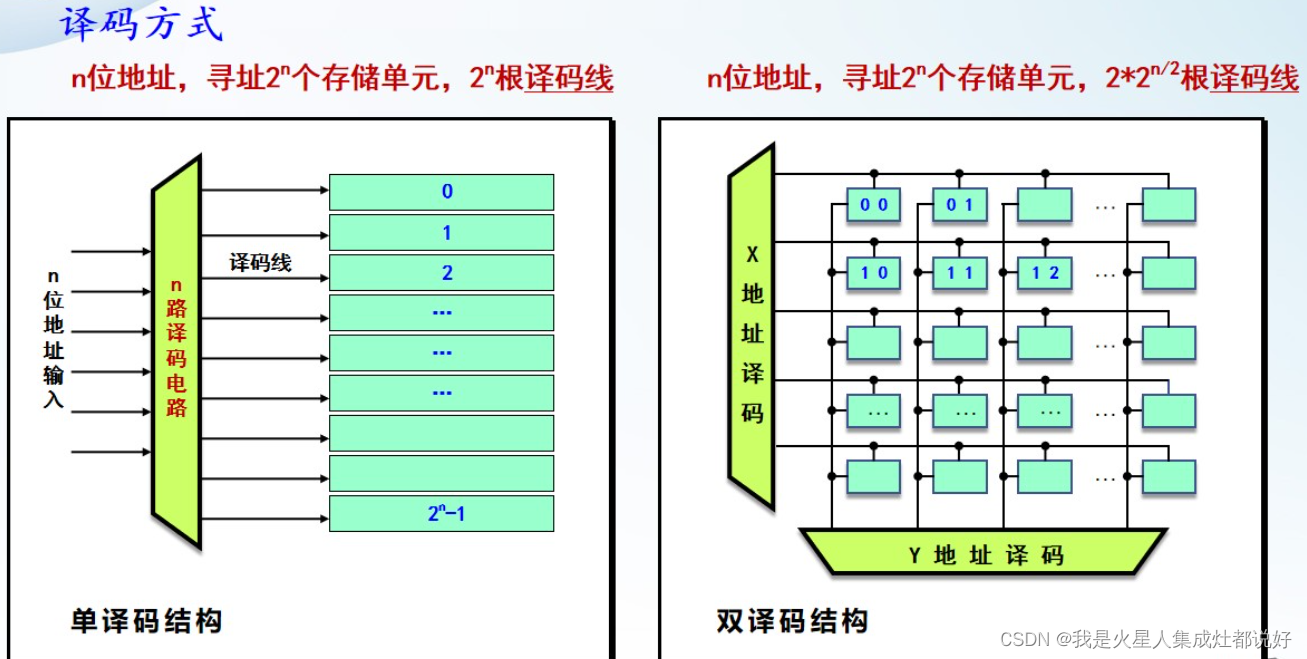

译码方式

DRAM芯片

主存和CPU的连接

DRAM芯片的扩展

带Cache的CPU的访存操作过程

直接映射方式的实现

组相联映射方式的硬件实现

主存块在主存-总线-Cache之间的传送过程

内存条和内存条中芯片排列示意图

进程的存储映像

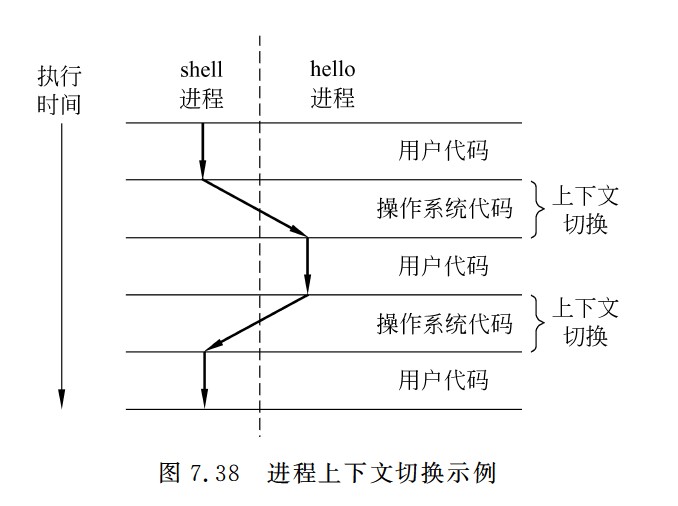

进程上下文切换示例

Linux虚拟地址空间

主存中的页表示意

寻址方式汇总

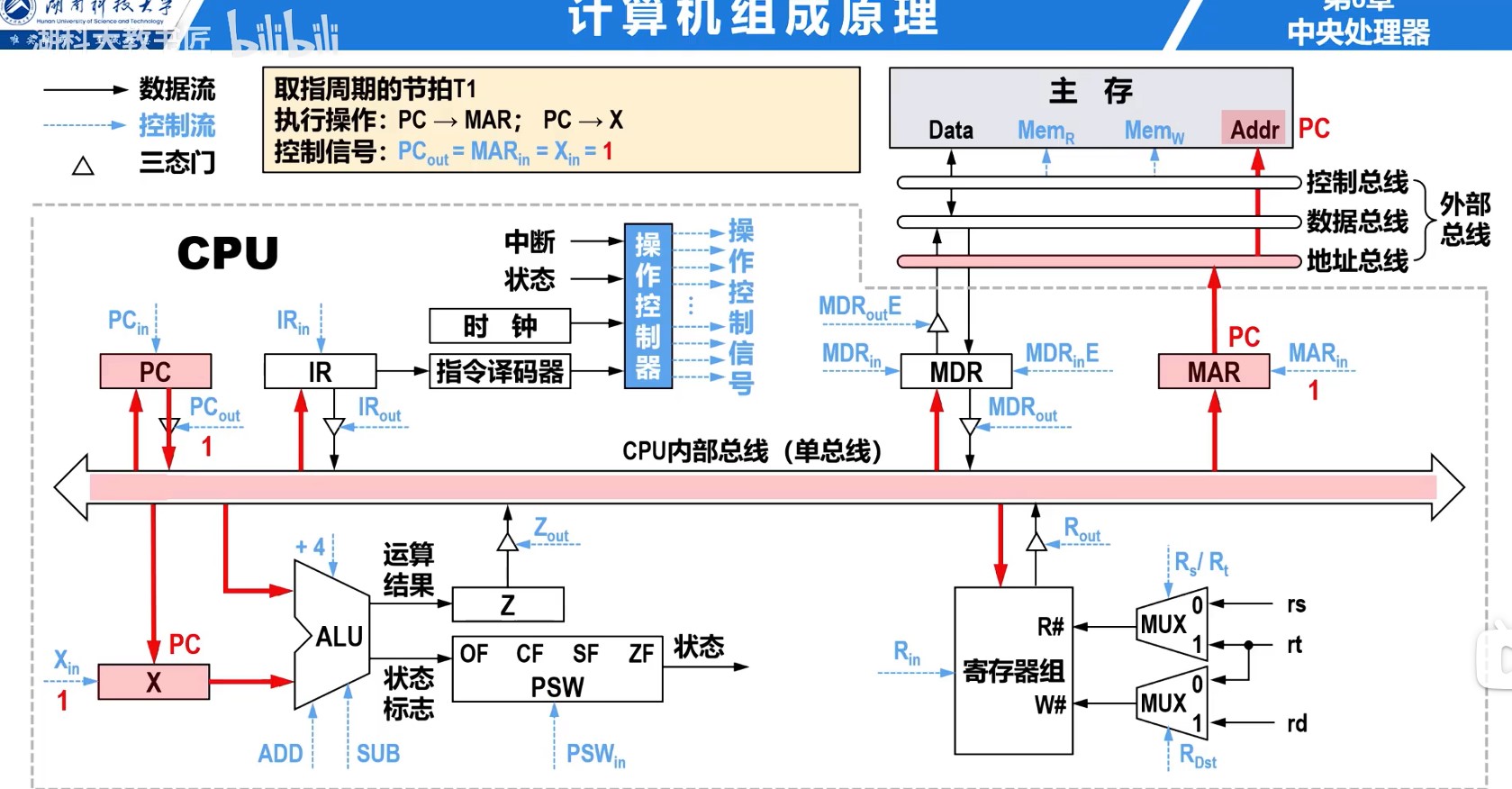

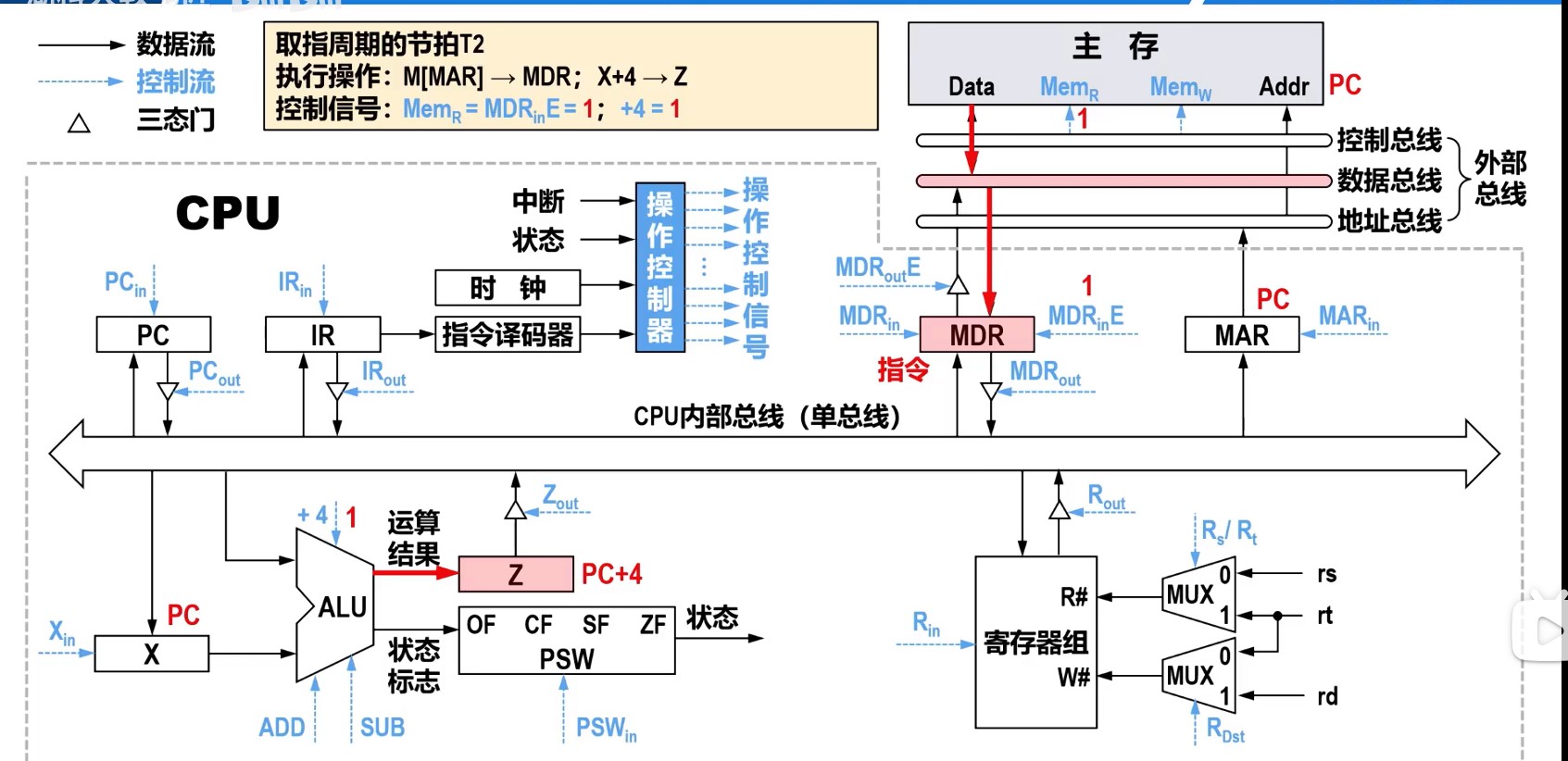

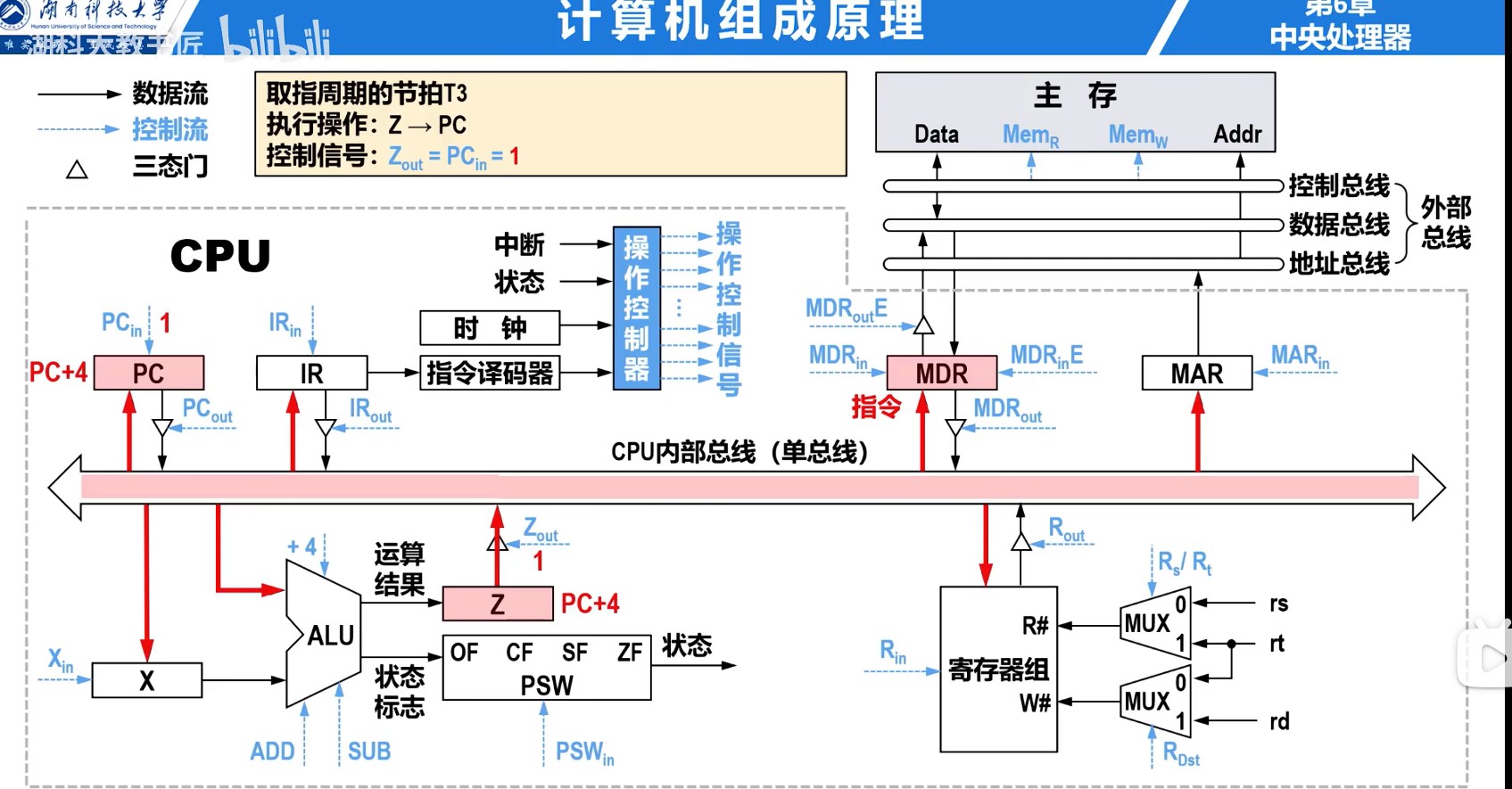

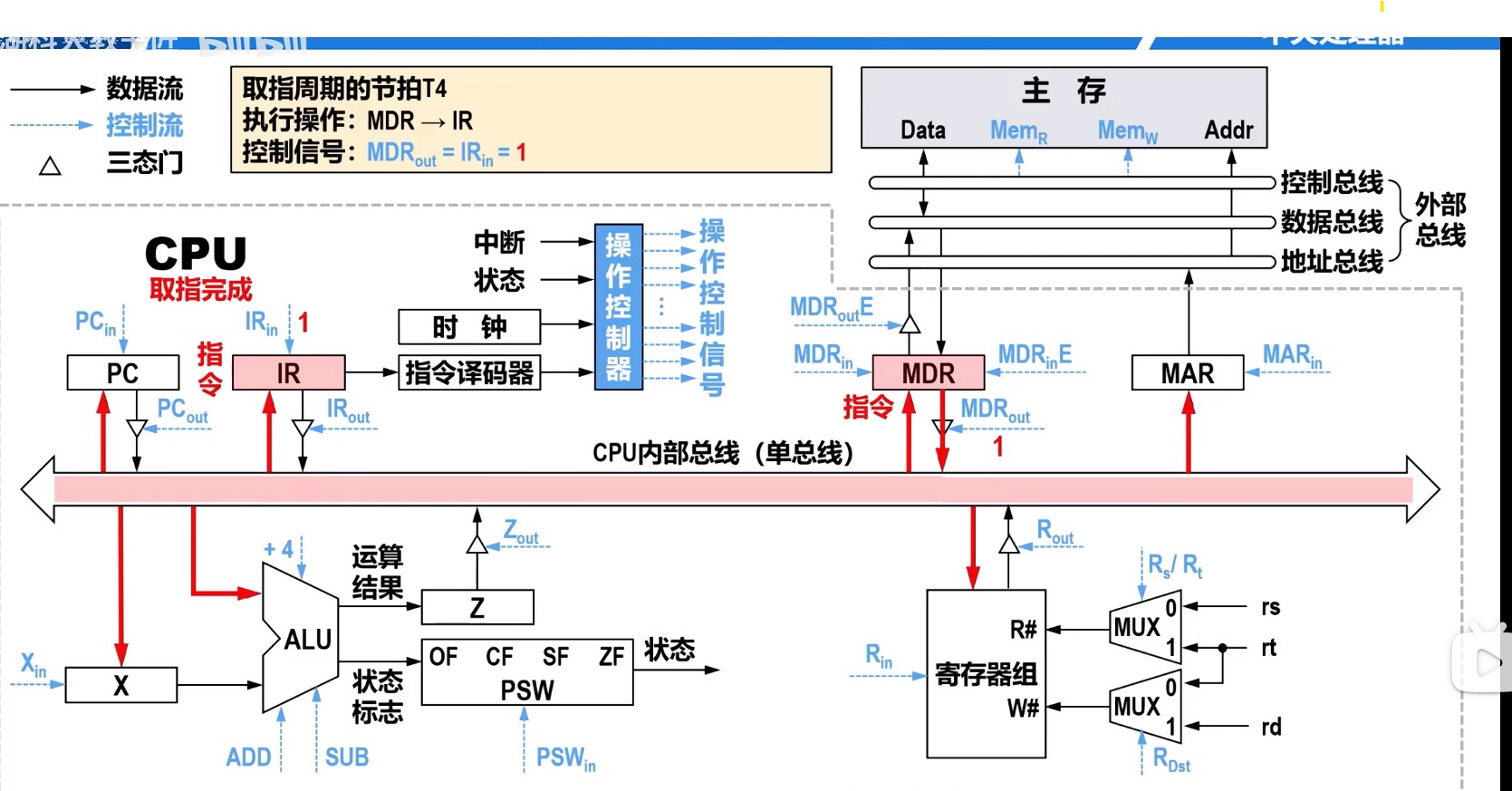

取指周期的数据流

间址周期的数据流

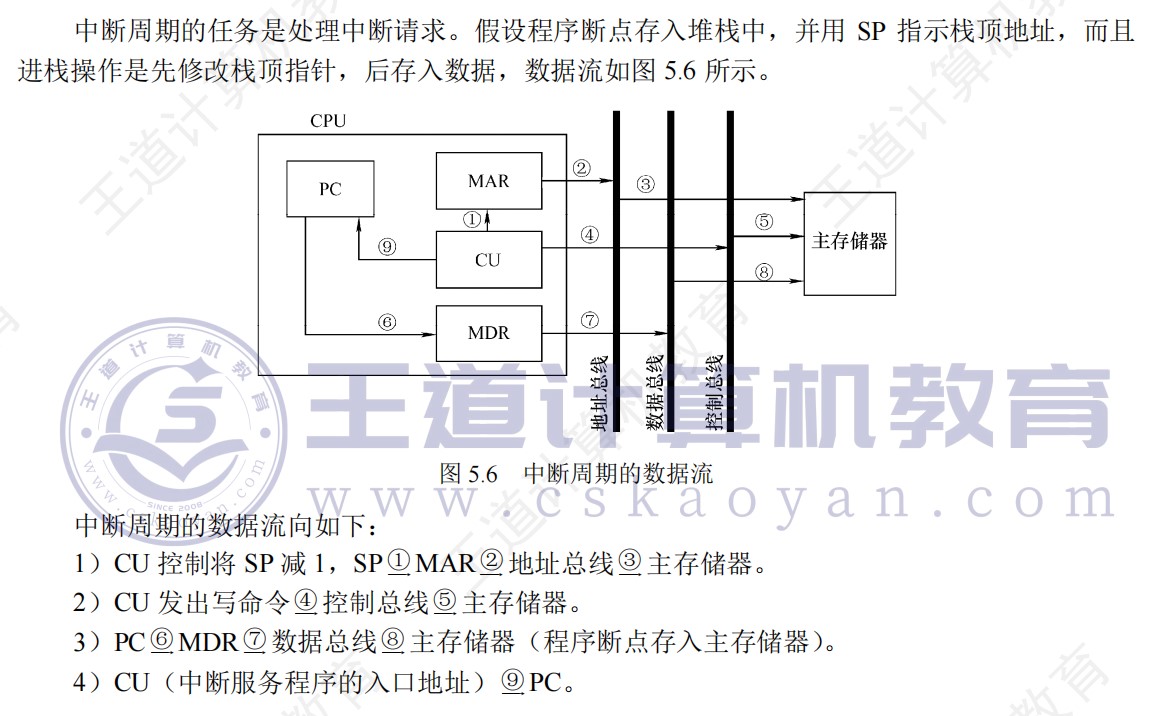

中断周期的数据流

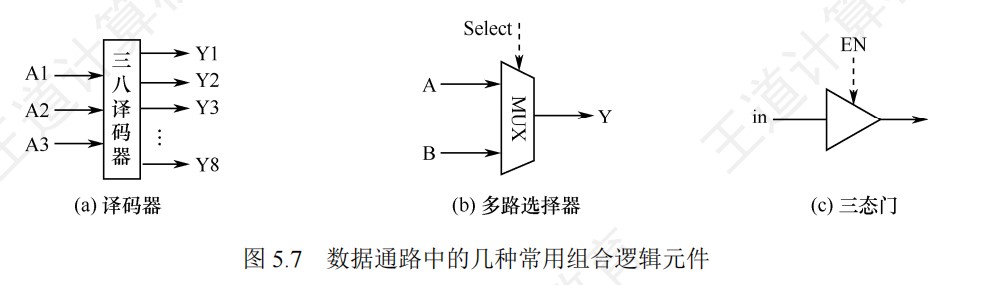

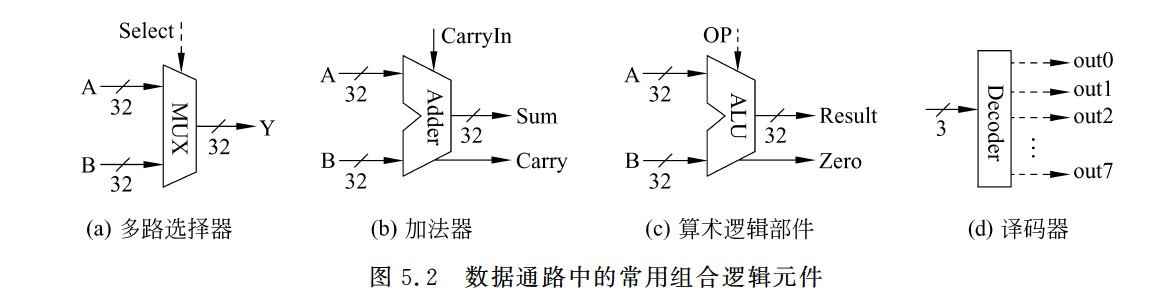

数据通路中几种常用组合逻辑元件

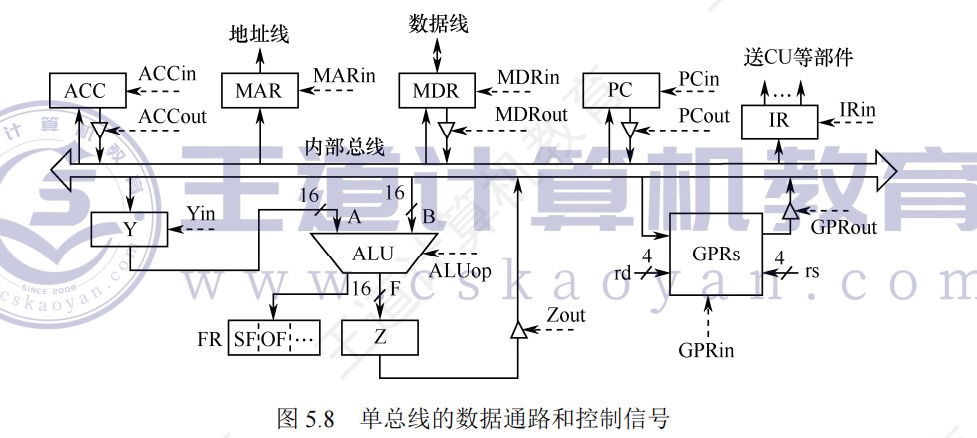

单总线的数据通路和控制信号

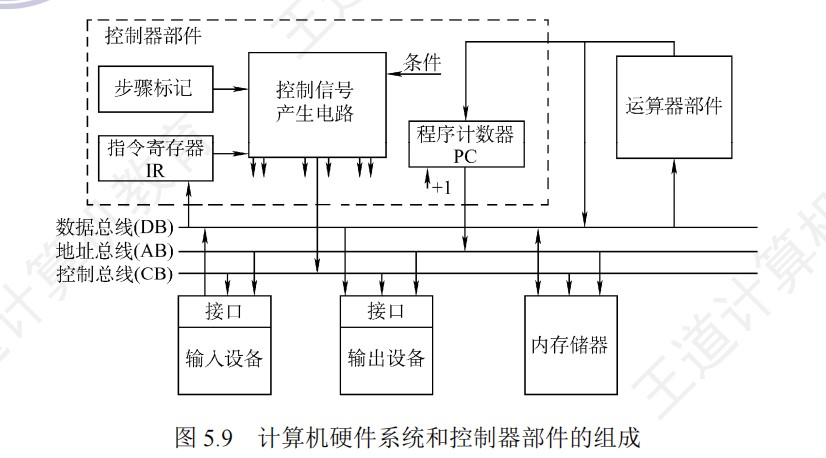

计算机硬件系统和控制器部件组成

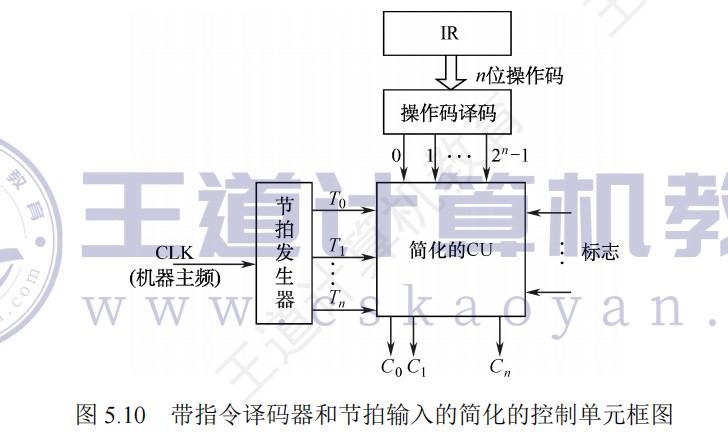

带指令译码器和节拍输入的简化的控制单元

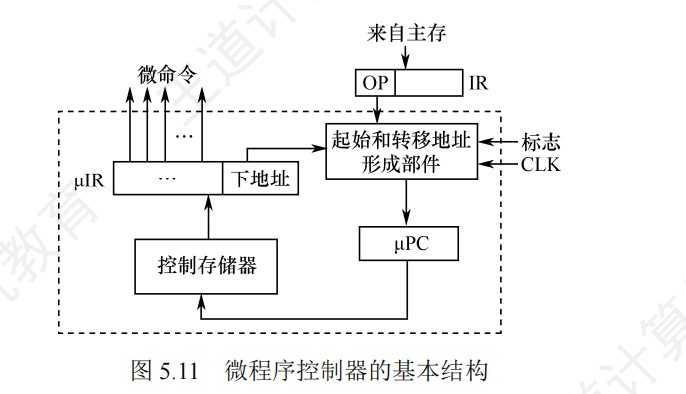

微程序控制器的基本结构

流水线的逻辑结构图

不同类型指令在各流水段中的操作

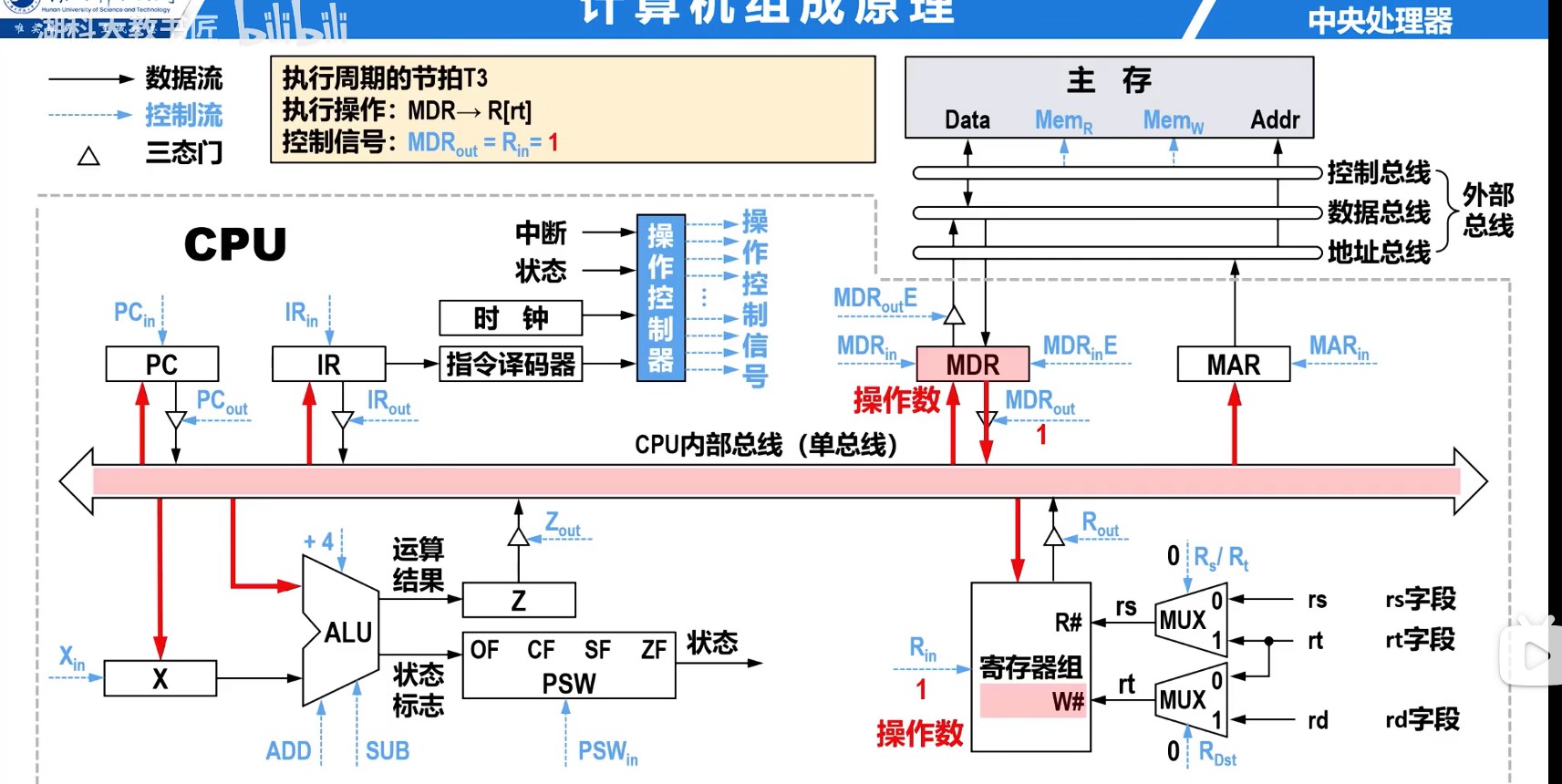

CPU基本组成原理图

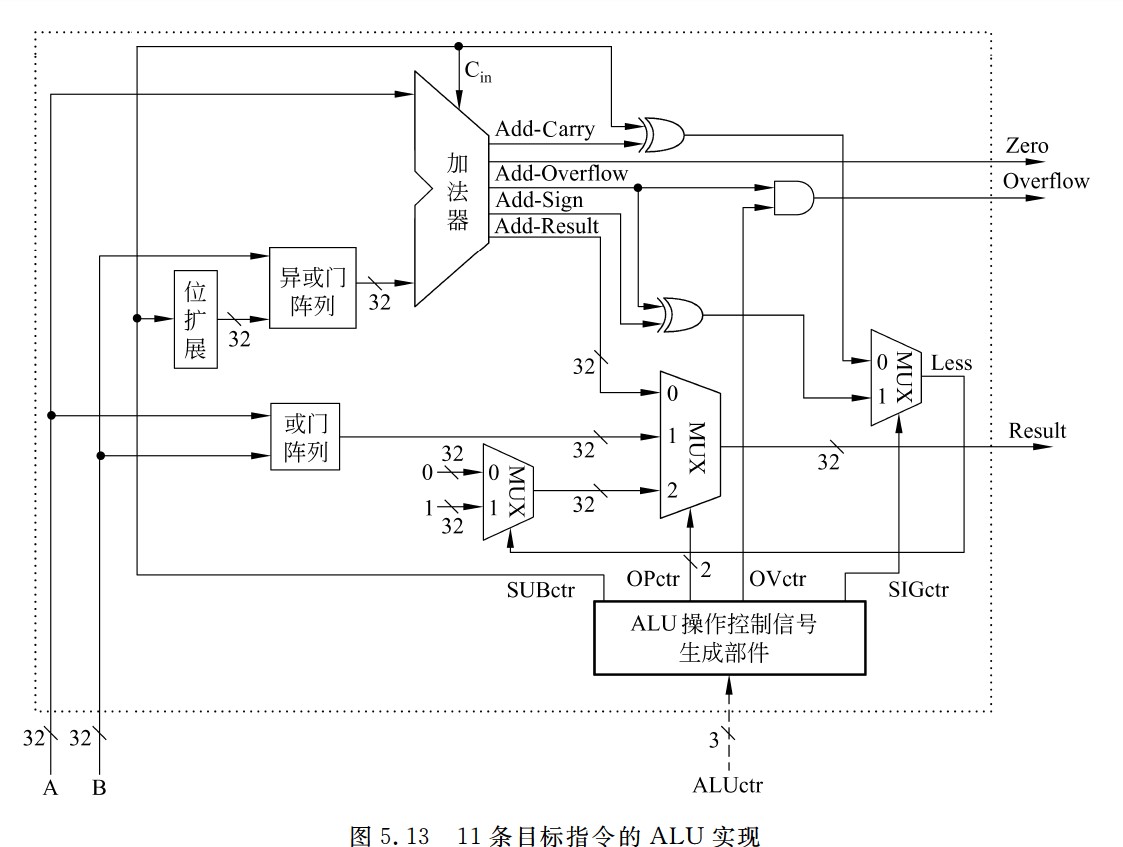

11条目标指令的ALU实现

- 图中异或门阵列,减数同1进行异或,相当于取反

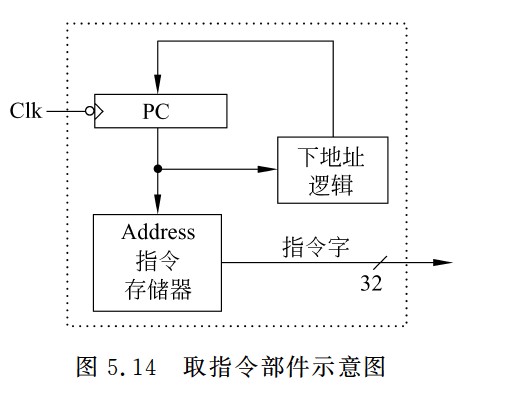

取指令部件示意图

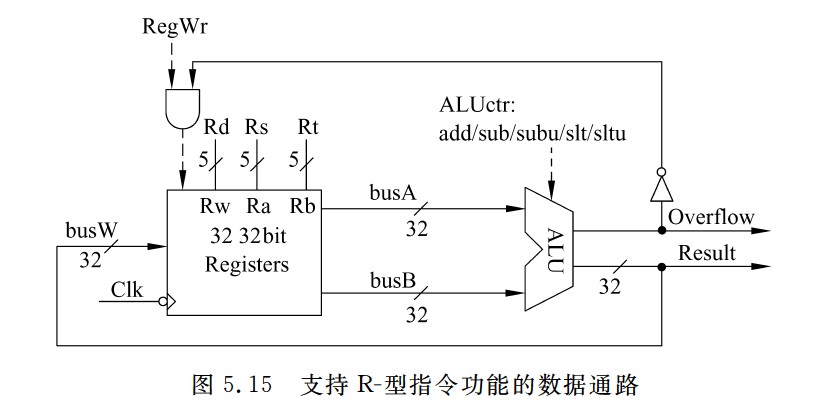

支持R-型指令功能的数据通路

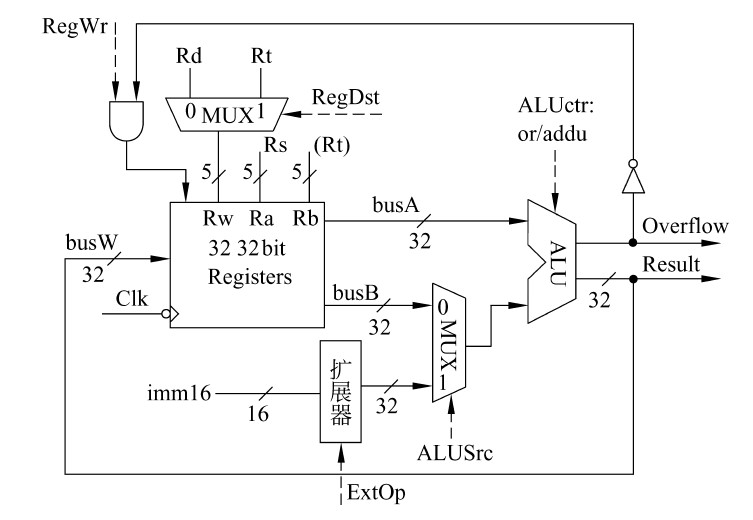

立即数运算指令的数据通路

- 对于按位逻辑运算,应采用0扩展,对于算术运算,应采用符号扩展,因此,在数据通路中应该增加一个扩展器,由控制信号ExtOp控制进行符号扩展还是零扩展。

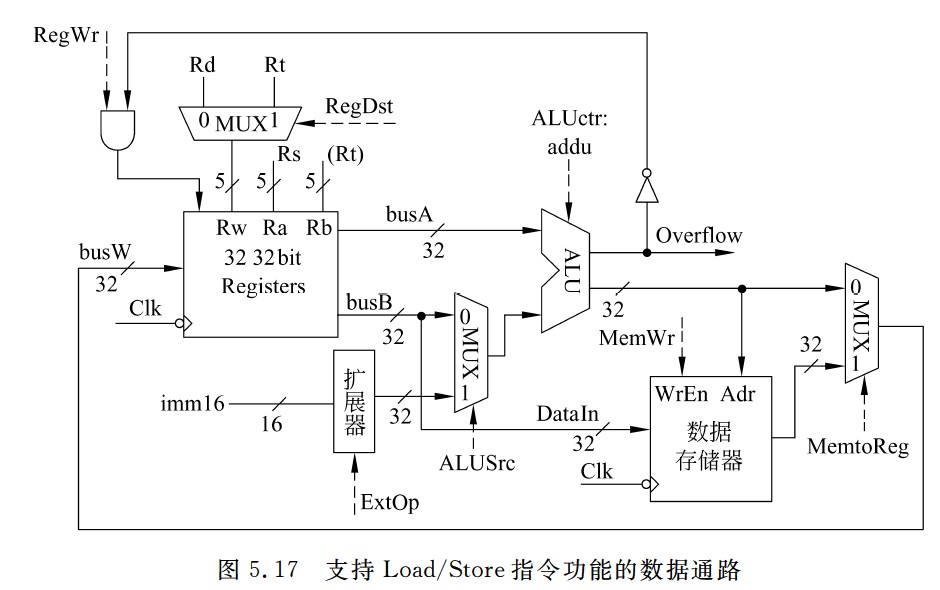

Load/Store指令的数据通路

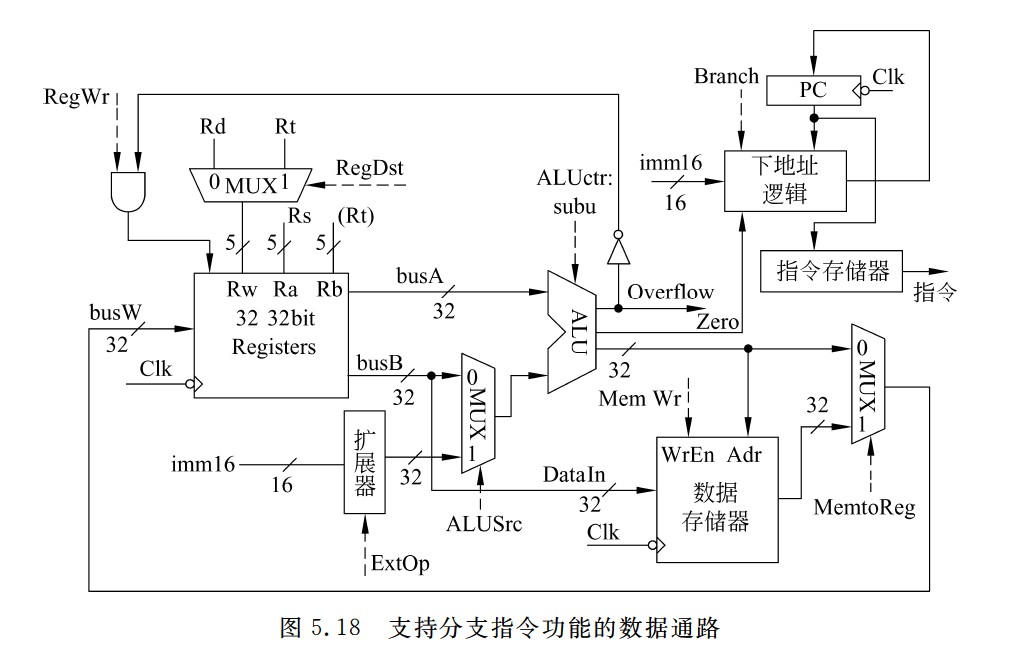

支持分支指令功能的数据通路

- 对于转移目标地址的计算,需要先对立即数imm16进行符号扩展再乘以4,然后和基准地址PC+4相加,所以,ALU的输出Zero标志需送到下地址逻辑,立即数imm16和PC也要送到下地址逻辑,控制信号Branch表示当前指令是否是分支指令,也应该送到下地址逻辑,以决定是否按分支指令方式计算下一条地址。

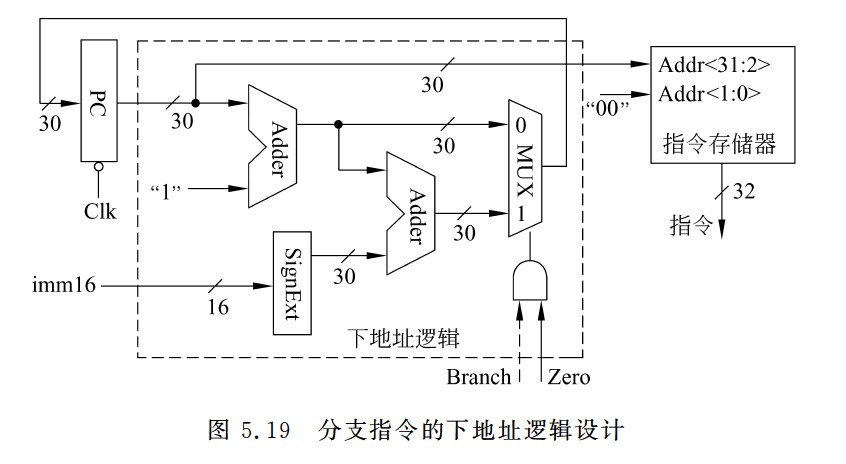

- 因为指令长度32位,主存按照字节编址,所以指令地址总是4的倍数,即最后两位总是00,因此,PC中只需存放前30位地址,即PC<31 : 2>

- 因此符号扩展x4也是为了地址对齐,必须左移2位,否则产生的地址低2位不是00,会导致非对齐访问异常,这不是合法的指令地址。

分支指令的下地址逻辑设计

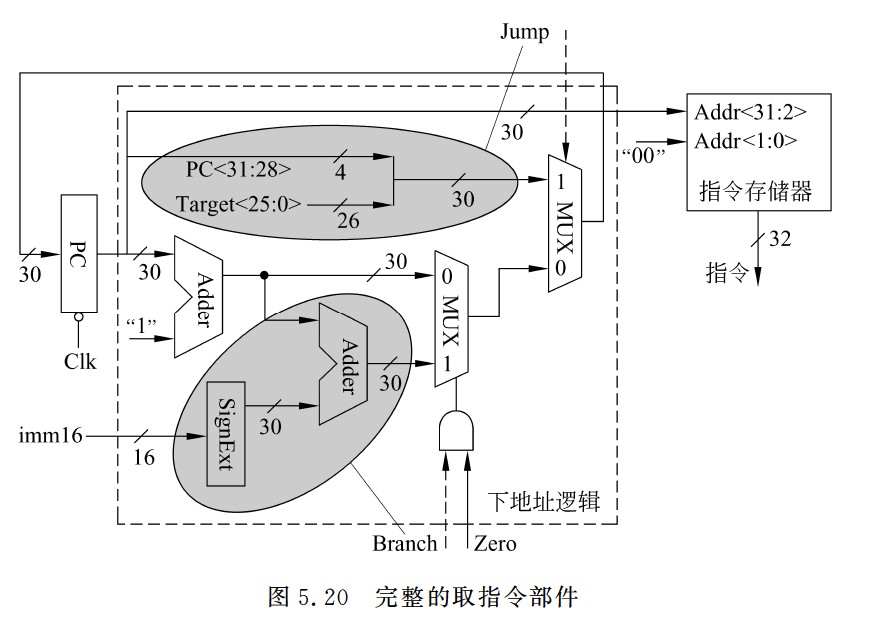

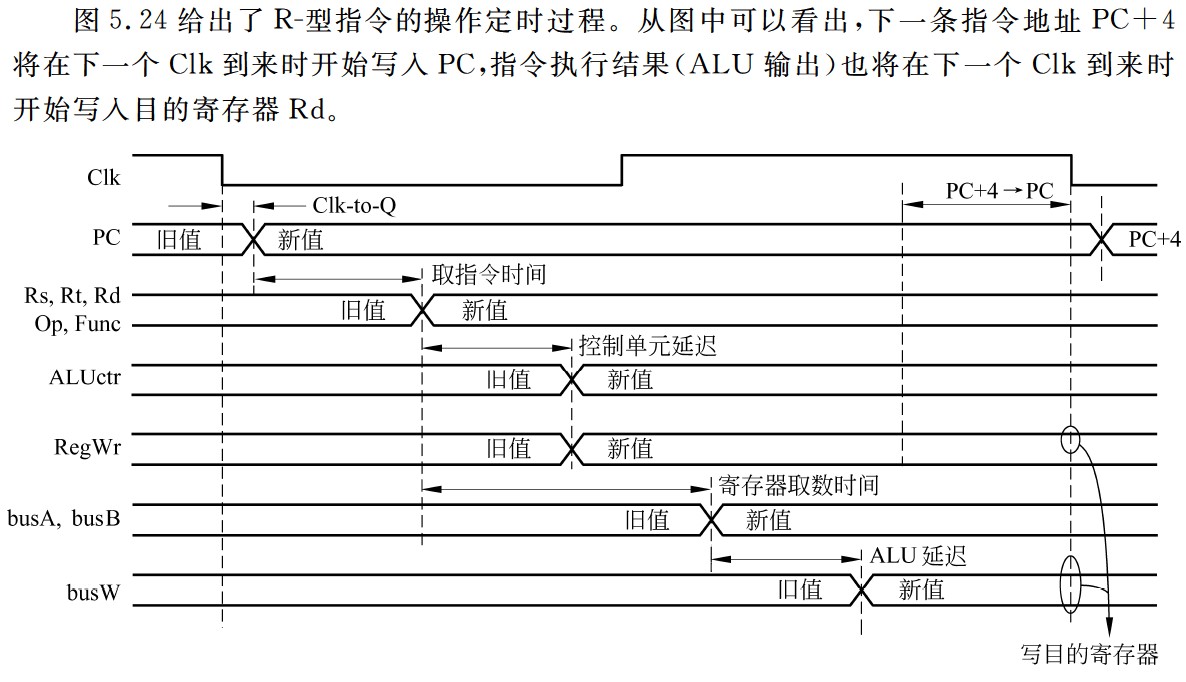

完整的取指令部件

- 取指令阶段开始时,新指令还未被取出和译码,因此取指令部件中的控制信号的值还是上一条指令产生的旧值,此外,新指令还未被执行,因而标志也为旧值。但是,由这些旧控制信号值确定的地址只被送到PC输入端,并不会写入PC,因此不会影响取指令功能。只要保证在下一个时钟Clk到来之前能产生正确的下一条指令地址即可。单周期方式下,所有指令都在单个时钟周期内完成执行,因而下一个时钟会在足够长的时间(最长的指令周期)后到来,此时,控制信号早就是新取出的当前指令对应的控制信号了,因而,取指令部件能得到正确的下一条指令地址,并在下一个时钟到来之前被送到PC的输入端,一旦下一个时钟到来后,该地址开始写入PC,并作为新指令的地址从指令存储器中取出新的指令。

- 取指令部件的输出是指令,输入有3个:标志Zero,控制信号Branch和Jump。下地址逻辑中的立即数imm16和目标地址target<25:0>都直接来自取出的指令。

- 分支指令执行阶段

- 其数据在数据通路中的执行路径为:

- Register File(Rs,Rt)→busA,busB→ALU(subu)→Zero标志→取指令部件

- beq指令各控制信号的取值如下:

- Branch=1,

- Jump=0,

- RegDst=x,

- ALUsrc=0,

- ALUctr=subu,

- MemtoReg=x,

- RegWr=0,

- Mem Wr=0,

- ExtOp=x。

- 其数据在数据通路中的执行路径为:

- 无条件转移指令执行阶段

- 在11条指令中,无条件转移指令最简单,除了改变PC的值外,不做任何其他工作。因此,只在取指令部件中由控制信号Jump控制下一条指令地址的计算,其控制信号取值只要保证:①Branch=0,Jump=1,以使取指令部件能正确得到下条指令地址;②RegWr=0,MemWr=0,以使寄存器堆和数据存储器在本指令执行时不被写入任何结果。其他控制信号的取值无所谓。

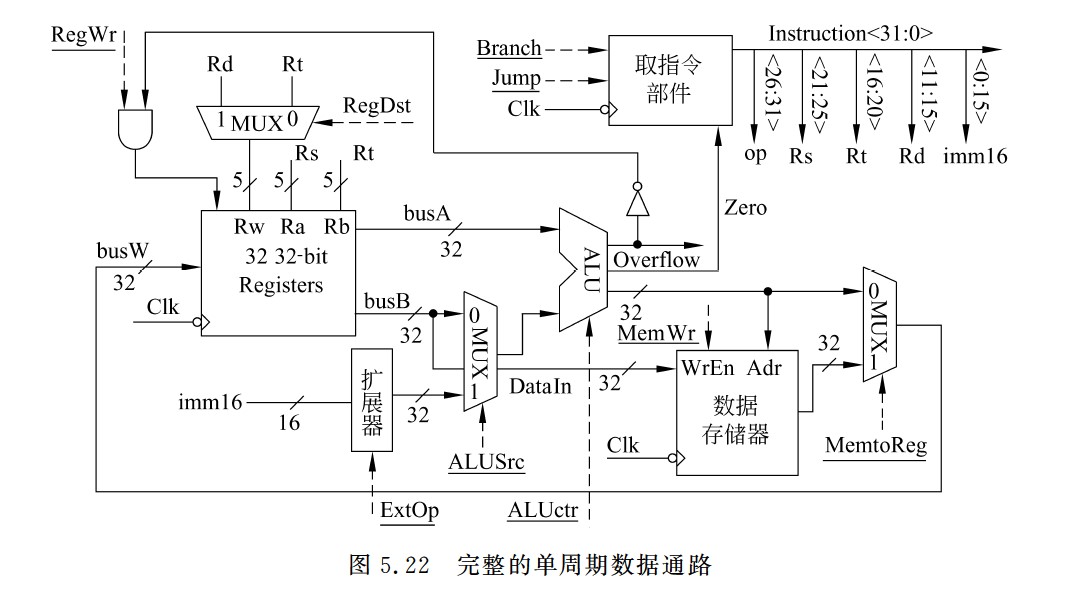

完整的单周期数据通路

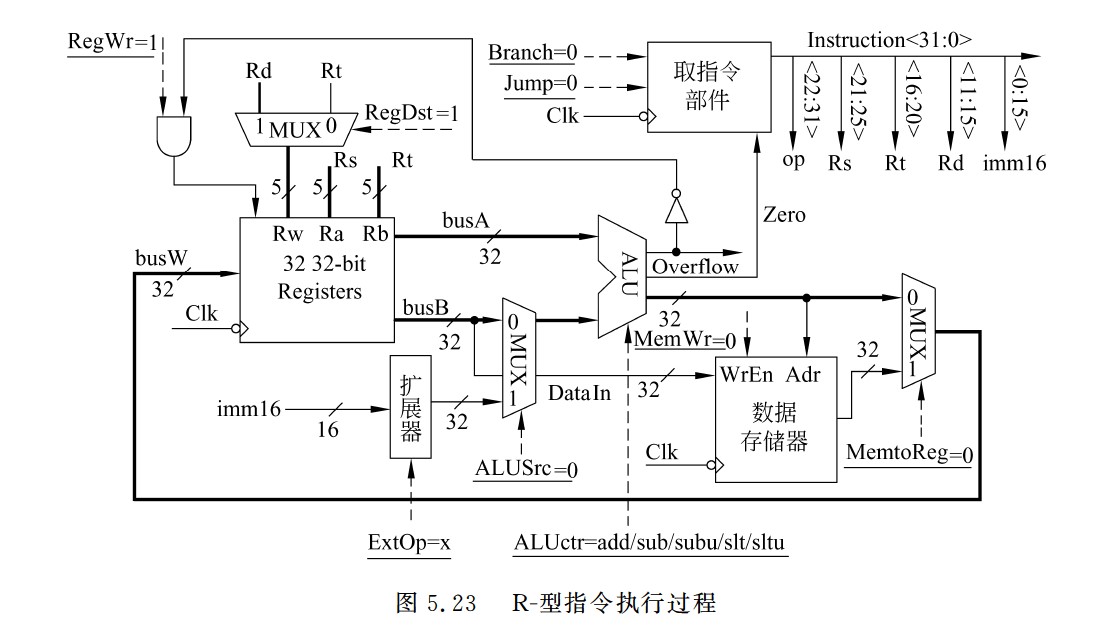

R-型指令执行过程

- 粗线描述了R-型指令的数据在数据通路中的执行路径

- Register File(Rs,Rt)→busA,busB→ALU→Register File(Rd)

- 控制信号的取指分析如下

- Branch=Jump=0:因为不是分支指令和无条件跳转指令。

- RegDst=1:因为R-型指令的目的寄存器为Rd。

- ALUsrc=0:保证选择busB作为ALU的B口操作数。

- ALUctr=add/sub/subu/slt/sltu:5条R-型指令的操作各不相同,因而对应5种类型。

- MemtoReg=0:保证选择ALU输出送到目的寄存器。

- RegWr=1:保证在下个时钟到来时,在不发生溢出的情况下结果被写到目的寄存器。

- MemWr=0:保证在下个时钟到来时,不会有信息写到数据存储器。

- ExtOp=x:因为ALUsrc=0,所以扩展器(Extender)的值不会影响执行结果,故ExtOp取0或1都无所谓。

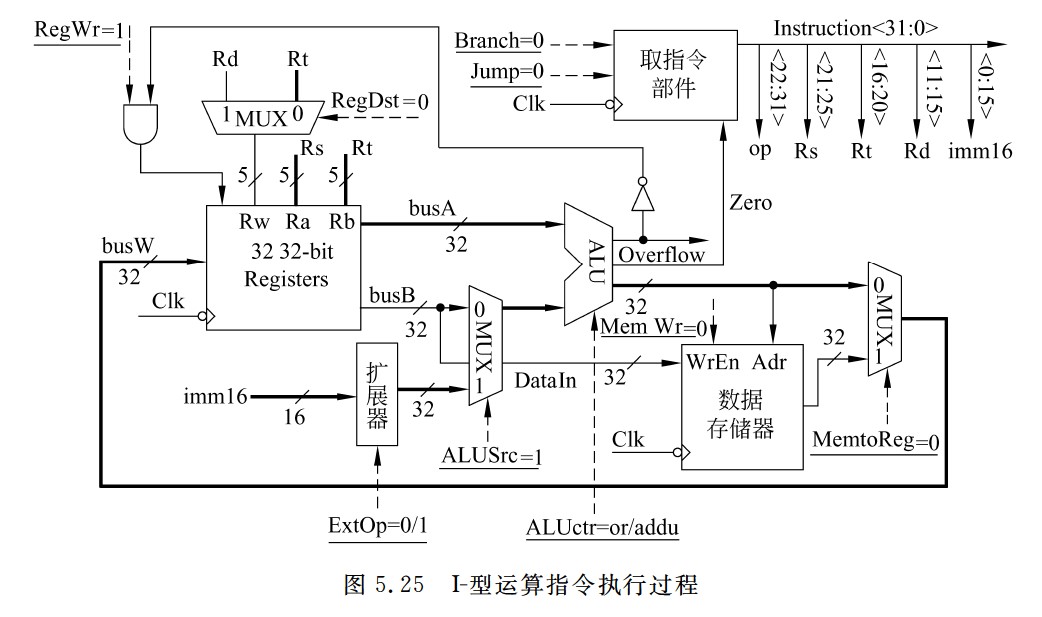

I-型运算指令执行过程

- 其数据在数据通路中的执行路径为:

- Register File(Rs)→busA,扩展器(imm16)→ALU→Register File(Rt)

- 各控制信号的取值如下:

- Branch=Jump=0

- RegDst=0

- ALUsrc=1

- ALUctr=or/addu(ori指令为or,addiu指令为addu)

- MemtoReg=0

- RegWr=1

- MemWr=0

- ExtOp=0/1(ori指令为0,addiu指令为1)

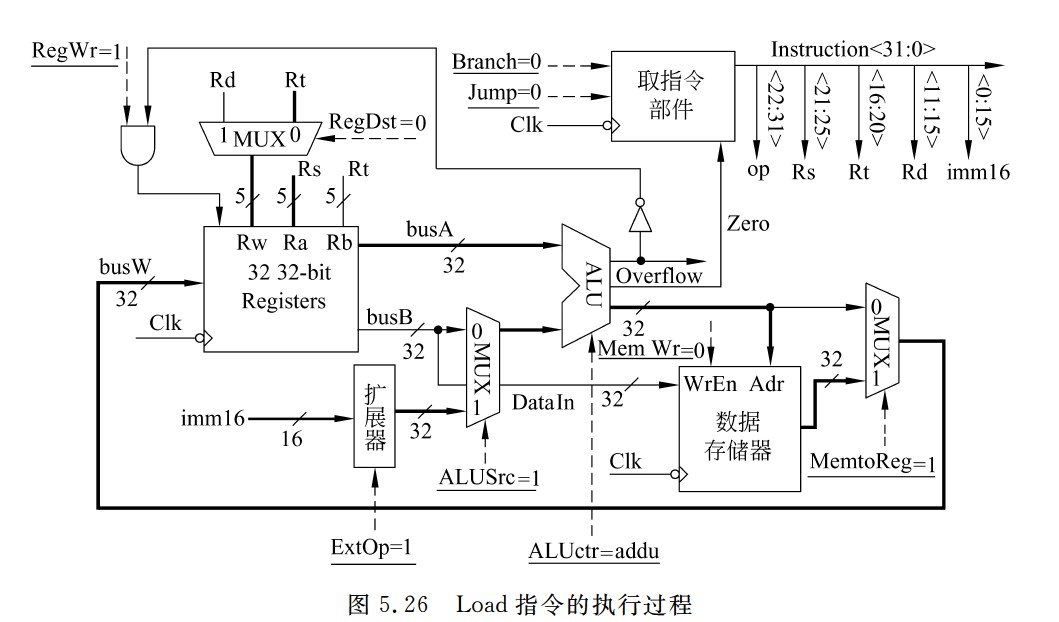

Load指令的执行过程

- 数据在数据通路中的执行路径为:

- Register File(Rs)→busA,扩展器(imm16)→ALU(addu)→数据存储器→Register File(Rt)

- 各控制信号的取值如下:

- Branch=Jump=0

- RegDst=0

- ALUsrc=1

- ALUctr=addu

- MemtoReg=1

- RegWr=1

- MemWr=0

- ExtOp=1(符号扩展)

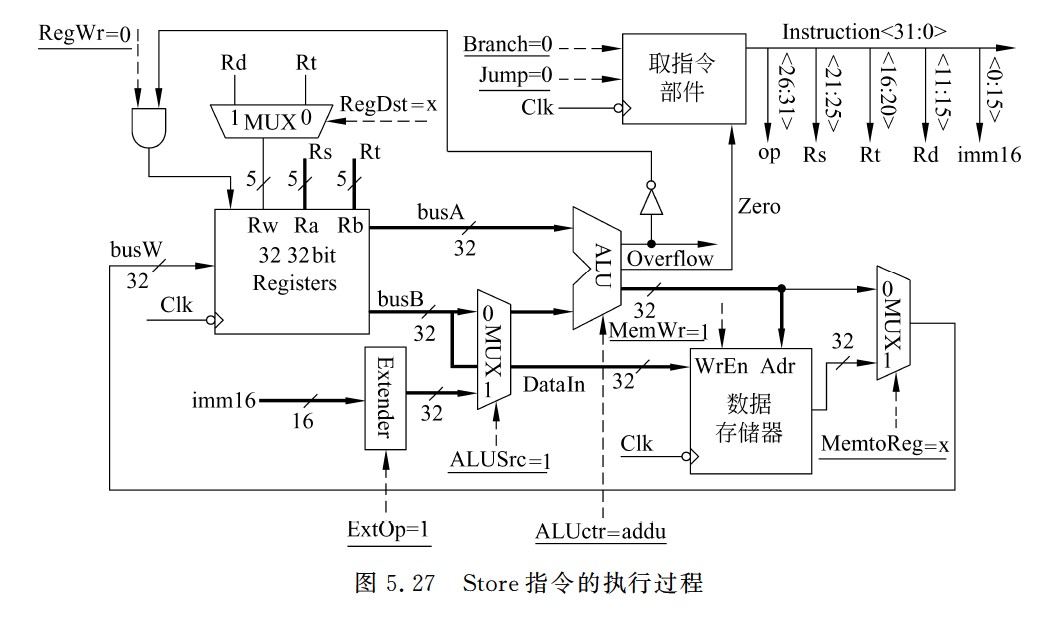

Store指令的执行过程

- 数据在数据通路中的执行路径为:

- Register File(Rs,Rt)→busA,扩展器(imm16),busB→ALU(addu),busB→数据存储器

- Store指令各控制信号的取值如下:

- Branch=Jump=0,

- RegDst=x,

- ALUsrc=1,

- ALUctr=addu,

- MemtoReg=x,

- Reg Wr=0,

- MemWr=1,

- ExtOp=1(符号扩展)

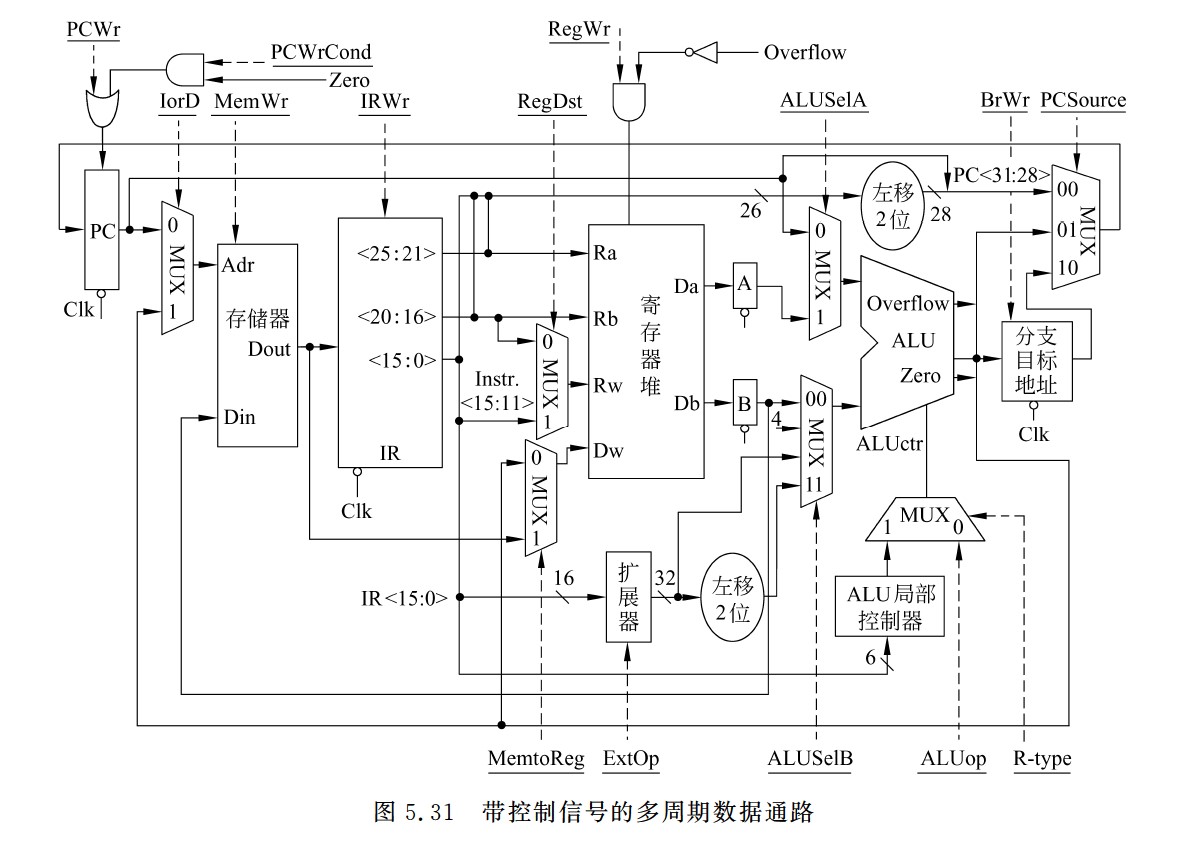

带控制信号的多周期数据通路

采用断定法的微程序控制器结构

CPU内部单总线示意图

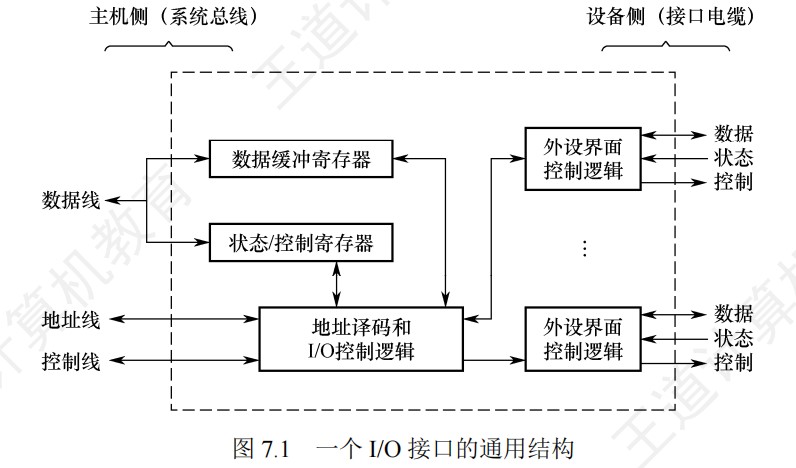

I/O接口的通用结构

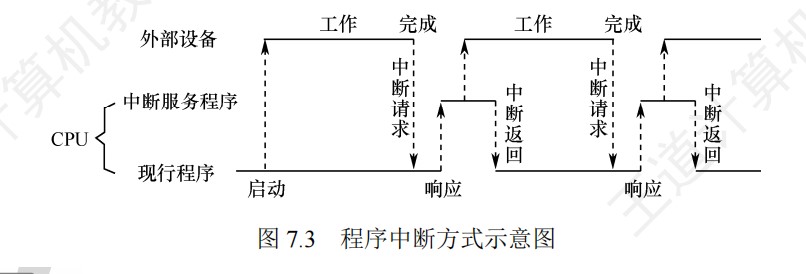

程序中断方式示意图

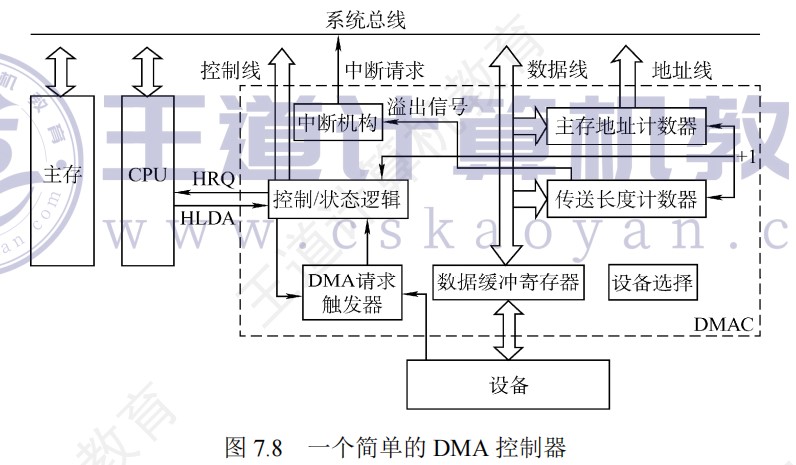

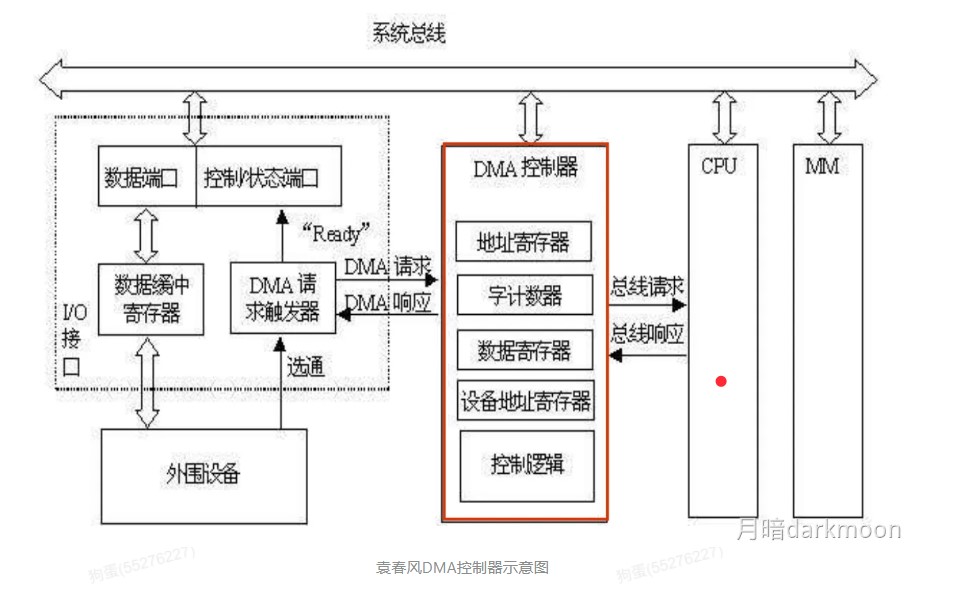

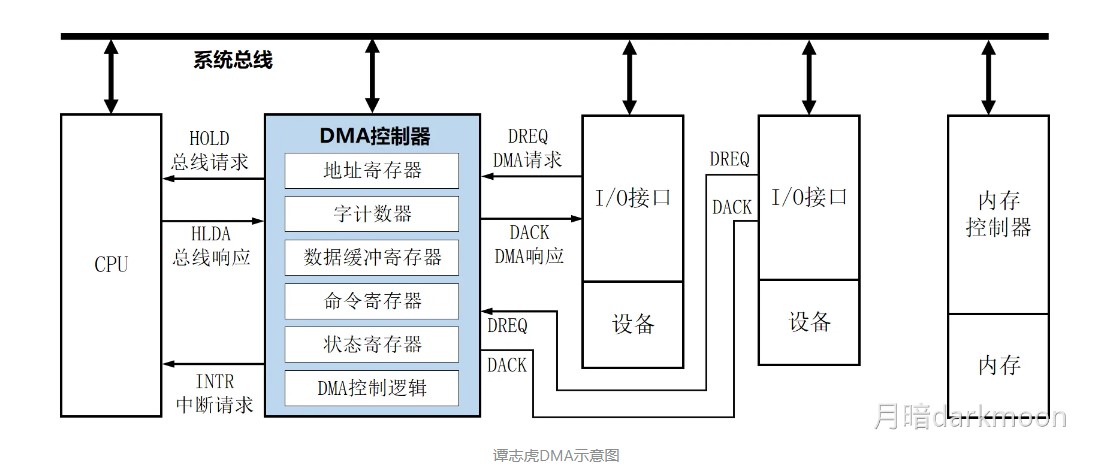

DMA控制器

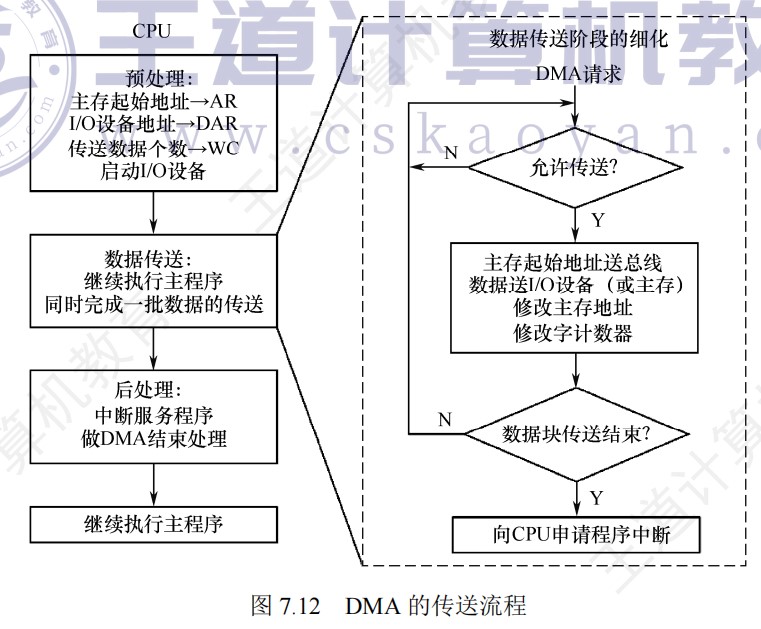

DMA的传送流程

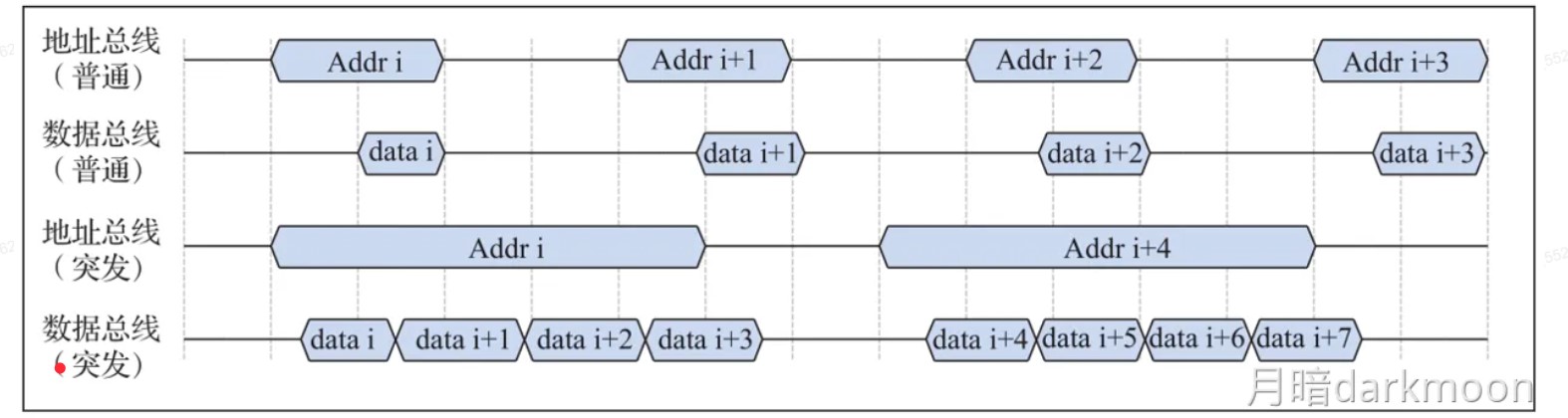

突发传送和普通传送对比

硬件判优方法(中断向量法)

五段流水线数据通路基本框架图

取指令部件的内部实现

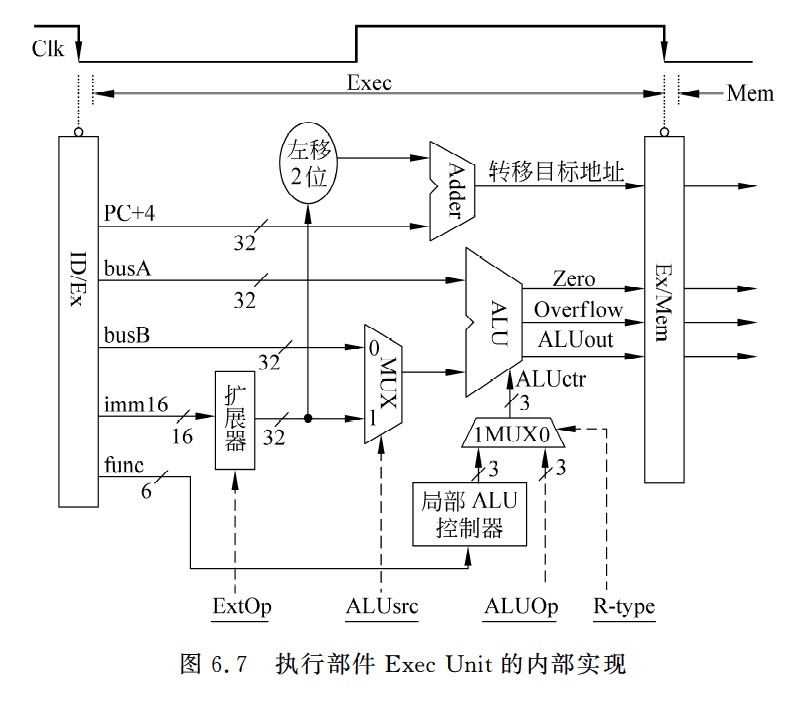

执行部件的内部实现

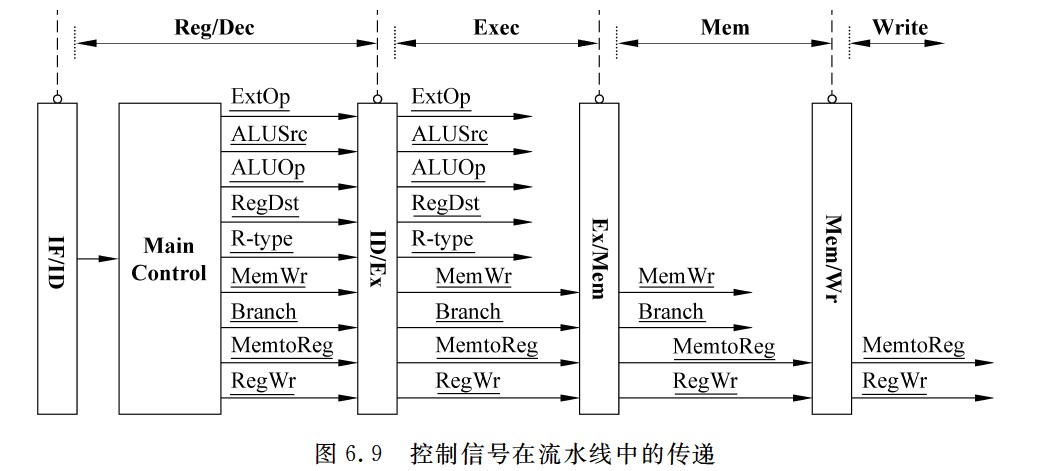

控制信号的传输

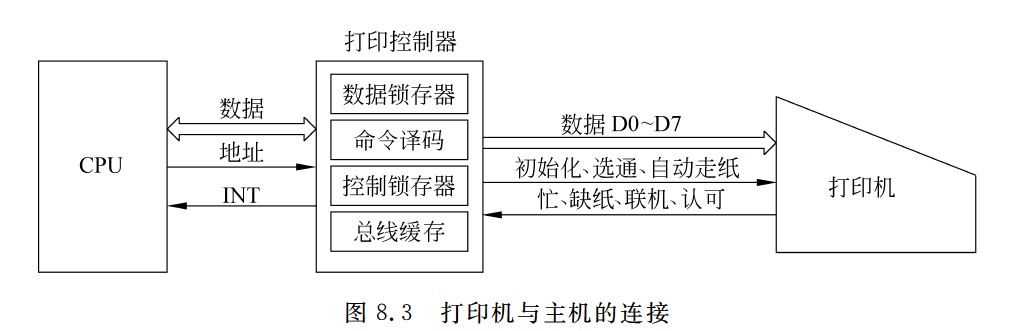

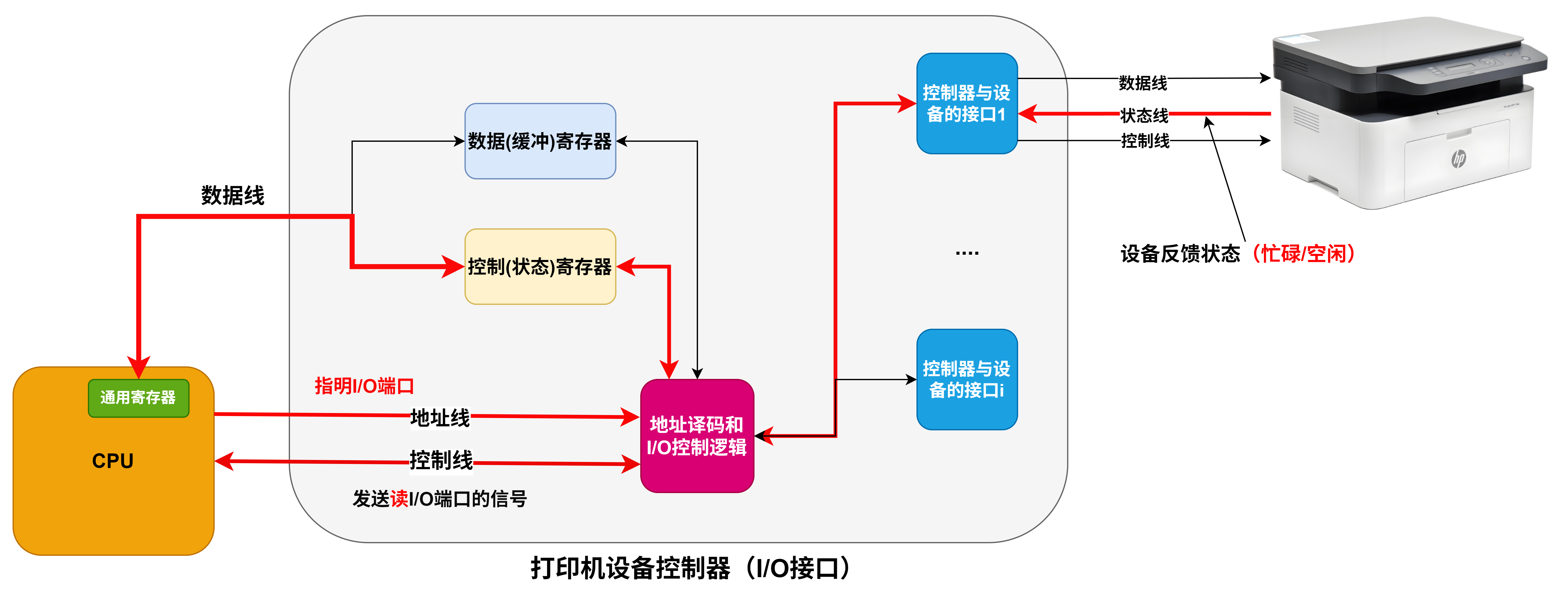

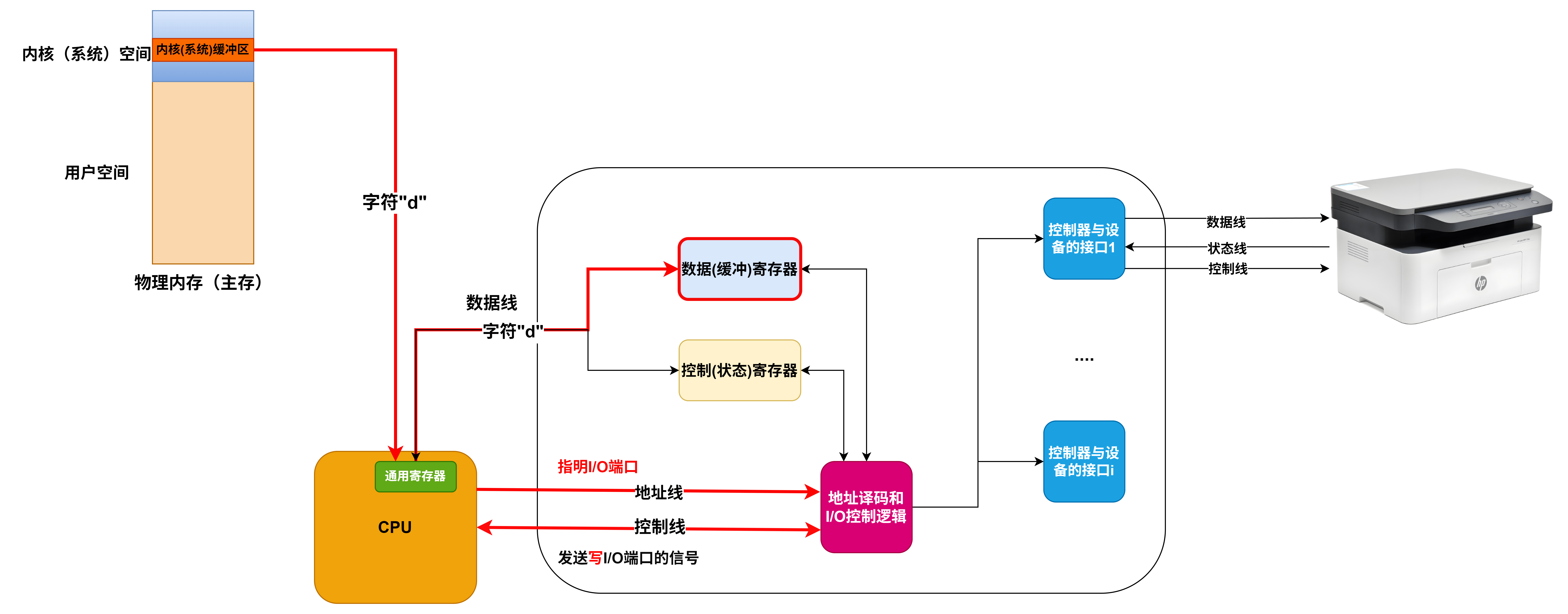

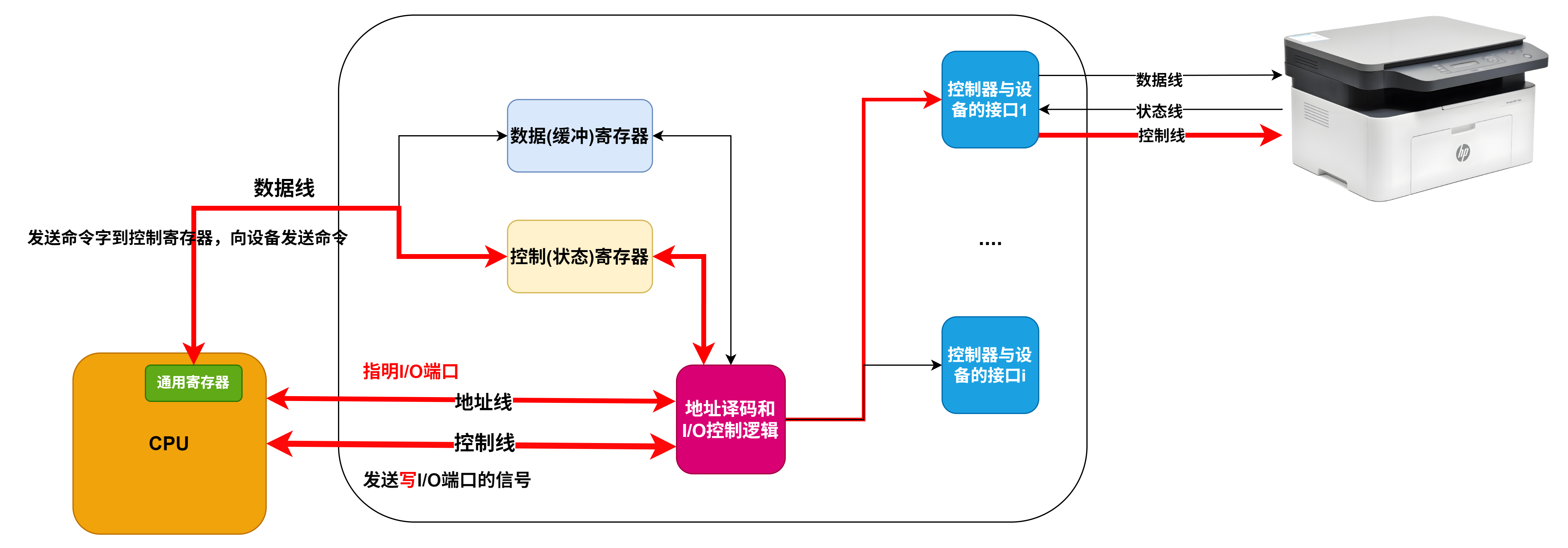

打印机与主机的连接

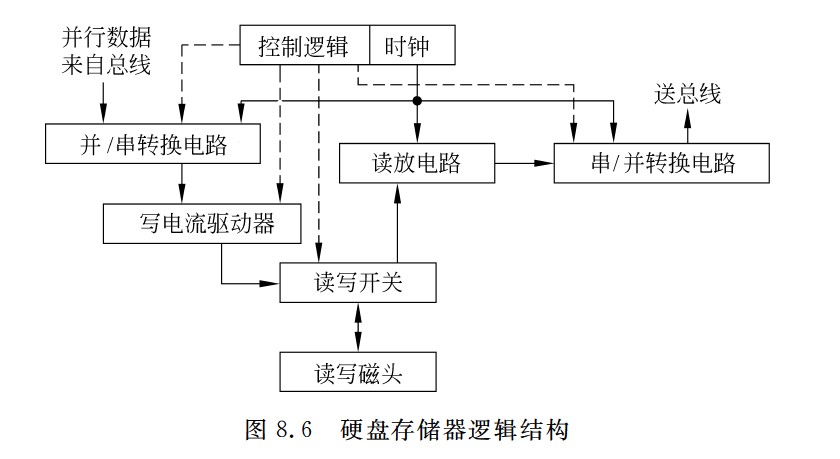

硬盘存储器逻辑结构

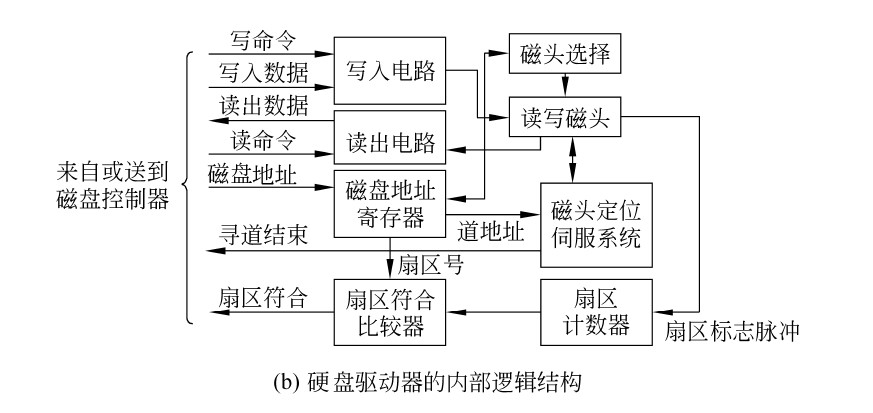

磁盘驱动器的内部逻辑结构

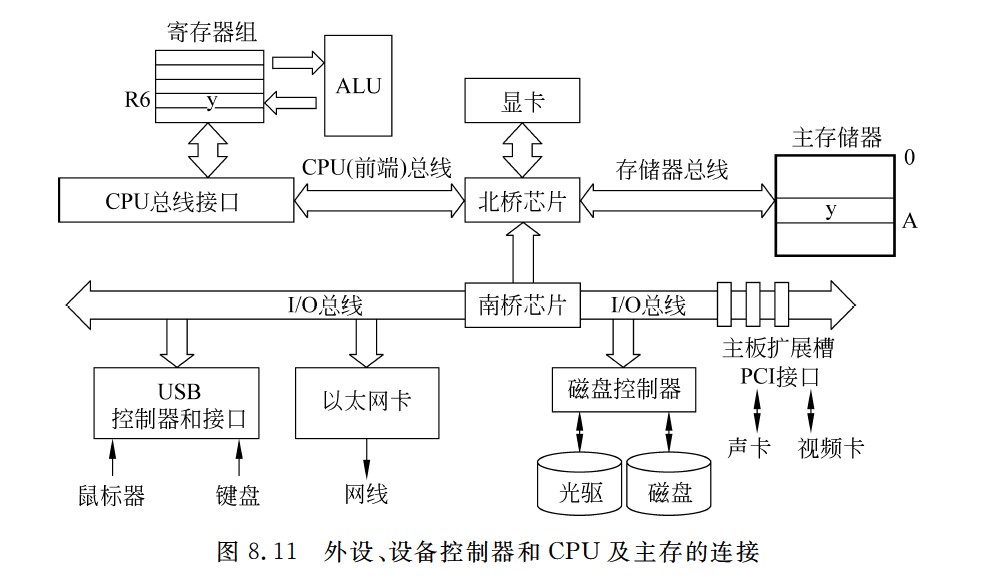

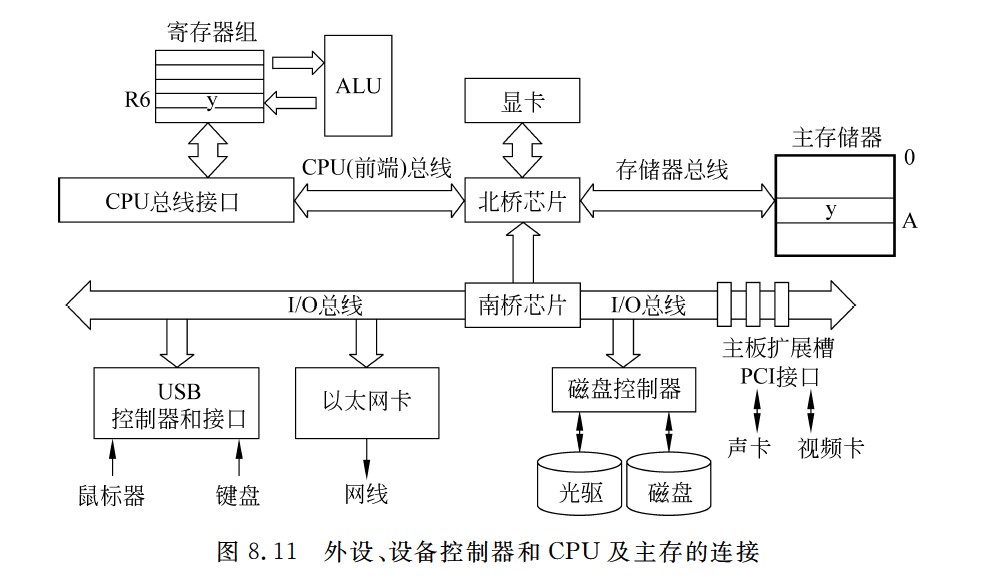

外设、设备控制器和CPU及主存的连接

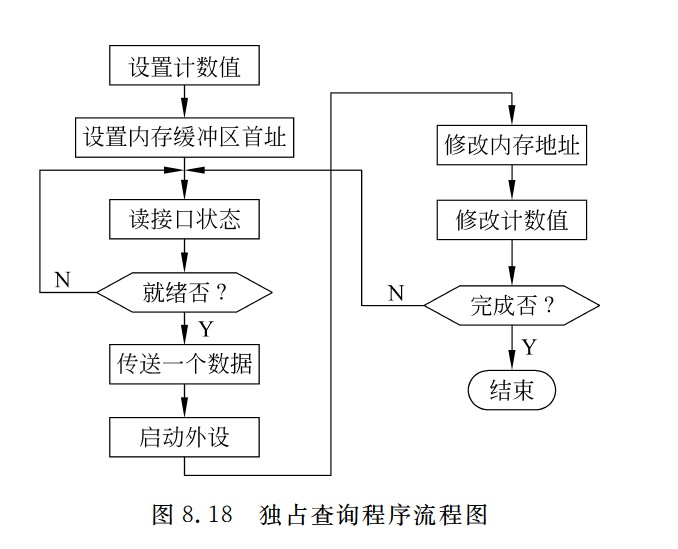

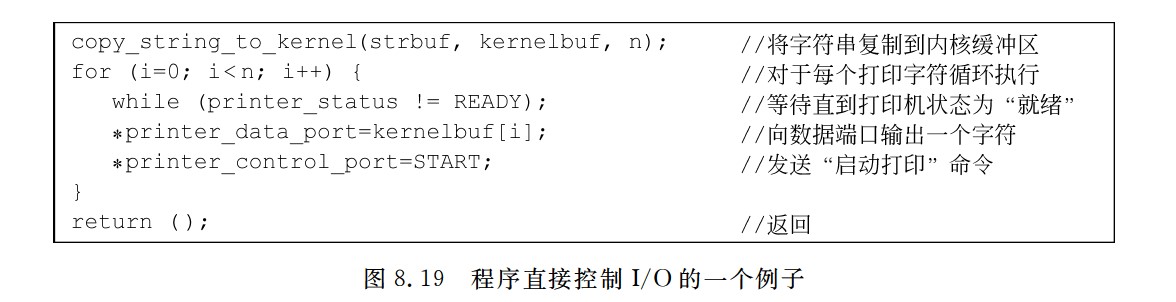

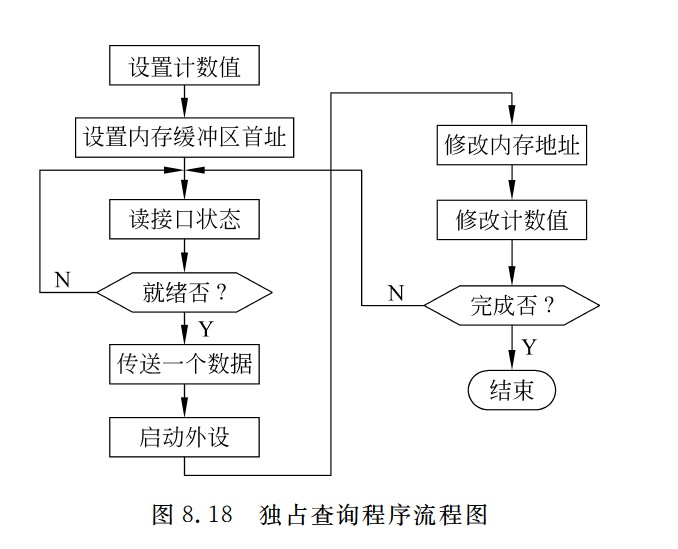

独占查询程序流程图

CPU与外设并行工作

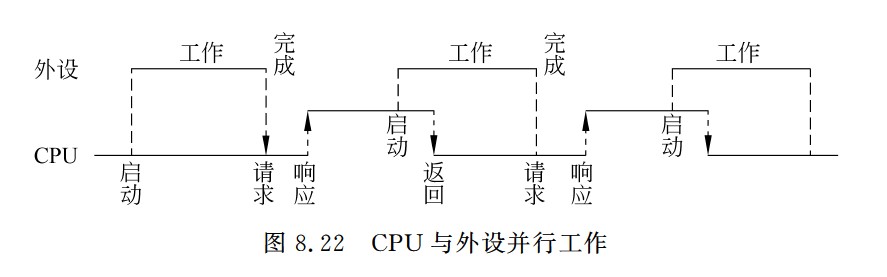

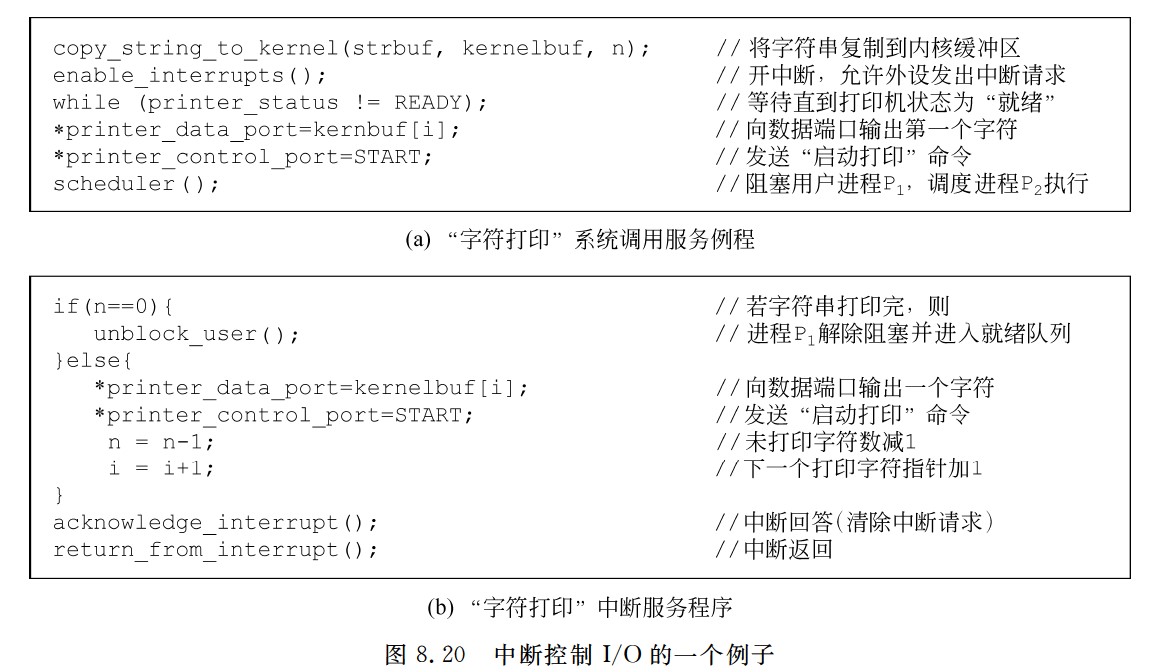

中断控制I/O过程

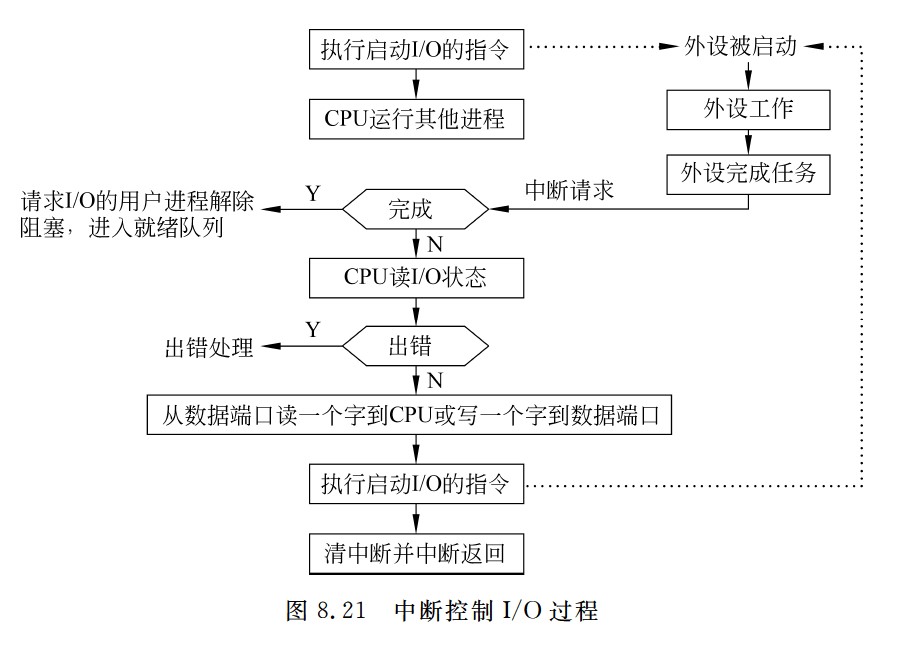

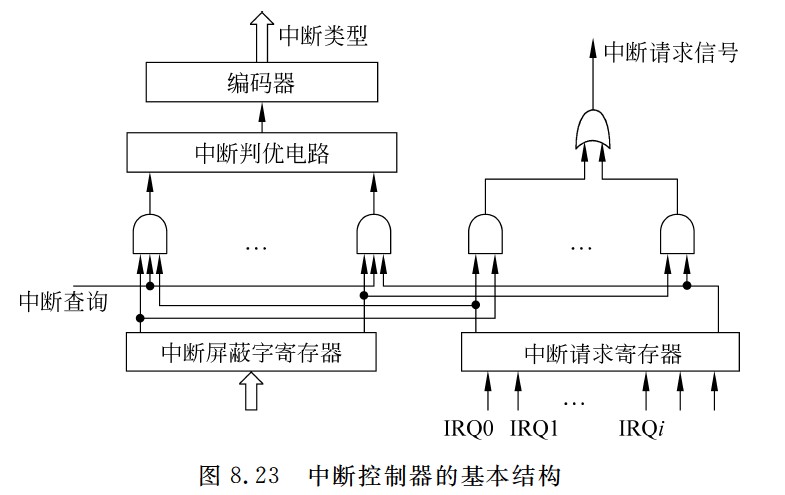

中断控制器的基本结构

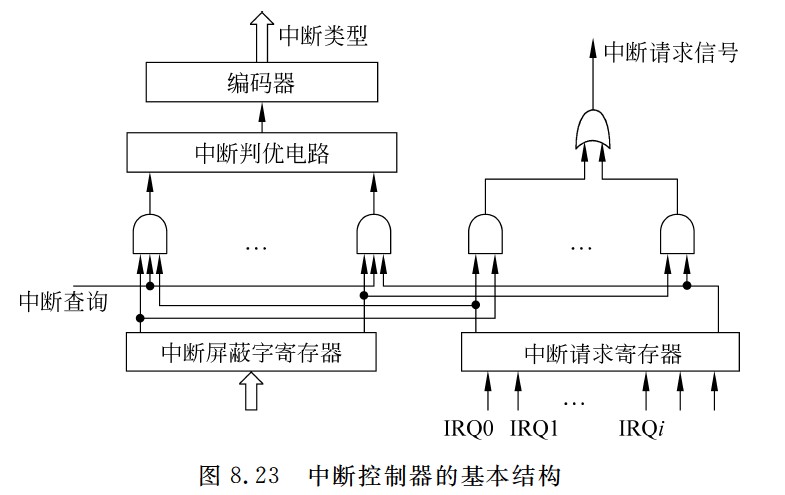

中断服务程序的典型结构

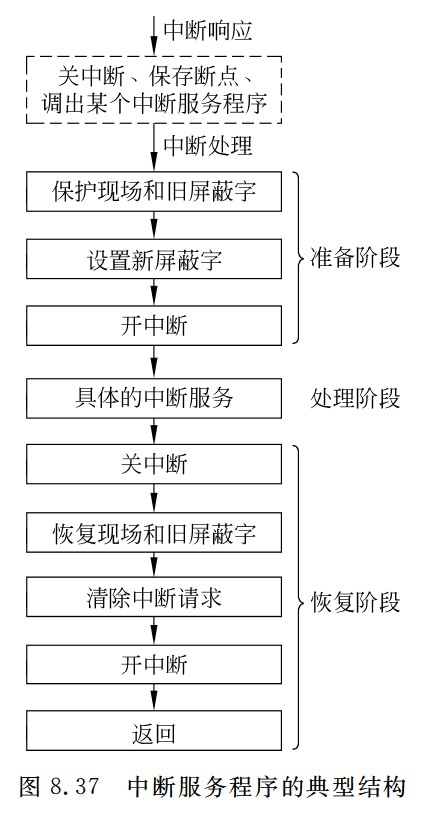

通用寄存器组

袁书笔记补充

计算机系统概述

-

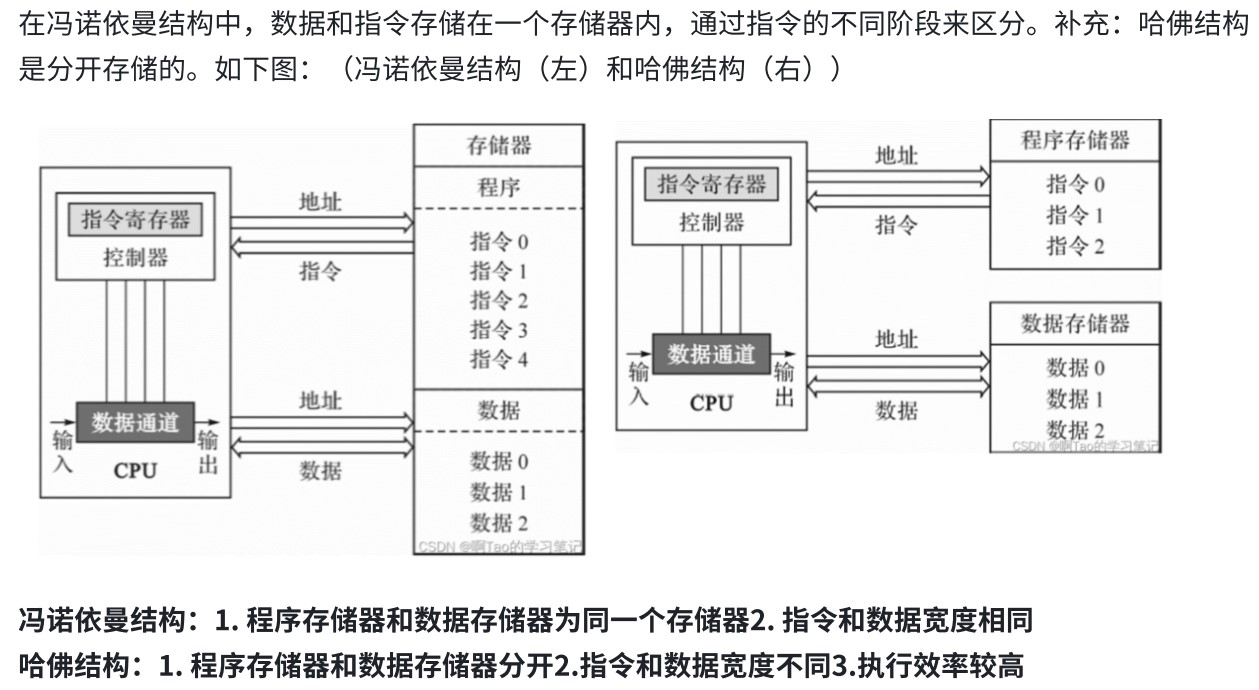

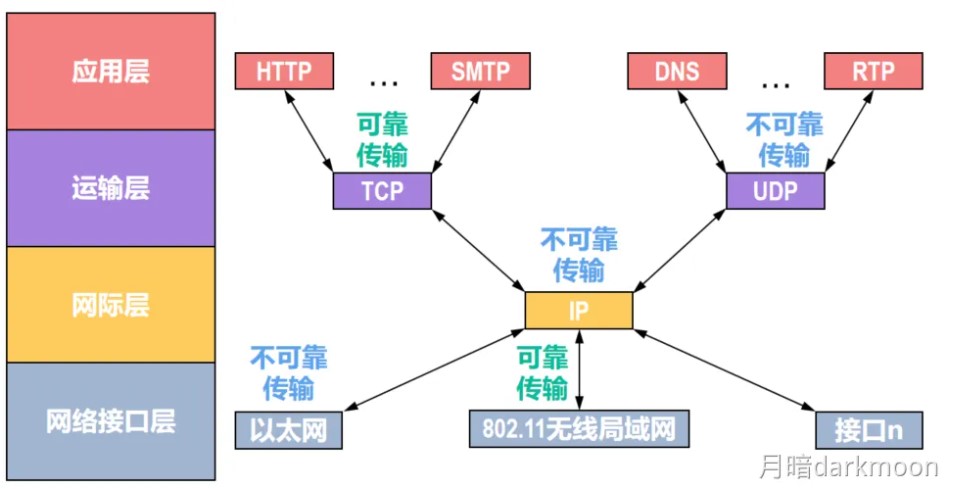

ISA和微体系结构是两个不同层面的概念,微体系结构是软件不可感知的部分,比如加法器采用串行进位方式还是并行进位方式属于微体系结构,相同的ISA可能有不同的微体系结构

-

有相同的ISA,即使微体系架构不同,一种处理器上运行的程序也能在另一种处理器上运行

-

启动和执行程序的过程

-

指令和操作地址都是一组连续存储单元中最小的地址

-

CPU性能和系统性能不等价

-

在逻辑功能上,软件和硬件是等价的

-

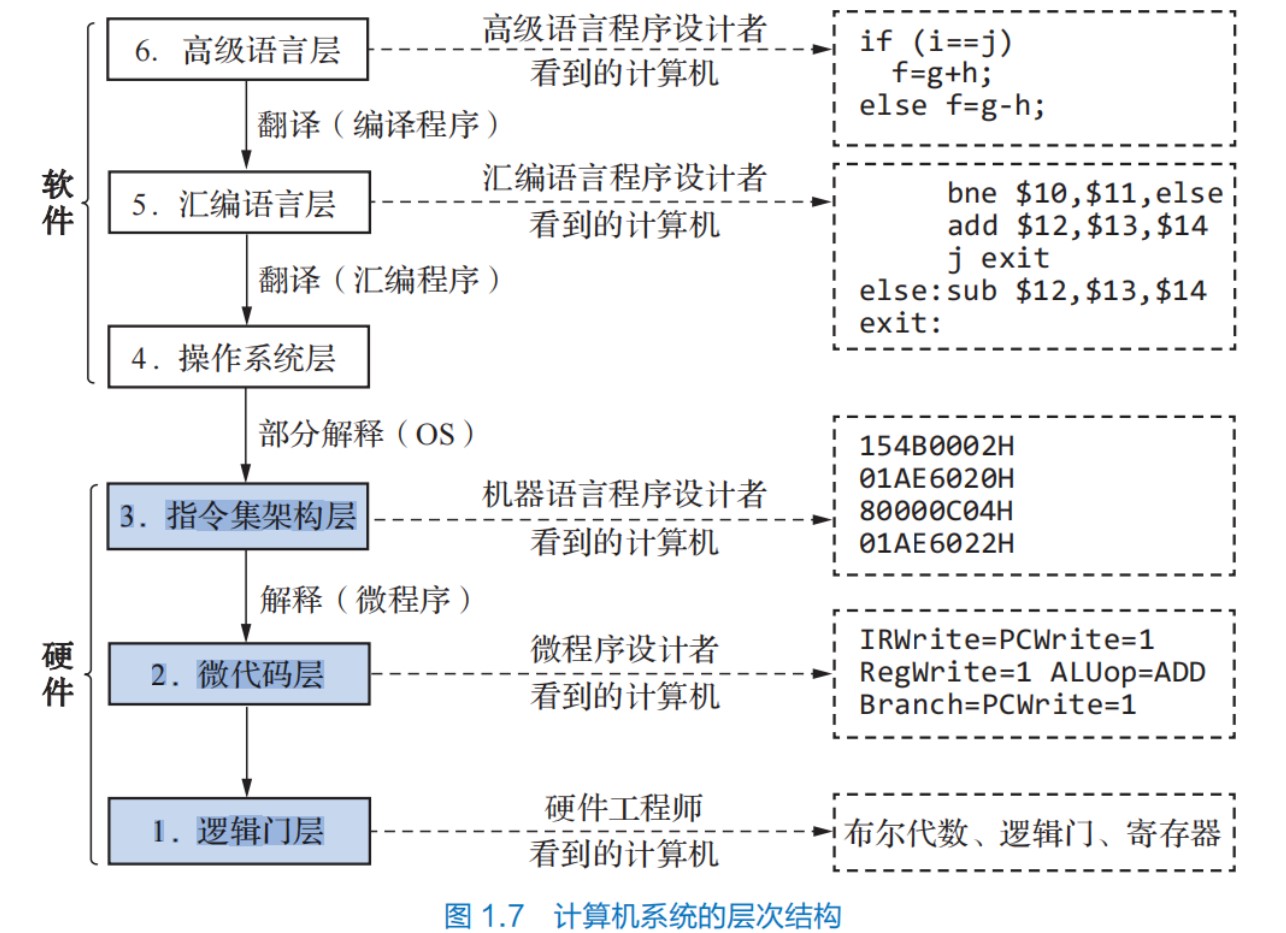

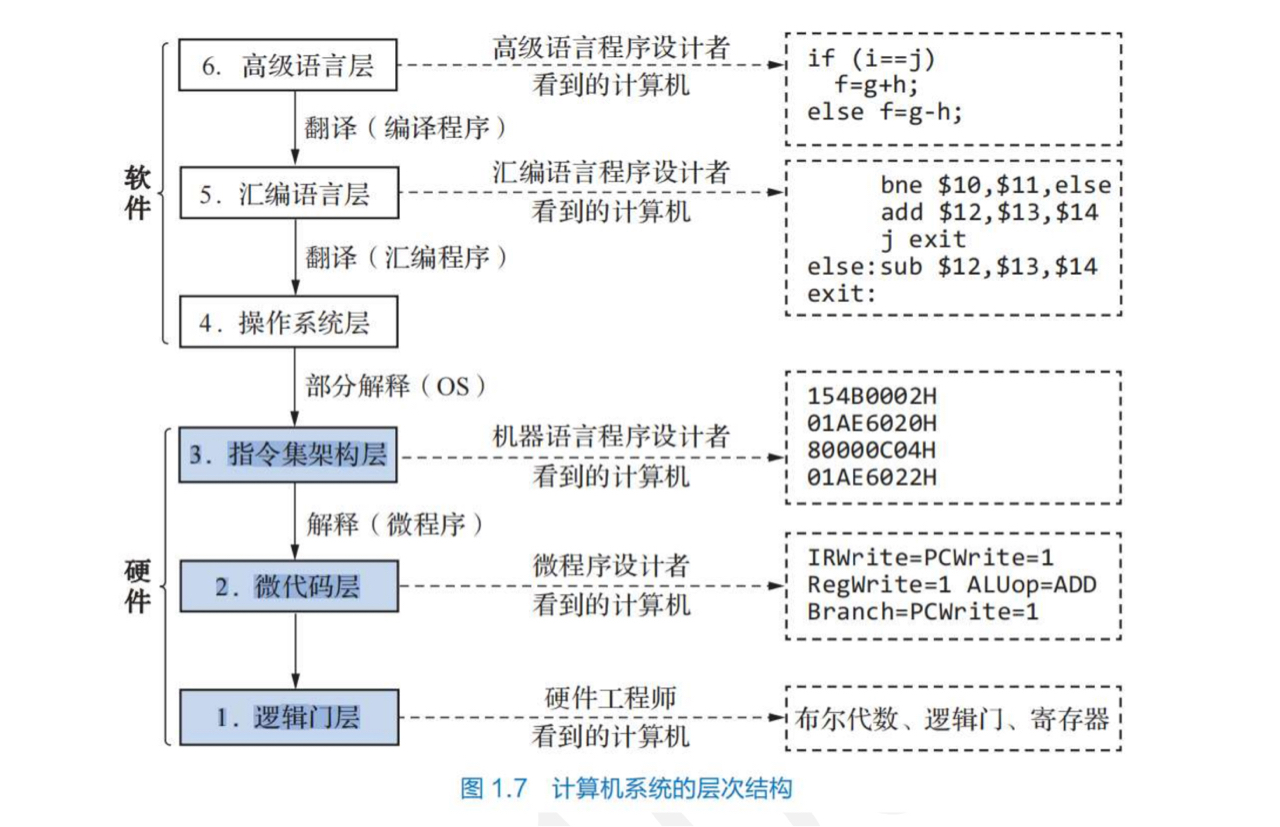

计算机系统层次结构

数据的机器级表示

-

同一个真值在不同位数的补码表示中,其对应的机器数不同

-

在机器内部,编码的位数就是机器中运算部件的位数

-

如果执行一个运算时同时有无符号数和带符号整数参加,那么,C编译器会隐含地将带符号整数强制类型转换为无符号数

-

计算机中专门用浮点数来表示实数

-

①若被除数为0,除数不为0,或者定点整数除法时|被除数|<|除数|,则说明商为0,余数为被除数,不再继续执行

- ②若被除数不为0,除数为0,对于整数,则发生“除数为0”异常;对于浮点数,则结果等于无穷大

- ③若被除数和除数都为0,对于整数,则发生除法错异常;对于浮点数,则有些机器产生一个不发信号的NaN,或者产生NaN信号,取决于最高有效位

-

当结果出现尾数为0的时候,不管阶码是什么,都将阶码取为0

-

若基数为R,则规格化数的标志是,尾数部分真值的绝对值>=1/R(一般来说,1/R这个边界值要舍掉)

-

逻辑数据和数值数据都是一串0/1序列,在形式上无任何差异,需要通过指令的操作码类型来识别他们

-

IEEE754移码为2^(n-1)-1的好处

- ①尾数可表示的位数多1位,因而使浮点数的精度更高

- ②指数的可表示范围更大,因而使浮点数的范围更大

-

非规格化数可用于处理解码下溢,使得出现比最小规格化数还小的数时程序也能继续进行下去

-

当操作数为无穷大时,系统可以有两种处理方式

- 产生不发信号的非数NaN

- 产生明确的结果

-

NaN

- 当最高有效位为1的时候,为不发信号NaN,当结果产生这种非数时,不发异常通知,即不进行异常处理;当最高有效位为0时为发信号NaN,当结果产生这种非数时,则发一个异常操作通知,表示要进行异常处理

- 除了第一位有定义外其余的位没有定义,所以可用其余位来指定具体的异常条件

- 一些没有数学解释的计算,会产生一个NaN

-

平时所说的xxx位机就是机器字长xxx位

-

字长就是机器字长,等于CPU内部用于整数运算的运算器位数和通用寄存器宽度

-

字和字长概念不同,字用来表示被处理信息的单位,用来度量各种数据的宽度,也就是说,字只出现在描述某一变量类型是半字,单字,双字之类的场景;一个是软件(字)上的概念,一个是硬件(字长)上的概念,字和字长可以一样也可以不一样

-

长整数的长度与机器字长的宽度相同,这也就是为什么long在32位机上是4B,在64位机上是8B

-

指针和长整数的宽度一样,也等于机器字长的宽度

-

为什么会有大端小端方式

- ①计算机按字节编址

- ②程序中对每个数据只给定一个地址

- ③因此当一个数据(比如int)的大小超过1B,就要考虑这个数据n个字节在给定的地址空间中的排列

- ④因此,大端小端是指某个数据在给定的地址空间中,它的不同字节的排列顺序,每个数据的大小端存储以其被分配的存储空间(地址范围)为限

-

对正数来说,原码和补码的编码相同, 所以其整数(补码表示)和浮点数尾数的有效位数一样,对于负数来说,其整数表示和浮点数表示中不一定会有相同的一段位序列(第一个1之前相反)

-

MIPS指令系统涉及的运算有

- ①按位逻辑运算

- ②逻辑移位

- ③算术移位

- ④带符号整数的加减乘除

- ⑤无符号整数加减乘除

- ⑥带符号整数的符号扩展

- ⑦无符号数的0扩展

- ⑧单精度浮点数加减乘除

- ⑨双精度浮点数加减乘除

- MIPS指令中没有专门的算术左移指令

-

float的有效位数是24位,相当于十进制7位,double的有效位数是53位,相当于十进制17位,int的有效位是31位,相当于十进制10位

-

类型 二进制有效位 十进制有效位 数值范围 用途 float 24位 约7位 ±10³⁸ 一般精度计算 double 53位 约16位 ±10³⁰⁸ 高精度计算 int 31位 约10位 ±2.1×10⁹ 精确整数计算 -

特性 数值范围 有效位数 定义 能表示的最小值和最大值 能精确表示的数字位数 关注点 数的大小 数的精度 决定因素 指数位的位数 尾数位的位数 类比 尺子的总长度 尺子的最小刻度 -

可表示的数据个数取决于编码所采用的位数,编码位数一定,则编码出来的数据个数就是一定的,n位编码最多只能表示2^n个数,但是,有时由于一个值可能有两个或多个编码对应,编码个数会有少量差异

-

定点小数补码的模是2,定点整数补码的模是2^(n+1)

运算方法和运算部件

-

标志位的逻辑

-

ALU中可以实现左(右)移一位和两位的操作,当然也可用一个移位寄存器实现移位,单这两种方式每次都只能固定移动一位或两位,有时移位指令要求一次移动若干位,对于这种一次左移或右移多位的操作,通常用一个做在ALU之外的桶型移位器实现。桶形移位器不同于普通移位寄存器,它利用大量多路选择器来实现数据的快速移位,移位操作能够一次完成。在ALU外单独设置桶型移位器,还可简化ALU的控制逻辑,并实现移位操作和ALU操作的并行性

-

两个n位定点正整数相除,ACC全0,MQ中为被除数X;两个n位定点正小数相除,ACC中为被除数,MQ中全0

-

并行进位加法器中高位的进位依赖于低位,是指依赖于C0

-

标志寄存器不需要单独编号,本身就是一个专用的状态寄存器,通过标志位而非编号来标识功能

-

标志寄存器中的内容,是执行指令的过程中,cpu根据指令执行的结果生成的,用户不能通过指令直接指定标志寄存器的编号或者修改它

-